抓取猫眼TOP100的数据

import requests

import re

import json

from multiprocessing import Pool

from multiprocessing import Manager

import time

import functools #函数的包装器

# 抓取猫眼TOP100的数据

# 第一步:下载页面

def get_one_page(url):

# 设置UA

ua_header = {"User-Agent":"Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/53"}

response = requests.get(url, headers=ua_header)

if response.status_code == 200:#OK

return response.text

return None

# 第二步:提取信息

def parse_one_page(html):

# 使用正则表达式的懒惰+findall的模式来提取信息

pattern = re.compile('<p class="name"[\s\S]*?title="([\s\S]*?)"[\s\S]*?<p class="star">([\s\S]*?)</p>[\s\S]*?<p class="releasetime">([\s\S]*?)</p>')

items = re.findall(pattern, html)

# 使用yield来返回信息给上层

for item in items:

yield{

"title":item[0].strip(),

"actor":item[1].strip(),

"time":item[2].strip()

}

# 第三步:保存到本地文件系统中

def write_to_file(item):

# 存储成json格式,以便于将来能方便的提取出来

with open("maoyanTop100.txt", 'a', encoding="utf-8") as f:

f.write(json.dumps(item, ensure_ascii=False)+'\n')

#0-100: 0,10,20,...,90

#http://maoyan.com/board/4?offset=

def CrawlPage(lock, offset):

# 将下载页面,解析页面及保存信息放入一个函数中

url = "http://maoyan.com/board/4?offset="+str(offset)

html = get_one_page(url)

for item in parse_one_page(html):

lock.acquire() #加锁

write_to_file(item)

lock.release() #释放锁

if __name__ == "__main__":

# 使用进程池来抓取数据

# 在进程池之间通信或者加锁时需要用Manager

manager = Manager()

lock = manager.Lock()

# 产生一个新的包装函数

newCrawlPage = functools.partial(CrawlPage, lock)

pool = Pool()

pool.map(newCrawlPage, [i*10 for i in range(10)])

pool.close()

pool.join()

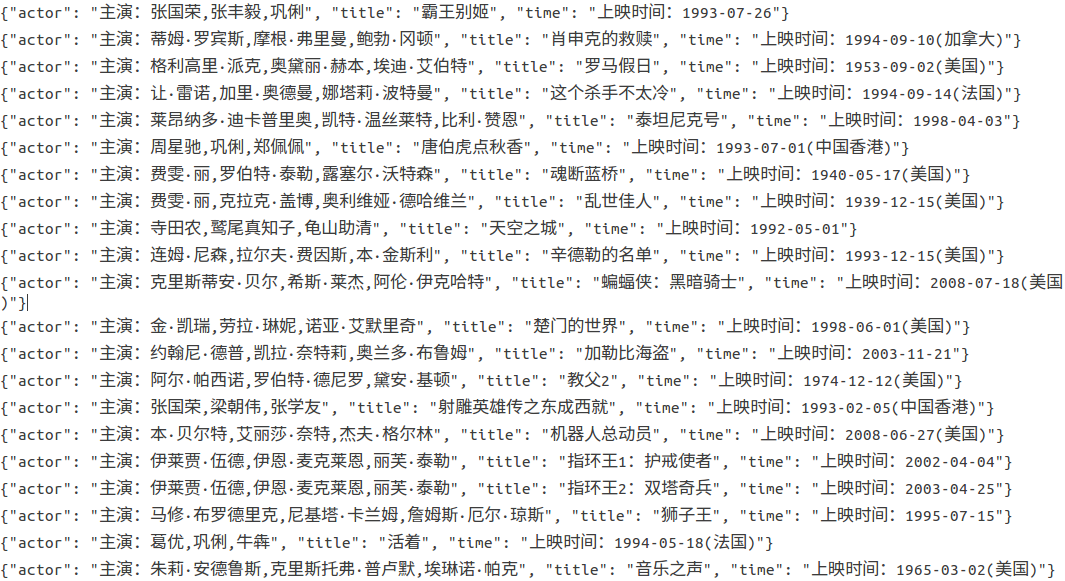

效果:

抓取猫眼TOP100的数据的更多相关文章

- Python爬取猫眼top100排行榜数据【含多线程】

# -*- coding: utf-8 -*- import requests from multiprocessing import Pool from requests.exceptions im ...

- Python Spider 抓取猫眼电影TOP100

""" 抓取猫眼电影TOP100 """ import re import time import requests from bs4 im ...

- Python爬虫之requests+正则表达式抓取猫眼电影top100以及瓜子二手网二手车信息(四)

requests+正则表达式抓取猫眼电影top100 一.首先我们先分析下网页结构 可以看到第一页的URL和第二页的URL的区别在于offset的值,第一页为0,第二页为10,以此类推. 二.< ...

- 使用Python抓取猫眼近10万条评论并分析

<一出好戏>讲述人性,使用Python抓取猫眼近10万条评论并分析,一起揭秘“这出好戏”到底如何? 黄渤首次导演的电影<一出好戏>自8月10日在全国上映,至今已有10天,其主演 ...

- python爬虫:爬取猫眼TOP100榜的100部高分经典电影

1.问题描述: 爬取猫眼TOP100榜的100部高分经典电影,并将数据存储到CSV文件中 2.思路分析: (1)目标网址:http://maoyan.com/board/4 (2)代码结构: (3) ...

- python+requests+re匹配抓取猫眼上映电影信息

python+requests抓取猫眼中上映电影,re正则匹配获取对应电影的排名,图片地址,片名,主演及上映时间和评分 import requests import re, json def get_ ...

- 使用 Python 抓取欧洲足球联赛数据

Web Scraping在大数据时代,一切都要用数据来说话,大数据处理的过程一般需要经过以下的几个步骤 数据的采集和获取 数据的清洗,抽取,变形和装载 数据的分析,探索和预测 ...

- 抓取Js动态生成数据且以滚动页面方式分页的网页

代码也可以从我的开源项目HtmlExtractor中获取. 当我们在进行数据抓取的时候,如果目标网站是以Js的方式动态生成数据且以滚动页面的方式进行分页,那么我们该如何抓取呢? 如类似今日头条这样的网 ...

- 如何用python抓取js生成的数据 - SegmentFault

如何用python抓取js生成的数据 - SegmentFault 如何用python抓取js生成的数据 1赞 踩 收藏 想写一个爬虫,但是需要抓去的的数据是js生成的,在源代码里看不到,要怎么才能抓 ...

随机推荐

- Python笔记(十)_迭代器与生成器

迭代 用for...in来遍历一个可迭代对象的过程就叫迭代 可迭代对象:列表.元组.字典.集合.字符串.生成器 可以使用内置函数isinstance()判断一个对象是否是可迭代对象 >>& ...

- Vue 创建组件的两种方法

地址:https://blog.csdn.net/cofecode/article/details/74634301 创建组件的两种方法 1.全局注册 2.局部注册 var child=Vue.ext ...

- leetcode.双指针.88合并两个有序数组-Java

1. 具体题目 给定两个有序整数数组 nums1 和 nums2,将 nums2 合并到 nums1 中,使得 num1 成为一个有序数组. 说明: 初始化 nums1 和 nums2 的元素数量分别 ...

- ZOJ 3681E - Cup 2(记忆化dfs)不好读

版权声明:本文为博主原创文章.未经博主同意不得转载. https://blog.csdn.net/opm777/article/details/25726221 E - Cup 2 Time Limi ...

- python问答

1)什么是Python?使用Python有什么好处? Python是一种编程语言,包含对象,模块,线程,异常和自动内存管理.Python的好处在于它简单易用,可移植,可扩展,内置数据结构,并且它是一个 ...

- Java中File的处理

不知道“文件”和“文件路径”是否存在的处理情况 1.如果是文件,先获取文件父路径,没有就生成父路径,然后再生成文件. public class TestMain { public static voi ...

- jQuery 菜单 垂直菜单实现

HTML <!DOCTYPE html> <html> <head> <meta charset="utf-8" /> <ti ...

- linux(一)vi和vim

vi 多模式文本编辑器 多模式产生的原因 四种模式 正常模式 插入模式 命令模式 可视模式 vi man vi vim vim正常模式 直接vim回车,或vim空格文件名回车 i进入插入模式 I(sh ...

- 【leetcode】910. Smallest Range II

题目如下: 解题思路:我的思路是先找出最大值.对于数组中任意一个元素A[i]来说,如果A[i] + K 是B中的最大值,那么意味着从A[i+1]开始的元素都要减去K,即如果有A[i] + K > ...

- 如何在cmd中启动MongoDB服务器和客户端

1 先将MongoDB的bin路径添加到环境变量中 2 打开cmd输入mongod 开启MongoDB服务器 3 输入mongo开启MongoDB客户端