Python3实现文本预处理

1、数据集准备

测试数据集下载:https://github.com/Asia-Lee/Vulnerability_classify/blob/master/testdata.xls

停用词过滤表下载:https://github.com/Asia-Lee/Vulnerability_classify/blob/master/stopwords.txt

2、数据预处理

(1)简单分词

# -*- coding: utf-8 -*- import pandas as pd

import jieba

"""

函数说明:简单分词

Parameters:

filename:数据文件

Returns:

list_word_split:分词后的数据集列表

category_labels: 文本标签列表

"""

def word_split(filename):

read_data=pd.read_excel(filename)

list_word_split=[]

category_labels=[]

for i in range(len(read_data)):

row_data = read_data.iloc[i, 1] # 读取单个漏洞描述文本

list_row_data = list(jieba.cut(row_data)) # 对单个漏洞进行分词

list_row_data=[x for x in list_row_data if x!=' '] #去除列表中的空格字符

list_word_split.append(list_row_data) row_data_label=read_data.iloc[i,2] #读取单个漏洞的类别标签

category_labels.append(row_data_label) #将单个漏洞的类别标签加入列表

return list_word_split, category_labels if __name__=='__main__':

list_word_split, category_labels=word_split('testdata.xls') #获得每条文本的分词列表和标签列表

print(list_word_split)

print(category_labels)

print('分词成功')

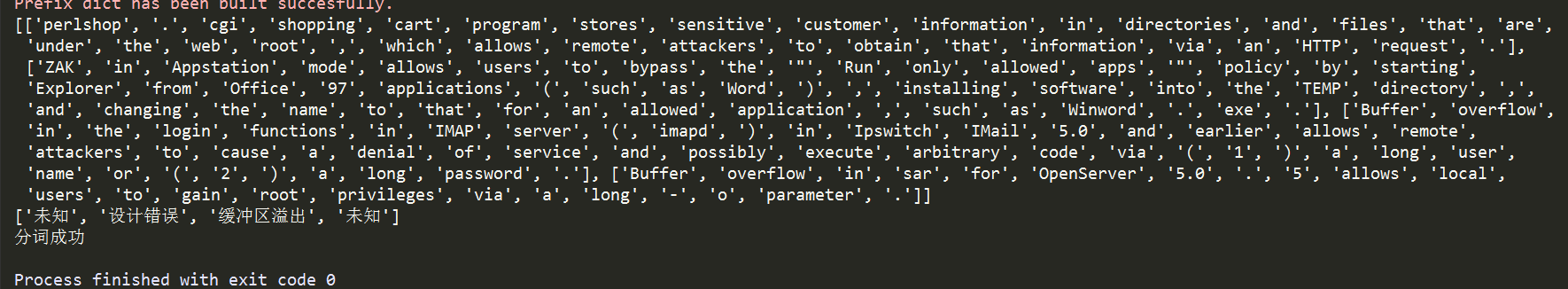

分词结果:

(2)词性还原

# -*- coding: utf-8 -*- import pandas as pd

import jieba

from nltk.stem import WordNetLemmatizer """

函数说明:词性还原

Parameters:

list_words:数据列表

Returns:

list_words_lemmatizer:词性还原后的数据集列表

"""

def word_lemmatizer(list_words):

wordnet_lemmatizer = WordNetLemmatizer()

list_words_lemmatizer = []

for word_list in list_words:

lemmatizer_word = []

for i in word_list:

lemmatizer_word.append(wordnet_lemmatizer.lemmatize(i))

list_words_lemmatizer.append(lemmatizer_word)

return list_words_lemmatizer if __name__=='__main__':

list_word_split, category_labels=word_split('testdata.xls') #获得每条文本的分词列表和标签列表

print('分词成功')

list_words_lemmatizer=word_lemmatizer(list_word_split) #词性还原

print('词性还原成功')

(3)停用词过滤

# -*- coding: utf-8 -*- import pandas as pd

import jieba

from nltk.stem import WordNetLemmatizer """

函数说明:停用词过滤

Parameters:

filename:停用词文件

list_words_lemmatizer:词列表

Returns:

list_filter_stopwords:停用词过滤后的词列表

"""

def stopwords_filter(filename,list_words_lemmatizer):

list_filter_stopwords=[] #声明一个停用词过滤后的词列表

with open(filename,'r') as fr:

stop_words=list(fr.read().split('\n')) #将停用词读取到列表里

for i in range(len(list_words_lemmatizer)):

word_list = []

for j in list_words_lemmatizer[i]:

if j not in stop_words:

word_list.append(j.lower()) #将词变为小写加入词列表

list_filter_stopwords.append(word_list)

return list_filter_stopwords if __name__=='__main__':

list_word_split, category_labels=word_split('testdata.xls') #获得每条文本的分词列表和标签列表

print('分词成功')

list_words_lemmatizer=word_lemmatizer(list_word_split) #词性还原

print('词性还原成功')

list_filter_stopwords=stopwords_filter('stopwords.txt',list_words_lemmatizer) #获得停用词过滤后的列表

print("停用词过滤成功")

(4)特征选择

对于处理这类文本数据,常用的特征选择方法有: TF-IDF(词频-逆向文档频率),信息增益、卡方检验、互信息、N-Gram

(5)文本标签向量化

"""

函数说明:文本向量化,标签向量化 one-hot编码

Parameters:

feature_words:特征词集

doc_words:文本列表

doc_category_labels:文本类别标签

Returns:

docvec_list:文本向量列表

labelvec_list:标签向量列表

"""

def words2vec(feature_words,doc_words,doc_category_labels):

#文本列表转向量列表

docvec_list=[]

for words in doc_words:

docvec = [0] * len(feature_words)

for j in words:

if j in feature_words:

docvec[feature_words.index(j)]=1

docvec_list.append(docvec)

#标签列表转向量列表

labelvec_list = []

labelset=list(set(doc_category_labels))

for label in doc_category_labels:

doclabel = [0] * len(labelset)

doclabel[labelset.index(label)]=1

labelvec_list.append(doclabel)

return docvec_list,labelvec_list

(6)选择算法模型进行训练(机器学习、深度学习)

Python3实现文本预处理的更多相关文章

- 浅谈NLP 文本分类/情感分析 任务中的文本预处理工作

目录 浅谈NLP 文本分类/情感分析 任务中的文本预处理工作 前言 NLP相关的文本预处理 浅谈NLP 文本分类/情感分析 任务中的文本预处理工作 前言 之所以心血来潮想写这篇博客,是因为最近在关注N ...

- 【NLP】Tika 文本预处理:抽取各种格式文件内容

Tika常见格式文件抽取内容并做预处理 作者 白宁超 2016年3月30日18:57:08 摘要:本文主要针对自然语言处理(NLP)过程中,重要基础部分抽取文本内容的预处理.首先我们要意识到预处理的重 ...

- Keras文本预处理

学习了Keras文档里的文本预处理部分,参考网上代码写了个例子 import keras.preprocessing.text as T from keras.preprocessing.text i ...

- [ DLPytorch ] 文本预处理&语言模型&循环神经网络基础

文本预处理 实现步骤(处理语言模型数据集距离) 文本预处理的实现步骤 读入文本:读入zip / txt 等数据集 with zipfile.ZipFile('./jaychou_lyrics.txt. ...

- NLP自然语言处理入门-- 文本预处理Pre-processing

引言 自然语言处理NLP(nature language processing),顾名思义,就是使用计算机对语言文字进行处理的相关技术以及应用.在对文本做数据分析时,我们一大半的时间都会花在文本预处理 ...

- L4文本预处理

文本预处理 timemachine.txt数据下载地址 链接:https://pan.baidu.com/s/1RO2OLyTRQZ90HJUW7V7BCQ 提取码:bjox NLTK数据集下载 链接 ...

- 学习笔记--python中使用多进程、多线程加速文本预处理

一.任务描述 最近尝试自行构建skip-gram模型训练word2vec词向量表.其中有一步需要统计各词汇的出现频率,截取出现频率最高的10000个词汇进行保留,形成常用词词典.对于这个问题,我建立了 ...

- NLP 文本预处理

1.不同类别文本量统计,类别不平衡差异 2.文本长度统计 3.文本处理,比如文本语料中简体与繁体共存,这会加大模型的学习难度.因此,他们对数据进行繁体转简体的处理. 同时,过滤掉了对分类没有任何作用的 ...

- Python3之文本操作

文件操作示例分析: 文件操作一般要经历三个步骤: 打开文件 操作文件 关闭文件 读取操作示例: >>>f = open('test.txt', 'r') # 打开文件test.txt ...

随机推荐

- input 的 type 等于 file

高版本浏览器由安全问题没法获得文件的绝对路径, 因此使用浏览器自制播放器只能使用其他的手段实现. 使用相对路径, 把浏览器与文件放在同一路径下即可使用.通用性受到限制.

- 滑动报 Unable to preventDefault inside passive event listener due to target being treated as passive 的解决方法

google浏览器滑动出现以下问题: 解决办法如下:在html元素下添加样式 touch-action: none; html{ touch-action:none; }

- Oracle--SQL程序优化案例一

下面是存储过程的一部分程序: PROCEDURE SAP_MAN_ROUTING_SO (CITEM_ID VARCHAR2, C ...

- db2查看当前用户模式及当前用户的权限

1.连接数据库:db2 connect to appdb 2.查询当前用户模式:select current schema from sysibm.sysdummy1 或 select current ...

- 转:SqlBulkCopy类进行大数据(一万条以上)插入测试

转自:https://www.cnblogs.com/LenLi/p/3903641.html 结合博主实例,自己测试了一下,把数据改为3万行更明显!! 关于上一篇博客中提到的,在进行批量数据插入数据 ...

- React Native商城项目实战14 - 首页中间下部分

1.MiddleBottomView.js /** * 首页中间下部分 */ import React, { Component } from 'react'; import { AppRegistr ...

- React-Native 之 GD (二十一)APP 打包

1.生成一个签名密钥: 在 /android/app 下运行 说明:keytool -genkey -v -keystore my-release-key.keystore -alias my-key ...

- 用JS实现将十进制转化为二进制

- 用 Redis 实现 PHP 的简单消息队列

参考:PHP高级编程之消息队列 消息队列就是在消息的传输过程中,可以保存消息的容器. 常见用途: 存储转发:异步处理耗时的任务 分布式事务:多个消费者消费同一个消息队列 应对高并发:通过消息队列保存任 ...

- Shell脚本中单引号(‘)和双引号(“)的使用区别

在Linux操作系统上编写Shell脚本时候,我们是在变量的前面使用$符号来获取该变量的值,通常在脚本中使用”$param”这种带双引号的格式,但也有出现使用'$param'这种带引号的使用的场景,首 ...