【大数据应用期末总评】Hadoop综合大作业

作业要求来自:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339

一、Hadoop综合大作业 要求:

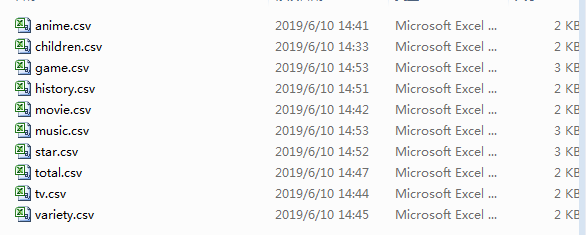

1.将爬虫大作业产生的csv文件上传到HDFS

爬取的数据总共有10个表格(分别是不同类别)

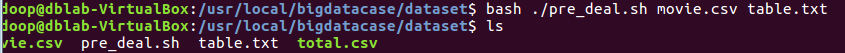

2.对CSV文件进行预处理生成无标题文本文件

对字段进行预处理:

查看生成的table.txt:

3.把hdfs中的文本文件最终导入到数据仓库Hive中

启动hdfs:

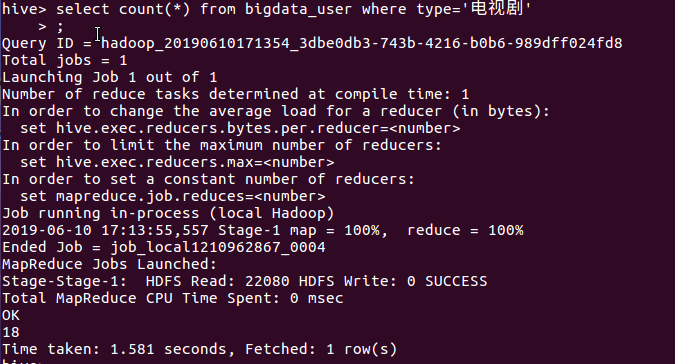

4.在Hive中查看并分析数据

5.用Hive对爬虫大作业产生的进行数据分析,写一篇博客描述你的分析过程和分析结果。(10条以上的查询分析)

(1)查询总榜中(total.csv)总共有多少条不重复数据:

分析:查询发现表格中总共有51行数据不重复,展现了数据的确切性和真实性。

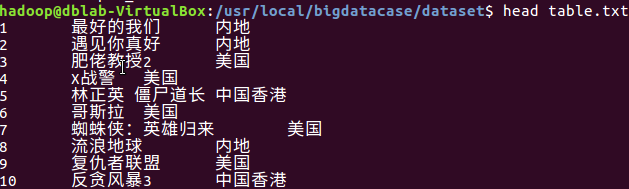

(2)查询总榜中(total.csv)类别属于电视剧的视频总数:

分析:查询结果得总榜中有18条都是属于电视剧,占比为36%,也就是差不多三分之一都是电视剧。这也就说明了大家在腾讯视频上偏爱看电视剧。

既然大家都喜爱看电视剧,那么我们就来查查看有关于电视剧的数据,看看大家都在看什么电视剧。

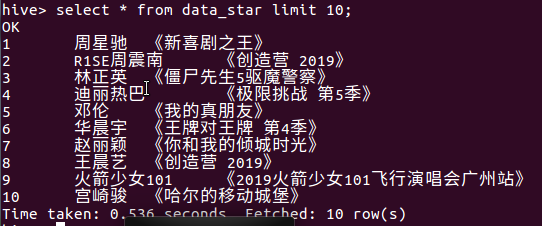

(3)查询电视剧榜中(tv.csv)排行前九的电视剧名称及其地区:

分析:排行榜前列的电视剧都是最近在网络热议上爆火的电视剧,特别是排行榜第一的《破冰行动》,经常上微博热搜,它讲述了两代缉毒警察为"雷霆扫毒"专项行动奉献热血与生命的故事。排行第三四的均是古装剧,也说明了古装剧受到了大家的偏爱。

电视剧列表的地区清一色都是内地的电视剧,那么我们来查查看上榜的电视剧有多少是地区属于内地的。

(4)查询电视剧榜中(tv.csv)中地区属于内地的总数:

分析:查询结果得排行榜中总共有49个电视剧是属于内地电视剧,占比高达98%,可以说基本是来自内地的电视剧,也就说明了比起其他地区的电视剧,大家还是比较喜欢看内地的电视剧。

既然内地电视剧占比如此大,我们来看看都是哪些内地电视剧。

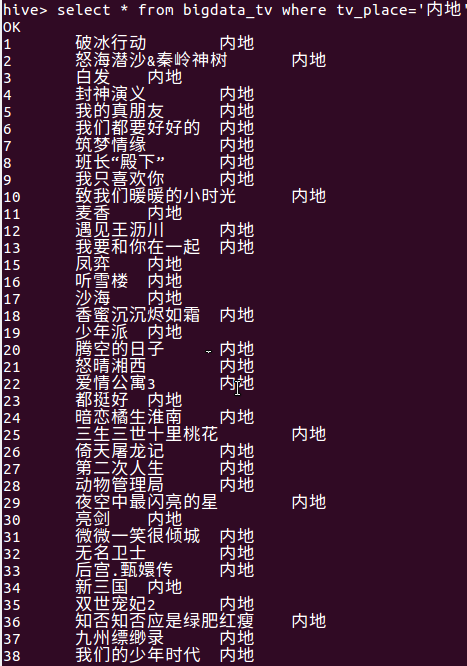

(5)查询电视剧榜中(tv.csv)地区属于内地的电视剧:

分析:查询结果得均是我们最近热播的剧集,包含了很多不同的种类,从古装到现代,从爱情到悬疑,各种各样的电视剧都是老百姓的喜爱。

之后我们来查查看是否有来自美国的电视剧上榜。

(6)查询电视剧榜中(tv.csv)地区属于美国的电视剧:

分析:查询到了有一条数据地区属于美国的,那就是排行第14的《权力的游戏 第八季》,这是一部获奖无数的电视剧,现在连载到第八季,深受大家的喜爱。

看完电数据排行榜我们来看看电影排行榜。

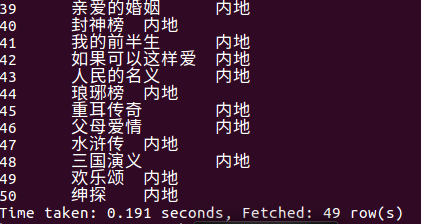

(7)查询电影榜中(movie.csv)排行前九的电影名称及其地区:

分析:排行第一的是最近新上映的青春爱情电影《最好的我们》,临近初高中毕业季,这种类型的片子最受大家的偏爱。后面的大部分是科幻大片较多,并且长期处于排行榜的前列。

(8)查询电影榜(movie.csv)中属于内地的电影:

分析:查询结果可以看出排行榜中有不少电影是来自中国内地的,也能映射出最近几年中国内地的电影事业发展越来越好,越来越多观众喜欢看我国的电影。而且其中喜剧占比最大,这里十九部电影中有七部都是喜剧,这也说明大家偏爱观看中国的喜剧。

看完电影榜来看看明星榜。

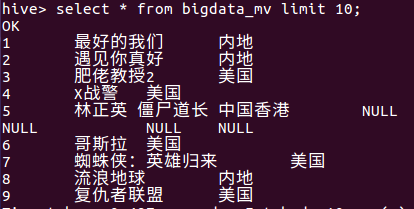

(9)查询明星榜中(star.csv)排行前九的明星名称及其代表作:

分析:果然说到影视业不能不提及的就是我们的“星爷”周星驰,明星榜排行第一,秒杀了许多最近新出的小鲜肉。往下的名列便是在年青一代家喻户晓的的歌手或演员,还有他们最近火热的综艺电影或电视剧。

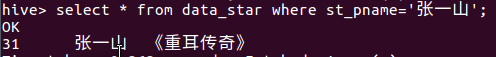

(10)查询明星榜中(star.csv)中明星张一山是否上榜:

分析:查询结果得明星张一山位于明星榜的第31位,其最近的火热作品是《重耳传奇》,是一部古装剧。

(11)查询明星榜中(star.csv)中代表作名为《地久天长》的明星:

分析:查询了一下是否有参演《地久天长》的明星上榜明星榜,结果找到了00后的明星王源,是凭借着《地久天长》这部电影上榜,并且排行第35位。

总结:这次hadoop综合大作业的数据是用了新的数据,因此离上次期中作业检查隔了有一段的时间,排行榜排名有变动,因此我把十个表都重新爬了一次,数据都是最新的。经过这次,学会了在hive上用sql语句查询之后发现这样子分析数据方便了许多。尽管我有十个表格那么多,把他们都上传到hdfs后仍然能清晰地查询出我想要的数据。这节课受益匪浅,以后有需要分析数据也会选择用这种方法。

【大数据应用期末总评】Hadoop综合大作业的更多相关文章

- 大数据应用期末总评——Hadoop综合大作业

作业要求来自:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 Hadoop综合大作业 要求: 1.将爬虫大作业产生的csv文件 ...

- 大数据应用期末总评Hadoop综合大作业

作业要求来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 1.将爬虫大作业产生的csv文件上传到HDFS 此次作业选取的 ...

- 大数据应用期末总评(hadoop综合大作业)

作业要求源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 一.将爬虫大作业产生的csv文件上传到HDFS (1)在/usr ...

- Hadoop综合大作业

Hadoop综合大作业 要求: 用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)词频统计. 用Hive对爬虫大作业产生的csv文件进行数据分析 1. 用Hive对爬虫大作业产 ...

- 《Hadoop综合大作业》

作业要求来自于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3339 我主要的爬取内容是关于热门微博文章“996”与日剧<我要 ...

- 菜鸟学IT之Hadoop综合大作业

Hadoop综合大作业 作业来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 1.将爬虫大作业产生的csv文件上传到HDF ...

- Hadoop综合大作业1

本次作业来源于:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE1/homework/3363 一.课程评分标准: 分数组成: 考勤 10 平时作业 30 爬 ...

- 大数据平台搭建(hadoop+spark)

大数据平台搭建(hadoop+spark) 一.基本信息 1. 服务器基本信息 主机名 ip地址 安装服务 spark-master 172.16.200.81 jdk.hadoop.spark.sc ...

- 大数据学习系列之四 ----- Hadoop+Hive环境搭建图文详解(单机)

引言 在大数据学习系列之一 ----- Hadoop环境搭建(单机) 成功的搭建了Hadoop的环境,在大数据学习系列之二 ----- HBase环境搭建(单机)成功搭建了HBase的环境以及相关使用 ...

随机推荐

- js原型链的看法

原型链 对象 对象: 1,函数对象:由function创造出来的函数 2,普通对象:除开函数对象之外的对象,都是普通对象 **即普通对象obj是构造函数Object的一个实例,因此: obj.__pr ...

- Linux安装和配置MySQL5.7【修改密码、修改字符集等配置】(5.7.18+版本也可参考,我是5.7.22)

本文是转载篇,这里是 原文原文原文. --------------------分割线------------------------------- 这下面内容讲述如何修改密码为简单密码(比如:1234 ...

- MySQL高可用架构应该考虑什么? 你认为应该如何设计?

一.MySQL高可用架构应该考虑什么? 对业务的了解,需要考虑业务对数据库一致性要求的敏感程度,切换过程中是否有事务会丢失 对于基础设施的了解,需要了解基础设施的高可用的架构.例如 单网线,单电源等情 ...

- Java开发环境之MongoDB

查看更多Java开发环境配置,请点击<Java开发环境配置大全> 伍章:MongoDB安装教程 1)官网下载MongoDB安装包 https://www.mongodb.com/downl ...

- LFS7.10——构建LFS系统

参考:LFS7.10——准备Host系统 LFS7.10——构造临时Linux系统 本文正式开始构建LFS系统,后面所有命令的执行都是在root用户下完成的. 这时开始构建LFS前准备工作 更改$LF ...

- Jenkins服务器的安装

Jenkins服务器的安装 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.安装jdk 详情请参考:https://www.cnblogs.com/yinzhengjie/p/1 ...

- 基于JFinal中搭建wopi协议支撑办法

1.添加maven依赖 <dependency> <groupId>com.github.icecooly</groupId> <artifactId> ...

- 第二次作业之——AchaoCalculator

AchaoCalculator(阿超计算器) GIT地址 我的GitHub GIT用户名 Pastrain 学号后五位 62213 博客地址 我的博客地址 作业链接 作业内容 Part.1 配置VS中 ...

- windows10访问ftp中文乱码怎么办?

windows10访问ftp中文乱码怎么办? 打开控制面板 选择时间和区域 选择更改数字格式 点击管理并点击更改系统区域设置 打勾

- 《老子》是帝王术,提倡复古,崇拜圣人,主张愚民,甘居下流,不争上游:4星|李零《人往低处走:<老子>天下第一》

“ 俗话说,“人往高处走,水往低处流”.<老子>正好相反,它强调的是作“天下谷”.“天下溪”.“天下之牝”,甘居下流,不争上游(第28和第61章).司马谈说,道家的特点是“去健羡,绌聪 ...