一张900w的数据表,16s执行的SQL优化到300ms?

- 一,前言

- 证实

有一张财务流水表,未分库分表,目前的数据量为9555695,分页查询使用到了limit,优化之前的查询耗时16 s 938 ms (execution: 16 s 831 ms, fetching: 107 ms),按照下文的方式调整SQL后,耗时347 ms (execution: 163 ms, fetching: 184 ms);

操作: 查询条件放到子查询中,子查询只查主键ID,然后使用子查询中确定的主键关联查询其他的属性字段;

原理: 减少回表操作;

-- 优化前SQL

SELECT 各种字段

FROM `table_name`

WHERE 各种条件

LIMIT 0,10;

-- 优化后SQL

SELECT 各种字段

FROM `table_name` main_tale

RIGHT JOIN

(

SELECT 子查询只查主键

FROM `table_name`

WHERE 各种条件

LIMIT 0,10;

) temp_table ON temp_table.主键 = main_table.主键

找到的原理分析:MySQL 用 limit 为什么会影响性能?

一,前言

首先说明一下MySQL的版本:

mysql> select version();

+-----------+

| version() |

+-----------+

| 5.7.17 |

+-----------+

1 row in set (0.00 sec)

表结构:

mysql> desc test;

+--------+---------------------+------+-----+---------+----------------+

| Field | Type | Null | Key | Default | Extra |

+--------+---------------------+------+-----+---------+----------------+

| id | bigint(20) unsigned | NO | PRI | NULL | auto_increment |

| val | int(10) unsigned | NO | MUL | 0 | |

| source | int(10) unsigned | NO | | 0 | |

+--------+---------------------+------+-----+---------+----------------+

3 rows in set (0.00 sec)

id为自增主键,val为非唯一索引。

灌入大量数据,共500万:

mysql> select count(*) from test;

+----------+

| count(*) |

+----------+

| 5242882 |

+----------+

1 row in set (4.25 sec)

我们知道,当limit offset rows中的offset很大时,会出现效率问题:

mysql> select * from test where val=4 limit 300000,5;

+---------+-----+--------+

| id | val | source |

+---------+-----+--------+

| 3327622 | 4 | 4 |

| 3327632 | 4 | 4 |

| 3327642 | 4 | 4 |

| 3327652 | 4 | 4 |

| 3327662 | 4 | 4 |

+---------+-----+--------+

5 rows in set (15.98 sec)

为了达到相同的目的,我们一般会改写成如下语句:

mysql> select * from test a inner join (select id from test where val=4 limit 300000,5) b on a.id=b.id;

+---------+-----+--------+---------+

| id | val | source | id |

+---------+-----+--------+---------+

| 3327622 | 4 | 4 | 3327622 |

| 3327632 | 4 | 4 | 3327632 |

| 3327642 | 4 | 4 | 3327642 |

| 3327652 | 4 | 4 | 3327652 |

| 3327662 | 4 | 4 | 3327662 |

+---------+-----+--------+---------+

5 rows in set (0.38 sec)

时间相差很明显。

为什么会出现上面的结果?我们看一下select * from test where val=4 limit 300000,5;的查询过程:

查询到索引叶子节点数据。根据叶子节点上的主键值去聚簇索引上查询需要的全部字段值。

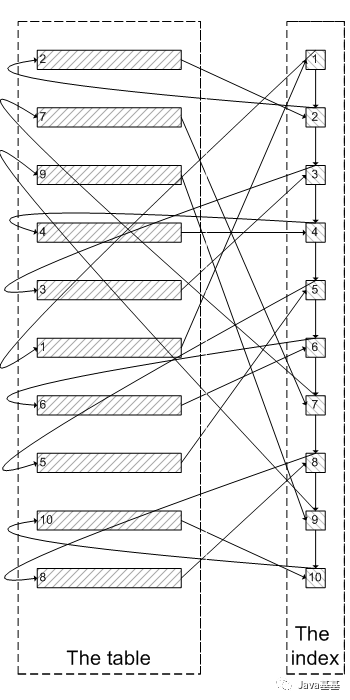

类似于下面这张图:

像上面这样,需要查询300005次索引节点,查询300005次聚簇索引的数据,最后再将结果过滤掉前300000条,取出最后5条。MySQL耗费了大量随机I/O在查询聚簇索引的数据上,而有300000次随机I/O查询到的数据是不会出现在结果集当中的。

肯定会有人问:既然一开始是利用索引的,为什么不先沿着索引叶子节点查询到最后需要的5个节点,然后再去聚簇索引中查询实际数据。这样只需要5次随机I/O,类似于下面图片的过程:

其实我也想问这个问题。

证实

下面我们实际操作一下来证实上述的推论:

为了证实select * from test where val=4 limit 300000,5是扫描300005个索引节点和300005个聚簇索引上的数据节点,我们需要知道MySQL有没有办法统计在一个sql中通过索引节点查询数据节点的次数。我先试了Handler_read_*系列,很遗憾没有一个变量能满足条件。

我只能通过间接的方式来证实:

InnoDB中有buffer pool。里面存有最近访问过的数据页,包括数据页和索引页。所以我们需要运行两个sql,来比较buffer pool中的数据页的数量。预测结果是运行select * from test a inner join (select id from test where val=4 limit 300000,5); 之后,buffer pool中的数据页的数量远远少于select * from test where val=4 limit 300000,5;对应的数量,因为前一个sql只访问5次数据页,而后一个sql访问300005次数据页。

select * from test where val=4 limit 300000,5

mysql> select index_name,count(*) from information_schema.INNODB_BUFFER_PAGE where INDEX_NAME in('val','primary') and TABLE_NAME like '%test%' group by index_name;Empty set (0.04 sec)

可以看出,目前buffer pool中没有关于test表的数据页。

mysql> select * from test where val=4 limit 300000,5;

+---------+-----+--------+

| id | val | source |

+---------+-----+--------+|

3327622 | 4 | 4 |

| 3327632 | 4 | 4 |

| 3327642 | 4 | 4 |

| 3327652 | 4 | 4 |

| 3327662 | 4 | 4 |

+---------+-----+--------+

5 rows in set (26.19 sec) mysql> select index_name,count(*) from information_schema.INNODB_BUFFER_PAGE where INDEX_NAME in('val','primary') and TABLE_NAME like '%test%' group by index_name;

+------------+----------+

| index_name | count(*) |

+------------+----------+

| PRIMARY | 4098 |

| val | 208 |

+------------+----------+2 rows in set (0.04 sec)

可以看出,此时buffer pool中关于test表有4098个数据页,208个索引页。

select * from test a inner join (select id from test where val=4 limit 300000,5) ;为了防止上次试验的影响,我们需要清空buffer pool,重启mysql。 mysqladmin shutdown

/usr/local/bin/mysqld_safe &

mysql> select index_name,count(*) from information_schema.INNODB_BUFFER_PAGE where INDEX_NAME in('val','primary') and TABLE_NAME like '%test%' group by index_name; Empty set (0.03 sec)

运行sql:

mysql> select * from test a inner join (select id from test where val=4 limit 300000,5) b on a.id=b.id;

+---------+-----+--------+---------+

| id | val | source | id |

+---------+-----+--------+---------+

| 3327622 | 4 | 4 | 3327622 |

| 3327632 | 4 | 4 | 3327632 |

| 3327642 | 4 | 4 | 3327642 |

| 3327652 | 4 | 4 | 3327652 |

| 3327662 | 4 | 4 | 3327662 |

+---------+-----+--------+---------+

5 rows in set (0.09 sec) mysql> select index_name,count(*) from information_schema.INNODB_BUFFER_PAGE where INDEX_NAME in('val','primary') and TABLE_NAME like '%test%' group by index_name;

+------------+----------+

| index_name | count(*) |

+------------+----------+

| PRIMARY | 5 |

| val | 390 |

+------------+----------+

2 rows in set (0.03 sec)

我们可以看明显的看出两者的差别:第一个sql加载了4098个数据页到buffer pool,而第二个sql只加载了5个数据页到buffer pool。符合我们的预测。也证实了为什么第一个sql会慢:读取大量的无用数据行(300000),最后却抛弃掉。而且这会造成一个问题:加载了很多热点不是很高的数据页到buffer pool,会造成buffer pool的污染,占用buffer pool的空间。 遇到的问题

为了在每次重启时确保清空buffer pool,我们需要关闭innodb_buffer_pool_dump_at_shutdown和innodb_buffer_pool_load_at_startup,这两个选项能够控制数据库关闭时dump出buffer pool中的数据和在数据库开启时载入在磁盘上备份buffer pool的数据。

Java 的知识面非常广,面试问的涉及也非常广泛,重点包括:Java 基础、Java 并发,JVM、MySQL、数据结构、算法、Spring、微服务、MQ 等等,涉及的知识点何其庞大,所以我们在复习的时候也往往无从下手,今天小编给大家带来一套 Java 面试题,题库非常全面,包括 Java 基础、Java 集合、JVM、Java 并发、Spring全家桶、Redis、MySQL、Dubbo、Netty、MQ 等等,包含 Java 后端知识点 2000 +

资料获取方式:关注公众号:“程序员白楠楠”获取上述资料

一张900w的数据表,16s执行的SQL优化到300ms?的更多相关文章

- 2016/05/13 thinkphp 3.2.2 ① 数据删除及执行原生sql语句 ②表单验证

[数据删除及执行原生sql语句] delete() 返回受影响的记录条数 $goods -> delete(30); 删除主键值等于30的记录信息 $goods -> delete( ...

- Mysql学习---视图/触发器/存储过程/函数/执行计划/sql优化 180101

视图 视图: 视图是一个虚拟表(非真实存在),动态获取数据,仅仅能做查询操作 本质:[根据SQL语句获取动态的数据集,并为其命名],用户使用时只需使用[名称]即可获取结果集,并可以将其当作表来使用.由 ...

- 大数据量高并发访问SQL优化方法

保证在实现功能的基础上,尽量减少对数据库的访问次数:通过搜索参数,尽量减少对表的访问行数,最小化结果集,从而减轻网络负担:能够分开的操作尽量分开处理,提高每次的响应速度:在数据窗口使用SQL时,尽量把 ...

- SQL Server 查看数据表占用空间大小的SQL语句

) ) if object_id('tempdb..#space') is not null drop table #space ),rows ),data ),index_size ),unused ...

- 4W条人才表循环处理业务sql优化过程

场景: 使用windows服务定时更新合同数据:执行存储过程(pas_RefreshContractStatus),但存储过程里面有一个需要更新4W条人才表循环处理业务 问题: 循环更新4W条人才表状 ...

- 从两表连接看Oracle sql优化器的效果

select emp.*,dept.* from tb_emp03 emp,tb_dept03 dept where emp.deptno=dept.id -- 不加hint SQL> sele ...

- MySQL数据库查询某个库下有几张数据表

如果统计某数据库中存在多少张数据表,使用如下SQL检索语句即可: SELECT COUNT(*) TABLES, table_schema FROM information_schema.TABLES ...

- 大数据技术之_19_Spark学习_03_Spark SQL 应用解析 + Spark SQL 概述、解析 、数据源、实战 + 执行 Spark SQL 查询 + JDBC/ODBC 服务器

第1章 Spark SQL 概述1.1 什么是 Spark SQL1.2 RDD vs DataFrames vs DataSet1.2.1 RDD1.2.2 DataFrame1.2.3 DataS ...

- Oracle 11g系列:数据表对象

Oracle数据库的下一层逻辑结构并非数据表,而是表空间.每个数据表都属于唯一的表空间. 1.Oracle表空间 与数据表相同,Oracle表空间是一个逻辑对象,而非物理对象,是数据库的组成部分.当使 ...

随机推荐

- 持续集成工具之jenkins+sonarqube做代码扫描

上一篇我们主要聊了下代码质量管理平台sonarqube的安装部署以及它的工作方式做了简单的描述和代码扫描演示:回顾请参考https://www.cnblogs.com/qiuhom-1874/p/13 ...

- go mod 使用bee工具

https://github.com/beego/bee/releases bee windows https://github.com/beego/bee/releases/download/v1 ...

- Python可迭代对象和迭代器对象

可迭代对象iterable: 对象字面意思:Python中一切皆对象.一个实实在在存在的值. 可迭代:更新迭代.迭代是一个重复的过程,每次重复是基于上一次的结果而继续的,每次都有新的内容. 可迭代对象 ...

- C++学习笔记---引用的本质

本质:引用本质上是C++内部实现的一个指针常量 发现是引用的话,自动帮我们转换成指针常量 运行后,发现修改ref的值那么a的值也会一起改变,这就说明了引用的本质就是指针

- GO-数据类型

目录 数据类型 1.分类 2.布尔类型 3.整型 4.浮点型 5.字符类型 6.字符串 7.复数类型 数据类型 1.分类 Go语言内置以下这些基础类型: 类型 名称 长度 零值 说明 bool 布尔类 ...

- SSM中 spring-mvc.xml 配置文件

<!--扫描控制器包--><context:component-scan base-package="<!--控制器包所在路径-->">< ...

- sentinel控制台与应用通信原理

1,应用程序配置中的port选项用于指定在应用端启动的http server的端口,默认8719 sentinel: transport: dashboard: localhost:8080 port ...

- 利用python3监控服务器状态进行邮件报警

在正式的生产环境中,我们常常会需要监控服务器的状态,以保证公司整个业务的正常运转,常常我们会用到像nagios.zabbix这类工具进行实时监控,那么用python我们怎么进行监控呢?这里我们利用了p ...

- 关于GIT配置公私钥

问题:pull代码时显示 原因:公钥与私钥对不上,或者没有配置导致 解决: 1.生成私钥:TortoiseGIT → PuttyGen → Generate(点击后鼠标晃动会加速)→Save Priv ...

- Docker(1)- 什么是 Docker

如果你还想从头学起 Docker,可以看看这个系列的文章哦! https://www.cnblogs.com/poloyy/category/1690628.html 备注 这里的概念直接引用官方的, ...