Python爬虫入门教程:豆瓣Top电影爬取

基本开发环境

- Python 3.6

- Pycharm

相关模块的使用

- requests

- parsel

- csv

安装Python并添加到环境变量,pip安装需要的相关模块即可。

爬虫基本思路

一、明确需求

爬取豆瓣Top250排行电影信息

- 电影名字

- 导演、主演

- 年份、国家、类型

- 评分、评价人数

- 电影简介

二、发送请求

Python中的大量开源的模块使得编码变的特别简单,我们写爬虫第一个要了解的模块就是requests。

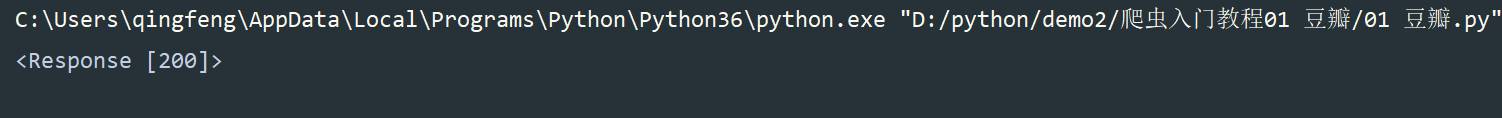

请求url地址,使用get请求,添加headers请求头,模拟浏览器请求,网页会给你返回response对象

# 模拟浏览器发送请求

import requests

url = 'https://movie.douban.com/top250'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

print(response)

200是状态码,表示请求成功

2xx (成功)

3xx (重定向)

4xx(请求错误)

5xx(服务器错误)

常见状态码

- 200 - 服务器成功返回网页,客户端请求已成功。

- 302 - 对象临时移动。服务器目前从不同位置的网页响应请求,但请求者应继续使用原有位置来进行以后的请求。

- 304 - 属于重定向。自上次请求后,请求的网页未修改过。服务器返回此响应时,不会返回网页内容。

- 401 - 未授权。请求要求身份验证。 对于需要登录的网页,服务器可能返回此响应。

- 404 - 未找到。服务器找不到请求的网页。

- 503 (服务不可用) 服务器目前无法使用(由于超载或停机维护)。通常,这只是暂时状态。

三、获取数据

import requests

url = 'https://movie.douban.com/top250'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

print(response.text)

requests.get(url=url, headers=headers) 请求网页返回的是response对象

response.text: 获取网页文本数据

response.json: 获取网页json数据

这两个是用的最多的,当然还有其他的

apparent_encoding cookies history

iter_lines ok close

elapsed is_permanent_redirect json

raise_for_status connection encoding

is_redirect links raw

content headers iter_content

next reason url

四、解析数据

常用解析数据方法: 正则表达式、css选择器、xpath、lxml…

常用解析模块:bs4、parsel…

我们使用的是 parsel 无论是在之前的文章,还是说之后的爬虫系列文章,我都会使用 parsel 这个解析库,无它就是觉得它比bs4香。

parsel 是第三方模块,pip install parsel 安装即可

parsel 可以使用 css、xpath、re解析方法

所有的电影信息都包含在 li 标签当中。

# 把 response.text 文本数据转换成 selector 对象

selector = parsel.Selector(response.text)

# 获取所有li标签

lis = selector.css('.grid_view li')

# 遍历出每个li标签内容

for li in lis:

# 获取电影标题 hd 类属性 下面的 a 标签下面的 第一个span标签里面的文本数据 get()输出形式是 字符串获取一个 getall() 输出形式是列表获取所有

title = li.css('.hd a span:nth-child(1)::text').get() # get()输出形式是 字符串

movie_list = li.css('.bd p:nth-child(1)::text').getall() # getall() 输出形式是列表

star = movie_list[0].strip().replace('\xa0\xa0\xa0', '').replace('/...', '')

movie_info = movie_list[1].strip().split('\xa0/\xa0') # ['1994', '美国', '犯罪 剧情']

movie_time = movie_info[0] # 电影上映时间

movie_country = movie_info[1] # 哪个国家的电影

movie_type = movie_info[2] # 什么类型的电影

rating_num = li.css('.rating_num::text').get() # 电影评分

people = li.css('.star span:nth-child(4)::text').get() # 评价人数

summary = li.css('.inq::text').get() # 一句话概述

dit = {

'电影名字': title,

'参演人员': star,

'上映时间': movie_time,

'拍摄国家': movie_country,

'电影类型': movie_type,

'电影评分': rating_num,

'评价人数': people,

'电影概述': summary,

}

# pprint 格式化输出模块

pprint.pprint(dit)

以上的知识点使用到了

- parsel 解析模块的方法

- for 循环

- css 选择器

- 字典的创建

- 列表取值

- 字符串的方法:分割、替换等

- pprint 格式化输出模块

所以扎实基础是很有必要的。不然你连代码都不知道为什么要这样写。

五、保存数据(数据持久化)

常用的保存数据方法 with open

像豆瓣电影信息这样的数据,保存到Excel表格里面会更好。

所以需要使用到 csv 模块

# csv模块保存数据到Excel

f = open('豆瓣电影数据.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['电影名字', '参演人员', '上映时间', '拍摄国家', '电影类型',

'电影评分', '评价人数', '电影概述'])

csv_writer.writeheader() # 写入表头

这就是爬取了数据保存到本地了。这只是一页的数据,爬取数据肯定不只是爬取一页数据。想要实现多页数据爬取,就要分析网页数据的url地址变化规律。

可以清楚看到每页url地址是 25 递增的,使用for循环实现翻页操作

for page in range(0, 251, 25):

url = f'https://movie.douban.com/top250?start={page}&filter='

完整实现代码

""""""

import pprint

import requests

import parsel

import csv

'''

1、明确需求:

爬取豆瓣Top250排行电影信息

电影名字

导演、主演

年份、国家、类型

评分、评价人数

电影简介

'''

# csv模块保存数据到Excel

f = open('豆瓣电影数据.csv', mode='a', encoding='utf-8', newline='')

csv_writer = csv.DictWriter(f, fieldnames=['电影名字', '参演人员', '上映时间', '拍摄国家', '电影类型',

'电影评分', '评价人数', '电影概述'])

csv_writer.writeheader() # 写入表头

# 模拟浏览器发送请求

for page in range(0, 251, 25):

url = f'https://movie.douban.com/top250?start={page}&filter='

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

# 把 response.text 文本数据转换成 selector 对象

selector = parsel.Selector(response.text)

# 获取所有li标签

lis = selector.css('.grid_view li')

# 遍历出每个li标签内容

for li in lis:

# 获取电影标题 hd 类属性 下面的 a 标签下面的 第一个span标签里面的文本数据 get()输出形式是 字符串获取一个 getall() 输出形式是列表获取所有

title = li.css('.hd a span:nth-child(1)::text').get() # get()输出形式是 字符串

movie_list = li.css('.bd p:nth-child(1)::text').getall() # getall() 输出形式是列表

star = movie_list[0].strip().replace('\xa0\xa0\xa0', '').replace('/...', '')

movie_info = movie_list[1].strip().split('\xa0/\xa0') # ['1994', '美国', '犯罪 剧情']

movie_time = movie_info[0] # 电影上映时间

movie_country = movie_info[1] # 哪个国家的电影

movie_type = movie_info[2] # 什么类型的电影

rating_num = li.css('.rating_num::text').get() # 电影评分

people = li.css('.star span:nth-child(4)::text').get() # 评价人数

summary = li.css('.inq::text').get() # 一句话概述

dit = {

'电影名字': title,

'参演人员': star,

'上映时间': movie_time,

'拍摄国家': movie_country,

'电影类型': movie_type,

'电影评分': rating_num,

'评价人数': people,

'电影概述': summary,

}

pprint.pprint(dit)

csv_writer.writerow(dit)

实现效果

Python爬虫入门教程:豆瓣Top电影爬取的更多相关文章

- Python爬虫入门教程 8-100 蜂鸟网图片爬取之三

蜂鸟网图片--啰嗦两句 前几天的教程内容量都比较大,今天写一个相对简单的,爬取的还是蜂鸟,依旧采用aiohttp 希望你喜欢 爬取页面https://tu.fengniao.com/15/ 本篇教程还 ...

- Python爬虫入门教程 6-100 蜂鸟网图片爬取之一

1. 蜂鸟网图片--简介 国庆假日结束了,新的工作又开始了,今天我们继续爬取一个网站,这个网站为 http://image.fengniao.com/ ,蜂鸟一个摄影大牛聚集的地方,本教程请用来学习, ...

- Python爬虫入门教程 5-100 27270图片爬取

27270图片----获取待爬取页面 今天继续爬取一个网站,http://www.27270.com/ent/meinvtupian/ 这个网站具备反爬,so我们下载的代码有些地方处理的也不是很到位, ...

- Python爬虫入门教程: 27270图片爬取

今天继续爬取一个网站,http://www.27270.com/ent/meinvtupian/ 这个网站具备反爬,so我们下载的代码有些地方处理的也不是很到位,大家重点学习思路,有啥建议可以在评论的 ...

- Python爬虫入门教程 7-100 蜂鸟网图片爬取之二

蜂鸟网图片--简介 今天玩点新鲜的,使用一个新库 aiohttp ,利用它提高咱爬虫的爬取速度. 安装模块常规套路 pip install aiohttp 运行之后等待,安装完毕,想要深造,那么官方文 ...

- Python爬虫入门教程 48-100 使用mitmdump抓取手机惠农APP-手机APP爬虫部分

1. 爬取前的分析 mitmdump是mitmproxy的命令行接口,比Fiddler.Charles等工具方便的地方是它可以对接Python脚本. 有了它我们可以不用手动截获和分析HTTP请求和响应 ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- Python爬虫入门教程 43-100 百思不得姐APP数据-手机APP爬虫部分

1. Python爬虫入门教程 爬取背景 2019年1月10日深夜,打开了百思不得姐APP,想了一下是否可以爬呢?不自觉的安装到了夜神模拟器里面.这个APP还是比较有名和有意思的. 下面是百思不得姐的 ...

- [Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息

[Python爬虫] 使用 Beautiful Soup 4 快速爬取所需的网页信息 2018-07-21 23:53:02 larger5 阅读数 4123更多 分类专栏: 网络爬虫 版权声明: ...

随机推荐

- Cocos Creator 新资源管理系统剖析

目录 1.资源与构建 1.1 creator资源文件基础 1.2 资源构建 1.2.1 图片.图集.自动图集 1.2.2 Prefab与场景 1.2.3 资源文件合并规则 2. 理解与使用 Asset ...

- 利用Python下载:You-Get的安装及使用方法

You-Get是一个非常优秀的网站视频下载工具.使用You-Get可以很轻松的下载到网络上的视频.图片及音乐. 1.打开这个网址https://www.python.org/ 下载并安装Python, ...

- 【Java集合】HashSet源码解析以及HashSet与HashMap的区别

HashSet 前言 HashSet是一个不可重复且元素无序的集合.内部使用HashMap实现. 我们可以从HashSet源码的类注释中获取到如下信息: 底层基于HashMap实现,所以迭代过程中不能 ...

- 【Oracle】Oracle SQL的优化软件

对于SQL开发人员和DBA来说,根据业务需求写出一条正确的SQL很容易.但是SQL的执行性能怎么样呢?能优化一下跑得更快吗?如果不是资深 DBA,估计很多人都没有信心. 幸运的是,自动化优化工具可以 ...

- pg_rman的安装与使用

1.下载对应数据库版本及操作系统的pg_rman源码 https://github.com/ossc-db/pg_rman/releases 本例使用的是centos6.9+pg10,因此下载的是pg ...

- 阿里云VOD(二)

一.准备工作 1.设置不转码 测试之前设置默认"不转码",以节省开发成本 2.找到子账户的AccessKey ID 3.给子账户添加授权 AliyunVODFullAccess 4 ...

- Kubernetes调整Node节点快速驱逐pod的时间

在高可用的k8s集群中,当Node节点挂掉,kubelet无法提供工作的时候,pod将会自动调度到其他的节点上去,而调度到节点上的时间需要我们慎重考量,因为它决定了生产的稳定性.可靠性,更快的迁移可以 ...

- /bin/sh: cc: command not found

make的时候报错:/bin/sh: cc: command not found 解决: 1. sudo yum -y install gcc gcc-c++ libstdc++-devel 2. m ...

- 使用Jmeter对SHA1加密接口进行性能测试

性能测试过程中,有时候会遇到需要对信息头进行加密鉴权,下面我就来介绍如何针对SHA1加密鉴权开发性能测试脚本1.首先了解原理,就是需要对如下三个参数进行SHA1加密,(AppSecret + Nonc ...

- vue.esm.js?efeb:628 [Vue warn]: Invalid prop: type check failed for prop "defaultActive". Expected String with value "0", got Number with value 0.

vue.esm.js?efeb:628 [Vue warn]: Invalid prop: type check failed for prop "defaultActive". ...