利用scrapy和MongoDB来开发一个爬虫

今天我们利用scrapy框架来抓取Stack Overflow里面最新的问题(),并且将这些问题保存到MongoDb当中,直接提供给客户进行查询。

安装

在进行今天的任务之前我们需要安装二个框架,分别是Scrapy (1.1.0)和pymongo (3.2.2).

scrapy

如果你运行的的系统是osx或者linux,可以直接通过pip进行安装,而windows需要另外安装一些依赖,因为电脑的原因不对此进行讲解。

$ pip install Scrapy

一旦安装完成之后你可以直接在python shell当中输入下面的命令,倘若没有出现错误的话,说明已安装完成

>>> import scrapy

>>>

安装PyMongo和mongodb

因为系统是osx的,所以直接通过下面的语句就可以安装。

brew install mongodb

运行mongodb同样特别的简单,只需要在终端下面输入下面的语法:

mongod --dbpath=.

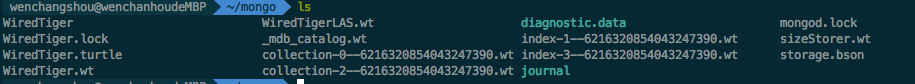

--dbpath是指定数据库存放的路径,运行之后会在该路径下面生成一些文件

下一步我们就需要安装PyMongo,同样采用pip的方式

$ pip install pymongo

Scrapy 项目

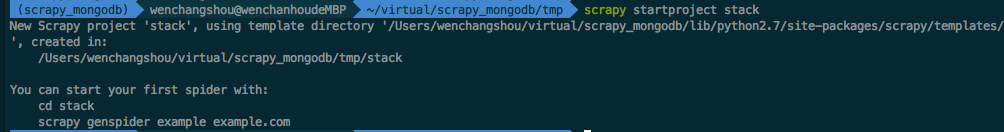

我们来创建一个新的scrapy的项目,在终端输入下面的语法

$ scrapy startproject stack

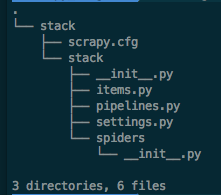

一旦上面的命令完成之后,scrapy会直接创建相应的文件,这些文件包含了基本的信息,便于你来修改相应的内容。

定义数据

items.py文件用于我们定义需要抓取对象的存储的“容器“

有关StackItem()预定义时并让其继承于scrapy.Item

# -*- coding: utf-8 -*-

# Define here the models for your scraped items

#

# See documentation in:

# http://doc.scrapy.org/en/latest/topics/items.html

import scrapy

class StackItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

pass

这里我们需要在里面添加两个字段,分别用来存放抓取到的标题以及链接

from scrapy.item import Item,Field

class StackItem(Item):

# define the fields for your item here like:

title=Field()

url=Field()

创建爬虫

我们需要在spider文件夹下面创建一个stack_spider.py的文件,这个里面包容我们爬虫进行抓取时的行为。就是告诉爬虫我们需要抓取哪些内容以及内容的来源。

from scrapy import Spider

from scrapy.selector import Selector

from stack.items import StackItem

class StackSpider(Spider):

name="stack"

allowed_domains=['stackoverflow.com']

start_urls = [

"http://stackoverflow.com/questions?pagesize=50&sort=newest",

]

- name 是定义爬虫的名称

- allowed_domains 指定爬虫进行爬取的域地址

- start_urls 定义爬虫需要抓取的网页的url地址

XPath 选择

scrapy使用XPath来进行匹配相应的数据的来源,html是一种标记的语法,里面定义了很多的标签和属性,比如说我们定义一个下面的这样的一个标签,这里我们就可以通过'//div[@class="content"]'来找到这个标记,找到之后我们可以取出其中的属性或者它的子节点

<div class='content'>

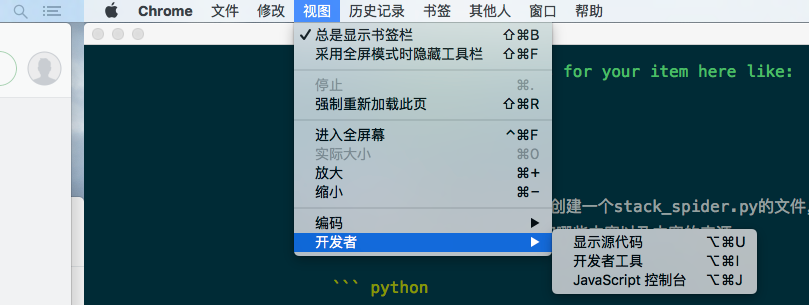

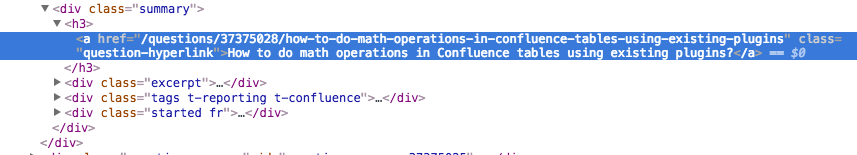

下面我们通过chrome来讲解如果找到xpath的路径 ,在进行操作之前我们需要打开开发者工具,可以点击菜单栏上面的视图->开发者->开发者工具来打进入开发者模式,或者可以根据快捷捷来进行打开。

打开之后我们在需要的内容上面点击右击会弹出一个菜单,这里我们可以选择检查来找到当前的内容在html相应的位置

这里chrome会自动帮助我们找到相应的位置,通过下面的分析,我们知道标题的路径是包含在一个

现在我们来更新相应的stack_spider.py脚本

from scrapy import Spider

from scrapy.selector import Selector

from stack.items import StackItem

class StackSpider(Spider):

name="stack"

allowed_domains=['stackoverflow.com']

start_urls = [

"http://stackoverflow.com/questions?pagesize=50&sort=newest",

]

def parse(self,response):

questions=Selector(response).xpath('//div[@class="summary"]/h3')

提取数据

创建抓取的规约之后,我们需要与刚才创建的items实体进行关联,我们继续修改stack_spider.py文件

from scrapy import Spider

from scrapy.selector import Selector

from stack.items import StackItem

class StackSpider(Spider):

name="stack"

allowed_domains=['stackoverflow.com']

start_urls = [

"http://stackoverflow.com/questions?pagesize=50&sort=newest",

]

def parse(self,response):

questions=Selector(response).xpath('//div[@class="summary"]/h3')

for question in questions:

item=StackItem()

item['title'] = question.xpath(

'a[@class="question-hyperlink"]/text()').extract()[0]

item['url'] = question.xpath(

'a[@class="question-hyperlink"]/@href').extract()[0]

yield item

通过遍历所有的符合//div[@class="summary"]/h3的元素,并且从中找到我们真正需要爬取的元素内容

测试

现在我们进行测试,只要在项目的目录下面运行以下的脚本就可以进行测试 。

scrapy crawl stack

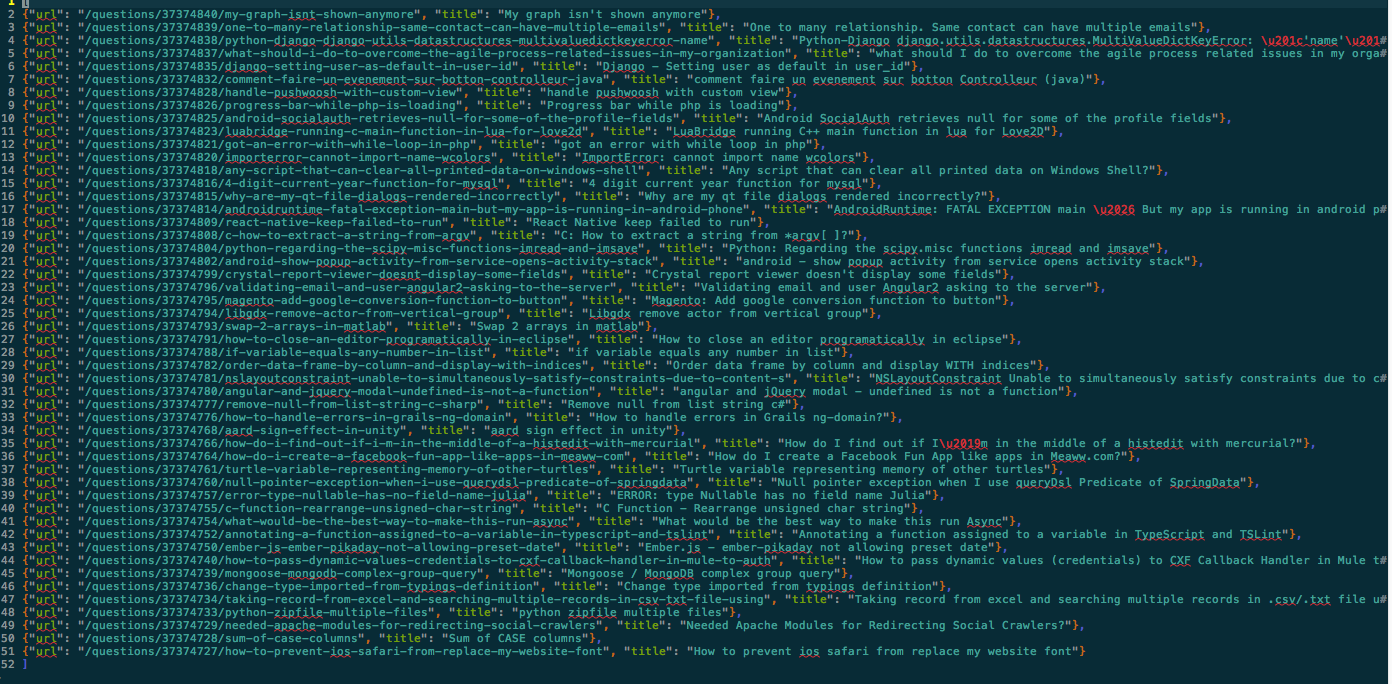

现在我们需要将爬取到的所有的信息保存到一个文件当中,可以在后面添加二个参数-o和-t

scrapy crawl stack -o items.json -t json

下面是实际保存的文件的内容分别包含了title和url

将元素存放入MongoDB

这里我们需要将所有的元素保存到Mongodb collection当中。

在进行操作之前我们需要在setinngs.py指定相应的pipeline和添加一些数据库的参数

ITEM_PIPELINES = {

'stack.pipelines.MongoDBPipeline': 300,

}

MONGODB_SERVER = "localhost"

MONGODB_PORT = 27017

MONGODB_DB = "stackoverflow"

MONGODB_COLLECTION = "questions"

pipeline 管理

在之前的步骤里面我们分别已经完成了对html的解析,以及指定数据的存储。但是这时所有的信息都在内存当中,我们需要将这些爬取到数据存储到数据库当中,这里就轮到pipelines.py上场了,这玩意就负责对数据的存储的。

在上面我们已经定义了数据库的参数,现在我们终于派上用场了。

import pymongo

from scrapy.conf import settings

from scrapy.exceptions import DropItem

from scrapy import log

class MongoDBPipeline(object):

def __init__(self):

connection=pymongo.MongoClient(

settings['MONGODB_SERVER'],

settings['MONGODB_PORT']

)

db=connection[settings['MONGODB_DB']]

self.collection=db[settings['MONGODB_COLLECTION']]

上面的代码是我们创建了一个MongoDBPipeline()的类,以及定义初始化函数,用来读取刚才的参数来创建一个Mongo的连接。

数据处理

下一步我们需要定义一个函数来处理解析的数据

# -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: http://doc.scrapy.org/en/latest/topics/item-pipeline.html

import pymongo

from scrapy.conf import settings

from scrapy.exceptions import DropItem

from scrapy import log

class MongoDBPipeline(object):

def __init__(self):

connection=pymongo.MongoClient(

settings['MONGODB_SERVER'],

settings['MONGODB_PORT']

)

db=connection[settings['MONGODB_DB']]

self.collection=db[settings['MONGODB_COLLECTION']]

def process_item(self,item,spider):

valid=True

for data in item:

if not data:

valid=False

raise DropItem('Missing{0}!'.format(data))

if valid:

self.collection.insert(dict(item))

log.msg('question added to mongodb database!',

level=log.DEBUG,spider=spider)

return item

上面已经完成了对数据的连接,以及相应数据的存储

测试

我们同样在stack目录当中运行下面的命令

$ scrapy crawl stack

当内容执行完成之后没有出现任何的错误的提示,恭喜你已经将数据正确的存入到mongodb当中。

这里我们通过Robomongo来访问数据库的时候发现创建了一个stackoverflow的数据库,下面已经成功创建了一个名为questions的Collections.并且已经存入了相应的数据了。

利用scrapy和MongoDB来开发一个爬虫的更多相关文章

- python scrapy 入门,10分钟完成一个爬虫

在TensorFlow热起来之前,很多人学习python的原因是因为想写爬虫.的确,有着丰富第三方库的python很适合干这种工作. Scrapy是一个易学易用的爬虫框架,尽管因为互联网多变的复杂性仍 ...

- 如何利用scrapy新建爬虫项目

抓取豆瓣top250电影数据,并将数据保存为csv.json和存储到monogo数据库中,目标站点:https://movie.douban.com/top250 一.新建项目 打开cmd命令窗口,输 ...

- Python 开发轻量级爬虫08

Python 开发轻量级爬虫 (imooc总结08--爬虫实例--分析目标) 怎么开发一个爬虫?开发一个爬虫包含哪些步骤呢? 1.确定要抓取得目标,即抓取哪些网站的哪些网页的哪部分数据. 本实例确定抓 ...

- 利用scrapy抓取网易新闻并将其存储在mongoDB

好久没有写爬虫了,写一个scrapy的小爬爬来抓取网易新闻,代码原型是github上的一个爬虫,近期也看了一点mongoDB.顺便小用一下.体验一下NoSQL是什么感觉.言归正传啊.scrapy爬虫主 ...

- webmagic的设计机制及原理-如何开发一个Java爬虫

之前就有网友在博客里留言,觉得webmagic的实现比较有意思,想要借此研究一下爬虫.最近终于集中精力,花了三天时间,终于写完了这篇文章.之前垂直爬虫写了一年多,webmagic框架写了一个多月,这方 ...

- python爬虫实战:利用scrapy,短短50行代码下载整站短视频

近日,有朋友向我求助一件小事儿,他在一个短视频app上看到一个好玩儿的段子,想下载下来,可死活找不到下载的方法.这忙我得帮,少不得就抓包分析了一下这个app,找到了视频的下载链接,帮他解决了这个小问题 ...

- Python下用Scrapy和MongoDB构建爬虫系统(1)

本文由 伯乐在线 - 木羊 翻译,xianhu 校稿.未经许可,禁止转载!英文出处:realpython.com.欢迎加入翻译小组. 这篇文章将根据真实的兼职需求编写一个爬虫,用户想要一个Python ...

- webmagic的设计机制及原理-如何开发一个Java爬虫 转

此文章是webmagic 0.1.0版的设计手册,后续版本的入门及用户手册请看这里:https://github.com/code4craft/webmagic/blob/master/user-ma ...

- 【爬虫】利用Scrapy抓取京东商品、豆瓣电影、技术问题

1.scrapy基本了解 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架.可以应用在包括数据挖掘, 信息处理或存储历史数据等一系列的程序中.其最初是为了页面抓取(更确切来说,网络抓 ...

随机推荐

- Angular的自定义指令以及实例

本文章已收录于: AngularJS知识库 分类: javascript(55) http://www.cnblogs.com/xiaoxie53/p/5058198.html 前面的文章介 ...

- 利用模板将HTML从JavaScript中抽离

利用模板将HTML从JavaScript中抽离 一.当需要注入大段的HTML标签到页面中时,应该使用服务器渲染(从服务器加载HTML标签) 该方法将模板放置于服务器中使用XMLHttpRequest对 ...

- Nessus的安装(Linux)

Nessus有三种安装方式: 1.源文件安装 源文件安装是最复杂的安装方式,用此方式安装可以修改配置参数. 2.rpm安装 rpm安装比起源文件安装更简单一些,它已经把一些底层的东西写好了,用户只要按 ...

- Dagger2 (二) 进阶篇

一.作用域Scope 之前了解RoboGuice的时候,我们知道它默认给我们提供了几个注解,ContextSingleton和Singleton,但是Dagger2更为灵活,只有javax包中提供的S ...

- 原创 C++应用程序在Windows下的编译、链接(四)动态链接

4动态链接 4.1概述 在静态链接阶段,链接器为PE文件生成了导入表,导出表,符号表,并调整了Call指令后面的操作数,在程序调用的时候,能够直接地或者间接地定位到IAT中的某个位置,在PE文件中,该 ...

- C#用链式方法表达循环嵌套

情节故事得有情节,不喜欢情节的朋友可看第1版代码,然后直接跳至“三.想要链式写法” 一.起缘 故事缘于一位朋友的一道题: 朋友四人玩LOL游戏.第一局,分别选择位置:中单,上单,ADC,辅助:第二局新 ...

- 错误: “WebForm_DoPostBackWithOptions”未定义

无论是ASP.NET WebForm 还是 ASP.NET MVC项目,在本地程序测试没问题,但是部署在IIS上访问就会出现 错误: “WebForm_DoPostBackWithOptions”未 ...

- 3.raid基础应用

raid分为软备份和硬备份 软备份主要用来实验 应备份用于生产环境 raid0(带区卷) 具有很高的数据传输率,没有数据的冗余 1块磁盘 raid1(镜像卷) 提供数据冗余,利用率低 2块 ...

- 域普通用户执行金蝶K/3权限不够解决方法

一.问题 公司财务部的机器加入域后,用户一直授予本地管理员的权限,主管坚持要撤销管理员权限,而金蝶K3没管理员权限又无法执行. 报错信息为“注册表许可权不够,请参考安装目录的帮助档案进行许可权的配置. ...

- 【Linux管理】用户管理

每次玩linux都会去网上找一些命令,想想应该记录一下,希望方便大家,当然更方便自己. 1.添加用户 useradd username//添加用户 passwd username//设置密码 2.配置 ...