005.Ceph文件系统基础使用

一 Ceph文件系统

1.1 概述

- 需要一个已经正常运行的ceph集群;

- 至少包含一个ceph元数据服务器(MDS)。

1.2 相关名词

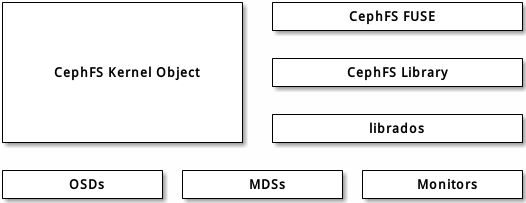

1.3 客户端I/O机制

- client端与mds节点通讯,获取metadata信息(metadata也存在osd上)

- client直接写数据到osd

1.4 挂载ceph文件系统的方式

- 使用本地系统内核驱动程序进行挂载

- 使用ceph fuse进行挂载

二 文件系统使用

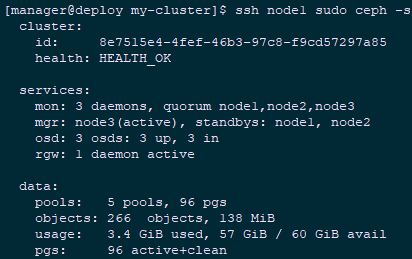

2.1 查看集群

- [root@deploy ~]# su - manager

- [manager@deploy ~]$ cd my-cluster/

- [manager@deploy my-cluster]$ ssh node1 sudo ceph -s

2.2 创建MDS

- [root@deploy ~]# su - manager

- [manager@deploy ~]$ cd my-cluster/

- [manager@deploy my-cluster]$ ssh node1 sudo ceph mds stat #查看mds信息

- , 1 up:standby

2.3 创建文件系统

- [manager@deploy my-cluster]$ ssh node1 sudo ceph osd pool create cephfs_data 16 16 #创建data pool

- [manager@deploy my-cluster]$ ssh node1 sudo ceph osd pool create cephfs_metadata 16 16 #创建metadata pool

- [manager@deploy my-cluster]$ ssh node1 sudo ceph fs new cephfs cephfs_metadata cephfs_data #创建cephfs

- [manager@deploy my-cluster]$ ssh node1 sudo ceph fs ls #查看验证

- name: cephfs, metadata pool: cephfs_metadata, data pools: [cephfs_data ]

- [manager@deploy my-cluster]$ ssh node1 sudo ceph mds stat

- cephfs-1/1/1 up {0=node1=up:active} #再次查看mds信息

2.4 创建认证密钥

- [root@node1 ~]# cat /etc/ceph/ceph.client.admin.keyring #查看key

- [client.admin]

- key = AQDs9D1cCanyJBAA/rj991xmzENsIgEesfe8KQ==

- [root@cephclient ~]# vi /root/admin.secret #客户端创建key

- AQDs9D1cCanyJBAA/rj991xmzENsIgEesfe8KQ==

三 客户端使用文件系统(内核驱动)

3.1 客户端执行挂载

- [root@cephclient ~]# mkdir /mnt/mycephfs

- [root@cephclient ~]# mount -t ceph -o name=admin,secretfile=/root/admin.secret \

- 172.24.8.72:6789:/ /mnt/mycephfs/ #执行挂载并附带key文件

2.6 确认验证

- [root@cephclient ~]# df -hT

- Filesystem Type Size Used Avail Use% Mounted on

- ……

- 172.24.8.72:6789:/ ceph 18G 0 18G 0% /mnt/mycephfs

- [root@cephclient ~]# echo 'This is my test file!' >>/mnt/mycephfs/test.txt

四 客户端使用文件系统(FUSE)

4.1 安装FUSE相关包

- [root@cephclient ~]# yum -y install ceph-fuse

- [manager@deploy my-cluster]$ ceph-deploy --overwrite-conf mon add cephclient

4.2 客户端执行挂载

- [root@cephclient ~]# mkdir /mnt/mycephfs

- [root@cephclient ~]# ceph-fuse -k /etc/ceph/ceph.client.admin.keyring -m 172.24.8.72:6789 /mnt/mycephfs/ #执行挂载并附带key文件

4.3 确认验证

- [root@cephclient ~]# df -hT

- Filesystem Type Size Used Avail Use% Mounted on

- ……

- ceph-fuse fuse.ceph-fuse 18G 0 18G 0% /mnt/mycephfs

- [root@cephclient ~]# echo 'This is my test file!' >>/mnt/mycephfs/test2.txt

参考:http://docs.ceph.com/docs/master/start/quick-rbd/

005.Ceph文件系统基础使用的更多相关文章

- 理解 OpenStack + Ceph (4):Ceph 的基础数据结构 [Pool, Image, Snapshot, Clone]

本系列文章会深入研究 Ceph 以及 Ceph 和 OpenStack 的集成: (1)安装和部署 (2)Ceph RBD 接口和工具 (3)Ceph 物理和逻辑结构 (4)Ceph 的基础数据结构 ...

- ceph 文件系统(cephfs) -- 初体验

一.介绍: ceph MDS 是元数据服务器,只有ceph 文件系统(cephFS)才会需要. cephFS 在RADOS 层之上 提供一个兼容POSIX 的文件系统.他是用MDS 作为守护进程,负责 ...

- ceph存储基础概念

一.分布式文件系统: 是指文件系统管理的物理存储资源不一定直接是连接在本地节点上,而是通过计算机网络与节点相连. 分布式文件系统的设计基与C/S架构(客户端/服务器) 常见的分布式文件系统:Ceph. ...

- Ceph 文件系统 CephFS 的实战配置,等你来学习 -- <4>

Ceph 文件系统 CephFS 的介绍与配置 CephFs介绍 Ceph File System (CephFS) 是与 POSIX 标准兼容的文件系统, 能够提供对 Ceph 存储集群上的文件访问 ...

- ext3文件系统基础

http://blog.csdn.net/haiross/article/category/1488205/2 block size: 是文件系统最小的单位,Ext2/Ext3/Ext4 的区块大 ...

- Ceph 的基础数据结构 [Pool, Image, Snapshot, Clone]

原文链接:http://www.cnblogs.com/sammyliu/p/4843812.html?utm_source=tuicool&utm_medium=referral 1 Poo ...

- Linux性能优化从入门到实战:14 文件系统篇:Linux 文件系统基础

磁盘为系统提供了最基本的持久化存储. 文件系统则在磁盘的基础上,提供了一个用来管理文件的树状结构. 文件系统:索引节点和目录项 文件系统是对存储设备上的文件,进行组织管理的机制.组织方式不 ...

- Linux操作系统文件系统基础知识详解

一 .Linux文件结构 文件结构是文件存放在磁盘等存贮设备上的组织方法.主要体现在对文件和目录的组织上. 目录提供了管理文件的一个方便而有效的途径. Linux使用标准的目录结构,在安装的时候,安装 ...

- 为cloudstack搭建ceph文件系统

1. 安装dell服务器, raid卡需要采用直通模式(non-raid); 各磁盘独立运行. 网络依赖硬件不同,使用万兆网卡或者两个千兆网卡做bonding6. 2. 配置host map(1 ...

随机推荐

- Confluence 6 Oracle 驱动输入你的数据库细节

Confluence 的安装向导将会指导你一步一步的在 Confluence 中配置安装 Oracle 数据库. 使用 JDBC 连接(默认) JDBC 是推荐的连接你的 Confluence 到数据 ...

- 9.jexus 配置ssl

这里非常感谢宇内流云,这是他的博客http://www.cnblogs.com/yunei/. 1,运行环境 CentOS7 jexus5.8.2.9(独立版) jexus 的下载地址 https:/ ...

- NIO(五)

分散读取,聚集写入 package com.cppdy.nio; import java.io.RandomAccessFile; import java.nio.ByteBuffer; import ...

- 使用gulp-babel转换Es6出现exports is not defined 问题

//问题描述:当使用import导入模块时,出现exports is not defined //1.安装插件 npm install --save-dev babel-plugin-transfor ...

- IDEA复制项目操作

- C#接口和泛型类

1.定义: 定义为一个约束,实现接口的类或者结构必须遵守该约定.借口是类之间交互的一个协议.定义了类之间的交互标准. 接口是类之间相互交互的一个抽象,把类之间需要交互的内容抽象出来定义成接口. 接口只 ...

- Android Studio编译OsmAnd出现警告:GeoPointParserUtil.java使用或覆盖了已过时的 API。有关详细信息请使用-Xlint:deprecation重新编译

[背景] 之前折腾: [记录]Android Studio中导入OsmAnd并编译 期间,遇到了编译警告: 1 2 3 4 5 :OsmAnd-java:compileJava 注: E:\crifa ...

- ROW_NUMBER() OVER(PARTITION BY COLUMN ORDER BY COLUMN DESC)函数的使用

ROW_NUMBER() OVER(PARTITION BY COLUMN ORDER BY COLUMN DESC)函数的作用是指定COLUMN(列)进行分区,在分区内指定COLUMN(列)进行排序 ...

- (原创)C# 压缩解压那些事儿

吐槽: 搜狗推广API的报告服务太坑爹了!!! 搜狗推广API的报告服务太坑爹了!!! 搜狗推广API的报告服务太坑爹了!!! 搜狗的太垃圾了,获取下来的压缩包使用正常方式无法解压!!没有专门的API ...

- NEST 之旅 · 开启

NEST 之旅 · 开启 Version:5.x 英文原文地址:Getting started 说实话,这篇文章翻译的很糟糕.但是我的能力有限,目前只有这个水平,还望各位多指导. NEST 是 Ela ...