线上CPU100%排查

生产服务器上部署了几个java程序,突然出现了CPU100%的异常告警,你如何定位出问题?

这个问题分为两版回答!

高调版

对不起,我是做研发的,这个问题在生产上是不可能遇见的!因为研发是不可能直接操作生产服务器,如果贵公司能出现这个问题,应该要反思一下自己的权限控制是否合理!

面试官心里活动:装13是不是,赶紧走!

低调版

这个问题我在生产上没碰到过,因为我们是没法直接操作生产环境的。只能说,在测试环境曾经遇见过。操作步骤如下,balabala…

面试官心里活动:权限控制的不错,应该是在大厂呆过。

我们开始

下面给出两种系统下的排查步骤,都是一模一样的,只是命令稍有区别!

查消耗cpu最高的进程PID

根据PID查出消耗cpu最高的线程号

根据线程号查出对应的java线程,进行处理。

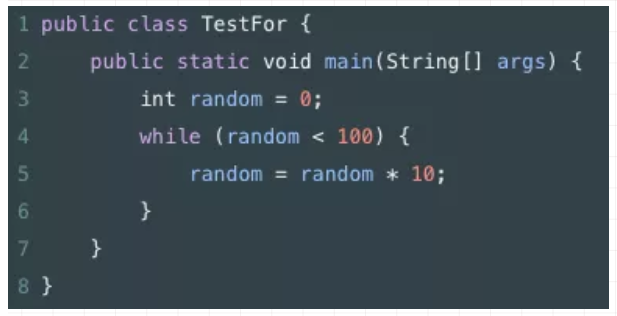

准备一行死循环代码:

怎么跑,应该不用我说了,直接教大家怎么查

windows版

可能有人有疑问,我为什么要说windows版的!因为,我曾经给很多政府部门做过系统。我发现他们用的是windows server,不是linux系统。所有必要说一下!

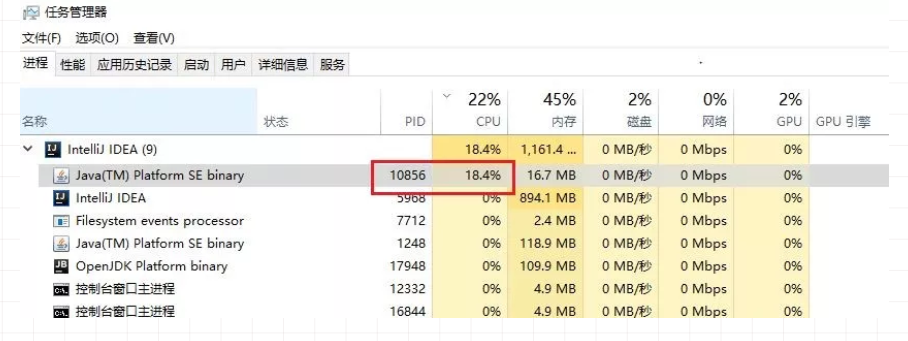

查消耗cpu最高的进程PID

手边没有windows server机器,我以win 10为例,截图给大家看一下,先调出PID显示项!

然后发现进程PID如下图所示,为10856

接下来呢?

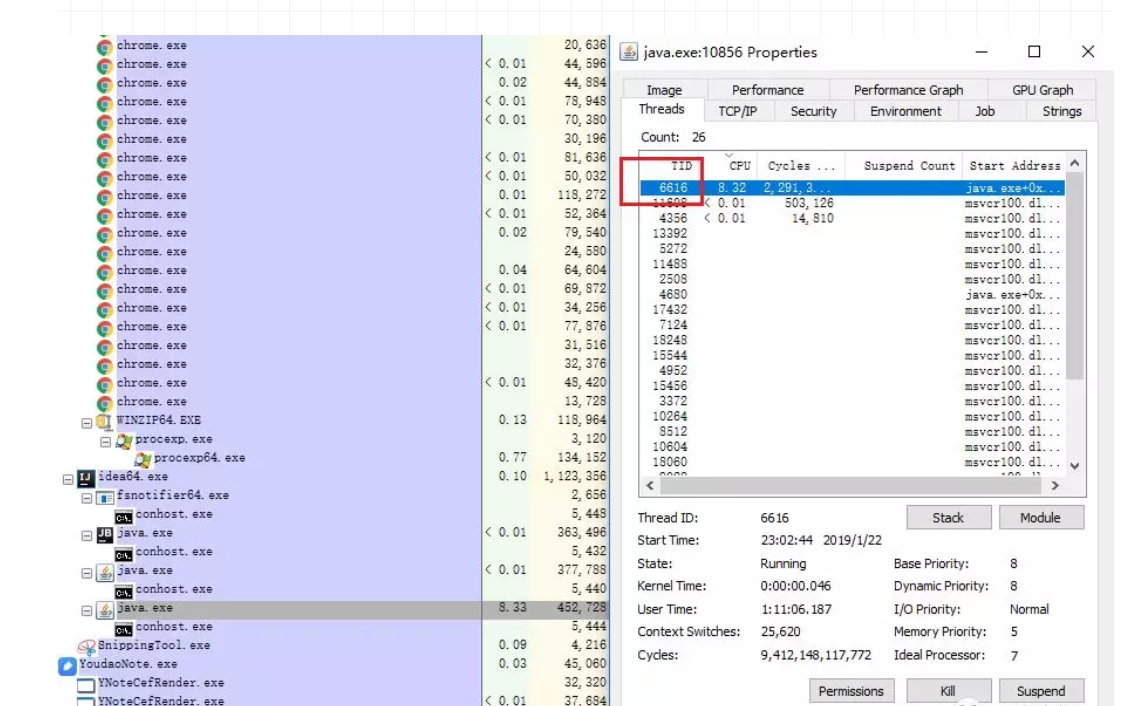

根据PID查出消耗cpu最高的线程号

这里用到微软的工具Process Explorer v16.22,地址如下https://docs.microsoft.com/zh-cn/sysinternals/downloads/process-explorer

如图所示

发现最耗cpu的线程的TId为6616

这是十进制的数据,转成十六进制为19d8

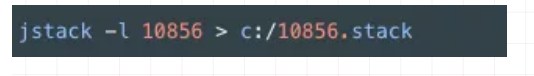

根据线程号查出对应的java线程,进行处理

执行命令,导出进程快照

打开文件 c:/10856.stack,搜索19d8,如下图所示

根据文件就可以看出,我们的TestFor.java文件第七行一直在跑,至此定位到问题

Linux版

Linux版本,步骤是一模一样的,就是命令换了一下

查消耗cpu最高的进程PID

执行命令

执行

top -c,显示进程运行信息列表。按下P,进程按照cpu使用率排序

如下图所示,PID为3033的进程耗费cpu最高

根据PID查出消耗cpu最高的线程号

执行命令

top -Hp 3033,显示一个进程的线程运行信息列表。按下P,进程按照cpu使用率排序

如下图所示,PID为3034的线程耗费cpu最高

这是十进制的数据,转成十六进制为0xbda

根据线程号查出对应的java线程,进行处理

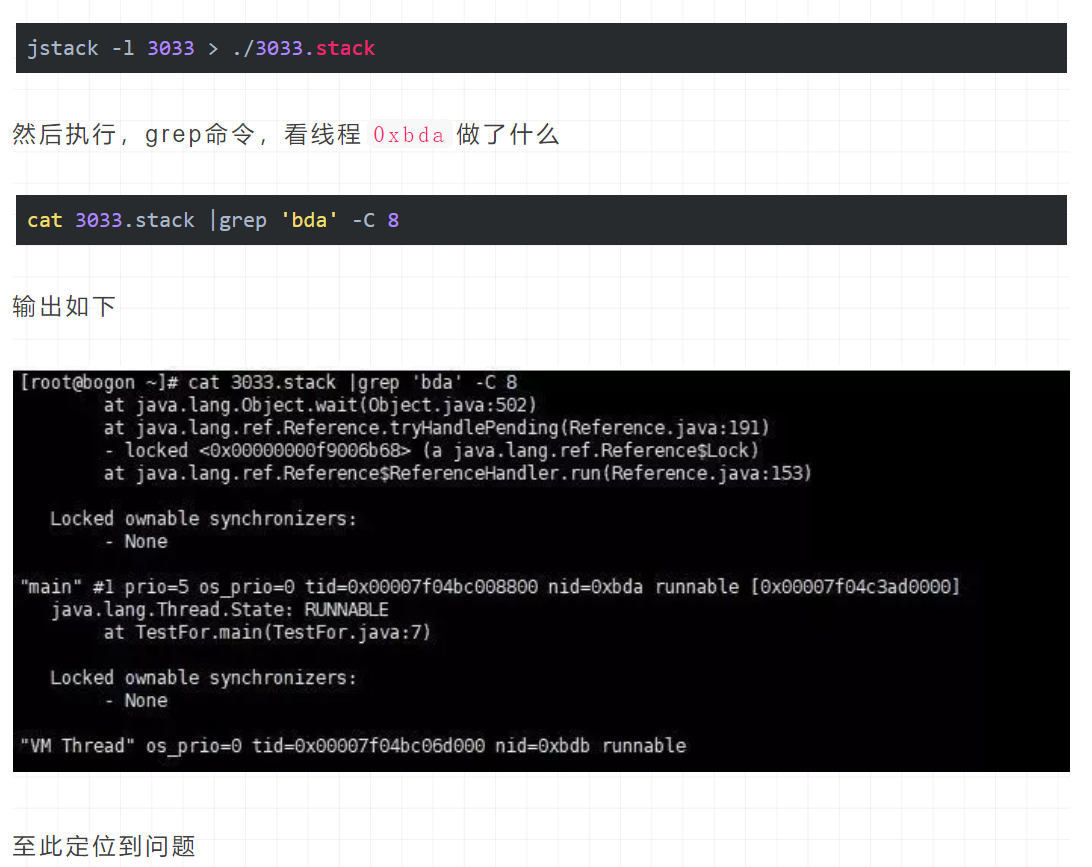

执行命令,导出进程快照

jstack -l 3033 > ./3033.stack

然后执行,grep命令,看线程0xbda做了什么

cat 3033.stack |grep 'bda' -C 8

输出如下

至此定位到问题

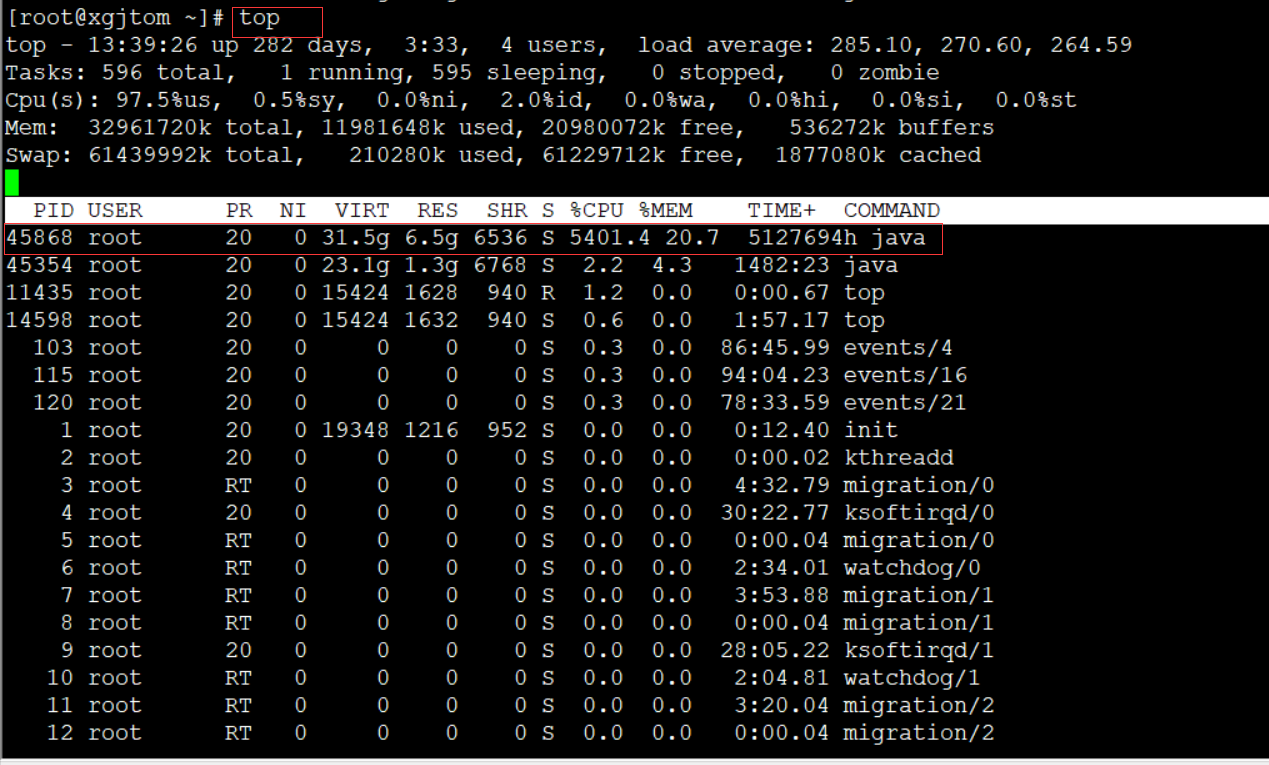

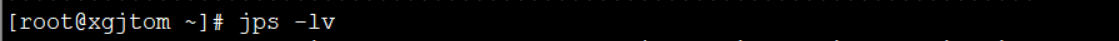

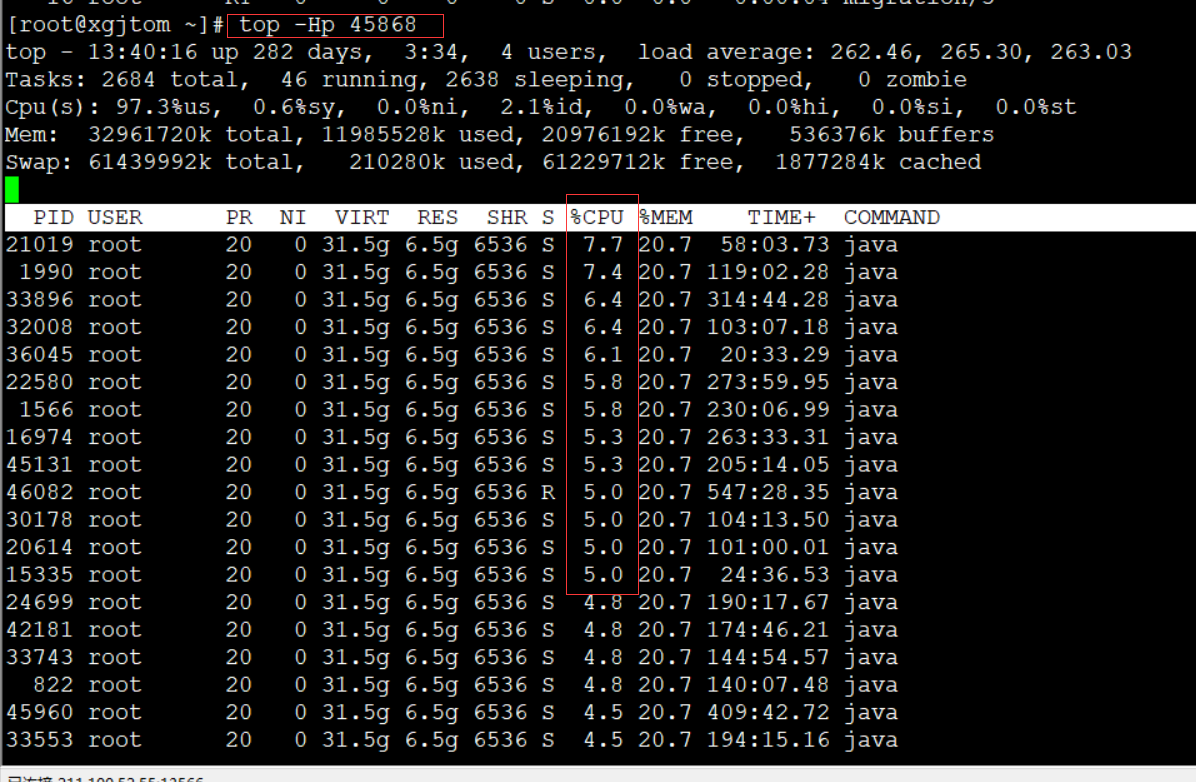

实战:

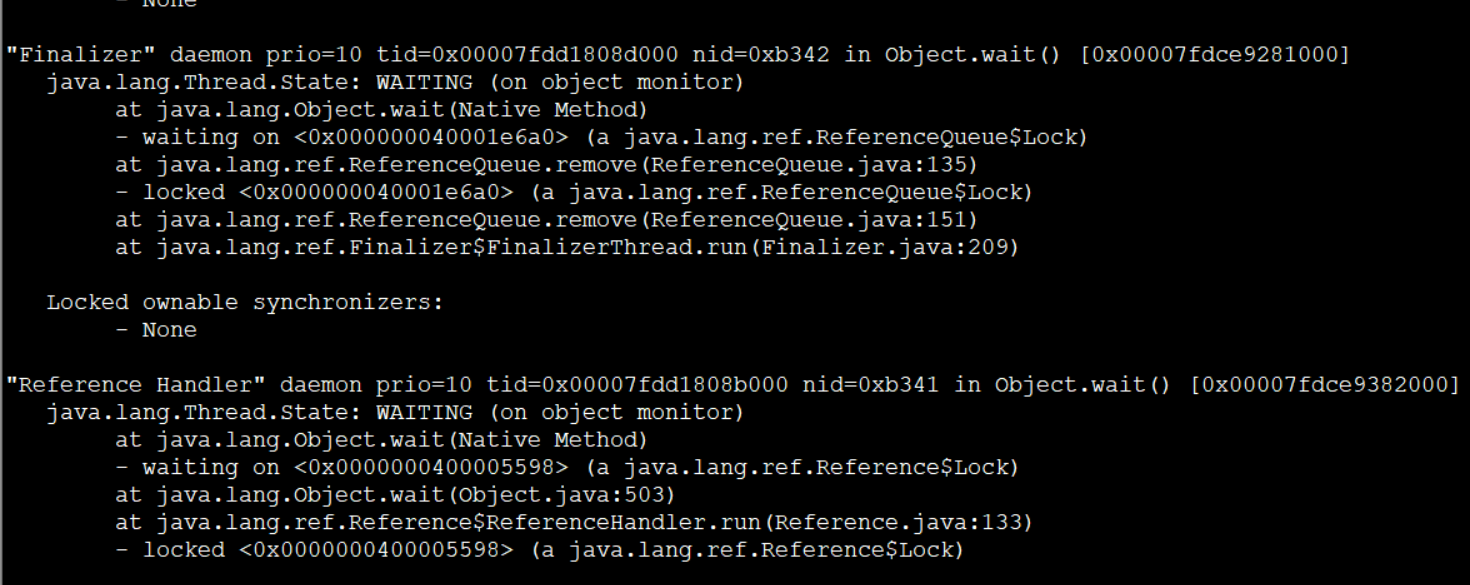

top -Hp 45868 进程下面的所有线程

jstack -l 45868 进程下的错误提示

玩过性能优化的朋友都清楚,性能优化的关键并不在于怎么进行优化,而在于怎么找到当前系统的性能瓶颈。

性能优化分为好几个层次,比如系统层次、算法层次、代码层次…JVM 的性能优化被认为是底层优化,门槛较高,精通这种技能的人比较少。笔者呆过几家技术力量不算弱的公司,每个公司内部真正能够进行 JVM 性能调优的人寥寥无几、甚至没有。如是乎,能够有效通过 JVM 调优提升系统性能的人往往被人们冠以”大牛”、”大师”之类的称呼。

其实 JVM 本身给我们提供了很多强大而有效的监控进程、分析定位瓶颈的工具,比如 JConsole、JMap、JStack、JStat 等等。使用这些命令,再结合 Linux 自身提供的一些强大的进程、线程命令,能够快速定位系统瓶颈。本文以一次使用这些工具准确定位到某系统瓶颈的实战经验为例,希望能为大家掌握 JVM 调优这项技能起到一些借鉴作用。

本文背景:

- Linux:RedHat 6.1

- Weblogic:11g

- JRokit:R28.2.4

- JDK:1.6.0_45

Weblogic 跑在 JRokit 上面,JDK 是我们对 JRokit 进行监控分析的工具。

1. LoadRunner 压测结果

该系统其实早已跑在生产上好多年,虽然没有做过压力测试,但稳定性还是可以的。公司进行架构调整,有一些新系统将对接该系统。公司领导担心对接后该系统的并发性能问题,于是开始对该系统进行并发压力测试。

50 个用户并发压十几个小时,TRT 在 20 左右,TPS 在 2.5 左右。领导对这个结果不满意,要求进行优化。但这是个老系统,开发在之前明显已经对其代码做过很多优化,如今面对这种状况也束手无策。

2. Oracle 的 awr 报告分析

有句老话,优化来优化去,系统的性能瓶颈还是会在数据库上面。在这里我们首先想到的也是数据库的问题。

并发压测的时候 Spotlight 查看数据库服务器各项性能指标,很清闲。

分析 awr 报告,结果显示也是很清闲。

并发压测的时候去相关数据表执行一些 sql 的速度很快也证明着问题不在 Oracle 这边。

3. Weblogic 服务器的性能指标

使用 Spotlight 查看并发压测时的 Weblogic 所在的 Linux 服务器,除了 CPU 之外其它各项指标显示,Linux 也很清闲。

虽然 CPU 利用率始终在 200% 左右徘徊,但这对于 16 核的系统来讲也算是正常的吧?

4. JStack 报告分析

事情到了这里,大家已经想到了线程死锁、等待的问题了。

没错,JStack 隆重登场。JStack 能够看到当前 Java 进程中每个线程的当前状态、调用栈、锁住或等待去锁定的资源,而且很强悍的是它还能直接报告是否有线程死锁,可谓解决线程问题的不二之选。

$ /opt/jdk1.6.0_45/bin/jstack -l 10495 > ~/10495jstack.txt

JRokit 堆栈的拉取,可以直接用 JDK 的 JStack,10495 是 Weblogic 服务的进程 ID。注意一定要用该进程的启动用户去拉,否则会报 Unable to open socket file: target process not responding or HotSpot VM not loaded 错误。

JStack 拉取的文件信息基本分为以下几个部分:

- 该拉取快照的服务器时间

- JVM 版本

- 以线程 ID(即 tid)升序依次列出当前进程中每个线程的调用栈

- 死锁(如果有的话)

- 阻塞锁链

- 打开的锁链

- 监视器解锁情况跟踪

每个线程在等待什么资源,这个资源目前在被哪个线程 hold,尽在眼前。JStack 最好在压测时多次获取,找到的普遍存在的现象即为线程瓶颈所在。

4.1. TLA 空间的调整

多次拉取 JStack,发现很多线程处于这个状态:

at jrockit/vm/Allocator.getNewTla(JJ)V(Native Method)

at jrockit/vm/Allocator.allocObjectOrArray(Allocator.java:354)[optimized]

at java/util/HashMap.resize(HashMap.java:564)[inlined]

at java/util/LinkedHashMap.addEntry(LinkedHashMap.java:414)[optimized]

at java/util/HashMap.put(HashMap.java:477)[optimized]

由此怀疑出现上述堆栈的原因可能是 TLA 空间不足引起。TLA 是 thread local area 的缩写,是每个线程私有的空间,所以在多线程环境下 TLA 带来的性能提升是显而易见的。如果大部分线程的需要分配的对象都较大,可以考虑提高 TLA 空间,因为这样更大的对象可以在 TLA 中进行分配,这样就不用担心和其它线程的同步问题了。但这个也不可以调的太大,否则也会带来一些问题,比如会带来更多内存碎片、更加频繁的垃圾搜集。

TLA 默认最小大小 2 KB,默认首选大小 16 KB – 256 KB (取决于新生代分区大小)。这里我们调整 TLA 空间大小为最小 32 KB,首选 1024 KB,JVM 启动参数中加入:

-XXtlaSize:min=32k,preferred=1024k

5. JStat 结合 GC 日志报告分析

第 4 步参数生效之后继续压测,TLA 频繁申请是降下来了,但 TRT 仍旧是 20,TPS 依旧 2.5。别灰心,改一个地方就立竿见影,胜利似乎来得太快了点。

现在怀疑是服务堆内存太小,查看一下果然。服务器物理内存 32 GB,Weblogic 进程只分到了 6 GB。怎么查看?至少有四种办法:

5.1. ps 命令

$ ps -ef | grep java

defonds 29874 29819 2 Sep03 ? 09:03:17 /opt/jrockit-jdk1.6.0_33/bin/java -jrockit -Xms6000m -Xmx6000m -Dweblogic.Name=AdminServer -Djava.security.policy=

5.2. Weblogic 控制台

登录 Weblogic 管理控制台 -> 环境 -> 服务器,选择该服务器实例 -> 监视 -> 性能 -> 当前堆大小。

这个页面还能看到进程已运行时间,启动以来发生的 GC 次数,可以折算出 GC 的频率,为本次性能瓶颈 – GC 过于频繁提供有力的佐证。

5.3. GC 日志报告

开启 JRokit GC 日志报告只需在 Java 进程启动参数里加入

-Xverbose:memory -Xverboselog:verboseText.txt

GC 日志将会被输出到 verboseText.txt 文件,这个文件一般会生成在启动的 Weblogic 域目录下。如果找不着也可以用 find 命令去搜:

$ find /appserver/ -name verboseText.txt

/appserver/Oracle/Middleware/user_projects/domains/defonds_domain/verboseText.txt

GC log 拿到后,第 3 行中的 maximal heap size 即为该进程分配到的最大堆大小:

[INFO ][memory ] Heap size: 10485760KB, maximal heap size: 10485760KB, nursery size: 5242880KB.

下面还有进程启动以后较为详细的每次 GC 的信息:

[INFO ][memory ] [YC#2547] 340.828-340.845: YC 10444109KB->10417908KB (10485760KB), 0.018 s, sum of pauses 17.294 ms, longest pause 17.294 ms.

[INFO ][memory ] [YC#2548] 340.852-340.871: YC 10450332KB->10434521KB (10485760KB), 0.019 s, sum of pauses 18.779 ms, longest pause 18.779 ms.

[INFO ][memory ] [YC#2549] 340.878-340.895: YC 10476739KB->10485760KB (10485760KB), 0.017 s, sum of pauses 16.520 ms, longest pause 16.520 ms.

[INFO ][memory ] [OC#614] 340.895-341.126: OC 10485760KB->10413562KB (10485760KB), 0.231 s, sum of pauses 206.458 ms, longest pause 206.458 ms.

第一行表示该进程启动后的第 340.828 秒 – 340.845 秒期间进行了一次 young gc,该次 GC 持续了 17.294 ms,将整个已用掉的堆内存由 10444109 KB 降低到 10417908 KB。

第三行同样是一次 young gc,但该次 GC 后已用堆内存反而上升到了 10485760 KB,也就是达到最大堆内存,于是该次 young gc 结束的同时触发 full gc。

第四行是一次 old gc (即 full gc),将已用堆内存由 10485760 KB 降到了 10413562 KB,耗时 206.458 ms。

这些日志同样能够指出当前压力下的 GC 的频率,为本次性能瓶颈 – GC 过于频繁提供有力的佐证。

5.4. JStat 报告

跟 JStack 的拉取一样,可以直接用 JDK 的 JStat 去拉取 JRokit 的 GC 信息:

$ /opt/jdk1.6.0_45/bin/jstat -J-Djstat.showUnsupported=true -snap 10495 > ~/10495jstat.txt

注意这个信息是一个快照,这是跟 GC 日志报告不同的地方。

jrockit.gc.latest.heapSize=10737418240

jrockit.gc.latest.nurserySize=23100384

上述是当前已用碓大小和新生代分区大小。多拉几次即可估算出各自分配的大小。

5.5. 内存分配

根据 5.1 – 5.4 我们得出当前服务器分配堆内存太小的结论,根据 5.3 GC 日志报告和 5.4. JStat 报告可以得出新生代分区太小的结论。

于是我们调整它们的大小,结合 4.1 TLA 调整的结论,JVM 启动参数增加以下:

-Xms10240m -Xmx10240m -Xns:1024m -XXtlaSize:min=32k,preferred=1024k

再次压测,TRT 降到了 2.5,TPS 上升到 20。

6. 性能瓶颈的定位

很明显,上述 JVM 调整没有从根本上解决性能问题,我们还没有真正定位到系统性能瓶颈。

6.1. 性能线程的定位

6.1.1. 性能进程的获取

使用 TOP 命令拿到最耗 CPU 的那个进程:

进程 ID 为 10495 的那个进程一直在占用很高的 CPU。

6.1.2. 性能线程的获取

现在我们来找到这个进程中占用 CPU 较高的那些线程:

$ ps p 10495 -L -o pcpu,pid,tid,time,tname,cmd > ~/10495ps.txt

多次拉这个快照,我们找到了 tid 为 10499、10500、10501、10502 等线程一直在占用着很高的 CPU:

拉 JStack 快照看看都是一些什么线程:

$ /opt/jdk1.6.0_45/bin/jstack -l 10495 > ~/10495jstack.txt

相关部分结果如下:

“(GC Worker Thread 1)” id=? idx=0×10 tid=10499 prio=5 alive, daemon

at pthread_cond_wait@@GLIBC_2.3.2+202(:0)@0x3708c0b44a

at eventTimedWaitNoTransitionImpl+71(event.c:90)@0x7fac47be8528

at eventTimedWaitNoTransition+66(event.c:72)@0x7fac47be8593

at mmGCWorkerThread+137(gcthreads.c:809)@0x7fac47c0774a

at thread_stub+170(lifecycle.c:808)@0x7fac47cc15bb

at start_thread+208(:0)@0x3708c077e1

Locked ownable synchronizers:

- None

“(GC Worker Thread 2)” id=? idx=0×14 tid=10500 prio=5 alive, daemon

at pthread_cond_wait@@GLIBC_2.3.2+202(:0)@0x3708c0b44a

at eventTimedWaitNoTransitionImpl+71(event.c:90)@0x7fac47be8528

at eventTimedWaitNoTransition+66(event.c:72)@0x7fac47be8593

at mmGCWorkerThread+137(gcthreads.c:809)@0x7fac47c0774a

at thread_stub+170(lifecycle.c:808)@0x7fac47cc15bb

at start_thread+208(:0)@0x3708c077e1

Locked ownable synchronizers:

- None

“(GC Worker Thread 3)” id=? idx=0×18 tid=10501 prio=5 alive, daemon

at pthread_cond_wait@@GLIBC_2.3.2+202(:0)@0x3708c0b44a

at eventTimedWaitNoTransitionImpl+71(event.c:90)@0x7fac47be8528

at eventTimedWaitNoTransition+66(event.c:72)@0x7fac47be8593

at mmGCWorkerThread+137(gcthreads.c:809)@0x7fac47c0774a

at thread_stub+170(lifecycle.c:808)@0x7fac47cc15bb

at start_thread+208(:0)@0x3708c077e1

Locked ownable synchronizers:

- None

“(GC Worker Thread 4)” id=? idx=0x1c tid=10502 prio=5 alive, daemon

at pthread_cond_wait@@GLIBC_2.3.2+202(:0)@0x3708c0b44a

at eventTimedWaitNoTransitionImpl+71(event.c:90)@0x7fac47be8528

at eventTimedWaitNoTransition+66(event.c:72)@0x7fac47be8593

at mmGCWorkerThread+137(gcthreads.c:809)@0x7fac47c0774a

at thread_stub+170(lifecycle.c:808)@0x7fac47cc15bb

at start_thread+208(:0)@0x3708c077e1

Locked ownable synchronizers:

- None

6.2. 找到性能瓶颈

事情到了这里,已经不难得出当前系统瓶颈就是频繁 GC。

为何会如此频繁 GC 呢?继续看 JStack,发现这两个互相矛盾的现象:

一方面 GC Worker 线程在拼命 GC,但是 GC 前后效果不明显,已用堆内存始终降不下来;

另一方面大量 ExecuteThread 业务处理线程处于 alloc_enqueue_allocation_and_wait_for_gc 的 native_blocked 阻塞状态。

此外,停止压测以后,查看已用堆内存大小,也就几百兆,不到分配堆内存的 1/10。

这说明了什么呢?这说明了我们应用里没有内存泄漏、静态对象不是太多、有大量的业务线程在频繁创建一些生命周期很长的临时对象。

很明显还是代码里有问题。那么这些对象来自哪里?如何在海量业务代码里边准确定位这些性能代码?也就是说如何利用 JVM 调优驱动代码层面的调优?请参考博客《JVM 性能调优实战之:使用阿里开源工具 TProfiler 在海量业务代码中精确定位性能代码》,使用 TProfiler 我们成功找到了代码里边导致 JVM 频繁 GC 的元凶,并最终解决掉了这个性能瓶颈,将 TRT 降到了 0.5,TPS 提升至 100 +

线上CPU100%排查的更多相关文章

- 【原创】谈谈线上CPU100%排查套路

引言 不知道在大家面试中,有没有遇到这个问题 生产服务器上部署了几个java程序,突然出现了CPU100%的异常告警,你如何定位出问题呢? 这个问题分为两版回答! 高调版 对不起,我是做研发的,这个问 ...

- 谈谈线上CPU100%排查套路

知识点总结 ---------------------------------------------------------------------------------------------- ...

- 告诉你如何回答"线上CPU100%排查"面试问题

不知道在大家面试中,有没有遇到这个问题: 生产服务器上部署了几个java程序,突然出现了CPU100%的异常告警,你如何定位出问题呢? 这个问题分为两版回答!高调版对不起,我是做研发的,这个问题在生产 ...

- 性能分析 | 线上CPU100%排查

不知道在大家面试中,有没有遇到这个问题: 生产服务器上部署了几个java程序,突然出现了CPU100%的异常告警,你如何定位出问题呢? 这个问题分为两版回答! 高调版 对不起,我是做研发的,这个问题在 ...

- 线上 CPU100% 排查方案

问题:生产服务器上部署了几个java程序,突然出现了CPU100%的异常告警,你如何定位出问题呢? 下面给出两种系统下的排查步骤,都是一模一样的,只是命令稍有区别! 查消耗cpu最高的进程PID 根据 ...

- 如何回答“线上CPU100%排查”面试问题

案例: public class App { public static void main( String[] args ) { int a = 0; while (a < 100) { a ...

- BTrace:线上问题排查工具

BTrace简介 GitHub地址:BTrace 下载地址:v1.3.11.3 官方使用教程:Btrace使用教程 使用场景 BTrace 是一个事后工具,所谓事后工具就是在服务已经上线了,但是发现存 ...

- 记一次线上bug排查-quartz线程调度相关

记一次线上bug排查,与各位共同探讨. 概述:使用quartz做的定时任务,正式生产环境有个任务延迟了1小时之久才触发.在这一小时里各种排查找不出问题,直到延迟时间结束了,该任务才珊珊触发.原因主要就 ...

- Java线上问题排查思路及Linux常用问题分析命令学习

前言 之前线上有过一两次OOM的问题,但是每次定位问题都有点手足无措的感觉,刚好利用星期天,以测试环境为模版来学习一下Linux常用的几个排查问题的命令. 也可以帮助自己在以后的工作中快速的排查线上问 ...

随机推荐

- vue.js 精学组件记录

组件需要注册后才可以使用. Vue.component('my-component',{ template:'<div>这是组件内容</div>' }): 局部注册组件 var ...

- Jmeter 非 GUI 命令行执行脚本文件

https://www.cnblogs.com/yebaofang/p/9803273.html

- 连接mysql用mysql_connect不能连接

用mysqli_connect就可以解决. mysqli_array()有连个参数,第一个是连接mysql名. php遇到这个警告Warning: Use of undefined constant ...

- APP测试常用工具以及框架

APP测试常用工具以及框架 1)纯白盒方式的测试,Monkey.一般是开发用的比较多,动手能力强的同学可以自己去尝试下! 2)偏白盒的robotium,这家伙号称是黑盒,但是本人不太认同- 因为使用r ...

- 剑指offer前6题

二维数组中的查找 在一个二维数组中,每一行都按照从左到右递增的顺序排序,每一列都按照从上到下递增的顺序排序.请完成一个函数,输入这样的一个二维数组和一个整数,判断数组中是否含有该整数. 时间限制:1秒 ...

- Spock - Document - 03 - Data Driven Testing

Data Driven Testing Peter Niederwieser, The Spock Framework TeamVersion 1.1 Oftentimes, it is useful ...

- 常见模块(七) re模块

首先明白正则表达式和re模块的关系:正则:是一种规则,这种规则在任何一种语言中都严格按照此规则进行匹配.正则匹配的就是字符串,从字符串的左边往右边匹配re: re是python语言中的利用正则规则的一 ...

- 学习笔记TF054:TFLearn、Keras

元框架(metaframework). TFLearn.模块化深度学习框架,更高级API,快速实验,完全透明兼容. TFLearn实现AlexNet.https://github.com/tflear ...

- C#中的参数和调用方式(可选参数、具名参数、可空参数)

具名参数 和 可选参数 是 C# framework 4.0 出来的新特性. 一. 常规方法定义及调用 public void Demo1(string x, int y) { //do someth ...

- lua 5.3最简单plugin编写

#include <windows.h> #include "lauxlib.h" /* Pop-up a Windows message box with your ...