简单爬虫 -- 以爬取NASA AOD数据(TIFF文件)为例

目录:

- 网站分析

- 爬取下载链接

- 爬取TIFF图片

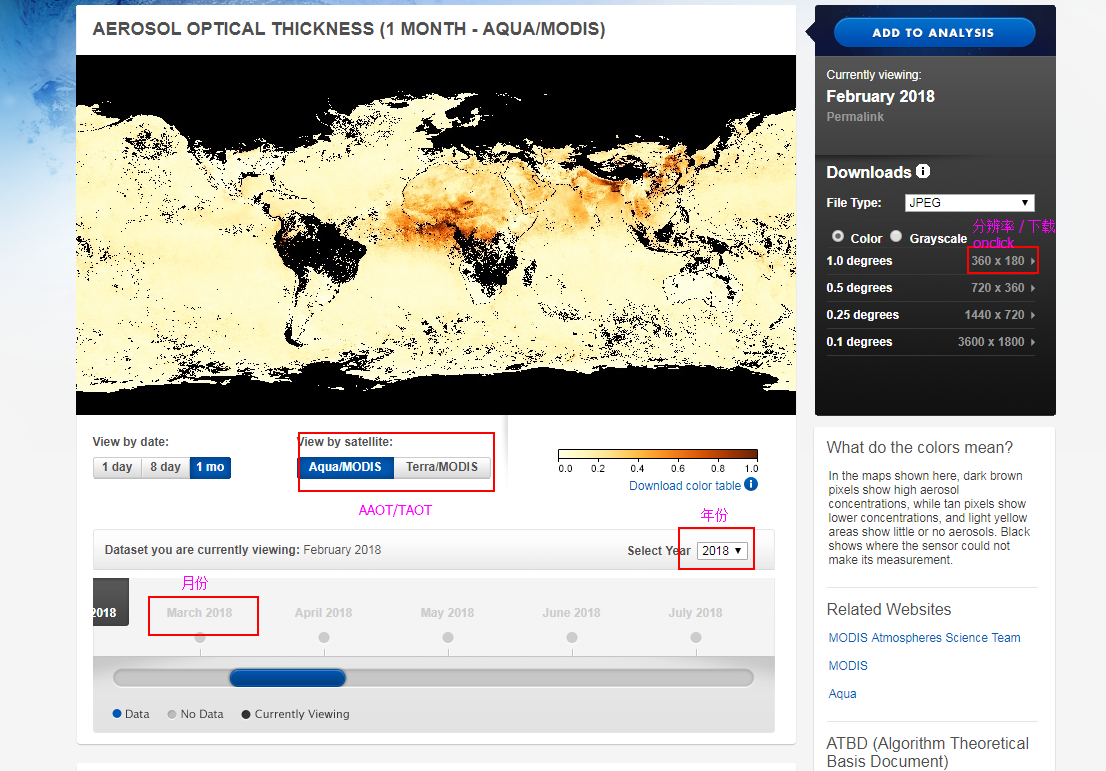

1、网站分析

主页面:https://neo.sci.gsfc.nasa.gov/view.php?datasetId=MYDAL2_M_AER_OD

需求:下载不同年份、不同月份、AAOT和TAOT数据;

点击AAOT和TAOT和年份可知,链接:

AAOT:https://neo.sci.gsfc.nasa.gov/view.php?datasetId=MYDAL2_M_AER_OD&year=

TAOT:https://neo.sci.gsfc.nasa.gov/view.php?datasetId=MODAL2_M_AER_OD&year=

AAOT和TAOT的区分:改变MYD和MOD;

年份区分:改变“year=”后面的数字;

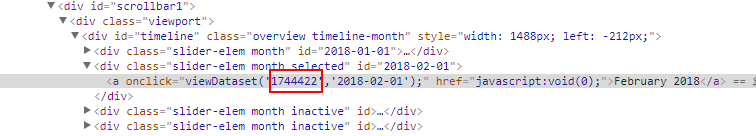

月份如何区分?

点击下载处,链接为:

https://neo.sci.gsfc.nasa.gov/servlet/RenderData?si=&cs=rgb&format=FLOAT.TIFF&width=360&height=180

https://neo.sci.gsfc.nasa.gov/servlet/RenderData?si=&cs=rgb&format=FLOAT.TIFF&width=360&height=180

可知在下载链接里面“si=”后面的数字是不知道的,查看源代码,检查上图中月份处,发现这个数字就在这里:这个就是月份区分

分析完毕,爬取思路:

- 根据月份检查元素获取图片下载链接中的“si”,构建所有的下载链接;

- 下载已爬取的下载链接中的TIFF图片

2、爬取下载链接

由以上的分析,代码如下,这里爬取的是2008-2011的AAOT和TAOT数据链接:

import requests

from bs4 import BeautifulSoup as bsp def url_collect():

// 两个主链接

taot_main_url = 'https://neo.sci.gsfc.nasa.gov/view.php?datasetId=MODAL2_M_AER_OD&year='

aaot_main_url = 'https://neo.sci.gsfc.nasa.gov/view.php?datasetId=MYDAL2_M_AER_OD&year=' // 需要下载的年份

years = ['', '', '', ''] // 构造确定AOT类别和年份页面链接

aot_url_list = []

for year in years:

aot_url_list.append(taot_main_url + year)

aot_url_list.append(aaot_main_url + year) for aot_url in aot_url_list:

// 请求获取网页

try:

response = requests.get(aot_url)

response.raise_for_status()

print('aot_url connect succeed !')

except:

print('aot_url connect failed !') // 分析网页,获取代表月份的“si=”后面的数字

response_text = response.text

soup = bsp(response_text, 'html.parser')

divs = soup.find_all('div',{"class":"slider-elem month"}) // 创建保存链接和命名形式的文件

url_txt = open('D:/home/research/lung_cancer/code/aot_url_all.txt', 'a')

url_name_txt = open('D:/home/research/lung_cancer/code/url_name.txt', 'a') // 构造下载链接和命名形式,并保存到文件中

for div in divs:

print(div)

aot_url_txt = 'https://neo.sci.gsfc.nasa.gov/servlet/RenderData?si=' + div.a['onclick'][13:20] + '&cs=rgb&format=FLOAT.TIFF&width=360&height=180'

name = aot_url.split('?')[1][10:] + div.a['onclick'][27:-3] + '.TIFF'

url_txt.write(aot_url_txt + '\n')

url_name_txt.write(name + '\n')

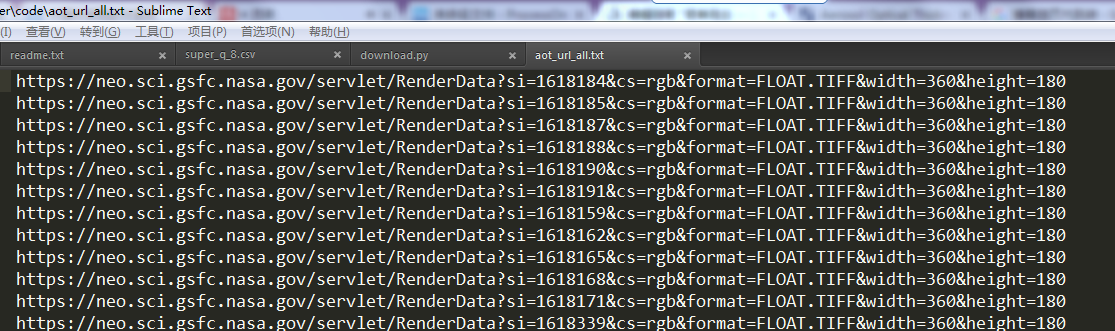

以下是爬取的结果:

Q:为什么要把命名形式也写入文件?

A:因为下载文件时,发现命名形式并不固定,有时候包含了年、月和AOT类别,有时候就是个简单的RenderData.TIFF,这样文件下载下来了也不知道是什么数据,所以命名很重要。

3、爬取TIFF图片

根据上一步爬取下来的链接,就可开始爬取图片了:

# code : utf-8 """

下载指定链接(在文本文件中)下的tiff图像

""" import requests def download():

local_path = 'D:/home/research/lung_cancer/code/' // 读取文本文件中已经下载好的链接

url_list = []

with open(local_path + 'aot_url_all.txt', 'r') as f:

for url in f.readlines():

url_list.append(url.strip()) // 读取命名形式

name_list = []

with open(local_path + 'url_name.txt', 'r') as f:

for name in f.readlines():

name_list.append(name.strip()) // 获取以上链接中的TIFF文件

for i in range(len(url_list)):

url = url_list[i]

name = name_list[i] try:

response = requests.get(url)

response.raise_for_status()

print('main_url connect succeed !')

except:

print('main_url connect failed !') // 将文件写入本地硬盘

with open('D:/home/research/lung_cancer/data/AOD_process/' + name, 'wb') as f:

f.write(response.content)

print(name + "write succeed!")

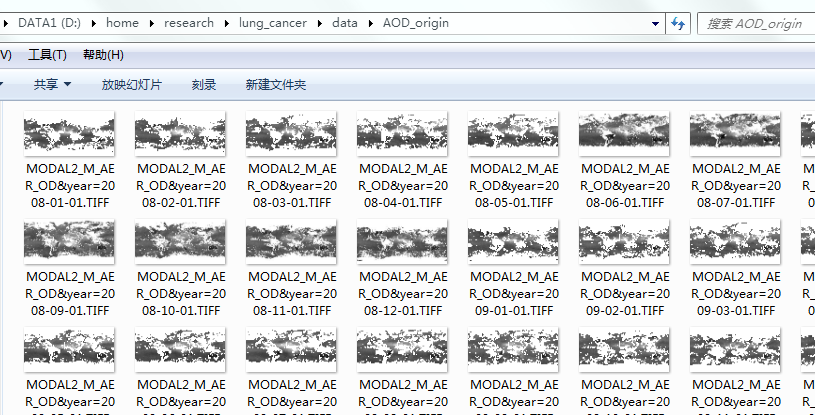

爬取结果:

简单爬虫 -- 以爬取NASA AOD数据(TIFF文件)为例的更多相关文章

- python爬虫25 | 爬取下来的数据怎么保存? CSV 了解一下

大家好 我是小帅b 是一个练习时长两年半的练习生 喜欢 唱! 跳! rap! 篮球! 敲代码! 装逼! 不好意思 我又走错片场了 接下来的几篇文章 小帅b将告诉你 如何将你爬取到的数据保存下来 有文本 ...

- node 爬虫 --- 将爬取到的数据,保存到 mysql 数据库中

步骤一:安装必要模块 (1)cheerio模块 ,一个类似jQuery的选择器模块,分析HTML利器. (2)request模块,让http请求变的更加简单 (3)mysql模块,node连接mysq ...

- Python爬虫:爬取喜马拉雅音频数据详解

前言 喜马拉雅是专业的音频分享平台,汇集了有声小说,有声读物,有声书,FM电台,儿童睡前故事,相声小品,鬼故事等数亿条音频,我最喜欢听民间故事和德云社相声集,你呢? 今天带大家爬取喜马拉雅音频数据,一 ...

- python简单爬虫(爬取pornhub特定关键词的items图片集)

请提前搭好梯子,如果没有梯子的话直接403. 1.所用到的包 requests: 和服务器建立连接,请求和接收数据(当然也可以用其他的包,socket之类的,不过requests是最简单好用的) Be ...

- java爬虫,爬取当当网数据

背景:女票快毕业了(没错!我是有女票的!!!),写论文,主题是儿童性教育,查看儿童性教育绘本数据死活找不到,没办法,就去当当网查询下数据,但是数据怎么弄下来呢,首先想到用Python,但是不会!!百 ...

- 【转】java爬虫,爬取当当网数据

背景:女票快毕业了(没错!我是有女票的!!!),写论文,主题是儿童性教育,查看儿童性教育绘本数据死活找不到,没办法,就去当当网查询下数据,但是数据怎么弄下来呢,首先想到用Python,但是不会!!百 ...

- 使用requests简单的页面爬取

首先安装requests库和准备User Agent 安装requests直接使用pip安装即可 pip install requests 准备User Agent,直接在百度搜索"UA查询 ...

- python爬虫项目-爬取雪球网金融数据(关注、持续更新)

(一)python金融数据爬虫项目 爬取目标:雪球网(起始url:https://xueqiu.com/hq#exchange=CN&firstName=1&secondName=1_ ...

- python网络爬虫《爬取get请求的页面数据》

一.urllib库 urllib是python自带的一个用于爬虫的库,其主要作用就是可以通过代码模拟浏览器发送请求.其常被用到的子模块在python3中的为urllib.request和urllib. ...

随机推荐

- PHP simpleXML文件编程

SimpleXML simpleXML该技术的核心思想是以面向对象的方式来操作xml文件 <?php //simplexml文件 讲所有的元素转成对象 $library=simplexml_lo ...

- VTK显示mhd,mha格式文件

下一篇文章将详细介绍mhd,mha文件的构成以及如何制作void renderMhd () { // read input image vtkSmartPointer<vtkMetaImageR ...

- Error Code: 1318. Incorrect number of arguments for PROCEDURE student.new_procedure; expected 0, got

1.错误描述 13:58:20 call new_procedure('2000','zhangsan') Error Code: 1318. Incorrect number of argument ...

- C# 获取一个独一无二的字符串 GUID

在保存文件,创建目录时,为了保证名称不重复,经常使用Random产生一个随机数,有更简单且不会重复的办法是: Guid.NewGuid().ToString() 就会生成一个类似 37c1acec-4 ...

- python之文件读写详解

打开文件 函数open() 参数说明: file:文件路径 mode: 文件的读写方式,默认'r',只读方式: buffering:设置缓冲策略,0用于二进制文件,1为行缓冲,用于文本模式:默认二进制 ...

- 项目中的导出(jxl插件)

第一步,获取要导出的参数,为导出做准备 public ModelAndView downloadInfo(final HttpServletRequest request, final HttpSer ...

- 极速搞定1小时不出结果SQL的优化(SQL Tuning)

今天帮用户做了一个SQL TUNING,原来为1个多小时不出结果,TUNING后为几秒,图片为我调优时参考的explain plan,隐去某些具体信息,虽然通过该计划,不能完全确定SQL慢的原因,但稍 ...

- 初识SSO与JWT

以前在学校做项目的时候,登录注销,权限验证这些事情,都是交给框架来做的,每次都是把这个架子拿到项目中去,也没有真正思考过它的过程,总觉的这些都是十分简单的逻辑. 然而来公司工作之后,慢慢觉得登录和权限 ...

- 我在微信小程序遇到的坑

这段时间刚好结束一个小程序,被坑的好惨,所以罗列出来,有用的着的,就抱走吧! 1.关于音频,项目要求能在退出小程序的情况下继续播放,所以我直接用了 wx.getBackgroundAudioM ...

- 5 分钟让你秒懂 Docker !

Docker是啥? 打开翻译君输入Docker 结果显示码头工人,没错!码头工人搬运的是集装箱,那么今天要讲的Docker其操作的也是集装箱,这个集装箱就静态而言就是一个应用镜像文件,就动态而言,就是 ...