4.2:Scrapy爬虫

使用Scrapy框架对网站的内容进行爬取

在桌面处打开终端,并在终端中输入:

scrapy startproject bitNews

cd bitNews/bitNews

修改items文件的内容,输入vim items.py按 i 进行编辑,将其中的代码修改为:

# -*- coding: utf-8 -*-

import scrapy class BitnewsItem(scrapy.Item):

# define the fields for your item here like:

name = scrapy.Field()

pass

按shift+zz 退出。在终端输入:

scrapy genspider bitnews "www.bit.edu.cn"

cd spiders

vim bitnews.py

修改代码为下图所示:

# -*- coding: utf-8 -*-

import scrapy

from bitNews.items import BitnewsItem class BitnewsSpider(scrapy.Spider):

name = 'bitnews'

allowed_domains = ['www.bit.edu.cn']

start_urls = ['http://www.bit.edu.cn/xww/jdgz/index.htm'] def parse(self, response):

items=[]

div = response.xpath("//div[@class='new_con']")

for each in div.xpath("ul/li"):

item=BitnewsItem()

item['name']=each.xpath('a/text()').extract()

items.append(item)

pass

return items

保存退出之后,在终端输入:cd ..

修改settings.py:vim settings.py

找到ROBOTSTXT_OBEY的值改为False:并添加设置如下:

ROBOTSTXT_OBEY=False

FEED_EXPORT_ENCODING = "UTF-8"

保存退出后,终端输入:

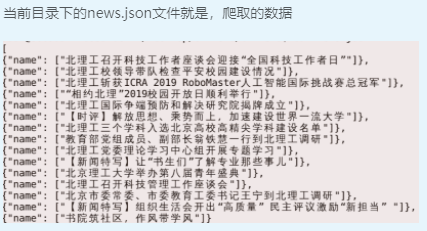

scrapy crawl bitnews -o news.json

4.2:Scrapy爬虫的更多相关文章

- scrapy爬虫结果插入mysql数据库

1.通过工具创建数据库scrapy

- Python之Scrapy爬虫框架安装及简单使用

题记:早已听闻python爬虫框架的大名.近些天学习了下其中的Scrapy爬虫框架,将自己理解的跟大家分享.有表述不当之处,望大神们斧正. 一.初窥Scrapy Scrapy是一个为了爬取网站数据,提 ...

- Linux搭建Scrapy爬虫集成开发环境

安装Python 下载地址:http://www.python.org/, Python 有 Python 2 和 Python 3 两个版本, 语法有些区别,ubuntu上自带了python2.7. ...

- Scrapy 爬虫

Scrapy 爬虫 使用指南 完全教程 scrapy note command 全局命令: startproject :在 project_name 文件夹下创建一个名为 project_name ...

- [Python爬虫] scrapy爬虫系列 <一>.安装及入门介绍

前面介绍了很多Selenium基于自动测试的Python爬虫程序,主要利用它的xpath语句,通过分析网页DOM树结构进行爬取内容,同时可以结合Phantomjs模拟浏览器进行鼠标或键盘操作.但是,更 ...

- 同时运行多个scrapy爬虫的几种方法(自定义scrapy项目命令)

试想一下,前面做的实验和例子都只有一个spider.然而,现实的开发的爬虫肯定不止一个.既然这样,那么就会有如下几个问题:1.在同一个项目中怎么创建多个爬虫的呢?2.多个爬虫的时候是怎么将他们运行起来 ...

- 如何让你的scrapy爬虫不再被ban之二(利用第三方平台crawlera做scrapy爬虫防屏蔽)

我们在做scrapy爬虫的时候,爬虫经常被ban是常态.然而前面的文章如何让你的scrapy爬虫不再被ban,介绍了scrapy爬虫防屏蔽的各种策略组合.前面采用的是禁用cookies.动态设置use ...

- 如何让你的scrapy爬虫不再被ban

前面用scrapy编写爬虫抓取了自己博客的内容并保存成json格式的数据(scrapy爬虫成长日记之创建工程-抽取数据-保存为json格式的数据)和写入数据库(scrapy爬虫成长日记之将抓取内容写入 ...

- scrapy爬虫成长日记之将抓取内容写入mysql数据库

前面小试了一下scrapy抓取博客园的博客(您可在此查看scrapy爬虫成长日记之创建工程-抽取数据-保存为json格式的数据),但是前面抓取的数据时保存为json格式的文本文件中的.这很显然不满足我 ...

- 【图文详解】scrapy爬虫与动态页面——爬取拉勾网职位信息(2)

上次挖了一个坑,今天终于填上了,还记得之前我们做的拉勾爬虫吗?那时我们实现了一页的爬取,今天让我们再接再厉,实现多页爬取,顺便实现职位和公司的关键词搜索功能. 之前的内容就不再介绍了,不熟悉的请一定要 ...

随机推荐

- 【项目实战】Kaggle泰坦尼克号的幸存者预测

前言 这是学习视频中留下来的一个作业,我决定根据大佬的步骤来一步一步完成整个项目,项目的下载地址如下:https://www.kaggle.com/c/titanic/data 大佬的传送门:http ...

- shell分割字符串并赋值给变量

假如变量var的值为:num=12,也即var="num=12",现在想把 12赋值给变量id awk 的-F 后跟上要分割字符串时的指定分隔符 awk中$0是要分割的字符串,$1 ...

- kvm里的虚拟机硬盘和网卡使用virtio驱动

1.首先从虚拟机的xml文件中找到已经使用virtio驱动的硬件,复制里面的address这行参数出来 <address type='pci' domain='0x0000' bus='0x00 ...

- SkyWalking 6.x 的架构图

可以看到主要由四部分组成: Agent(也叫Probe):代理或者探针,集成在被监测的应用中(SDK形式或者动态注入),采集应用的数据发送给后端(OAP). UI:自带的Web页面. OAP:后端,接 ...

- 分步骤讲解Deployment故障排除

背景假设 当你希望在Kubernetes中部署应用程序时,你通常会定义三个组件: 一个Deployment - 这是一份用于创建你的应用程序的Pod副本的"食谱": 一个Servi ...

- 示例:Service连接应用程序

整体思路: 1.创建pod 2.创建关联上一步pod的service 3.使用不同的方式配置service从而能够在集群内部访问 4.使用ssl方式加密访问service 5.配置service为no ...

- 初试 Ceph 存储之块设备、文件系统、对象存储

转载自:https://cloud.tencent.com/developer/article/1010543 1.Ceph 存储介绍 Ceph 是一个开源的分布式存储系统,包括对象存储.块设备.文件 ...

- [基础] BS/CS 区别 Http/Https 区别 中间件请求

BS和CS的区别: 1.BS结构:Browser-Server-从浏览器到服务器,浏览器打开的所有内容都属于BS(三大主流浏览器Safari.Chrome和Firefo) 2.CS结构:Cli ...

- PAT (Basic Level) Practice 1005 继续(3n+1)猜想 分数 25

卡拉兹(Callatz)猜想已经在1001中给出了描述.在这个题目里,情况稍微有些复杂. 当我们验证卡拉兹猜想的时候,为了避免重复计算,可以记录下递推过程中遇到的每一个数.例如对 n=3 进行验证的时 ...

- 洛谷P3810 陌上花开 (cdq)

最近才学了cdq,所以用cdq写的代码(这道题也是cdq的模板题) 这道题是个三维偏序问题,先对第一维排序,然后去掉重复的,然后cdq分治即可. 为什么要去掉重复的呢?因为相同的元素互相之间都能贡献, ...