Golang 爬虫01

学习地址:

https://www.bilibili.com/video/BV1Nt411H7sP?p=4

目录站:

https://tieba.baidu.com/f?kw=绝地求生&ie=utf-8&pn=0

https://tieba.baidu.com/f?kw=绝地求生&ie=utf-8&pn=50

https://tieba.baidu.com/f?kw=绝地求生&ie=utf-8&pn=100

爬虫概念:

访问web服务器,获取指定数据信息的一段程序.

工作流程:

- 明确目标Url.

- 发送请求,获取应答数据包.

- 保存,过滤数据.提取有用信息.

- 使用,分析得到数据信息.

百度贴吧爬虫实现:

go实战代码

单进程

实现过程:

- 提示用户指定起始,终止页.创建working函数.

- 使用start,end循环爬取每一页数据.

- 获取第一页的url--下一页=前一页+50.

- 封闭实现HttpGet()函数,爬取一个网页的数据内容,通过result返回.

httpGet/resp.Body.Close/buf:=make(4096)/for - 创建.html文件.使用循环因子i命名.

- 将result写入文件WriteString(result).f.close() 不推荐使用defer.

package main

import (

"fmt"

"io"

"net/http"

"os"

"strconv"

)

// HttpGet ...

func HttpGet(url string) (result string, err error) {

resp, err1 := http.Get(url)

if err1 != nil {

err = err1

return

}

defer resp.Body.Close()

//循环读取网页数据,传出给调用者

buf := make([]byte, 4096)

for {

n, err2 := resp.Body.Read(buf)

if n == 0 {

fmt.Println("读取网页完成")

break

}

if err2 != nil && err2 != io.EOF {

err = err2

return

}

result += string(buf[:n])

}

return

}

func working(start, end int) {

fmt.Printf("正在爬取第%d页到第%d页...\n", start, end)

// 循环爬取第一页的数据

for i := start; i <= end; i++ {

url := "https://tieba.baidu.com/f?kw=%E7%BB%9D%E5%9C%B0%E6%B1%82%E7%94%9F&ie=utf-8&pn=" + strconv.Itoa((i-1)*50)

result, err := HttpGet(url)

if err != nil {

fmt.Println("HttpGet err:", err)

continue

}

// fmt.Println("result=", result)

//将读到的整网页数据,保存为为文件

f, err := os.Create("第 " + strconv.Itoa(i) + " 页.html")

if err != nil {

fmt.Println("Create err:", err)

continue

}

f.WriteString(result)

f.Close()

}

}

func main() {

var start, end int

fmt.Print("请输入爬取的起始页(>=1):")

fmt.Scan(&start)

fmt.Print("请输入爬取的终止页(>=start):")

fmt.Scan(&end)

working(start, end)

}

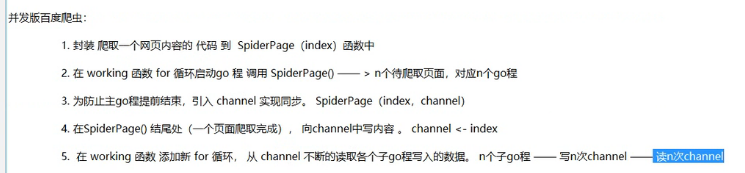

并发爬取

实现过程:

package main

import (

"fmt"

"io"

"net/http"

"os"

"strconv"

)

// HttpGet ...

func HttpGet(url string, i int) (result string, err error) {

resp, err1 := http.Get(url)

if err1 != nil {

err = err1

return

}

defer resp.Body.Close()

//循环读取网页数据,传出给调用者

buf := make([]byte, 4096)

for {

n, err2 := resp.Body.Read(buf)

if n == 0 {

fmt.Printf("正在读取第 %d 页\n", i)

break

}

if err2 != nil && err2 != io.EOF {

err = err2

return

}

result += string(buf[:n])

}

return

}

//SpiderPage ...

func SpiderPage(i int, page chan int) {

url := "https://tieba.baidu.com/f?kw=%E7%BB%9D%E5%9C%B0%E6%B1%82%E7%94%9F&ie=utf-8&pn=" + strconv.Itoa((i-1)*50)

result, err := HttpGet(url, i)

if err != nil {

fmt.Println("HttpGet err:", err)

return

}

// fmt.Println("result=", result)

//将读到的整网页数据,保存为为文件

f, err := os.Create("第 " + strconv.Itoa(i) + " 页.html")

if err != nil {

fmt.Println("Create err:", err)

return

}

f.WriteString(result)

f.Close()

page <- i

}

func working(start, end int) {

fmt.Printf("正在爬取第%d页到第%d页...\n", start, end)

page := make(chan int)

// 循环爬取第一页的数据

for i := start; i <= end; i++ {

go SpiderPage(i, page)

}

for i := start; i < end; i++ {

fmt.Printf("第 %d 页都页面完成...\n", <-page)

}

}

func main() {

var start, end int

fmt.Print("请输入爬取的起始页(>=1):")

fmt.Scan(&start)

fmt.Print("请输入爬取的终止页(>=start):")

fmt.Scan(&end)

working(start, end)

}

Golang 爬虫01的更多相关文章

- Golang - 爬虫案例实践

目录 Golang - 爬虫案例实践 1. 爬虫步骤 2. 正则表达式 3. 并发爬取美图 Golang - 爬虫案例实践 1. 爬虫步骤 明确目标(确定在哪个网址搜索) 爬(爬下数据) 取(去掉没用 ...

- Golang爬虫示例包系列教程(一):pedaily.com投资界爬虫

Golang爬虫示例包 文件结构 自己用Golang原生包封装了一个爬虫库,源码见go get -u -v github.com/hunterhug/go_tool/spider ---- data ...

- 从别人的代码中学习golang系列--01

自己最近在思考一个问题,如何让自己的代码质量逐渐提高,于是想到整理这个系列,通过阅读别人的代码,从别人的代码中学习,来逐渐提高自己的代码质量.本篇是这个系列的第一篇,我也不知道自己会写多少篇,但是希望 ...

- Python 开发轻量级爬虫01

Python 开发轻量级爬虫 (imooc总结01--课程目标) 课程目标:掌握开发轻量级爬虫 为什么说是轻量级的呢?因为一个复杂的爬虫需要考虑的问题场景非常多,比如有些网页需要用户登录了以后才能够访 ...

- Python爬虫01——第一个小爬虫

Python小爬虫——贴吧图片的爬取 在对Python有了一定的基础学习后,进行贴吧图片抓取小程序的编写. 目标: 首先肯定要实现图片抓取这个基本功能 然后实现对用户所给的链接进行抓取 最后要有一定的 ...

- Python爬虫-01:爬虫的概念及分类

目录 # 1. 为什么要爬虫? 2. 什么是爬虫? 3. 爬虫如何抓取网页数据? # 4. Python爬虫的优势? 5. 学习路线 6. 爬虫的分类 6.1 通用爬虫: 6.2 聚焦爬虫: # 1. ...

- (Python爬虫01)-本想给随笔加个序号才发现这么不方便

本想给随机加个序号,才发现还得去返回看看文章的序号.好在cnblog能断点自动保存. 作为一个小程序员,点赞的同时还在想,谁知道咋实现这种实时保存呢?有知道的给个参考文档呗.太感激了! 重点在这里 有 ...

- 之前写的关于chromedp的文章被别人转到CSDN,很受鼓励,再来一篇golang爬虫实例

示例说明:用chromedp操作chrome,导航到baidu,然后输入“美女”,然后再翻2页,在此过程中保存cookie和所有img标签内容,并保存第一页的baidu logo为png 注释已经比较 ...

- 爬虫01 /jupyter、爬虫概述、requests基本使用

爬虫02 /jupyter.爬虫概述.requests基本使用 目录 爬虫02 /jupyter.爬虫概述.requests基本使用 1. jupyter的基本使用 2. 爬虫概述 3. reques ...

- python爬虫01在Chrome浏览器抓包

尽量不要用国产浏览器,很多是有后门的 chrome是首选 百度 按下F12 element标签下对应的HTML代码 点击Network,可以看到很多请求 HTTP请求的方式有好几种,GET,POST, ...

随机推荐

- 一款比Typora更简洁优雅的Markdown编辑器神器(完全开源免费)

前言 自从Typora收费以后经常有朋友会问有没有一个好用.简洁.免费的Markdown编辑器推荐的,今天大姚给大家分享一款比Typora更简洁优雅的.完全开源免费(MIT License)Markd ...

- CSP 2021 入门级

CSP 2021 入门级(DONE) 1.C 语言不支持面向对象. 2.计算机界的最高奖项"图灵奖"以英国的阿兰·艾伦·图灵命名,被称为"计算机界的诺贝尔奖". ...

- #根号分治,分块#洛谷 5309 [Ynoi2011] 初始化

题目传送门 分析 如果 \(x\) 比较大那么可以暴力修改,\(x\) 比较小的话可以用数组打标记 查询的时候对于暴力修改的部分可以分块,暴力修改的同时需要给块打标记 如果 \(x\) 比较小的情况, ...

- #特征方程,dp,快速幂#洛谷 4451 [国家集训队]整数的lqp拆分

题目 分析 设\(dp[n]\)表示答案,因为\(dp[n]=\sum\prod_{i=1}^mF_{a_i}\) \(dp[n]=\sum_{i=1}^{n-1}dp[i]*F_{n-i-1}\) ...

- 区块链从入门到放弃系列教程-涵盖密码学,超级账本,以太坊,Libra,比特币等持续更新

目录 简介 什么是区块链 区块链不是什么 区块链的基础:密码学 区块链的基础:分布式系统和共识机制 超级账本Hyperledger 以太坊 Libra 比特币 总结 简介 区块链是一种防篡改的共享数字 ...

- 密码学系列之:SAFER

密码学系列之:SAFER 简介 分组密码是一个非常优秀的加密结构,很多常用加的加密算法使用的都是分组算法,比如DES.SAFER表示的也是一种分组密码算法.一起来看看吧. SAFER简介 SAFER的 ...

- 玩转OpenHarmony PID:教你打造两轮平衡车

简介 此次为大家带来的是OpenAtom OpenHarmony(以下简称"OpenHarmony")系统与PID控制算法相结合并落地的平衡车项目. PID控制算法是一种经典的,并 ...

- C# 虚方法virtual详解(转载)

C# 虚方法virtual详解 在C++.Java等众多OOP语言里都可以看到virtual的身影,而C#作为一个完全面向对象的语言当然也不例外. 虚拟函数从C#的程序编译的角度来看,它和其它一般的函 ...

- 鼠标移动出现雪花-js实现

// 鼠标移动出现雪花.html <!DOCTYPE html> <html> <head> <title></title> <scr ...

- 抓包整理————tcp 三次握手[九]

前言 简单抓包一下3次握手. 正文 握手的目标: 同步sequence 序列化 初始化序列化ISN(Initial Sequence Number) 交换tcp 通信参数 如MSS.窗口比例因子.选择 ...