Flink+Druid构建实时OLAP的探索

场景

k12在线教育公司的业务场景中,有一些业务场景需要实时统计和分析,如分析在线上课老师数量、学生数量,实时销售额,课堂崩溃率等,需要实时反应上课的质量问题,以便于对整个公司的业务情况有大致的了解。

方案对比

对比了很多解决方案,如下几种,列出来供参考。

| 方案 | 实时入库 | SQL支持度 |

|---|---|---|

| Spark+CarbonData | 支持 | Spark SQL语法丰富 |

| Kylin | 不支持 | 支持join |

| Flink+Druid | 支持 | 0.15以前不支持SQL,不支持join |

- 上一篇文章所示,使用Spark+CarbonData也是一种解决方案,但是他的缺点也是比较明显,如不能和Flink进行结合,因为我们整个的大数据规划的大致方向是,Spark用来作为离线计算,Flink作为实时计算,并且这两个大方向短时间内不会改变;

- Kylin一直是老牌OLAP引擎,但是有个缺点无法满足我们的需求,就是在技术选型的那个时间点kylin还不支持实时入库(后续2.0版本支持实时入库),所以就选择了放弃;

- 使用Flink+Druid方式实现,这个时间选择这个方案,简直是顺应潮流呀,Flink现在如日中天,各大厂都在使用,Druid是OLAP的新贵,关于它的文章也有很多,我也不赘述太多。有兴趣的可以看下这篇文章,我的博客其它文章也有最新版本的安装教程,实操方案哦。

设计方案

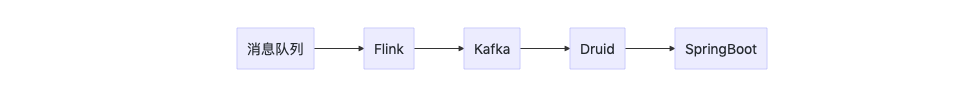

实时处理采用Flink SQL,实时入库Druid方式采用 druid-kafka-indexing-service,另一种方式入库方式,Tranquility,这种方式测试下来问题多多,放弃了。数据流向如下图。

场景举例

实时计算课堂连接掉线率。此事件包含两个埋点上报,进入教室和掉线分别上报数据。druid设计的字段

flink的处理

将上报的数据进行解析,上报使用的是json格式,需要解析出所需要的字段然后发送到kafka。字段包含如下

sysTime,DateTime格式

pt,格式yyyy-MM-dd

eventId,事件类型(enterRoom|disconnect)

lessonId,课程ID

Druid处理

启动Druid Supervisor,消费Kafka里的数据,使用预聚合,配置如下

{

"type": "kafka",

"dataSchema": {

"dataSource": "sac_core_analyze_v1",

"parser": {

"parseSpec": {

"dimensionsSpec": {

"spatialDimensions": [],

"dimensions": [

"eventId",

"pt"

]

},

"format": "json",

"timestampSpec": {

"column": "sysTime",

"format": "auto"

}

},

"type": "string"

},

"metricsSpec": [

{

"filter": {

"type": "selector",

"dimension": "msg_type",

"value": "disconnect"

},

"aggregator": {

"name": "lesson_offline_molecule_id",

"type": "cardinality",

"fields": ["lesson_id"]

},

"type": "filtered"

}, {

"filter": {

"type": "selector",

"dimension": "msg_type",

"value": "enterRoom"

},

"aggregator": {

"name": "lesson_offline_denominator_id",

"type": "cardinality",

"fields": ["lesson_id"]

},

"type": "filtered"

}

],

"granularitySpec": {

"type": "uniform",

"segmentGranularity": "DAY",

"queryGranularity": {

"type": "none"

},

"rollup": true,

"intervals": null

},

"transformSpec": {

"filter": null,

"transforms": []

}

},

"tuningConfig": {

"type": "kafka",

"maxRowsInMemory": 1000000,

"maxBytesInMemory": 0,

"maxRowsPerSegment": 5000000,

"maxTotalRows": null,

"intermediatePersistPeriod": "PT10M",

"basePersistDirectory": "/tmp/1564535441619-2",

"maxPendingPersists": 0,

"indexSpec": {

"bitmap": {

"type": "concise"

},

"dimensionCompression": "lz4",

"metricCompression": "lz4",

"longEncoding": "longs"

},

"buildV9Directly": true,

"reportParseExceptions": false,

"handoffConditionTimeout": 0,

"resetOffsetAutomatically": false,

"segmentWriteOutMediumFactory": null,

"workerThreads": null,

"chatThreads": null,

"chatRetries": 8,

"httpTimeout": "PT10S",

"shutdownTimeout": "PT80S",

"offsetFetchPeriod": "PT30S",

"intermediateHandoffPeriod": "P2147483647D",

"logParseExceptions": false,

"maxParseExceptions": 2147483647,

"maxSavedParseExceptions": 0,

"skipSequenceNumberAvailabilityCheck": false

},

"ioConfig": {

"topic": "sac_druid_analyze_v2",

"replicas": 2,

"taskCount": 1,

"taskDuration": "PT600S",

"consumerProperties": {

"bootstrap.servers": "bd-prod-kafka01:9092,bd-prod-kafka02:9092,bd-prod-kafka03:9092"

},

"pollTimeout": 100,

"startDelay": "PT5S",

"period": "PT30S",

"useEarliestOffset": false,

"completionTimeout": "PT1200S",

"lateMessageRejectionPeriod": null,

"earlyMessageRejectionPeriod": null,

"stream": "sac_druid_analyze_v2",

"useEarliestSequenceNumber": false

},

"context": null,

"suspended": false

}

最重要的配置是metricsSpec,他主要定义了预聚合的字段和条件。

数据查询

数据格式如下

| pt | eventId | lesson_offline_molecule_id | lesson_offline_denominator_id |

|---|---|---|---|

| 2019-08-09 | enterRoom | "AQAAAAAAAA==" | "AQAAAAAAAA==" |

| 2019-08-09 | disconnect | "AQAAAAAAAA==" | "AQAAAAAAAA==" |

结果可以按照这样的SQL出

SELECT pt,CAST(APPROX_COUNT_DISTINCT(lesson_offline_molecule_id) AS DOUBLE)/CAST(APPROX_COUNT_DISTINCT(lesson_offline_denominator_id) AS DOUBLE) from sac_core_analyze_v1 group by pt

可以使用Druid的接口查询结果,肥肠的方便~

Flink+Druid构建实时OLAP的探索的更多相关文章

- druid.io 海量实时OLAP数据仓库 (翻译+总结) (1)

介绍 我是NDPmedia公司的大数据OLAP的资深高级工程师, 专注于OLAP领域, 现将一个成熟的可靠的高性能的海量实时OLAP数据仓库介绍给大家: druid.io NDPmedia在2014年 ...

- druid.io 海量实时OLAP数据仓库 (翻译+总结) (1)——分析框架如hive或者redshift(MPPDB)、ES等

介绍 我是NDPmedia公司的大数据OLAP的资深高级工程师, 专注于OLAP领域, 现将一个成熟的可靠的高性能的海量实时OLAP数据仓库介绍给大家: druid.io NDPmedia在2014年 ...

- DataPipeline丨构建实时数据集成平台时,在技术选型上的考量点

文 | 陈肃 DataPipeline CTO 随着企业应用复杂性的上升和微服务架构的流行,数据正变得越来越以应用为中心. 服务之间仅在必要时以接口或者消息队列方式进行数据交互,从而避免了构建单一数 ...

- OPPO数据中台之基石:基于Flink SQL构建实数据仓库

小结: 1. OPPO数据中台之基石:基于Flink SQL构建实数据仓库 https://mp.weixin.qq.com/s/JsoMgIW6bKEFDGvq_KI6hg 作者 | 张俊编辑 | ...

- 唯品会海量实时OLAP分析技术升级之路

本文转载自公众号 DBAplus社群 , 作者:谢麟炯 谢麟炯,唯品会大数据平台高级技术架构经理,主要负责大数据自助多维分析平台,离线数据开发平台及分析引擎团队的开发和管理工作,加入唯品会以来还曾负责 ...

- Demo:基于 Flink SQL 构建流式应用

Flink 1.10.0 于近期刚发布,释放了许多令人激动的新特性.尤其是 Flink SQL 模块,发展速度非常快,因此本文特意从实践的角度出发,带领大家一起探索使用 Flink SQL 如何快速构 ...

- 腾讯云EMR大数据实时OLAP分析案例解析

OLAP(On-Line Analytical Processing),是数据仓库系统的主要应用形式,帮助分析人员多角度分析数据,挖掘数据价值.本文基于QQ音乐海量大数据实时分析场景,通过QQ音乐与腾 ...

- ElasticSearch做实时OLAP框架~实时搜索、统计和OLAP需求,甚至可以作为NOSQL来使用(转)

使用ElasticSearch作为大数据平台的实时OLAP框架 – lxw的大数据田地 http://lxw1234.com/archives/2015/12/588.htm 一直想找一个用于大数据平 ...

- 使用 Kafka 和 Spark Streaming 构建实时数据处理系统

使用 Kafka 和 Spark Streaming 构建实时数据处理系统 来源:https://www.ibm.com/developerworks,这篇文章转载自微信里文章,正好解决了我项目中的技 ...

随机推荐

- 解决Spring的java项目打包后执行出现“无法读取方案文档...“、“原因为 1) 无法找到文档; 2) 无法读取文档; 3) 文档的根元素不是...”问题

问题 一个用Spring建的java项目,在Eclipse或idea中运行正常,为什么打包后运行出现如下错误呢? 2019/07/10/19:04:07 WARN [main] org.springf ...

- Codeforces Gym101341I:Matrix God(随机化构造矩阵降维)***

http://codeforces.com/gym/101341/problem/I 题意:给三个N*N的矩阵,问a*b是否等于c. 思路:之前遇到过差不多的题目,当时是随机行(点),然后验证,不满足 ...

- 初识Grep

前言:grep这个命令都不陌生,最常用的就是和管道符结合,例如:ps -ef | grep docker,但是我还是想认识一下这个非常giao的命令... Grep称为全局正则表达式检索工具,在企业中 ...

- 数字IC前后端设计中的时序收敛(五)--Max Transition违反的修复方法

本文转自:自己的微信公众号<数字集成电路设计及EDA教程> 里面主要讲解数字IC前端.后端.DFT.低功耗设计以及验证等相关知识,并且讲解了其中用到的各种EDA工具的教程. 考虑到微信公众 ...

- Leetcode 195 Tenth Line

Given a text file file.txt, print just the 10th line of the file. Example: Assume that file.txt has ...

- 设计模式:代理模式是什么,Spring AOP还和它有关系?

接着学习设计模式系列,今天讲解的是代理模式. 定义 什么是代理模式? 代理模式,也叫委托模式,其定义是给某一个对象提供一个代理对象,并由代理对象控制对原对象的引用.它包含了三个角色: Subject: ...

- Java基础之增强for循环

平时大家for循环应该用的不少,特别是增强for循环,简单快捷.但是在增强for中做删除操作,却会抛出java.util.ConcurrentModificationException,一起来看下. ...

- 【拓扑排序】排队-C++

描述 今天,学校老师让同学们排成一队,准备带大家出去玩,一共有 n 名同学,排队的时候同学们向老师提了 m 条要求,每一条要求是说同学 x 一定要排在同学 y 之前,老师现在想找到一种排队方式可以满足 ...

- 简单的量子算法(一):Hadamard 变换、Parity Problem

Hadamard Transform Hadamard 变换在量子逻辑门中提过,只不过那时是单量子的Hadamard门,负责把\(|1\rangle\)变成\(|-\rangle\),\(|0\ran ...

- 74859a颜色信息

74859a十进制的RGB值为R:116, G:133, B:154. CMYK值为C:24.675, M:13.636, Y: 0.0, K: 39.608 RGB 116, 133, 154 百分 ...