HBase 学习之路(八)——HBase协处理器

一、简述

在使用HBase时,如果你的数据量达到了数十亿行或数百万列,此时能否在查询中返回大量数据将受制于网络的带宽,即便网络状况允许,但是客户端的计算处理也未必能够满足要求。在这种情况下,协处理器(Coprocessors)应运而生。它允许你将业务计算代码放入在RegionServer的协处理器中,将处理好的数据再返回给客户端,这可以极大地降低需要传输的数据量,从而获得性能上的提升。同时协处理器也允许用户扩展实现HBase目前所不具备的功能,如权限校验、二级索引、完整性约束等。

二、协处理器类型

2.1 Observer协处理器

1. 功能

Observer协处理器类似于关系型数据库中的触发器,当发生某些事件的时候这类协处理器会被Server端调用。通常可以用来实现下面功能:

- 权限校验:在执行

Get或Put操作之前,您可以使用preGet或prePut方法检查权限; - 完整性约束: HBase不支持关系型数据库中的外键功能,可以通过触发器在插入或者删除数据的时候,对关联的数据进行检查;

- 二级索引: 可以使用协处理器来维护二级索引。

2. 类型

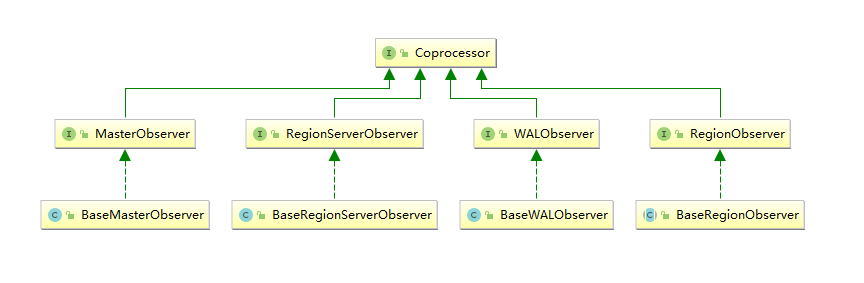

当前Observer协处理器有以下四种类型:

- RegionObserver :

允许您观察Region上的事件,例如Get和Put操作。 - RegionServerObserver :

允许您观察与RegionServer操作相关的事件,例如启动,停止或执行合并,提交或回滚。 - MasterObserver :

允许您观察与HBase Master相关的事件,例如表创建,删除或schema修改。 - WalObserver :

允许您观察与预写日志(WAL)相关的事件。

3. 接口

以上四种类型的Observer协处理器均继承自Coprocessor接口,这四个接口中分别定义了所有可用的钩子方法,以便在对应方法前后执行特定的操作。通常情况下,我们并不会直接实现上面接口,而是继承其Base实现类,Base实现类只是简单空实现了接口中的方法,这样我们在实现自定义的协处理器时,就不必实现所有方法,只需要重写必要方法即可。

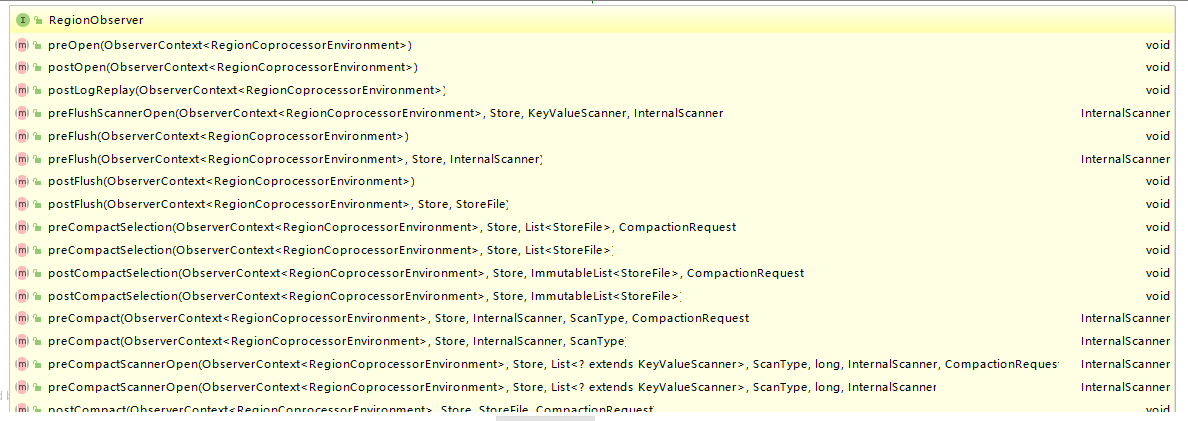

这里以RegionObservers为例,其接口类中定义了所有可用的钩子方法,下面截取了部分方法的定义,多数方法都是成对出现的,有pre就有post:

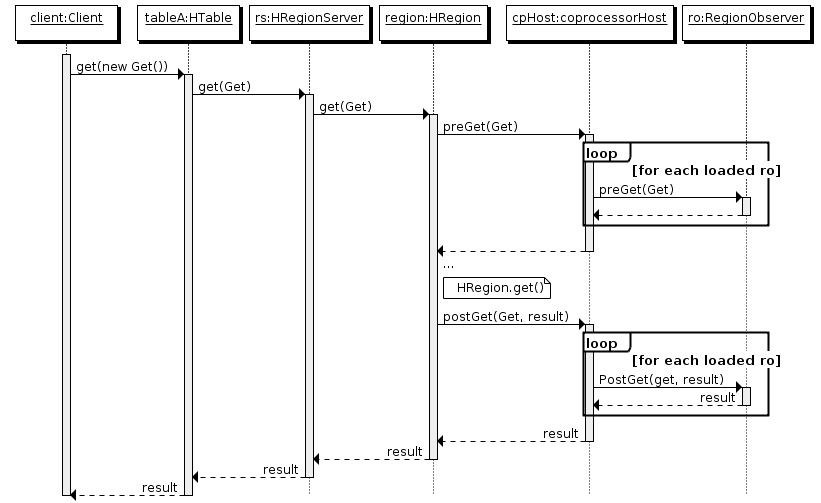

4. 执行流程

- 客户端发出 put 请求

- 该请求被分派给合适的 RegionServer 和 region

- coprocessorHost 拦截该请求,然后在该表的每个 RegionObserver 上调用 prePut()

- 如果没有被

prePut()拦截,该请求继续送到 region,然后进行处理 - region 产生的结果再次被 CoprocessorHost 拦截,调用

postPut() - 假如没有

postPut()拦截该响应,最终结果被返回给客户端

如果大家了解Spring,可以将这种执行方式类比于其AOP的执行原理即可,官方文档当中也是这样类比的:

If you are familiar with Aspect Oriented Programming (AOP), you can think of a coprocessor as applying advice by intercepting a request and then running some custom code,before passing the request on to its final destination (or even changing the destination).

如果您熟悉面向切面编程(AOP),您可以将协处理器视为通过拦截请求然后运行一些自定义代码来使用Advice,然后将请求传递到其最终目标(或者更改目标)。

2.2 Endpoint协处理器

Endpoint协处理器类似于关系型数据库中的存储过程。客户端可以调用Endpoint协处理器在服务端对数据进行处理,然后再返回。

以聚集操作为例,如果没有协处理器,当用户需要找出一张表中的最大数据,即 max 聚合操作,就必须进行全表扫描,然后在客户端上遍历扫描结果,这必然会加重了客户端处理数据的压力。利用 Coprocessor,用户可以将求最大值的代码部署到 HBase Server 端,HBase将利用底层 cluster 的多个节点并发执行求最大值的操作。即在每个 Region 范围内执行求最大值的代码,将每个 Region 的最大值在 Region Server 端计算出来,仅仅将该 max 值返回给客户端。之后客户端只需要将每个 Region 的最大值进行比较而找到其中最大的值即可。

三、协处理的加载方式

要使用我们自己开发的协处理器,必须通过静态(使用HBase配置)或动态(使用HBase Shell或Java API)加载它。

- 静态加载的协处理器称之为 System Coprocessor(系统级协处理器),作用范围是整个HBase上的所有表,需要重启HBase服务;

- 动态加载的协处理器称之为 Table Coprocessor(表处理器),作用于指定的表,不需要重启HBase服务。

其加载和卸载方式分别介绍如下。

四、静态加载与卸载

4.1 静态加载

静态加载分以下三步:

- 在

hbase-site.xml定义需要加载的协处理器。

<property>

<name>hbase.coprocessor.region.classes</name>

<value>org.myname.hbase.coprocessor.endpoint.SumEndPoint</value>

</property>

<name>标签的值必须是下面其中之一:

RegionObservers 和 Endpoints协处理器:

hbase.coprocessor.region.classesWALObservers协处理器:

hbase.coprocessor.wal.classesMasterObservers协处理器:

hbase.coprocessor.master.classes<value>必须是协处理器实现类的全限定类名。如果为加载指定了多个类,则类名必须以逗号分隔。

- 将jar(包含代码和所有依赖项)放入HBase安装目录中的

lib目录下; - 重启HBase。

4.2 静态卸载

- 从hbase-site.xml中删除配置的协处理器的<property>元素及其子元素;

- 从类路径或HBase的lib目录中删除协处理器的JAR文件(可选);

- 重启HBase。

五、动态加载与卸载

使用动态加载协处理器,不需要重新启动HBase。但动态加载的协处理器是基于每个表加载的,只能用于所指定的表。

此外,在使用动态加载必须使表脱机(disable)以加载协处理器。动态加载通常有两种方式:Shell 和 Java API 。

以下示例基于两个前提:

- coprocessor.jar 包含协处理器实现及其所有依赖项。

- JAR 包存放在HDFS上的路径为:hdfs:// <namenode>:<port> / user / <hadoop-user> /coprocessor.jar

5.1 HBase Shell动态加载

- 使用HBase Shell禁用表

hbase > disable 'tableName'

- 使用如下命令加载协处理器

hbase > alter 'tableName', METHOD => 'table_att', 'Coprocessor'=>'hdfs://<namenode>:<port>/

user/<hadoop-user>/coprocessor.jar| org.myname.hbase.Coprocessor.RegionObserverExample|1073741823|

arg1=1,arg2=2'

Coprocessor包含由管道(|)字符分隔的四个参数,按顺序解释如下:

- JAR包路径:通常为JAR包在HDFS上的路径。关于路径以下两点需要注意:

- 允许使用通配符,例如:

hdfs://<namenode>:<port>/user/<hadoop-user>/*.jar来添加指定的JAR包; - 可以使指定目录,例如:

hdfs://<namenode>:<port>/user/<hadoop-user>/,这会添加目录中的所有JAR包,但不会搜索子目录中的JAR包。 - 类名:协处理器的完整类名。

- 优先级:协处理器的优先级,遵循数字的自然序,即值越小优先级越高。可以为空,在这种情况下,将分配默认优先级值。

- 可选参数 :传递的协处理器的可选参数。

- 启用表

hbase > enable 'tableName'

- 验证协处理器是否已加载

hbase > describe 'tableName'

协处理器出现在TABLE_ATTRIBUTES属性中则代表加载成功。

5.2 HBase Shell动态卸载

- 禁用表

hbase> disable 'tableName'

- 移除表协处理器

hbase> alter 'tableName', METHOD => 'table_att_unset', NAME => 'coprocessor$1'

- 启用表

hbase> enable 'tableName'

5.3 Java API 动态加载

TableName tableName = TableName.valueOf("users");

String path = "hdfs://<namenode>:<port>/user/<hadoop-user>/coprocessor.jar";

Configuration conf = HBaseConfiguration.create();

Connection connection = ConnectionFactory.createConnection(conf);

Admin admin = connection.getAdmin();

admin.disableTable(tableName);

HTableDescriptor hTableDescriptor = new HTableDescriptor(tableName);

HColumnDescriptor columnFamily1 = new HColumnDescriptor("personalDet");

columnFamily1.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily1);

HColumnDescriptor columnFamily2 = new HColumnDescriptor("salaryDet");

columnFamily2.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily2);

hTableDescriptor.setValue("COPROCESSOR$1", path + "|"

+ RegionObserverExample.class.getCanonicalName() + "|"

+ Coprocessor.PRIORITY_USER);

admin.modifyTable(tableName, hTableDescriptor);

admin.enableTable(tableName);

在HBase 0.96及其以后版本中,HTableDescriptor的addCoprocessor()方法提供了一种更为简便的加载方法。

TableName tableName = TableName.valueOf("users");

Path path = new Path("hdfs://<namenode>:<port>/user/<hadoop-user>/coprocessor.jar");

Configuration conf = HBaseConfiguration.create();

Connection connection = ConnectionFactory.createConnection(conf);

Admin admin = connection.getAdmin();

admin.disableTable(tableName);

HTableDescriptor hTableDescriptor = new HTableDescriptor(tableName);

HColumnDescriptor columnFamily1 = new HColumnDescriptor("personalDet");

columnFamily1.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily1);

HColumnDescriptor columnFamily2 = new HColumnDescriptor("salaryDet");

columnFamily2.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily2);

hTableDescriptor.addCoprocessor(RegionObserverExample.class.getCanonicalName(), path,

Coprocessor.PRIORITY_USER, null);

admin.modifyTable(tableName, hTableDescriptor);

admin.enableTable(tableName);

5.4 Java API 动态卸载

卸载其实就是重新定义表但不设置协处理器。这会删除所有表上的协处理器。

TableName tableName = TableName.valueOf("users");

String path = "hdfs://<namenode>:<port>/user/<hadoop-user>/coprocessor.jar";

Configuration conf = HBaseConfiguration.create();

Connection connection = ConnectionFactory.createConnection(conf);

Admin admin = connection.getAdmin();

admin.disableTable(tableName);

HTableDescriptor hTableDescriptor = new HTableDescriptor(tableName);

HColumnDescriptor columnFamily1 = new HColumnDescriptor("personalDet");

columnFamily1.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily1);

HColumnDescriptor columnFamily2 = new HColumnDescriptor("salaryDet");

columnFamily2.setMaxVersions(3);

hTableDescriptor.addFamily(columnFamily2);

admin.modifyTable(tableName, hTableDescriptor);

admin.enableTable(tableName);

六、协处理器案例

这里给出一个简单的案例,实现一个类似于Redis中append 命令的协处理器,当我们对已有列执行put操作时候,HBase默认执行的是update操作,这里我们修改为执行append操作。

# redis append 命令示例

redis> EXISTS mykey

(integer) 0

redis> APPEND mykey "Hello"

(integer) 5

redis> APPEND mykey " World"

(integer) 11

redis> GET mykey

"Hello World"

6.1 创建测试表

# 创建一张杂志表 有文章和图片两个列族

hbase > create 'magazine','article','picture'

6.2 协处理器编程

完整代码可见本仓库:hbase-observer-coprocessor

新建Maven工程,导入下面依赖:

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-common</artifactId>

<version>1.2.0</version>

</dependency>

<dependency>

<groupId>org.apache.hbase</groupId>

<artifactId>hbase-server</artifactId>

<version>1.2.0</version>

</dependency>

继承BaseRegionObserver实现我们自定义的RegionObserver,对相同的article:content执行put命令时,将新插入的内容添加到原有内容的末尾,代码如下:

public class AppendRegionObserver extends BaseRegionObserver {

private byte[] columnFamily = Bytes.toBytes("article");

private byte[] qualifier = Bytes.toBytes("content");

@Override

public void prePut(ObserverContext<RegionCoprocessorEnvironment> e, Put put, WALEdit edit,

Durability durability) throws IOException {

if (put.has(columnFamily, qualifier)) {

// 遍历查询结果,获取指定列的原值

Result rs = e.getEnvironment().getRegion().get(new Get(put.getRow()));

String oldValue = "";

for (Cell cell : rs.rawCells())

if (CellUtil.matchingColumn(cell, columnFamily, qualifier)) {

oldValue = Bytes.toString(CellUtil.cloneValue(cell));

}

// 获取指定列新插入的值

List<Cell> cells = put.get(columnFamily, qualifier);

String newValue = "";

for (Cell cell : cells) {

if (CellUtil.matchingColumn(cell, columnFamily, qualifier)) {

newValue = Bytes.toString(CellUtil.cloneValue(cell));

}

}

// Append 操作

put.addColumn(columnFamily, qualifier, Bytes.toBytes(oldValue + newValue));

}

}

}

6.3 打包项目

使用maven命令进行打包,打包后的文件名为hbase-observer-coprocessor-1.0-SNAPSHOT.jar

# mvn clean package

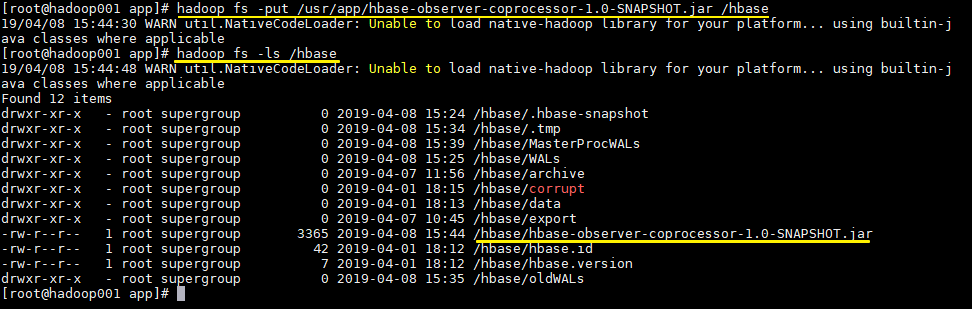

6.4 上传JAR包到HDFS

# 上传项目到HDFS上的hbase目录

hadoop fs -put /usr/app/hbase-observer-coprocessor-1.0-SNAPSHOT.jar /hbase

# 查看上传是否成功

hadoop fs -ls /hbase

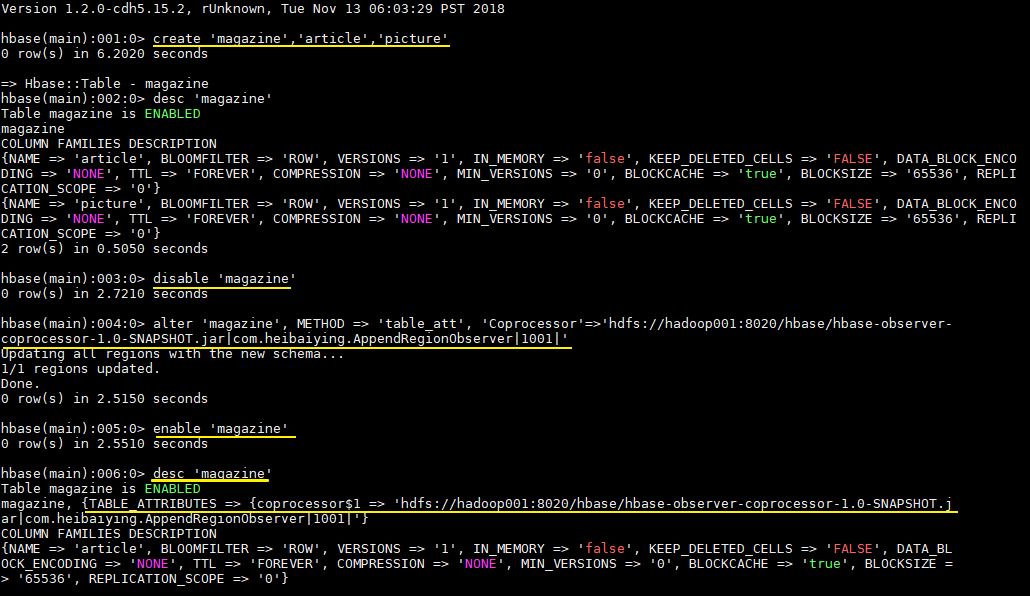

6.5 加载协处理器

- 加载协处理器前需要先禁用表

hbase > disable 'magazine'

- 加载协处理器

hbase > alter 'magazine', METHOD => 'table_att', 'Coprocessor'=>'hdfs://hadoop001:8020/hbase/hbase-observer-coprocessor-1.0-SNAPSHOT.jar|com.heibaiying.AppendRegionObserver|1001|'

- 启用表

hbase > enable 'magazine'

- 查看协处理器是否加载成功

hbase > desc 'magazine'

协处理器出现在TABLE_ATTRIBUTES属性中则代表加载成功,如下图:

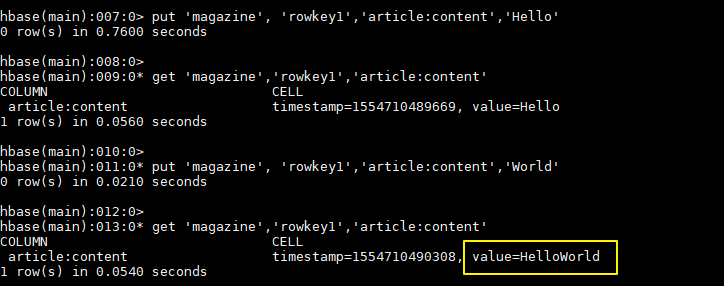

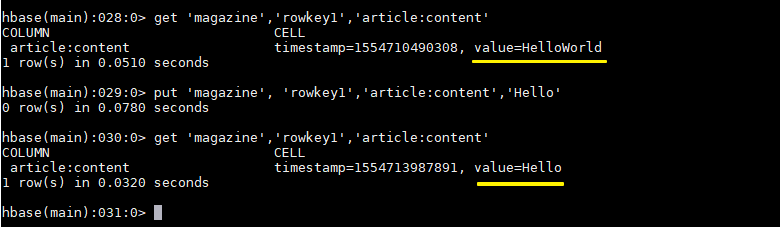

6.6 测试加载结果

插入一组测试数据:

hbase > put 'magazine', 'rowkey1','article:content','Hello'

hbase > get 'magazine','rowkey1','article:content'

hbase > put 'magazine', 'rowkey1','article:content','World'

hbase > get 'magazine','rowkey1','article:content'

可以看到对于指定列的值已经执行了append操作:

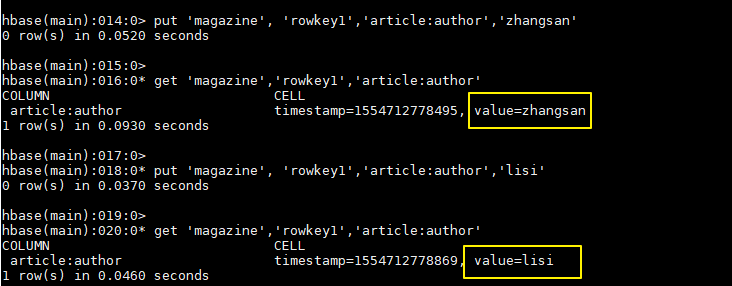

插入一组对照数据:

hbase > put 'magazine', 'rowkey1','article:author','zhangsan'

hbase > get 'magazine','rowkey1','article:author'

hbase > put 'magazine', 'rowkey1','article:author','lisi'

hbase > get 'magazine','rowkey1','article:author'

可以看到对于正常的列还是执行update操作:

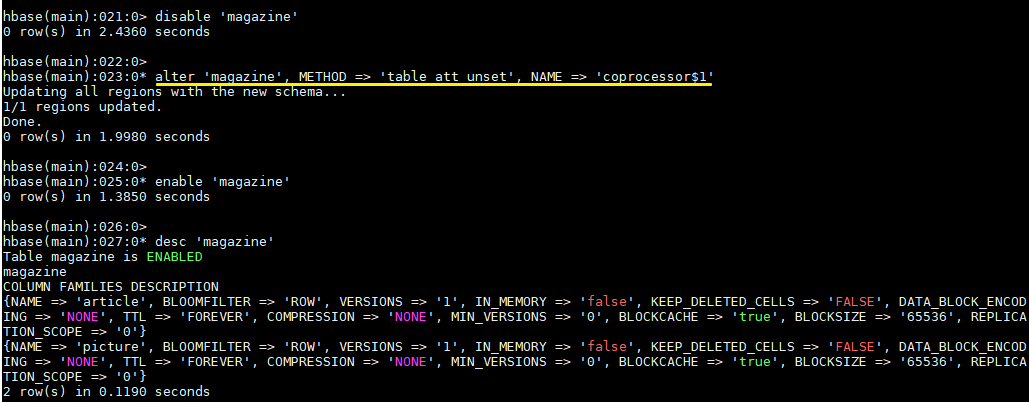

6.7 卸载协处理器

- 卸载协处理器前需要先禁用表

hbase > disable 'magazine'

- 卸载协处理器

hbase > alter 'magazine', METHOD => 'table_att_unset', NAME => 'coprocessor$1'

- 启用表

hbase > enable 'magazine'

- 查看协处理器是否卸载成功

hbase > desc 'magazine'

6.8 测试卸载结果

依次执行下面命令可以测试卸载是否成功

hbase > get 'magazine','rowkey1','article:content'

hbase > put 'magazine', 'rowkey1','article:content','Hello'

hbase > get 'magazine','rowkey1','article:content'

参考资料

更多大数据系列文章可以参见个人 GitHub 开源项目: 程序员大数据入门指南

HBase 学习之路(八)——HBase协处理器的更多相关文章

- HBase学习之路 (十一)HBase的协过滤器

协处理器—Coprocessor 1. 起源 Hbase 作为列族数据库最经常被人诟病的特性包括:无法轻易建立“二级索引”,难以执 行求和.计数.排序等操作.比如,在旧版本的(<0.92)Hba ...

- HBase学习之路 (二)HBase集群安装

前提 1.HBase 依赖于 HDFS 做底层的数据存储 2.HBase 依赖于 MapReduce 做数据计算 3.HBase 依赖于 ZooKeeper 做服务协调 4.HBase源码是java编 ...

- HBase学习之路 (三)HBase集群Shell操作

进入HBase命令行 在你安装的随意台服务器节点上,执行命令:hbase shell,会进入到你的 hbase shell 客 户端 [hadoop@hadoop1 ~]$ hbase shell S ...

- HBase学习之路 (一)HBase基础介绍

产生背景 自 1970 年以来,关系数据库用于数据存储和维护有关问题的解决方案.大数据的出现后, 好多公司实现处理大数据并从中受益,并开始选择像 Hadoop 的解决方案.Hadoop 使用分 布式文 ...

- HBase 学习之路(九)——HBase容灾与备份

一.前言 本文主要介绍Hbase常用的三种简单的容灾备份方案,即CopyTable.Export/Import.Snapshot.分别介绍如下: 二.CopyTable 2.1 简介 CopyTabl ...

- HBase 学习之路(六)——HBase Java API 的基本使用

一.简述 截至到目前(2019.04),HBase 有两个主要的版本,分别是1.x 和 2.x ,两个版本的Java API有所不同,1.x 中某些方法在2.x中被标识为@deprecated过时.所 ...

- 大数据学习之路之HBASE

Hadoop之HBASE 一.HBASE简介 HBase是一个开源的.分布式的,多版本的,面向列的,半结构化的NoSql数据库,提供高性能的随机读写结构化数据的能力.它可以直接使用本地文件系统,也可以 ...

- 【Hbase学习之二】Hbase 搭建

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 hbase-2.1.3 一.单机模 ...

- Hbase 学习(十) HBase Snapshots

HBase Snapshots允许你对一个表进行快照(即可用副本),它不会对Region Servers产生很大的影响,它进行复制和 恢复操作的时候不包括数据拷贝.导出快照到另外的集群也不会对Regi ...

随机推荐

- 我眼中的robot framework

由于近期公司需要,需要一个测试框架对于公司的服务做自动化测试. 由于服务的复杂性,人工测试的方式越来越复杂,体现在以下方面: 1.人工测试步骤复杂,容易出错.服务的复杂性会使人工测试的准备工作,测试条 ...

- Linux性能测试 top命令

原文地址:http://www.cnblogs.com/txw1958/archive/2012/07/25/linux-top-command.html top命令是Linux下常用的性能分析工具, ...

- Global Contrast based Salient Region Detection (Ming ming Cheng)

abstract: Automatic estimation of salient object regions across images, without any prior assumption ...

- HBase 数据备份

HBase提供了备份API,直接使用shell脚本可以叫它.如下面的命令的详细信息: hbase org.apache.hadoop.hbase.mapreduce.Export 'user' /hb ...

- angular form set dynamic control(form动态设置control)

实现效果 form表单控件的实时更新 效果如图 关键代码 validateForm: FormGroup; // 表单校验 constructor( private fb: FormBuilder ) ...

- GIS基础软件及操作(四)

原文 GIS基础软件及操作(四) 练习四.空间数据处理 1.空间数据处理(融合.合并.剪切.交叉.合并)2.设置地图投影及投影变换 空间数据处理 数据:云南县界.shp; Clip.shp西双版纳森林 ...

- Dynamic proxy (good-原创)

import java.lang.reflect.InvocationHandler; import java.lang.reflect.Method; import java.lang.reflec ...

- Android零基础入门第4节:正确安装和配置JDK, 高富帅养成第一招

原文:Android零基础入门第4节:正确安装和配置JDK, 高富帅养成第一招 在前几期中总结分享了Android的前世今生.Android 系统架构和应用组件那些事.带你一起来聊一聊Android开 ...

- C#高性能大容量SOCKET并发(五):粘包、分包、解包

原文:C#高性能大容量SOCKET并发(五):粘包.分包.解包 粘包 使用TCP长连接就会引入粘包的问题,粘包是指发送方发送的若干包数据到接收方接收时粘成一包,从接收缓冲区看,后一包数据的头紧接着前一 ...

- extjs grid 复选框选择事件

开发中需求是统计选择的行数,所以要监控checkbox的选择事件包括表头的全选事件 遇到的问题就不赘述了 方案是监控grid的复选框和行加载时绑定事件 baseView: DBEN.controls. ...