Scrapy爬取豆瓣图书数据并写入MySQL

项目地址 BookSpider

介绍

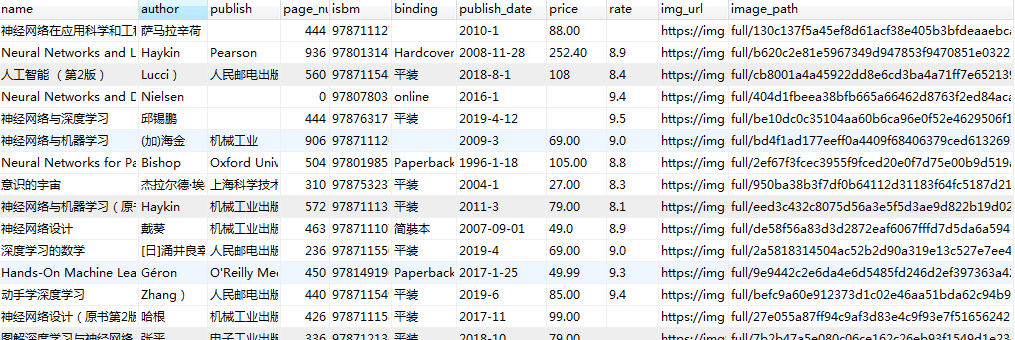

本篇涉及的内容主要是获取分类下的所有图书数据,并写入MySQL

准备

Python3.6、Scrapy、Twisted、MySQLdb等

演示

代码

一、创建项目

scrapy startproject BookSpider #创建项目

scrapy genspider douban book.douban.com #创建豆瓣爬虫

二、创建测试类(main.py)

from scrapy.cmdline import execute

execute(['scrapy', 'crawl', 'douban'])

三、修改配置(spiders/settings.py)

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.100 Safari/537.36' #浏览器

ROBOTSTXT_OBEY = False #不遵循豆瓣网站的爬虫协议

四、设置爬取的分类(spiders/douban.py)

start_urls = ['https://book.douban.com/tag/神经网络'] # 只测试爬取神经网络

五、获取分类列表页图书数据

from scrapy.http import Request

from urllib.parse import urljoin

def parse(self, response):

get_nodes = response.xpath('//div[@id="subject_list"]/ul/li/div[@class="pic"]/a')

for node in get_nodes:

url = node.xpath("@href").get()

img_url = node.xpath('img/@src').get()

yield Request(url=url, meta={"img_url": img_url}, callback=self.parse_book) # 传递img_url值 放在meta里面, parse_book回调函数,获取的详情再分析

next_url = response.xpath('//div[@class="paginator"]/span[@class="next"]/a/@href').get() # 获取下一页地址

if(next_url):

yield Request(url=urljoin(response.url, next_url), callback=self.parse) # 获取下一页内容

六、定义数据模型(spiders/items.py)

class BookspiderItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

name = scrapy.Field()

author = scrapy.Field()

publish = scrapy.Field()

page_num = scrapy.Field()

isbm = scrapy.Field()

binding = scrapy.Field()

publish_date = scrapy.Field()

price = scrapy.Field()

rate = scrapy.Field()

img_url = scrapy.Field()

image_path = scrapy.Field()

七、获取图书详情数据

import re

from BookSpider.items import BookspiderItem

def parse_book(self, response):

BookItem = BookspiderItem()

BookItem['name'] = response.xpath('//span[@property="v:itemreviewed"]/text()').get("").strip()

BookItem['author'] = response.xpath('//span[contains(text(), "作者")]/following-sibling::a[1]/text()').get("").split()[-1]

BookItem['publish'] = response.xpath('//span[contains(text(), "出版社")]/following-sibling::text()').get("").strip()

page_num = response.xpath('//span[contains(text(), "页数")]/following-sibling::text()').get("").strip()

BookItem['page_num'] = 0 if(page_num == '') else page_num

BookItem['isbm'] = response.xpath('//span[contains(text(), "ISBN")]/following-sibling::text()').get("").strip()

BookItem['binding'] = response.xpath('//span[contains(text(), "装帧")]/following-sibling::text()').get("").strip()

BookItem['publish_date'] = response.xpath('//span[contains(text(), "出版年")]/following-sibling::text()').get("").strip()

price = response.xpath('//span[contains(text(), "定价")]/following-sibling::text()').get("").strip()

BookItem['price'] = '' if(len(price) == 0) else re.findall(r'\d+\.?\d*', price)[0]

BookItem['rate'] = response.xpath('//div[contains(@class, "rating_self ")]/strong/text()').get("").strip()

BookItem['img_url'] = [response.meta.get('img_url')] #图片是列表

yield BookItem

八、下载图片

1、创建images文件加

2、配置spiders/settings.py

ITEM_PIPELINES = {

'BookSpider.pipelines.ImageStorePipeline': 1, #后面的数据是优先级

}

IMAGES_URLS_FIELD = "image_url"

IMAGES_STORE = os.path.join(os.path.abspath(os.path.dirname(__file__)), 'images')

3、创建ImageStorePipeline类(spiders/pipelines.py)

from scrapy.pipelines.images import ImagesPipeline

from scrapy.exceptions import DropItem

from scrapy.http import Request

class ImageStorePipeline(ImagesPipeline):

default_headers = {

'accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3',

'accept-encoding': 'gzip, deflate, br',

'accept-language': 'zh-CN,zh;q=0.9',

'user-agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.100 Safari/537.36', #这个一定要

}

def get_media_requests(self, item, info):

for image_url in item['img_url']:

self.default_headers['referer'] = image_url

yield Request(image_url, headers=self.default_headers)

def item_completed(self, results, item, info):

image_path = [x['path'] for ok, x in results if ok]

if not image_path:

raise DropItem("Item contains no images")

item['image_path'] = image_path

return item

八、写入数据库

1、配置spiders/settings.py

#设置数据库

MYSQL_HOST = ""

MYSQL_DBNAME = ""

MYSQL_USER = ""

MYSQL_PASSWORD = ""

ITEM_PIPELINES = {

'BookSpider.pipelines.ImageStorePipeline': 1,

'BookSpider.pipelines.MysqlTwistedPipeline': 30,

}

2、创建MysqlTwistedPipeline类(spiders/pipelines.py)

import MySQLdb.cursors

from twisted.enterprise import adbapi

class MysqlTwistedPipeline(object):

def __init__(self, dbpool):

self.dbpool = dbpool

@classmethod #静态方法,会优先执行from_settings, 这样self.dbpool就有值了

def from_settings(cls, settings):

dbpool = adbapi.ConnectionPool("MySQLdb", host=settings['MYSQL_HOST'], db = settings['MYSQL_DBNAME'], user = settings['MYSQL_USER'], passwd = settings['MYSQL_PASSWORD'], charset = 'utf8', cursorclass = MySQLdb.cursors.DictCursor, use_unicode = True)

return cls(dbpool)

def process_item(self, item, spider):

query = self.dbpool.runInteraction(self.do_insert, item)

query.addErrback(self.handle_error,item,spider)

def do_insert(self, cursor, item):

insert_sql = """

insert into douban(name, author, publish, page_num, isbm, binding, publish_date, price, rate, img_url, image_path)

values (%s, %s, %s, %s, %s, %s, %s, %s, %s, %s, %s)

"""

cursor.execute(insert_sql, (item['name'], item['author'], item['publish'], item['page_num'], item['isbm'], item['binding'], item['publish_date'], item['price'], item['rate'], item['img_url'], item['image_path']))

def handle_error(self, failure, item, spider):

print(failure)

九、测试

1、执行main.py文件

Scrapy爬取豆瓣图书数据并写入MySQL的更多相关文章

- python系列之(3)爬取豆瓣图书数据

上次介绍了beautifulsoup的使用,那就来进行运用下吧.本篇将主要介绍通过爬取豆瓣图书的信息,存储到sqlite数据库进行分析. 1.sqlite SQLite是一个进程内的库,实现了自给自足 ...

- Scrapy 通过登录的方式爬取豆瓣影评数据

Scrapy 通过登录的方式爬取豆瓣影评数据 爬虫 Scrapy 豆瓣 Fly 由于需要爬取影评数据在来做分析,就选择了豆瓣影评来抓取数据,工具使用的是Scrapy工具来实现.scrapy工具使用起来 ...

- 【python数据挖掘】爬取豆瓣影评数据

概述: 爬取豆瓣影评数据步骤: 1.获取网页请求 2.解析获取的网页 3.提速数据 4.保存文件 源代码: # 1.导入需要的库 import urllib.request from bs4 impo ...

- scrapy爬取豆瓣电影top250

# -*- coding: utf-8 -*- # scrapy爬取豆瓣电影top250 import scrapy from douban.items import DoubanItem class ...

- requests+正则爬取豆瓣图书

#requests+正则爬取豆瓣图书 import requests import re def get_html(url): headers = {'User-Agent':'Mozilla/5.0 ...

- Python 2.7_利用xpath语法爬取豆瓣图书top250信息_20170129

大年初二,忙完家里一些事,顺带有人交流爬取豆瓣图书top250 1.构造urls列表 urls=['https://book.douban.com/top250?start={}'.format(st ...

- python2.7爬取豆瓣电影top250并写入到TXT,Excel,MySQL数据库

python2.7爬取豆瓣电影top250并分别写入到TXT,Excel,MySQL数据库 1.任务 爬取豆瓣电影top250 以txt文件保存 以Excel文档保存 将数据录入数据库 2.分析 电影 ...

- 爬虫之爬取豆瓣图书名字及ID

from urllib import request from bs4 import BeautifulSoup as bs #爬取豆瓣最受关注图书榜 resp = request.urlopen(' ...

- Python爬虫-爬取豆瓣图书Top250

豆瓣网站很人性化,对于新手爬虫比较友好,没有如果调低爬取频率,不用担心会被封 IP.但也不要太频繁爬取. 涉及知识点:requests.html.xpath.csv 一.准备工作 需要安装reques ...

随机推荐

- SpringCache - 请求级别缓存的简易实现

前言 在SpringCache缓存初探中我们研究了如何利用spring cache已有的几种实现快速地满足我们对于缓存的需求.这一次我们有了新的更个性化的需求,想在一个请求的生命周期里实现缓存. 需求 ...

- java架构之路-(分布式zookeeper)zookeeper真实使用场景

上几次博客,我说了一下Zookeeper的简单使用和API的使用,我们接下来看一下他的真实场景. 一.分布式集群管理✨✨✨ 我们现在有这样一个需求,请先抛开Zookeeper是集群还是单机的概念,下面 ...

- webpack loader实现

正值前端组件化开发时代,那么必然离不开目前最火的构建工具--webpack(grunt,gulp等暂且不谈).说到这里,刚好有几个问题: 为什么运行打包命令之后,.vue 文件可以转成 .js 文件 ...

- css父元素透明度(opacity)对子元素的影响

首先子元素会继承父元素的透明度: 设置父元素opacity:0.5,子元素不设置opacity,子元素会受到父元素opacity的影响,也会有0.5的透明度. 其次子元素的透明度是基于父元素的透明度计 ...

- 6.InfluxDB-InfluxQL基础语法教程--GROUP BY子句

本文翻译自官网,官网地址:(https://docs.influxdata.com/influxdb/v1.7/query_language/data_exploration/) GROUP BY子句 ...

- django后台管理-admin

0922自我总结 django后台管理-admin 一.模型注册 admin.py 注册方式一: #在对于注册的app中的admin文件中导入模型然后注册模型 admin.site.register( ...

- PHP绕过disable_function限制(一)

测试环境 php 5.4.5 0x01 利用系统组件绕过 1.window com组件(php 5.4)(高版本扩展要自己添加) (COM组件它最早的设计意图是,跨语言实现程序组件的复用.) 测试: ...

- 本地向服务器上传文件的方式-FTP工具上传

笔者负责的一个研究生会的项目,向服务器端传项目代码,用到了FTP工具,这里总结下: FTP方式的步骤: 1,服务器端配置好FTP,(若没有,可网上下载一个服务器端安装的FTP).停止服务后,可以配置账 ...

- opencv::处理边缘

卷积边界问题 图像卷积的时候边界像素,不能被卷积操作,原因在于边界像素没有完全跟kernel重叠,所以当3x3滤波时候有1个像素的边缘没有被处理,5x5滤波的时候有2个像素的边缘没有被处理. 处理边缘 ...

- php服务器有哪些

服务器按照功能可以分为:文件服务器.数据库服务器.web服务器.邮件服务器.代理服务器..... 而上述所有的服务器,均可以用php做开发,比如说做web服务器,常用的构架是php+Mysql+Apa ...