Spark Dataframe 转 Json

import org.apache.spark.sql.DataFrame

import org.apache.spark.sql.functions._

import org.apache.spark.sql.types._ // Convenience function for turning JSON strings into DataFrames.

def jsonToDataFrame(json: String, schema: StructType = null): DataFrame = {

// SparkSessions are available with Spark 2.0+

val reader = spark.read Option(schema).foreach(reader.schema)

reader.json(sc.parallelize(Array(json)))

}

// Using a struct

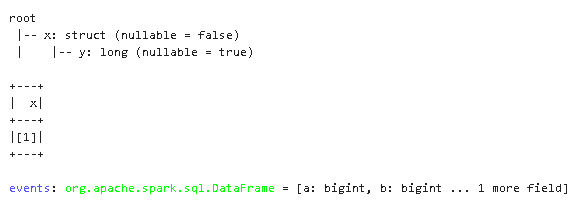

val schema = new StructType().add("a", new StructType().add("b", IntegerType)) val events = jsonToDataFrame("""

{

"a": {

"b": 1

}

}

""", schema) events.select("a.b").show()

val events = jsonToDataFrame("""

{

"a": 1,

"b": 2,

"c": 3

}

""")

events.select(struct('a as 'y) as 'x).printSchema()

events.select(struct('a as 'y) as 'x).show()

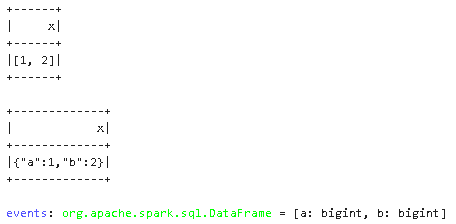

val events = jsonToDataFrame("""

{

"a": 1,

"b": 2

}

""")

events.select((struct("*") as 'x)).show()

events.select(to_json(struct("*")) as 'x).show()

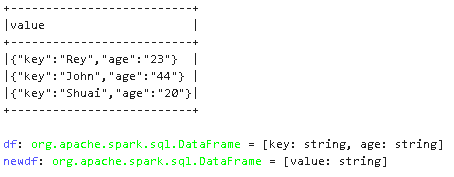

val df = Seq(("Rey", "23"), ("John", "44"),("Shuai", "20") ).toDF("key", "age")

df.columns.map(column)

val newdf = df.select(to_json(struct(df.columns.map(column):_*)).alias("value"))

newdf.show(false)

Ref:

https://docs.databricks.com/_static/notebooks/transform-complex-data-types-scala.html

Spark Dataframe 转 Json的更多相关文章

- Spark SQL,如何将 DataFrame 转为 json 格式

今天主要介绍一下如何将 Spark dataframe 的数据转成 json 数据.用到的是 scala 提供的 json 处理的 api. 用过 Spark SQL 应该知道,Spark dataf ...

- spark DataFrame的创建几种方式和存储

一. 从Spark2.0以上版本开始,Spark使用全新的SparkSession接口替代Spark1.6中的SQLContext及HiveContext接口来实现其对数据加载.转换.处理等功能.Sp ...

- spark dataframe unionall

今天本来想写一个spark dataframe unionall的demo,由于粗心报下面错误: Exception in thread "main" org.apache.spa ...

- spark dataframe操作集锦(提取前几行,合并,入库等)

https://blog.csdn.net/sparkexpert/article/details/51042970 spark dataframe派生于RDD类,但是提供了非常强大的数据操作功能.当 ...

- spark DataFrame 常见操作

spark dataframe派生于RDD类,但是提供了非常强大的数据操作功能.当然主要对类SQL的支持. 在实际工作中会遇到这样的情况,主要是会进行两个数据集的筛选.合并,重新入库. 首先加载数据集 ...

- Spark DataFrame中的join使用说明

spark sql 中join的类型 Spark DataFrame中join与SQL很像,都有inner join, left join, right join, full join; 类型 说明 ...

- 转】Spark DataFrame小试牛刀

原博文出自于: https://segmentfault.com/a/1190000002614456 感谢! 三月中旬,Spark发布了最新的1.3.0版本,其中最重要的变化,便是DataFrame ...

- spark DataFrame 读写和保存数据

一.读写Parquet(DataFrame) Spark SQL可以支持Parquet.JSON.Hive等数据源,并且可以通过JDBC连接外部数据源.前面的介绍中,我们已经涉及到了JSON.文本格式 ...

- spark dataFrame withColumn

说明:withColumn用于在原有DF新增一列 1. 初始化sqlContext val sqlContext = new org.apache.spark.sql.SQLContext(sc) 2 ...

- spark&dataframe

1.今天,我们来介绍spark以及dataframe的相关的知识点,但是在此之前先说一下对以前的hadoop的一些理解 当我启动hadoop的时候,上面有hdfs的存储结构,由于这个是分布式存储,所以 ...

随机推荐

- Vue3 如何接入 i18n 实现国际化多语言

1. 基本方法 在 Vue.js 3 中实现网页的国际化多语言,最常用的包是 vue-i18n,通常我们会与 vue-i18n-routing 一起使用. vue-i18n 负责根据当前页面的语言渲染 ...

- yb课堂 新版VueCli 4.3创建vue项目,Vue基础语法入门 《二十九》

Vue模版语法开发起步 基于HTML的模版语法,允许声明式地将DOM绑定至底层Vue实例的数据 用简洁的模版语法来声明式的将数据渲染进DOM的系统 结合响应系统,在应用状态改变时,Vue能够智能地计算 ...

- 洛谷P1043

[NOIP2003 普及组] 数字游戏 题目描述 丁丁最近沉迷于一个数字游戏之中.这个游戏看似简单,但丁丁在研究了许多天之后却发觉原来在简单的规则下想要赢得这个游戏并不那么容易.游戏是这样的,在你面前 ...

- 转载 | ofd转pdf最好用的软件,ofd文件如何转化成pdf?

1.背景 需要将ofd转换为pdf 2.使用方法 使用taurusxin 开发的软件Ofd2Pdf.exe即可实现,软件版权归原作者所有.这里表示感谢! 3.下载地址 官网:https://githu ...

- 安装jieba中文分词库

插入一条: 有个更快安装下载jieba的方法,用镜像下载,非常快,2秒就行 pip install jieba -i https://pypi.douban.com/simple/ 1.打开官方网站: ...

- 整段 html实现其中的每一个 a 标签跨域下载操作 window.URL.createObjectURL(blob)

window.URL.createObjectURL(blob) a 标签下载问题,通常在 a 标签中加上download属性,就可完成对href属性链接文件的下载,但仅仅是限于同源文件,如果是非同源 ...

- nacos一个奇怪的问题:找不到正确的应用名-环境.后缀名配置文件

spring: profiles: active: dev application: name: system-api cloud: nacos: server-addr: 192.168.101.6 ...

- 【JS】03 BOM 浏览器对象模型

BOM :Broswer Object Model 浏览器对象模型 核心对象是window对象,window对象又可以操作以下的常见对象: - frames[] 窗口对象数组? 浏览器可以打开多个窗口 ...

- NVIDA GPU-SXM和NVIDA GPU-PCIe 两种类型显卡到底哪个性能更高?

相关: 大模型时代该用什么样的显卡 -- 实验室新进两块A800显卡 浅析:NVIDA GPU卡SXM和PCIe之间的差异性 原来SXM类型的显卡比PCIex类型显卡性能要高.PCIE版本是通用接口, ...

- 腾达Tenda电力猫PA3的无线名称和密码

趁着2023年的双11,买了一对腾达电力猫,毕竟在家里长距离使用这东西还是蛮方便的. =============================== 配置其实蛮简单的,配对嘛,就是两个都插上电,然后在 ...