如何快速搭建hadoop集群

安装好虚拟机,重命名为master

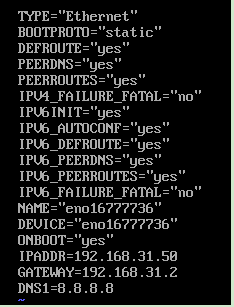

配置网卡

命令:vi /etc/sysconfig/network-scripts/ifcfg-en(按tab键)

这里要配置ip,网关,域名解析

例如我的

IPADDR=192.168.31.50

GATEWAY=192.168.31.2

DNS1=8.8.8.8

接着我们需要重启网卡才能生效

[root@localhost ~]# :service network restart

检验外网是否能连接

[root@localhost ~]#(以百度为例):ping www.baidu.com

(配置网卡完)

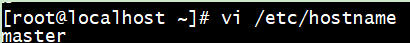

修改主机名(不能含有空格及特殊字符)

[root@localhost ~]# vi /etc/hostnname

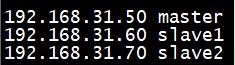

添加映射(使三台虚拟机能够相互通信)

[root@localhost ~]# vi /etc/hosts

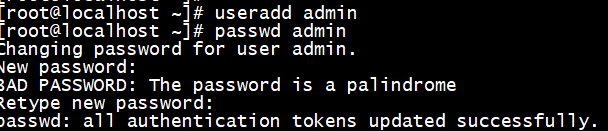

添加一个普通用户(admin),并设置密码

[root@localhost ~]# useradd admin

[root@localhost ~]# passwd admin

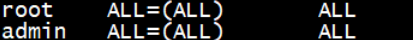

将我们添加的用户(admin)写入到配置文件中

[root@localhost ~]# visudo

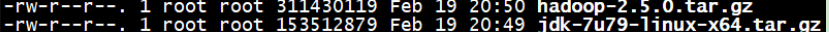

将hadoop和jdk的压缩包上传并解压

[root@localhost software]#tar -zxf hadoop-2.5.0.tar.gz -C /opt/modoules/

[root@localhost software]#tar -zxf jdk-7u79-linux-x64.tar.gz -C /opt/modoules/

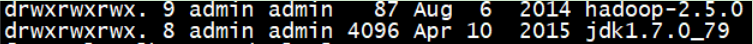

将压缩文件修改为普通(admin)用户,并开放所有权限

[root@localhost modoules]#chown admin:admin -R hadoop-2.5.0/

[root@localhost modoules]#chown admin:admin -R jdk1.7.0_79/

[root@localhost modoules]# chmod 777 -R hadoop-2.5.0/

[root@localhost modoules]# chmod 777 -R jdk1.7.0_79/

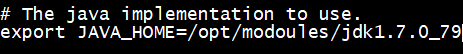

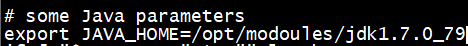

添加配置文件

[root@localhost modoules]# vi /etc/profile

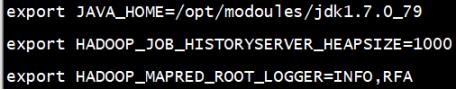

在hadoop-2.5.0下创建一个文件,并进行更名和权限赋予

用途:(用来指定hadoop运行时产生文件的存储目录 )

[root@localhost hadoop-2.5.0]# mkdir -p data/tmp

[root@localhost hadoop-2.5.0]# chown admin:admin -R data

[root@localhost hadoop-2.5.0]# chown 777 -R data

切换至hadoop目录,进行配置文件的更改

[root@localhost hadoop-2.5.0]# cd ./etc/hadoop

我们需要修改的配置文件如下

[root@localhost hadoop]# vi hadoop-env.sh

[root@localhost hadoop]# vi yarn-env.sh

(#代表注释,需要进行删除,才能生效)

[root@localhost hadoop]# vi mapred-env.sh

(#代表注释,需要进行删除,才能生效)

[root@localhost hadoop]# vi core-site.xml

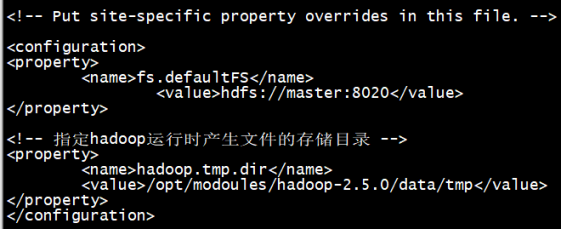

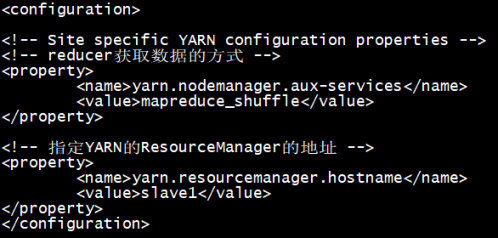

[root@localhost hadoop]# vi yarn-site.xml

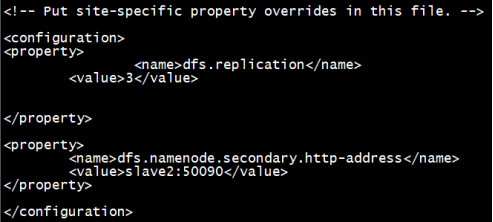

[root@localhost hadoop]# vi hdfs-site.xml

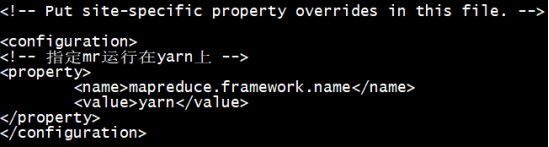

对mapred-site.xml.template文件进行更名,再进行配置

[root@localhost hadoop]# mv mapred-site.xml.template mapred-site.xml

[root@localhost hadoop]# vi mapred-site.xml

[root@localhost hadoop]# vi slaves

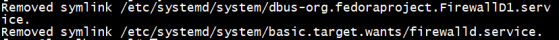

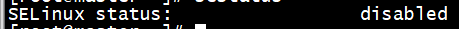

关闭防火墙状态

[root@localhost ~]# systemctl stop firewalld.service

[root@localhost ~]# systemctl disable firewalld.service

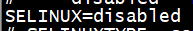

[root@localhost selinux]# cd /etc/selinux

[root@localhost selinux]# vi config

查看防火墙状态(查看之前先进行重启,否则不生效)

[root@localhost ~]# sestatus

克隆两台机器(虚拟机必须处于关机状态才能克隆,此外,选择完整克隆,不要链接克隆)

(并对另外两台网卡的ip,主机名做相应的更改)

(否则三台机器会出现ip冲突,或者意外报错)

master(主节点)

slave1(从节点)

slave2(从节点)

三台机器配置完成

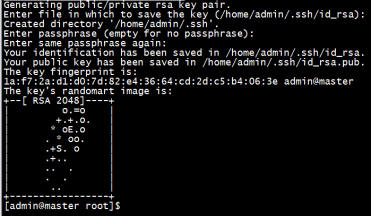

设置免密登录

(让三台机器进行无密钥通信)最好是用普通用户

[root@master ~]# su admin

[admin@master root]$ ssh-keygen(三次回车)

[admin@master root]$ ssh copy-id master

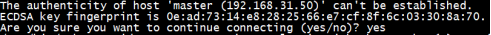

(以下操作会问:是否愿意给密钥给xxx,回答yes,其他机器皆如此)

同意之后它会要求进行密码的验证(如果三次输入密码错误,将会自动退出并进行从新输入)

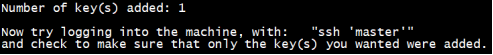

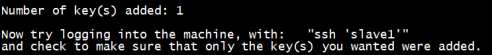

(说明密钥已成功给出)

[admin@master root]$ ssh-copy-id slave1

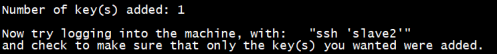

(说明密钥已成功给出)

(说明密钥已成功给出)

slave1,slave2需要重复以上操作

(否则三台机器会因为没有共同的密钥,从而导致无法访问)

切换目录,开始准备启动hadoop

[admin@master root]$ cd /opt/modoules/hadoop-2.5.0

进行格式化(只能操作一次,除非是配置文件错误,才能进行二次格式化,否则会出现一大堆的报错信息)

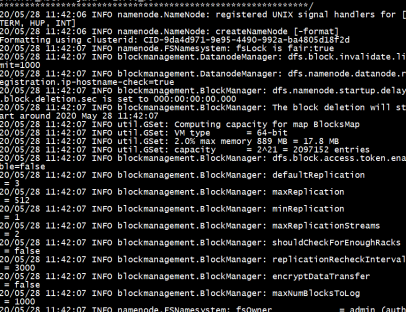

[admin@master hadoop-2.5.0]$ bin/hdfs namenode -format

格式化成功

(只能出现INFO,如果是error,expectation说明配置文件发生异常,需要返回进行检查并做相应的更改,不要忘记更改之后要进行格式化)

启动dfs

[admin@master hadoop-2.5.0]$ sbin/start-dfs.sh

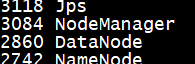

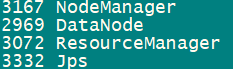

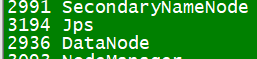

(显示如下进程说明启动成功)

启动yarn

[admin@slave1 hadoop-2.5.0]$ sbin/statr-yarn.sh

用jps查看MapReduce的进程

(以上就是hadoop的搭建)

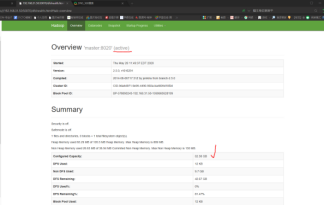

查看能否访问web页面

(active提示页面是可用,查看内存是否正常,如果是0说明非正常状态)

查看我们的datenode节点是否有三台虚拟机,如果只有1台或2台说明集群未能启动

如何快速搭建hadoop集群的更多相关文章

- VMware 克隆linux后找不到eth0(学习hadoop,所以想快速搭建一个集群)

发生情况: 由于在学习hadoop,所以想快速搭建一个集群出来.所以直接在windows操作系统上用VMware安装了CentOS操作系统,配置好hadoop开发环境后,采用克隆功能,直接克 ...

- 环境搭建-Hadoop集群搭建

环境搭建-Hadoop集群搭建 写在前面,前面我们快速搭建好了centos的集群环境,接下来,我们就来开始hadoop的集群的搭建工作 实验环境 Hadoop版本:CDH 5.7.0 这里,我想说一下 ...

- 使用Windows Azure的VM安装和配置CDH搭建Hadoop集群

本文主要内容是使用Windows Azure的VIRTUAL MACHINES和NETWORKS服务安装CDH (Cloudera Distribution Including Apache Hado ...

- virtualbox 虚拟3台虚拟机搭建hadoop集群

用了这么久的hadoop,只会使用streaming接口跑任务,各种调优还不熟练,自定义inputformat , outputformat, partitioner 还不会写,于是干脆从头开始,自己 ...

- 搭建Hadoop集群 (三)

通过 搭建Hadoop集群 (二), 我们已经可以顺利运行自带的wordcount程序. 下面学习如何创建自己的Java应用, 放到Hadoop集群上运行, 并且可以通过debug来调试. 有多少种D ...

- 搭建Hadoop集群 (一)

上面讲了如何搭建Hadoop的Standalone和Pseudo-Distributed Mode(搭建单节点Hadoop应用环境), 现在我们来搭建一个Fully-Distributed Mode的 ...

- 搭建Hadoop集群 (二)

前面的步骤请看 搭建Hadoop集群 (一) 安装Hadoop 解压安装 登录master, 下载解压hadoop 2.6.2压缩包到/home/hm/文件夹. (也可以从主机拖拽或者psftp压缩 ...

- Linux下搭建Hadoop集群

本文地址: 1.前言 本文描述的是如何使用3台Hadoop节点搭建一个集群.本文中,使用的是三个Ubuntu虚拟机,并没有使用三台物理机.在使用物理机搭建Hadoop集群的时候,也可以参考本文.首先这 ...

- Hadoop入门进阶步步高(五)-搭建Hadoop集群

五.搭建Hadoop集群 上面的步骤,确认了单机能够运行Hadoop的伪分布运行,真正的分布式运行无非也就是多几台slave机器而已,配置方面的有一点点差别,配置起来就很easy了. 1.准备三台se ...

随机推荐

- PyQt(Python+Qt)学习随笔:Qt Designer中QAbstractButton派生按钮部件autoExclusive属性

autoExclusive 属性保留是否启用按钮的自动排它特性,如果启用了,则属于同一父部件的可选中按钮任何时候只能选中一个按钮:选中另一个按钮将自动取消选中先前选中的按钮,这个功能与排他性按钮组的功 ...

- MacOS上Parallels Desktop安装MacOSHighSierra

下载dmg文件 http://www.macoshome.com/macos/977.html 配置宿主机时间2015-10-27 23:25 为了防止"macOS未能安装在您的电脑上_安装 ...

- UOJ80 二分图最大权匹配

草,学了一下午假板子,sb博客害人 题目大意: 一个教室有\(n\)个男生和\(m\)个女生,某些男女之间愿意早恋(雾),其早恋好感度为\(w_i\),问怎样让男女配对使得班里好感度之和最大 \(n\ ...

- 【题解】「CF1373B」01 Game

这题好水,就是简单的模拟+字符串. \(\sf Translation\) 给定一个 \(01\) 串,如果 \(0\) 出现的次数和 \(1\) 出现的次数的最小值是奇数,输出 DA ,否则输出 N ...

- 题解-JSOI2011 分特产

题面 JSOI2011 分特产 有 \(n\) 个不同的盒子和 \(m\) 种不同的球,第 \(i\) 种球有 \(a_i\) 个,用光所有球,求使每个盒子不空的方案数. 数据范围:\(1\le n, ...

- 题解-洛谷P4859 已经没有什么好害怕的了

洛谷P4859 已经没有什么好害怕的了 给定 \(n\) 和 \(k\),\(n\) 个糖果能量 \(a_i\) 和 \(n\) 个药片能量 \(b_i\),每个 \(a_i\) 和 \(b_i\) ...

- Django认证系统并不鸡肋反而很重要

在使用django-admin startproject创建项目后,Django就默认安装了一个采用session实现的认证系统.这是Django相比于其他框架的一大特点:自带认证系统,开箱即用.有人 ...

- 转载-没有IE就没有伤害!浏览器兼容性问题解决方案汇总

普及:浏览器的兼容性问题,往往是个别浏览器(没错,就是那个与众不同的浏览器)对于一些标准的定义不一致导致的.俗话说:没有IE就没有伤害. 贴士:内容都是自己总结的,不免会出现错误或者bug,欢迎更正和 ...

- Pytest 学习(二十五)- allure 命令行参数【转】

先看看 allure 命令的帮助文档 cmd 敲 allure -h allure 命令的语法格式 allure [options] [command] [command options] optio ...

- oracle 11g调优常用语句

1.查询表的基数及选择性 select a.column_name, b.num_rows, a.num_distinct cardinality, round( ...