Flume HA

flume提供fail over和load balance功能

1.添加collector配置(配置两个collector)

# Name the components on this agent

s1.sources = r1

s1.sinks = k1

s1.channels = c1

# Describe/configure the source

s1.sources.r1.type = avro #设置source类型,固定avro

s1.sources.r1.bind = node2 #设置绑定的hostname,agent会上传数据到这个hostname的端口

s1.sources.r1.port = 52020 #设置port

s1.sources.r1.interceptors = avroSerializeInterceptor

s1.sources.r1.interceptors.avroSerializeInterceptor.type = AvroSerializeInterceptor$Builder

#a1.sources.r1.port = 44444

# Describe the sink

s1.sinks.k1.type = org.apache.flume.sink.kafka.KafkaSink

s1.sinks.k1.kafka.topic = tp002

s1.sinks.k1.kafka.bootstrap.servers = 192.168.0.118:9092,192.168.0.118:9093,192.168.0.118:9094

s1.sinks.k1.kafka.flumeBatchSize = 20

s1.sinks.k1.kafka.producer.acks = 1

s1.sinks.k1.kafka.producer.linger.ms = 1

s1.sinks.k1.kafka.producer.compression.type = snappy

# Use a channel which buffers events in memory

s1.channels.c1.type = memory

s1.channels.c1.capacity = 1000

s1.channels.c1.transactionCapacity = 100

# Bind the source and sink to the channel

s1.sources.r1.channels = c1

s1.sinks.k1.channel = c1

2.添加agent配置

# Name the components on this agent

a1.sources = r1

a1.sinks = k1 k2 #设置多个sink

a1.channels = c1

a1.sinkgroups = g1 #设置sinkgroup,为配置load balance或者failover做准备

# Describe/configure the source

a1.sources.r1.channels = c1

a1.sources.r1.type = exec

a1.sources.r1.command = tail -f /tmp/test.log

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# Describe the sink

a1.sinks.k1.channel = c1

a1.sinks.k1.type = avro

a1.sinks.k1.hostname = node2 #设置要上传数据的hostname和端口,对应collector中的配置

a1.sinks.k1.port = 52020

a1.sinks.k2.channel = c1

a1.sinks.k2.type = avro

a1.sinks.k2.hostname = node2 #同上

a1.sinks.k2.port = 52021

# set sink group

a1.sinkgroups.g1.sinks = k1 k2 #设置group中的sink

# set group

a1.sinkgroups.g1.processor.type = failover #设置sinkgroup处理类型为fail over,取值类型为default,failover,load_balance

a1.sinkgroups.g1.processor.priority.k1 = 1 #设置sink权重

a1.sinkgroups.g1.processor.priority.k2 = 2

a1.sinkgroups.g1.processor.maxpenalty = 10000

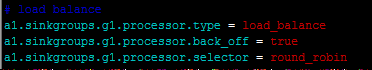

Load balance配置

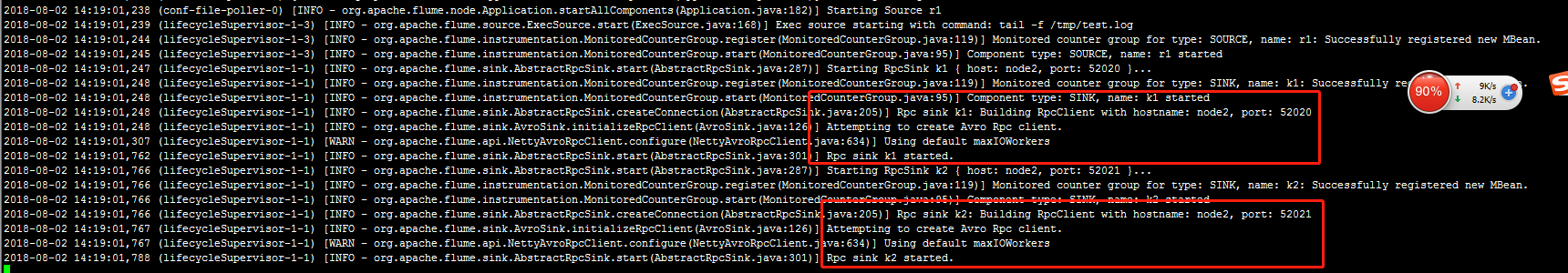

启动collector和agent会有相关日志

Flume HA的更多相关文章

- 海量日志采集Flume(HA)

海量日志采集Flume(HA) 1.介绍: Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集.聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据 ...

- flume的使用

1.flume的安装和配置 1.1 配置java_home,修改/opt/cdh/flume-1.5.0-cdh5.3.6/conf/flume-env.sh文件

- Flume - Kafka日志平台整合

1. Flume介绍 Flume是Cloudera提供的一个高可用的,高可靠的,分布式的海量日志采集.聚合和传输的系统,Flume支持在日志系统中定制各类数据发送方,用于收集数据:同时,Flume提供 ...

- Flafka: Apache Flume Meets Apache Kafka for Event Processing

The new integration between Flume and Kafka offers sub-second-latency event processing without the n ...

- 【翻译】Flume 1.8.0 User Guide(用户指南) Processors

翻译自官网flume1.8用户指南,原文地址:Flume 1.8.0 User Guide 篇幅限制,分为以下5篇: [翻译]Flume 1.8.0 User Guide(用户指南) [翻译]Flum ...

- 【翻译】Flume 1.8.0 User Guide(用户指南) Channel

翻译自官网flume1.8用户指南,原文地址:Flume 1.8.0 User Guide 篇幅限制,分为以下5篇: [翻译]Flume 1.8.0 User Guide(用户指南) [翻译]Flum ...

- 【翻译】Flume 1.8.0 User Guide(用户指南) Sink

翻译自官网flume1.8用户指南,原文地址:Flume 1.8.0 User Guide 篇幅限制,分为以下5篇: [翻译]Flume 1.8.0 User Guide(用户指南) [翻译]Flum ...

- HAProxy + Keepalived + Flume 构建高性能高可用分布式日志系统

一.HAProxy简介 HAProxy提供高可用性.负载均衡以及基于TCP和HTTP应用的代 理,支持虚拟主机,它是免费.快速并且可靠的一种解决方案.HAProxy特别适用于那些负载特大的web站点, ...

- flume学习笔记

#################################################################################################### ...

随机推荐

- conda 安装虚拟环境 fastai

一.conda常用命令 1.创建一个虚拟环境env_name,后面跟的是创建这个环境时,同时安装的软件包 conda create -n env_name python=3.6 2.通过克隆创建一个环 ...

- 记录一下RAC的使用

1 常规的对数组的操作,包括遍历.刷选.映射.替换 // 遍历 NSArray * array = @["]; [array.rac_sequence.signal subscribeNe ...

- poj2182 Lost Cows[BIT二分]

blog题解鸽了许久了..本来说好的切一题写一个题解的说 一个$1 \sim n$数列,已知每个数前面比他小的数个数,试确定该序列. 相当的一道水题.可以发现数列最后一个数是首先可以确定下来的.然后把 ...

- nginx启动、停止、重启

转自https://www.cnblogs.com/wangcp-2014/p/9922845.html 启动 启动代码格式:nginx安装目录地址 -c nginx配置文件地址 例如: [root@ ...

- linux运维、架构之路-K8s应用

一.Deployment k8s通过各种Controller管理Pod的生命周期,为了满足不同的业务场景,k8s提供了Deployment.ReplicaSet.DaemonSet.S ...

- List集合的三个实现类比较

1. ArrayList 底层数据结构是数组,查询快,增删慢 线程不安全,效率高 2. Vector 底层数据结构是数组,查询快,增删慢 线程安全,效率低 3. LinkedList 底层数据结构是链 ...

- vue路由 routers的写法:require用与不用

vue路由的写法有很多种,这里我只说routers的写法,一种是compcomponent后面直接写路径,另一种是用require的方式,来看代码 import Vue from 'vue' impo ...

- JavaWeb_客户端相对/绝对路径和服务器端路径

客户端的绝对路径和相对路径 相对路径:相对与某个基准目录的路径,在同一根目录下各子目录文件之间的相互引用, 绝对路径:指目录下的绝对位置,直接到的目标位置 @charset "UTF-8&q ...

- Mysql超强卸载

1.控制面板——>所有控制面板项——>程序和功能,卸载mysql server! 2.删除MySQL文件,尤其是ProgramData里面的隐藏文件MySQL,我当时没有删除,重新安装My ...

- spark 笔记 12: Executor,task最后的归宿

spark的Executor是执行task的容器.和java的executor概念类似. ===================start executor runs task============ ...