论文翻译:Fullsubnet: A Full-Band And Sub-Band Fusion Model For Real-Time Single-Channel Speech Enhancement

论文作者:Xiang Hao, Xiangdong Su, Radu Horaud, and Xiaofei Li

翻译作者:凌逆战

论文地址:Fullsubnet:实时单通道语音增强的全频带和子频带融合模型

代码:https://github.com/haoxiangsnr/FullSubNet

摘要

本文提出了一种用于单通道实时语音增强的全频带和子频带融合模型FullSubNet。全频带和子频带是指分别输入全频带和子频带噪声频谱特征,输出全频带和子频带语音目标的模型。子带模型独立处理每个频率。它的输入由一个频率和几个上下文频率组成。输出是对相应频率的干净语音目标的预测。这两种模型有不同的特点。全频带模型可以捕获全局 上下文谱和长距离交叉频带依赖。但缺乏信号平稳性建模和关注局部谱模式的能力。子带模型正好相反。在我们提出的FullSubNet中,我们将一个纯全频带模型和一个纯子频带模型依次连接起来,并利用实际的联合训练将这两种模型的优点结合起来。我们在DNS挑战(INTERSPEECH 2020)数据集上进行了实验,对所提出的方法进行了评价。实验结果表明,全频带信息和子频带信息是互补的,FullSubNet可以有效地集成它们。此外,FullSubNet的性能也超过了DNS Challenge (INTERSPEECH 2020)中排名第一的方法。

关键词:全频带,子频带融合,子频带,语音增强

1 引言

近年来,基于深度学习的单通道语音增强方法极大地提高了语音增强系统的语音质量和可懂度。这些方法通常在有监督的环境中进行训练,可分为时域方法和频域方法。时域方法[1-3]使用神经网络直接将带噪语音映射纯净语音波形。频域方法[4-7]通常使用噪声频谱特征(例如复频谱、幅度频谱)作为神经模型的输入。学习目标是干净语音的频谱特征或某个掩码(例如,理想二进制掩码(Ideal Binary Mask, IBM)[8]、理想比率掩码(Ideal Ratio Mask, IRM)[9]、复理想比率掩码(complex Ideal Ratio Mask, cIRM)[10])。一般来说,由于时域信号的维度较高并且缺乏明显的几何结构,频域方法仍然占据绝大多数语音增强方法的主导地位。在本文中,我们重点研究了频域实时单通道语音增强。

在我们之前的工作[11]中,提出了一种基于子带的单通道语音增强方法。与传统的基于全频带的方法不同,该方法以子频带方式执行:模型的输入由一个频率和多个上下文频率组成。输出是对应频率的干净语音目标的预测。所有频率都是独立处理的。该方法的设计依据如下:

- 它学习信号的频率平稳性来区分语音和平稳噪声。众所周知,语音是非平稳的,而许多类型的噪声是相对平稳的。随频率变化的STFT幅值的时间演化反映了平稳性,这是传统噪声功率估计器[12, 13]和语音增强方法[14, 15]的基础。

- 它着重于当前和上下文频率中呈现的局部频谱。局部谱模式已被证明是区分语音和其他信号的有用信息。该方法在INTERSPEECH 2020中提交给DNS挑战[16],并在16份实时音频提交中排名第四。

子带模型满足了DNS挑战的实时性要求,性能也非常有竞争力。然而,由于它不能对全局频谱进行建模,也不能利用长距离跨频带依赖性。特别是对于信噪比极低的子带,子带模型很难恢复干净的语音,而借助于全频带相关性可以恢复干净语音。另一方面,全频带模型[4,5]的训练是学习高维输入和输出之间的回归,缺乏专门用于子频带信息(如信号平稳性)的机制。

针对上述问题,本文提出了一种全频带与子频带融合模型FullSubNet。通过大量的前期实验,将FullSubNet设计成全频带模型和子频带模型的串联。简而言之,全频带模型的输出是子频带模型的输入。通过有效的联合训练,对两种模型进行了联合优化。FullSubNet可以捕获全局(全频带)上下文,同时保留对信号平稳性进行建模和关注局部频谱模式的能力。像子带模型一样,FullSubNet仍然满足实时需求,并且可以在合理的延迟内利用未来的信息。我们在DNS挑战(INTERSPEECH 2020)数据集上评估FullSubNet。实验结果表明,FullSubNet显著优于子带模型[17]和参数量较大的纯全带模型,说明子带信息和全带信息是互补的。所提出的融合模型可以有效地集成它们。此外,我们还比较了在DNS挑战中排名靠前的方法的性能,结果表明,我们的客观性能指标优于它们。

2 方法

我们用短时傅立叶变换(STFT)域表示语音信号:

$$公式1:X(t, f)=S(t, f)+N(t, f)$$

其中$X(t, f)$,$S(t, f)$,$N(t, f)$分别代表带噪语音、纯净语音 和干扰噪声 的 复数值。$t=1, ..., T$为时间帧,$f=0, ..., F-1$为频点。

本文只研究去噪任务,目标是抑制噪声$N(t, f)$,并恢复语音信号S(t, f)。我们提出了一个全频带和子频带融合模型来完成这一任务,包括一个纯全频带模型$$和G_{full}一个纯子频带模型$G_{sub}$。基本工作流程如图1所示。接下来,我们将详细介绍每个部分。

图1所示。提出的的FullSubNet图。矩形中的第二行描述了当前阶段数据的维数,例如,1 (F)表示一个F维向量。F (2N + 1)表示F独立(2N + 1)维向量

2.1 输入

先前的工作 [4, 5, 11, 17] 已经证明幅度谱特征可以提供关于全频段全局频谱、子带局部频谱和信号平稳性的关键线索。 因此,我们使用带噪语音的全频带幅度谱特征:

$$公式2:\mathbf{X}(t)=[|X(t, 0)|, \cdots,|X(t, f)|, \cdots,|X(t, F-1)|]^{T} \in \mathbb{R}^{F}$$

我们将其序列化为:

$$公式3:\tilde{\mathbf{X}}=(\mathbf{X}(1), \cdots, \mathbf{X}(t), \cdots, \mathbf{X}(T))$$

作为全频带模型$G_{full}$的输入。 然后,$G_{full}$可以捕获全局上下文信息并输出一个大小与$\tilde{X}$相同的谱embedding,有望为后面的子带模型$G_{sub}$提供补充信息。

子带模型$G_{sub}$根据带噪语音中子带信号的语音平稳性和编码后的局部谱 和 全带模型的输出 预测频率方向的纯净语音目标。取时频点$|X(t, f)|$及其相邻的$2*N$个时频点作为子带单元。$N$是每测考虑的相邻频率数。对于边界频率,当$f-N<0$或$f+N>F-1$,使用圆形傅里叶频率。我们将子带单元和全带模型的输出连接起来,表示为$G_{full}(|X(t, f)|)$,作为子带模型$G_{sub}$的输入

$$公式4:\begin{aligned}

\mathrm{x}(t, f)=&[|X(t, f-N)|, \cdots,|X(t, f-1)|,|X(t, f)|\\

&|X(t, f+1)|, \cdots,|X(t, f+N)| \\

&\left.G_{\text {full }}(|X(t, f)|)\right]^{T} \in \mathbb{R}^{2 N+2}

\end{aligned}$$

对于频率$f$, $G_{sub}$的输入序列为

$$公式5:\widetilde{\mathrm{x}}(f)=(\mathrm{x}(1, f), \cdots, \mathrm{x}(t, f), \cdots, \mathrm{x}(T, f))$$

在该序列中,信号随时间轴的时间变换反映了信号的平稳性,这是一个区分语音和相关的平稳噪声的有效线索。噪声子带谱(由2N + 1频率组成)及其时间动态提供了局部频谱模式,可通过专门的子带模型学习得到。虽然信号平稳性线索和局部模式实际上也存在于全频带模型$G_{full}$的输入中,但是,它们没有被全频带模型$G_{full}$专门的学习到。因此,子带模型$G_{sub}$仍然学习与全带模型$G_{full}$相关的一些额外且不同的信息。同时,全频带模型$G_{full}$的输出提供了子频带模型$G_{sub}$未看到的一些补充信息。

由于全频带频谱特征$X(f)$包含$F$个频率,我们最终为$G_{sub}$生成$F$个独立的输入序列,每个序列的维数为$2N+2$。

2.2 学习目标

毫无疑问,相位的精确估计可以提供更多的听觉感知质量改善,特别是在低信噪比(SNR)条件下。然而,相位被包裹在$-\pi~\pi$中,并且具有混乱的数据分布,这使得不容易估计。与之前的工作[11,17]一样,我们采用复数理想比率掩模(cIRM)作为模型的学习目标,而不是直接估计相位。按照[10],我们在训练中使用双曲正切来压缩cIRM,在推理中使用逆函数来解压缩掩码(K=10,C=0.1)。对于一个时频点,我们将cIRM表示为$y(t,f)\in R^2$。子带模型将频率$f$作为输入序列$\tilde{x}(f)$,然后预测cIRM序列

$$公式6:\widetilde{\mathbf{y}}(f)=(\mathbf{y}(1, f), \cdots, \mathbf{y}(t, f), \cdots, \mathbf{y}(T, f))$$

2.3 模型框架

图1显示了FullSubNet的架构。FullSuNet中的全频带和子频带模型具有相同的模型结构,包括两个堆叠的单向LSTM层和一个线性(完全连接)层。全频带模型的LSTM每层包含512个隐藏单元,并使用ReLU作为输出层的激活函数。全频带模型在每个时间步长输出一个$F$维向量,每个频率对应一个元素。然后将子带单元与该矢量频率逐次连接,形成F个独立的输入样本(如式4所示)。根据我们之前的实验,子带模型不需要像全带模型那样大,因此LSTM每层使用384个隐藏单元。根据[10]的设置,子带模型的输出层不使用激活函数。值得注意的是,所有的频率共享一个唯一的子频带网络(及其参数)。在训练过程中,考虑到LSTM记忆容量有限,采用等长序列生成输入-目标序列对。

为了使模型更易于优化,必须对输入序列进行规范化,以使输入振幅相等。对于全频带模型,我们根据经验计算全频带序列$\tilde{X}$上的幅度谱特征的平均值,并将输入序列归一化为$\frac{\bar{x}}{\mu_{full}}$。子带模型独立处理频率。对于频率$f$,我们计算输入序列$\tilde{x}(f)$上的平均值$\mu_{sub}(f)$,并将输入序列归一化为$\frac{\bar{x}(f)}{\mu_{sub}(f)}$。

在实时推理阶段,我们通常使用累积归一化方法[18,19],即每次使用所有可用帧计算用于归一化的平均值。然而,在实际的实时语音增强系统中,语音信号最初通常是无声的,这意味着语音信号的起始部分大部分是无效的。在这项工作中,为了更好地展示 FullSubNet 网的性能而不考虑规范化问题,我们直接使用在整个测试剪辑上计算的$\mu_{full}$和$\mu_{sub}(f)$来在推理过程中进行归一化。

与 [17] 中提到的方法相同,我们提出的方法支持输出延迟,这使模型能够在合理的小延迟内探索未来信息。 如图1所示,为了推断$y(t-\tau )$,未来的时间步长,也就是说$x(t-\tau+1),...,x(t)$作为在输入序列(就像图1所示)。

3 实验设置

3.1 数据集

我们在DNS Challenge (INTERSPEECH 2020)数据集上评估了FullSubNet[16]。clean speech set包括2150名说话人的500多小时片段。噪声数据集包含150个类别超过180个小时的片段。为了充分利用数据集,我们在模型训练过程中通过动态混合来模拟语音-噪声混合。具体地说,在每个训练阶段开始之前,75%的干净语音与

(1)多通道脉冲响应数据库[20]中随机选择的室内脉冲响应(RIR)混合,混响时间(T60)为0.16秒、0.36秒和0.61秒。

(2) 混响挑战数据集[21],具有三个混响时间0.3秒、0.6秒和0.7秒。

然后,通过将干净语音(其中75%为混响)和随机信噪比在-5到20 dB之间的噪声混合,动态生成语音-噪声混合。经过十个epoch训练后,该模型显示的总数据超过5000小时。DNS挑战提供了一个公开可用的测试数据集,包括两类合成剪辑,即无混响和有混响。每个类别有150个噪声片段,信噪比分布在0 ~ 20 dB之间。我们使用这个测试数据集进行评估。

3.2 实现

信号被转换到STFT域使用汉宁窗,窗长为512(32 ms)和256帧移。我们使用PyTorch来实现FullSubNet。Adam优化器的使用学习率为0.001。训练序列长度设置为T = 192帧(约3秒)。根据DNS Challenge (INTERSPEECH 2020)的实时性要求,我们设置$\tau$ = 2,利用两个未来帧来增强当前帧,并使用16*2 = 32ms的前瞻性。如[17],我们在FullSubNet中为子带模型的输入频率的每一侧设置了15个相邻频率。

3.3 基线

为了验证全频带和子频带融合方法的有效性,我们使用与FullSubNet相同的实验设置和学习目标(cIRM)与以下两种模型进行了比较。

- 子带模型[17]:子带模型在DNS-Challenge中取得了非常有竞争力的性能(实时跟踪的第四名)。为了公平地比较性能,就像训练FullSubNet一样,我们在训练期间使用动态混合。

- 全频带模型:我们构建一个纯全频带模型,它包含三个LSTM层,每层有512个隐藏单元。全频带模型的架构,即LSTM层的堆栈,实际上被广泛应用于语音增强,如[6,26]。该模型比所提出的融合模型略大,因此比较是足够公平的。

除了这两种模型,我们还比较了在DNS挑战(INTERSPEECH 2020)中排名第一的方法,包括NSNet[22]、DTLN[23]、convc - tasnet[24]、DCCRN[19]和PoCoNet[25]。

4 结果

4.1 与基线比较

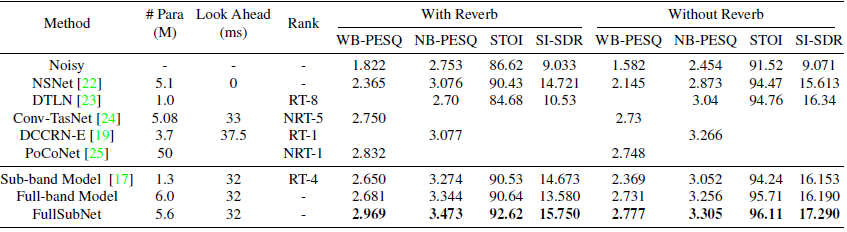

在表 1 的最后三行,我们比较了子带模型、全带模型和 FullSubNet 的性能。 #表中的Para和Look Ahead分别代表模型的参数量和使用的未来信息的长度。 With Reverb 是指测试数据集中的带噪语音不仅有噪声,而且有一定程度的混响,这大大增加了语音增强的难度。没有混响意味着测试数据集中的带噪语音只有噪音。为了公平比较,这三个模型使用相同的训练目标 (cIRM)、实验设置和使用的未来信息的长度。

从表中我们可以发现,大部分全频段模型的评估分数都优于子频段模型,因为全频段模型使用更大的网络来利用宽带信息。有趣的是,相对于全频段模型,子频段模型对于 With Reverb 数据似乎更有效,因为全频段模型对于 With Reverb 的优势小于无 Reverb 的优势。这表明子带模型通过关注窄带频谱的时间演化,有效地模拟了混响效应。这可能是由于混响效应的跨频带相关性实际上远低于信号频谱的跨频带相关性。

关于FullSubNet:(1)虽然子带模型的性能已经非常有竞争力,但是在集成了全带模型(由两个LSTM层和一个线性层堆叠而成)之后,模型性能得到了极大的提升。这种改进表明全局频谱模式和长距离跨带依赖性对于语音增强至关重要。 (2)FullSubNet的性能也明显超过了全频段模型。我们必须首先指出,这种改进并非来自使用更多参数。事实上,FullSubNet(两层全带LSTM加两层子带LSTM)的参数甚至比全带模型(三层全带LSTM)还要少。 FullSubNet 在集成子带模型后,继承了子带模型的独特能力,即利用信号平稳性和局部频谱模式,以及对混响效果进行建模的能力。 FullSubNet 相对于全波段模型的明显优势表明,子波段模型所利用的信息确实没有被全波段模型学习到,这是对全波段模型的补充。总的来说,这些结果证明所提出的融合模型成功地整合了全频带和子频带技术的优点。

4.2 与最先进的方法进行比较

在表1中,除了说明FullSubNet可以有效地整合两种互补的模型外,我们还将其与DNS Challenge (INTERSPEECH 2020)中排名第一的方法进行了性能比较。表格中的“Rank”列表示是否支持实时处理和挑战排名。例如,RT-8表示实时(RT)轨道的第8位。NRT-1是指非实时(NRT)轨道的第一个位置。

在表1中,NSNet是DNS挑战的官方基线方法,它使用一个紧凑的RNN以单帧输入、单帧输出的方式增强噪声短时间语音频谱。我们使用asteroid工具包中提供的DNS挑战配方来实现和训练NSNet。使用[17]中提到的方法生成训练数据。在表中,无论哪种指标,我们提出的方法在所有指标上都大大超过了NSNet。

在DNS挑战的主观听力测试中,DTLN、convtasnet、DCCRN、PoCoNet排名第一。为了保证比较的公平性,我们直接引用他们的原始论文成绩。表格中空白的位置表示在原论文中没有报告相应的分数。DTLN[23]具有实时处理能力。它将STFT操作和学习的分析和合成基础结合成一个不到100万个参数的堆叠网络。[24]提出了一个低延迟的Conv-TasNet。 Conv-TasNet [18]是一种应用广泛的时域音频分离网络,具有较大的计算复杂度。因此,低延迟的Conv-TasNet 无法满足实时性要求。DCCRN[19]模拟了卷积递归网络内部的复数运算。它赢得了实时赛道的第一名。PoCoNet[25]是一种采用频率-位置嵌入的卷积神经网络。此外,采用半监督方法对带噪数据集进行预增强,以增加会话训练数据。它赢得了非实时赛道的第一名。这些方法涵盖了大量基于深度学习的高级语音增强技术,在一定程度上代表了当前的先进水平。这些方法的原始论文提供了在本工作中使用的同一测试集上的评价结果,但并没有提供本工作中使用的所有指标。可以看出,在这个有限的数据集上,所提出的融合模型取得了比所有这些模型都要好得多的客观得分。PoCoNet的性能与我们的很接近,但它是非实时模型,具有更大的网络(约50m参数)。FullSubNet提供了一种新的全频带/子频带融合模型,这可能不会与这些最先进的模型中所采用的先进技术相冲突。因此,值得期待的是,适当地结合它们,可以进一步提高语音增强能力。

在计算复杂度方面,在基于Intel Xeon E5-2680 v4的虚拟四核CPU (2.4 GHz)上测试,提出的模型(PyTorch实现)的1帧STFT (32 ms)处理时间为10.32 ms,明显满足实时性要求。稍后,我们将开放源代码和预训练模型,并在https: //github.com/haoxiangsnr/FullSubNet上显示一些增强的音频剪辑。

表1。DNS挑战测试数据集上的WB-PESQ [MOS]、NB-PESQ [MOS]、STOI[%]和SI-SDR [dB]的性能

5 总结

在本文中,我们提出了一个全频带和子频带融合模型,称为FullSubNet,用于实时单通道语音增强。该模型融合了全频带模型和子频带模型的优点,既能捕获全局(全频带)光谱信息,又能捕获长距离跨频带依赖关系,同时保留了信号平稳性建模和局部光谱模式识别的能力。在DNS挑战(INTERSPEECH 2020)测试数据集上,我们证明了子频带信息和全频带信息是互补的,FullSubNet可以有效地集成它们。在DNS挑战中,我们还与一些排名前列的方法进行了性能比较,结果表明FullSubNet优于这些方法。

6 参考文献

[1] Dario Rethage, Jordi Pons, and Xavier Serra, A wavenet for speech denoising, in 2018 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2018, pp. 5069 5073.

[2] A. Pandey and D. Wang, Tcnn: Temporal convolutional neural network for real-time speech enhancement in the time domain, in ICASSP 2019 - 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2019, pp. 6875 6879.

[3] Xiang Hao, Xiangdong Su, Zhiyu Wang, Hui Zhang, and Batushiren, UNetGAN: A Robust Speech Enhancement Approach in Time Domain for Extremely Low Signal-to-Noise Ratio Condition, in Proc. Interspeech 2019, 2019, pp. 1786 1790.

[4] Y. Xu, J. Du, L. Dai, and C. Lee, A regression approach to speech enhancement based on deep neural networks, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 23, no. 1, pp. 7 19, 2015.

[5] D. Wang and J. Chen, Supervised speech separation based on deep learning: An overview, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 26, no. 10, pp. 1702 1726, 2018.

[6] Jitong Chen and DeLiangWang, Long short-term memory for speaker generalization in supervised speech separation, The Journal of the Acoustical Society of America, vol. 141, no. 6, pp. 4705 4714, 2017.

[7] H. Erdogan, J. R. Hershey, S. Watanabe, and J. Le Roux, Phase-sensitive and recognition-boosted speech separation using deep recurrent neural networks, in 2015 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pp. 708 712.

[8] DeLiang Wang, On Ideal Binary Mask As the Computational Goal of Auditory Scene Analysis, in Speech Separation by Humans and Machines, Pierre Divenyi, Ed., pp. 181 197.Kluwer Academic Publishers, Boston, 2005.

[9] Lei Sun, Jun Du, Li-Rong Dai, and Chin-Hui Lee, Multipletarget deep learning for lstm-rnn based speech enhancement, in 2017 Hands-free Speech Communications and Microphone Arrays (HSCMA). IEEE, 2017, pp. 136 140.

[10] D. S. Williamson, Y. Wang, and D. Wang, Complex ratio masking for monaural speech separation, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 24, no. 3, pp. 483 492, 2016.

[11] Xiaofei Li and Radu Horaud, Narrow-band Deep Filtering for Multichannel Speech Enhancement, arXiv preprint arXiv:1911.10791, 2019.

[12] Timo Gerkmann and Richard C Hendriks, Unbiased mmsebased noise power estimation with low complexity and low tracking delay, IEEE Transactions on Audio, Speech, and Language Processing, vol. 20, no. 4, pp. 1383 1393, 2011.

[13] Xiaofei Li, Laurent Girin, Sharon Gannot, and Radu Horaud, Non-stationary noise power spectral density estimation based on regional statistics, in 2016 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2016, pp. 181 185.

[14] Yariv Ephraim and David Malah, Speech enhancement using a minimum-mean square error short-time spectral amplitude estimator, IEEE Transactions on acoustics, speech, and signal processing, vol. 32, no. 6, pp. 1109 1121, 1984.

[15] Israel Cohen and Baruch Berdugo, Speech enhancement for non-stationary noise environments, Signal processing, vol. 81, no. 11, pp. 2403 2418, 2001.

[16] Chandan KA Reddy, Ebrahim Beyrami, Harishchandra Dubey, Vishak Gopal, Roger Cheng, Ross Cutler, Sergiy Matusevych, Robert Aichner, Ashkan Aazami, Sebastian Braun, et al., The interspeech 2020 deep noise suppression challenge: Datasets, subjective speech quality and testing framework, arXiv preprint arXiv:2001.08662, 2020.

[17] Xiaofei Li and Radu Horaud, Online monaural speech enhancement using delayed subband lstm, arXiv preprint arXiv:2005.05037, 2020.

[18] Y. Luo and N. Mesgarani, Conv-tasnet: Surpassing ideal time frequency magnitude masking for speech separation, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 27, no. 8, pp. 1256 1266, 2019.

[19] Yanxin Hu, Yun Liu, Shubo Lv, Mengtao Xing, Shimin Zhang, Yihui Fu, Jian Wu, Bihong Zhang, and Lei Xie, Dccrn: Deep complex convolution recurrent network for phase-aware speech enhancement, arXiv preprint arXiv:2008.00264, 2020.

[20] Elior Hadad, Florian Heese, Peter Vary, and Sharon Gannot, Multichannel audio database in various acoustic environments, in 2014 14th International Workshop on Acoustic Signal Enhancement (IWAENC). IEEE, 2014, pp. 313 317.

[21] Keisuke Kinoshita, Marc Delcroix, Sharon Gannot, Emanu el AP Habets, Reinhold Haeb-Umbach, Walter Kellermann, Volker Leutnant, Roland Maas, Tomohiro Nakatani, Bhiksha Raj, et al., A summary of the reverb challenge: state-of-the-art and remaining challenges in reverberant speech processing research, EURASIP Journal on Advances in Signal Processing, vol. 2016, no. 1, pp. 7, 2016.

[22] Y. Xia, S. Braun, C. K. A. Reddy, H. Dubey, R. Cutler, and I. Tashev, Weighted speech distortion losses for neuralnetwork- based real-time speech enhancement, in ICASSP 2020 - 2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2020, pp. 871 875.

[23] Nils L Westhausen and Bernd T Meyer, Dual-signal transformation lstm network for real-time noise suppression, arXiv preprint arXiv:2005.07551, 2020.

[24] Yuichiro Koyama, Tyler Vuong, Stefan Uhlich, and Bhiksha Raj, Exploring the Best Loss Function for DNN-Based Lowlatency Speech Enhancement with Temporal Convolutional Networks, arXiv:2005.11611 [cs, eess], Aug. 2020, arXiv: 2005.11611.

[25] Umut Isik, Ritwik Giri, Neerad Phansalkar, Jean-Marc Valin, Karim Helwani, and Arvindh Krishnaswamy, Poconet: Better speech enhancement with frequency-positional embeddings, semi-supervised conversational data, and biased loss, arXiv preprint arXiv:2008.04470, 2020.

[26] Felix Weninger, Hakan Erdogan, Shinji Watanabe, Emmanuel Vincent, Jonathan Le Roux, John R Hershey, and Bj orn Schuller, Speech enhancement with lstm recurrent neural networks and its application to noise-robust asr, in International Conference on Latent Variable Analysis and Signal Separation. Springer, 2015, pp. 91 99.

论文翻译:Fullsubnet: A Full-Band And Sub-Band Fusion Model For Real-Time Single-Channel Speech Enhancement的更多相关文章

- 论文翻译:2021_Towards model compression for deep learning based speech enhancement

论文地址:面向基于深度学习的语音增强模型压缩 论文代码:没开源,鼓励大家去向作者要呀,作者是中国人,在语音增强领域 深耕多年 引用格式:Tan K, Wang D L. Towards model c ...

- 论文翻译:2020_WaveCRN: An efficient convolutional recurrent neural network for end-to-end speech enhancement

论文地址:用于端到端语音增强的卷积递归神经网络 论文代码:https://github.com/aleXiehta/WaveCRN 引用格式:Hsieh T A, Wang H M, Lu X, et ...

- 论文翻译:2022_PACDNN: A phase-aware composite deep neural network for speech enhancement

论文地址:PACDNN:一种用于语音增强的相位感知复合深度神经网络 引用格式:Hasannezhad M,Yu H,Zhu W P,et al. PACDNN: A phase-aware compo ...

- 论文翻译:Conv-TasNet: Surpassing Ideal Time–Frequency Magnitude Masking for Speech Separation

我醉了呀,当我花一天翻译完后,发现已经网上已经有现成的了,而且翻译的比我好,哎,造孽呀,但是他写的是论文笔记,而我是纯翻译,能给读者更多的思想和理解空间,并且还有参考文献,也不错哈,反正翻译是写给自己 ...

- 论文翻译:2021_Performance optimizations on deep noise suppression models

论文地址:深度噪声抑制模型的性能优化 引用格式:Chee J, Braun S, Gopal V, et al. Performance optimizations on deep noise sup ...

- [原创]Faster R-CNN论文翻译

Faster R-CNN论文翻译 Faster R-CNN是互怼完了的好基友一起合作出来的巅峰之作,本文翻译的比例比较小,主要因为本paper是前述paper的一个简单改进,方法清晰,想法自然.什 ...

- R-CNN论文翻译

R-CNN论文翻译 Rich feature hierarchies for accurate object detection and semantic segmentation 用于精确物体定位和 ...

- SSD: Single Shot MultiBoxDetector英文论文翻译

SSD英文论文翻译 SSD: Single Shot MultiBoxDetector 2017.12.08 摘要:我们提出了一种使用单个深层神经网络检测图像中对象的方法.我们的方法,名为SSD ...

- R-FCN论文翻译

R-FCN论文翻译 R-FCN: Object Detection viaRegion-based Fully Convolutional Networks 2018.2.6 论文地址:R-FCN ...

随机推荐

- java 小算法

//鸡兔同笼 20个头 58腿 for(int a=0;a<=20;a++) { int b = 20-a; if((2*b+4*a)==58) { System.out.println(a+& ...

- [转]js之this,call,apply用法

(一)关于this 首先关于this我想说一句话,这句话记住了this的用法你也就差不多都能明白了:this指的是当前函数的对象.这句话可能比较绕,我会举出很多例子和这句话呼应的!(看下文)1.首先看 ...

- Selenium+Tesseract-OCR智能识别验证码爬取网页数据

1.项目需求描述 通过订单号获取某系统内订单的详细数据,不需要账号密码的登录验证,但有图片验证码的动态识别,将获取到的数据存到数据库. 2.整体思路 1.通过Selenium技术,无窗口模式打开浏览器 ...

- YbtOJ#943-平方约数【莫比乌斯反演,平衡规划】

正题 题目链接:http://www.ybtoj.com.cn/contest/122/problem/3 题目大意 \(S(i)\)表示\(i\)的约数个数,\(Q\)次询问给出\(n,m\)求 \ ...

- YbtOJ#723-欧拉之树【莫比乌斯反演,虚树】

正题 题目链接:http://www.ybtoj.com.cn/contest/121/problem/2 题目大意 给出\(n\)个点的一棵树,每个点有一个权值\(a_i\),求 \[\sum_{i ...

- P4345-[SHOI2015]超能粒子炮·改【Lucas定理,类欧】

正题 题目链接:https://www.luogu.com.cn/problem/P4345 题目大意 \(T\)组询问,给出\(n,k\)求 \[\sum_{i=0}^{k}\binom{n}{i} ...

- vue 移动端项目切换页面,页面置顶

之前项目是pc端是使用router的方式实现置顶的 //main.js router.afterEach((to, from, next) => { window.scrollTo(0, 0) ...

- 安全通信协议SSH应用与分析

一.实验简介: 本次实验属于安全协议应用与分析系列 二 实验环境: Windows server 2003 server windows xp 做client 三.实验目的 通过该实验了解SSH服务器 ...

- S_型文法到q_型文法再到LL(1)型文法演进笔记

title: S_型文法到q_型文法再到LL(1)型文法演进笔记 date: 2020-08-23 S_型文法到q_型文法再到LL(1)型文法演进笔记 S_型文法(简单的确定性文法) 每个产生式的右部 ...

- SQL实例_11Oracle基本操作

前言导读 本章介绍了在正常使用Oracle数据库之前进行的常规操作 本章语句的运行需要子啊PLSQL软件中运行 本章导入导出语句需要在虚拟环境中直接运行 1 Oracle创建表空间和用户 --1 创建 ...