使用pandas中的raad_html函数爬取TOP500超级计算机表格数据并保存到csv文件和mysql数据库中

参考链接:https://www.makcyun.top/web_scraping_withpython2.html

#!/usr/bin/env python

# -*- coding: utf-8 -*- from multiprocessing.pool import Pool import pandas as pd

import requests

from sqlalchemy import create_engine # 数据库相关信息

HOSTNAME = '127.0.0.1'

PORT = ''

DATABASE = 'top500'

USERNAME = 'root'

PASSWORD = 'root' SQLALCHEMY_DATABASE_URI = "mysql+mysqlconnector://{username}:{password}@{host}:{port}/{db}?charset=utf8mb4".format(

username=USERNAME,

password=PASSWORD,

host=HOSTNAME,

port=PORT,

db=DATABASE) SQLALCHEMY_TRACK_MODIFICATIONS = False

SQLALCHEMT_ENCODING = 'utf8mb4' engine = create_engine(SQLALCHEMY_DATABASE_URI, echo=True) # 获取网页收据

def get_one_page(url):

response = requests.get(url)

if response.status_code == 200:

return response.text

else:

return None # 保存到csv文件

def save_csv(html):

dataframe = pd.read_html(html)

tb = dataframe[0].drop([0]) # 获取网页数据中的第一个表格数据,然后再去掉第一个表格数据中的的第一行(去掉的话csv文件中没有列名,不去掉的话多次写入列名)

# tb.columns = ['rank', 'site', 'system', 'cores', 'rmax', 'rpeak', 'power'] # 重命名列名

tb.to_csv(r'top500.csv', mode='a', encoding='utf_8_sig', index=True, header=False) # def save_mysql(html):

dataframe = pd.read_html(html)

tb = dataframe[0].drop([0])

tb.columns = ['rank', 'site', 'system', 'cores', 'rmax', 'rpeak', 'power']

try:

tb.to_sql('top500', con=engine, if_exists='append', index=False) # 需要事先建好top500数据表,并注意字段名称跟数据列名一一对应,字段值的长度要足够

print('success')

except:

print('fail') def main(offset):

url = 'https://www.top500.org/list/2018/11/?page=' + str(offset)

html = get_one_page(url)

# save_csv(html)

save_mysql(html) if __name__ == '__main__':

pool = Pool()

pool.map(main, [i for i in range(1, 6)])

csv文件效果:

csv文件待优化的地方:加上列名

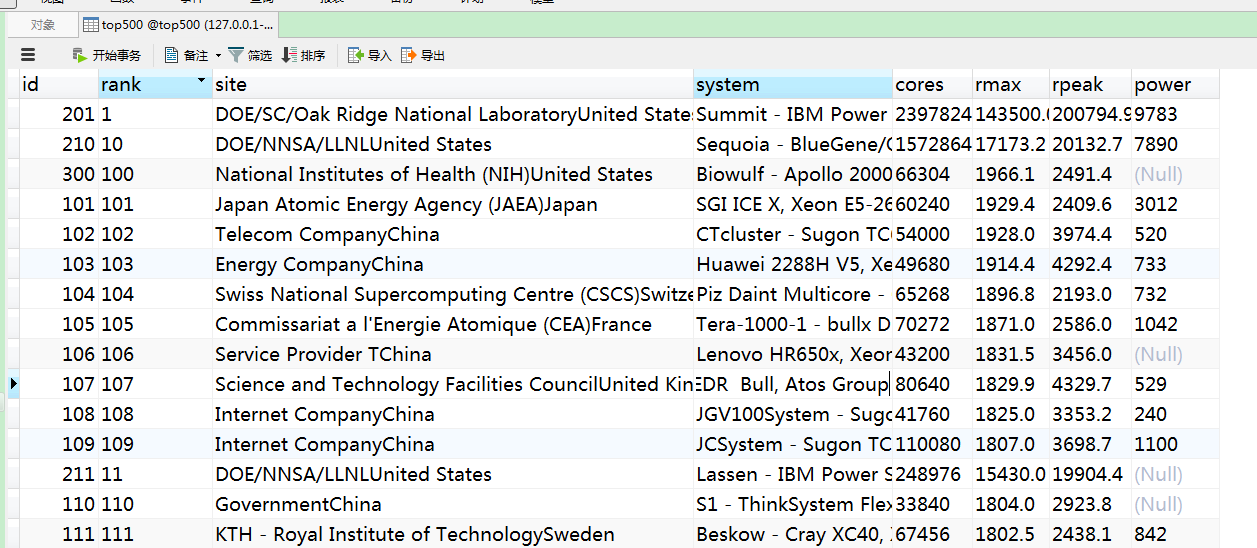

mysql效果:

问题:

1.不论是csv文件还是mysql表格数据,根据rank字段进行排序,竟然排序的不怎么准确

2.site字段的最后部分数据是国家,这个需要想办法给剥离出来,再弄一列数据展示

使用pandas中的raad_html函数爬取TOP500超级计算机表格数据并保存到csv文件和mysql数据库中的更多相关文章

- JAVA读取CSV文件到MySQL数据库中

maven项目pom配置: <dependency> <groupId>net.sourceforge.javacsv</groupId> <artifact ...

- 记录python爬取猫眼票房排行榜(带stonefont字体网页),保存到text文件,csv文件和MongoDB数据库中

猫眼票房排行榜页面显示如下: 注意右边的票房数据显示,爬下来的数据是这样显示的: 网页源代码中是这样显示的: 这是因为网页中使用了某种字体的缘故,分析源代码可知: 亲测可行: 代码中获取的是国内票房榜 ...

- 使用scrapy爬取的数据保存到CSV文件中,不使用命令

pipelines.py文件中 import codecs import csv # 保存到CSV文件中 class CsvPipeline(object): def __init__(self): ...

- python爬取当当网的书籍信息并保存到csv文件

python爬取当当网的书籍信息并保存到csv文件 依赖的库: requests #用来获取页面内容 BeautifulSoup #opython3不能安装BeautifulSoup,但可以安装Bea ...

- 爬取某网站景区列表并保存为csv文件

网址:http://www.halehuo.com/jingqu.html 经过查看可以发现,该景区页面没有分页,不停的往下拉,页面会进行刷新显示后面的景区信息 通过使用浏览器调试器,发现该网站使用的 ...

- 爬取拉勾网python工程师的岗位信息并生成csv文件

转载自:https://www.cnblogs.com/sui776265233/p/11146969.html 代码写得很好,但是目前只看得懂前一部分 一.爬取和分析相关依赖包 Python版本: ...

- 简单又强大的pandas爬虫 利用pandas库的read_html()方法爬取网页表格型数据

文章目录 一.简介 二.原理 三.爬取实战 实例1 实例2 一.简介 一般的爬虫套路无非是发送请求.获取响应.解析网页.提取数据.保存数据等步骤.构造请求主要用到requests库,定位提取数据用的比 ...

- 使用requests、BeautifulSoup、线程池爬取艺龙酒店信息并保存到Excel中

import requests import time, random, csv from fake_useragent import UserAgent from bs4 import Beauti ...

- 使用requests、re、BeautifulSoup、线程池爬取携程酒店信息并保存到Excel中

import requests import json import re import csv import threadpool import time, random from bs4 impo ...

随机推荐

- 2.3-STP生成树

2.3-STP生成树 单点失效(signle point of failure)及其解决方法: 当两个Segement之间只有一条物理连接时就有可能出现单点失效→ 单方面的故障导致全网 ...

- CentOS下安装使用phpMyAdmin. Set up phpMyAdmin on CentOS

须要组件: Apache PHP Mysql phpMyAdmin Apache 0. yum install httpd 1. 确认版本号 $ httpd -v 2. 启动apache $ sudo ...

- poj 1256 Anagram—next_permutation的神奇应用

题意:给你一条字符串,让你输出字符串中字符的全排列,输出的顺序要按它给的奇葩的字典序. 题解:要输出全排列,暴力dfs可以过,但要注意题目的字典序以及相同字符的情况.如果用next_permutati ...

- Codeforces Round #330 (Div. 2)B. Pasha and Phone 容斥

B. Pasha and Phone Pasha has recently bought a new phone jPager and started adding his friends' ph ...

- 2498 IncDec Sequence

2498 IncDec Sequence 时间限制: 1 s 空间限制: 64000 KB 题目等级 : 钻石 Diamond 题解 查看运行结果 题目描述 Description 给 ...

- oc28--Property增强

// // Person.h #import <Foundation/Foundation.h> @interface Person : NSObject /* { @public int ...

- 窗口函数 SELECT - OVER Clause (Transact-SQL)

https://docs.microsoft.com/en-us/sql/t-sql/queries/select-over-clause-transact-sql Determines the pa ...

- B1295 [SCOI2009]最长距离 最短路

就是一道最短路的裸题,直接跑spfa就行了.(spfa死了) 最后在答案处判断是否障碍物太多,然后就直接找最大值就行. (数据特别水,我错误算法60) 题干: Description windy有一块 ...

- 前缀和&&离散化

现在正在上课,但我还是要同步更新博文...\滑稽 先讲一个离散化,就是把几个离的特别远的数在不影响结果的情况下,变成相近的数.倒是没什么影响,但应用在数组下标的话可以节约空间.(貌似和hash有点像) ...

- 一、SQL系列之~使用SQL语言导出数据及实现定时导出数据任务

一般情况下,SQL数据库中带有导入与导出数据的直接按键操作,点击数据表所在的数据库--任务--导出/导入数据,根据导入/导出向导直接将数据导出即可. 但导出的数据格式多为Excel格式,如果需要导出的 ...