hdfs里的文件下载HDFS之fsimage、metadata、edits、fstime(二十七)

首先,要有这个观念,元数据信息(fsimage + editslog)。

fsimage是在磁盘

metadata是在内存

********************fsimage把内存的,序列化到磁盘了。********************

元数据信息(fsimage + editslog),内存保存一份,磁盘保存一份,,,,,其他有个什么地方也要保存一份。

==============》 就如,学校图书馆里。书库,为了使得借书运转,要买多本书存库。《======================

fsimage:元数据镜像文件,存储某一时段NameNode内存元数据信息。

在hadoop1.*里,就是fsimage。

在hadoop2.*里,还加了后缀。

听说过镜像。 关闭时,将机器内存的信息写到磁盘,启动时,将磁盘的东西读取到内存。

edits:操作日志文件

比如说,上传一个文件或删除一个文件,这些操作。

fstime:保存最近一次checkpoint的时间

比如说,在6月1号买的新电脑,在6月5日,做的第一次还原点,在6月18号,由于中病毒。在6月21号是做的第二次还原点。Checkpoint是保存最近的那次做还原点的数据。6月18-21日。

namenode始终在内存中保存metadata,用于处理“读请求”。到有“读请求”时,namenode会首先写editlog到磁盘,即向edits(操作日志文件)中写入日志,成功返回后,才会修改内存,并且向客户端返回。

形象化例子:我client提货员,向仓库管理员namenode,请求提货,在他同意同时,会将这情况写到editlog,先是将editlog写到磁盘,成功后,再写到内存。

fsimage载入内存 合并edits

|

|

|

新的 fsimage

|

|

|

namenode,替换旧的

条件一:

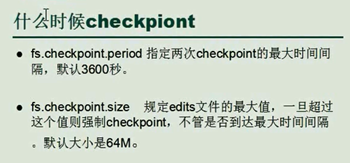

fs.checkpoint.period

默认是3600秒,每隔一个小时,Secondarynamenode就要下载fsimage和edits,进行数据的同步。

条件二:

fs.checkpoint.size

edits一直在变大。一旦达到,就要进行合并。

只要达到这两个条件的其中一个,都会进行合并。

hdfs里的文件下载HDFS之fsimage、metadata、edits、fstime(二十七)的更多相关文章

- Hadoop HDFS概念学习系列之hdfs里的文件下载闲谈(二十六)

hdfs里的文件下载 可以,通过hadoop distributed system来下载,而且速度非常之快.涨知识!!! 或者,通过命令行的方式,也可以! ********************** ...

- 访问hdfs里的文件

准备工作: 给hdfs里上传一份用于测试的文件 [root@master ~]# cat hello.txt hello 1 hello 2 hello 3 hello 4 [root@master ...

- (MySQL里的数据)通过Sqoop Import HDFS 里 和 通过Sqoop Export HDFS 里的数据到(MySQL)(五)

下面我们结合 HDFS,介绍 Sqoop 从关系型数据库的导入和导出 一.MySQL里的数据通过Sqoop import HDFS 它的功能是将数据从关系型数据库导入 HDFS 中,其流程图如下所示. ...

- hdfs深入:05、hdfs中的fsimage和edits的合并过程

6.4.secondarynameNode如何辅助管理FSImage与Edits文件 ①:secnonaryNN通知NameNode切换editlog ②:secondaryNN从NameNode中获 ...

- (第3篇)HDFS是什么?HDFS适合做什么?我们应该怎样操作HDFS系统?

摘要: 这篇文章会详细介绍HDFS是什么,HDFS的作用,适合和不适合的场景,我们该如何操作HDFS? HDFS文件系统 Hadoop 附带了一个名为 HDFS(Hadoop分布式文件系统)的分布 ...

- HDFS Federation(转HDFS Federation(HDFS 联盟)介绍 CSDN)

转载地址:http://blog.csdn.net/strongerbit/article/details/7013221 HDFS Federation(HDFS 联盟)介绍 1. 当前HDFS架构 ...

- Hadoop之HDFS(一)HDFS入门及基本Shell命令操作

1 . HDFS 基本概念 1.1 HDFS 介绍 HDFS 是 Hadoop Distribute File System 的简称,意为:Hadoop 分布式文件系统.是 Hadoop 核心组件之 ...

- hdfs的文件个数 HDFS Quotas Guide

HDFS Quotas Guide Overview HDFS允许管理员为多个每个目录设置使用的命名空间和空间的配额.命名空间配额和空间配额独立操作,但是这两种类型的配额的管理和实现非常类似. Nam ...

- vivo 万台规模 HDFS 集群升级 HDFS 3.x 实践

vivo 互联网大数据团队-Lv Jia Hadoop 3.x的第一个稳定版本在2017年底就已经发布了,有很多重大的改进. 在HDFS方面,支持了Erasure Coding.More than 2 ...

随机推荐

- Maven的Dependency怎么找?

用了Maven,所需的JAR包就不能再像往常一样,自己找到并下载下来,用IDE导进去就完事了,Maven用了一个项目依赖(Dependency)的概念,用俗话说,就是我的项目需要用你这个jar包,就称 ...

- WebViewJavascriptBridge的基本原理

前言 WebViewJavascriptBridge是支持到iOS6之前的版本的,用于支持native的iOS与javascript交互.如果需要支持到iOS6之前的app,使用它是很不错的.本篇讲讲 ...

- Android:使用ViewPager实现左右滑动切换图片(图上有点点)

在以下实例的基础上加上点点 Android:使用ViewPager实现左右滑动切换图片 (简单版) 效果预览: 因为要把点点放图片上,所以修改布局为相对布局: <?xml version=&qu ...

- SVN中update to revision与revert to revision的区别

假设我们有许多个版本,版本号分别是1-10 如果我们在7这里选择revert to this version那么7之后的8,9,10的操作都会被消除 如果在7选择revert changes from ...

- 细说javascript 中的 window.open() 参数设置

今天遇到一个问题,就是要用javascript中的window.open()打开一个新的网页,而且新打开的网页要在原来网页的基础之上,在查了一些资料之后,找到里一下方法:(其中,url 为链接的地址) ...

- Android开发UI之ListView中的Button点击设置

在ListView的Item中,如果有Button控件,那么要实现Button和Item点击都有响应,可以将Item的Layout中Button的focusable属性设为false,然后设置layo ...

- 读取Excel任务列表并显示在Outlook日历上

前几天,公司发了一个任务安排,时间不固定,但要求准时到,为了给自己加一个提醒,也为了回顾一下以前的技术,特做了一个Demo. 读取Excel就不多说了,代码很简单,但支持老版本Excel和的版本Exc ...

- [swustoj 183] 种树

种树(0183) 问题描述 Aconly有一块矩形的地,因为这块地里有很多石头,耕作很不方便,所以他打算在这块地上种一些果树.这块地用一个只含‘#’和‘*’的N*M的矩阵来表示,‘#’表示泥土,‘*’ ...

- jQuery.Validate验证库

一.用前必备官方网站:http://bassistance.de/jquery-plugins/jquery-plugin-validation/ API: http://jquery.bassist ...

- Entity Framework4.0 (七) EF4的存储过程

前面了解了EF4的CRUD的操作,你会发现EF4使用起来比较简单的.呵呵,之前我们使用数据库的时候,有时会使用存储过程代替在代码中直接使用SQL语句. 使用存储过程的好处: 提高效率:因为存储过程是经 ...