爬虫请求库之selenium

一、介绍

- selenium最初是一个自动化测试工具,而爬虫中使用它主要是为了解决requests无法直接执行JavaScript代码的问题

- selenium本质是通过驱动浏览器,完全模拟浏览器的操作,比如跳转、输入、点击、下拉等,来拿到网页渲染之后的结果,可支持多种浏览器

- from selenium import webdriver

- browser=webdriver.Chrome() #谷歌浏览器

- browser=webdriver.Firefox() #火狐浏览器

- browser=webdriver.PhantomJS()

- browser=webdriver.Safari()

- browser=webdriver.Edge()

二、安装

1.有界面浏览器

- #安装selenium+chromedriver

- 1.pip install selenium

- 2.一定要记得下载chromdriver.exe放到python安装路径scripts目录中,或者放在项目的根目录下,下载的时候注意和浏览器对应的版本

2.无界面浏览器

原来是用PhantomJS,现在使用谷歌浏览器headless模式

三、基本使用

- from selenium import webdriver

- from selenium.webdriver import ActionChains

- from selenium.webdriver.common.by import By #按照什么方式查找,By.ID,By.CSS_SELECTOR

- from selenium.webdriver.common.keys import Keys #键盘按键操作

- from selenium.webdriver.support import expected_conditions as EC

- from selenium.webdriver.support.wait import WebDriverWait #等待页面加载某些元素

- browser=webdriver.Chrome() #初始化

- try:

- browser.get('https://www.baidu.com') #访问网址

- input_tag=browser.find_element_by_id('kw') #根据id查找

- input_tag.send_keys('美女') #python2中输入中文错误,字符串前加个u

- input_tag.send_keys(Keys.ENTER) #输入回车

- wait=WebDriverWait(browser,10) #显示等待,等待某个元素被加载

- wait.until(EC.presence_of_element_located((By.ID,'content_left'))) #等到id为content_left的元素加载完毕,最多等10秒

- print(browser.page_source)

- print(browser.current_url)

- print(browser.get_cookies()) #获取cookies

- finally:

- browser.close()

四、选择器使用

一 基本用法

- from selenium import webdriver

- from selenium.webdriver import ActionChains

- from selenium.webdriver.common.by import By #按照什么方式查找,By.ID,By.CSS_SELECTOR

- from selenium.webdriver.common.keys import Keys #键盘按键操作

- from selenium.webdriver.support import expected_conditions as EC

- from selenium.webdriver.support.wait import WebDriverWait #等待页面加载某些元素

- import time

- bro=webdriver.Chrome() #初始化

- bro.get('http://www.baidu.com')

- wait=WebDriverWait(bro,10) #隐示等待

- # 1、find_element_by_id 根据id找

- # 2、find_element_by_link_text 根据链接名字找到控件(a标签的文字)

- # 3、find_element_by_partial_link_text 根据链接名字找到控件(a标签的文字)模糊查询

- # 4、find_element_by_tag_name 根据标签名

- # 5、find_element_by_class_name 根据类名

- # 6、find_element_by_name 根据属性名

- # 7、find_element_by_css_selector 根据css选择器

- # 8、find_element_by_xpath 根据xpath选择

#模拟登录百度- dl_button=bro.find_element_by_link_text("登录") #定位到登录按钮

- dl_button.click()

- user_login=bro.find_element_by_id('TANGRAM__PSP_10__footerULoginBtn') #点击用户名登录

- user_login.click()

- time.sleep(1)

- input_name=bro.find_element_by_name('userName') #定位到用户名输入框,输入用户名

- input_name.send_keys("30323545@qq.com")

- input_password=bro.find_element_by_id("TANGRAM__PSP_10__password") #输入密码

- input_password.send_keys("xxxxxx")

- submit_button=bro.find_element_by_id('TANGRAM__PSP_10__submit') #点击登录

- submit_button.click()

- time.sleep(100)

- print(bro.get_cookies()) #获取cookies方法 get_cookies()

- bro.close() #最后记得关闭

注意:上诉都可以改成find_elements_by_xxx的形式,查到的是多个元素,结果为列表

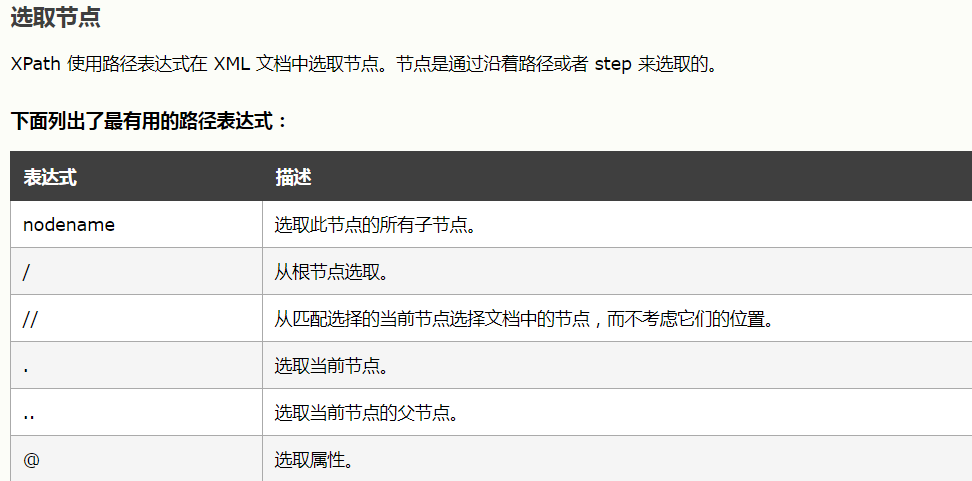

二、xpath

1.在selenium中使用xpath

- driver.find_element_by_xpath('//body/a') #开头的//代表从整篇文档中寻找,body之后的/代表body的儿子中找a标签,这一行找不到就会报错

- driver.find_element_by_xpath('//body//a') #开头的//代表从整篇文档中寻找,body之后的//代表body的子子孙孙中找a标签,这一行找不到就会报错

- driver.find_element_by_xpath('//a[5]') #找第五个a标签

- driver.find_element_by_xpath('//a[img/@src="data:image1"]') #找a标签下子标签img的src属性为image1

2.在lxml中使用xpath

- doc='''

- <html>

- <head>

- <base href='http://example.com/' />

- <title>Example website</title>

- </head>

- <body>

- <div id='images'>

- <a href='image1.html' a="xxx">Name: My image 1 <br /><img src='image1_thumb.jpg' /></a>

- <a href='image2.html'>Name: My image 2 <br /><img src='image2_thumb.jpg' /></a>

- <a href='image3.html'>Name: My image 3 <br /><img src='image3_thumb.jpg' /></a>

- <a href='image4.html' class='li'>Name: My image 4 <br /><img src='image4_thumb.jpg' /></a>

- <a href='image5.html' class='li li-item' name='items'>Name: My image 5 <br /><img src='image5_thumb.jpg' /></a>

- <a href='image6.html' name='items'><span><h5>test</h5></span>Name: My image 6 <br /><img src='image6_thumb.jpg' /></a>

- </div>

- </body>

- </html>

- '''

- from lxml import etree

- html=etree.HTML(doc)

- # html=etree.parse('search.html',etree.HTMLParser())

- # 1 所有节点

- a=html.xpath('//*') #匹配所有标签

- # 2 指定节点(结果为列表)

- # a=html.xpath('//head')

- # 3 子节点,子孙节点

- a=html.xpath('//div/a')

- a=html.xpath('//body/a') #无数据

- a=html.xpath('//body//a')

- # 4 父节点

- # a=html.xpath('//body//a[@href="image1.html"]/..')

- a=html.xpath('//body//a[1]/..') #从1开始

- # 也可以这样

- a=html.xpath('//body//a[1]/parent::*')

- # 5 属性匹配

- a=html.xpath('//body//a[@href="image1.html"]')

- # 6 文本获取

- a=html.xpath('//body//a[@href="image1.html"]/text()')

- a=html.xpath('//body//a/text()')

- # 7 属性获取

- # a=html.xpath('//body//a/@href')

- # # 注意从1 开始取(不是从0)

- a=html.xpath('//body//a[2]/@href')

- # 8 属性多值匹配

- # a 标签有多个class类,直接匹配就不可以了,需要用contains

- # a=html.xpath('//body//a[@class="li"]')

- a=html.xpath('//body//a[contains(@class,"li")]/text()')

- # a=html.xpath('//body//a[contains(@class,"li")]/text()')

- # 9 多属性匹配

- a=html.xpath('//body//a[contains(@class,"li") or @name="items"]')

- a=html.xpath('//body//a[contains(@class,"li") and @name="items"]/text()')

- a=html.xpath('//body//a[contains(@class,"li")]/text()')

- # 10 按序选择

- a=html.xpath('//a[2]/text()')

- a=html.xpath('//a[2]/@href')

- # 取最后一个

- a=html.xpath('//a[last()]/@href')

- # 位置小于3的

- a=html.xpath('//a[position()<3]/@href')

- # 倒数第二个

- a=html.xpath('//a[last()-2]/@href')

- # 11 节点轴选择

- # ancestor:祖先节点

- # 使用了* 获取所有祖先节点

- a=html.xpath('//a/ancestor::*')

- # # 获取祖先节点中的div

- a=html.xpath('//a/ancestor::div')

- # attribute:属性值

- a=html.xpath('//a[1]/attribute::*')

- # child:直接子节点

- a=html.xpath('//a[1]/child::*')

- # descendant:所有子孙节点

- a=html.xpath('//a[6]/descendant::*')

- # following:当前节点之后所有节点

- a=html.xpath('//a[1]/following::*')

- a=html.xpath('//a[1]/following::*[1]/@href')

- # following-sibling:当前节点之后同级节点

- a=html.xpath('//a[1]/following-sibling::*')

- a=html.xpath('//a[1]/following-sibling::a')

- a=html.xpath('//a[1]/following-sibling::*[2]/text()')

- a=html.xpath('//a[1]/following-sibling::*[2]/@href')

- print(a)

三、获取标签属性

- #获取标签属性值

- tag.get_attribute('src') #获取属性src的值

- #获取标签ID,位置,名称,大小

- tag.id

- tag.location

- tag.tag_name

- tag.size

五、等待元素被加载

- #1、selenium只是模拟浏览器的行为,而浏览器解析页面是需要时间的(执行css,js),一些元素可能需要过一段时间才能加载出来,为了保证能查找到元素,必须等待

- #2、等待的方式分两种:

- 隐式等待:在browser.get('xxx')前就设置,针对所有元素有效,写一个就行

browser.implicitly_wait(10) #在查找所有元素时,如果尚未被加载,则等10秒,如果没有10秒也会直接通过- 显式等待:在browser.get('xxx')之后设置,只针对某个元素有效,在每一个需要使用的标签都要写

六、元素交互操作

- 点击、清空

- click()

- clear()

七、其他

获取cookies

browser.get_cookies()

设置cookies

browser.add_cookie({'k1':'aaa','k2':'yyy'})

删除cookies

browser.delete_all_cookies()

注意:可以用selenium模拟登录获取到cookie,然后使用requests带上cookies参数请求网页获取数据(selenium结合requests使用)

爬虫请求库之selenium的更多相关文章

- 爬虫 - 请求库之selenium

介绍 官方文档 selenium最初是一个自动化测试工具,而爬虫中使用它主要是为了解决requests无法直接执行JavaScript代码的问题 selenium本质是通过驱动浏览器,完全模拟浏览器的 ...

- python爬虫请求库之selenium模块

一 介绍 selenium最初是一个自动化测试工具,而爬虫中使用它主要是为了解决requests无法直接执行JavaScript代码的问题 selenium本质是通过驱动浏览器,完全模拟浏览器 ...

- 爬虫——请求库之selenium模块

阅读目录 一 介绍 二 安装 三 基本使用 四 选择器 五 等待元素被加载 六 元素交互操作 七 其他 八 项目练习 一 介绍 selenium最初是一个自动化测试工具,而爬虫中使用它主要是为了解 ...

- 爬虫请求库之selenium模块

一 安装 #安装:selenium+chromedriver pip3 install selenium 下载chromdriver.exe放到python安装路径的scripts目录中即可,注意最新 ...

- 爬虫请求库——requests

请求库,即可以模仿浏览器对网站发起请求的模块(库). requests模块 使用requests可以模拟浏览器的请求,requests模块的本质是封装了urllib3模块的功能,比起之前用到的urll ...

- 爬虫----爬虫请求库selenium

一 介绍 selenium最初是一个自动化测试工具,而爬虫中使用它主要是为了解决requests无法直接执行JavaScript代码的问题 selenium本质是通过驱动浏览器,完全模拟浏览器的操作, ...

- 爬虫请求库——selenium

selenium模块 selenium最初是一个自动化测试工具,而爬虫中使用它主要是为了解决requests无法直接执行JavaScript代码的问题.selenium的缺点是效率会变得很慢. sel ...

- 爬虫请求库 requests

requests模块 阅读目录 一 介绍 二 基于GET请求 三 基于POST请求 四 响应Response 五 高级用法 一 介绍 #介绍:使用requests可以模拟浏览器的请求,比起之前用到 ...

- 爬虫基础库之Selenium

1.简介 selenium最初是一个自动化测试工具,而爬虫中使用它主要是为了解决requests无法直接执行JavaScript代码的问题 selenium本质是通过驱动浏览器,完全模拟浏览器的操作, ...

随机推荐

- let

let a=2+2 #+ - * / % ** 都支持 支持类C的计算方式 let i++ let i-- let i+=10 let i-=10 let i*=10 let i/=10 let i% ...

- 函数(定义、参数、return、变量、作用域、预解析)

一.函数定义 1.方式一 function 函数名(参数){ 函数体 }——————函数声明的方法 function fn(a){ console.log(a); }: 2.方式二 ...

- [RN] React Native 常见基本问题归纳总结

[RN] React Native 常见基本问题归纳总结 本问题总结涉及到版本为: "react": "16.8.3","react-native& ...

- Theano入门笔记2:scan函数等

1.Theano中的scan函数 目前先弱弱的认为:相当于symbolic的for循环吧,或者说计算图上的for循环,也可以用来替代repeat-until. 与scan相比,scan_checkpo ...

- CSS3 之loading动画实现思路

效果大致如下: 主要实现方式: 该效果主要用到animation-timing-function中的steps()函数,该函数主要用于分步隐藏不同模块. 实现思路: 第一步动画: 第二步动画: 第三步 ...

- jmeter5实现mysql数据库值提取--单sql提取

字段背景: 在进行接口测试或者压力测试过程中下文的请求需要用到上文请求的值,除了通过正则表达式的方式外,为了更准确的获得数据库值,我们可以直接从数据库提取 一.如何实现数据库的连接.此处不再赘述 点击 ...

- mysql 为啥用b+ 树

原因就是为了减少磁盘io次数,因为b+树所有最终的子节点都能在叶子节点里找见, 所以非叶子节点只需要存`索引范围和指向下一级索引(或者叶子节点)的地址` 就行了, 不需要存整行的数据,所以占用空间非常 ...

- [Beta]第八次 Scrum Meeting

[Beta]第八次 Scrum Meeting 写在前面 会议时间 会议时长 会议地点 2019/5/18 22:00 10min 大运村公寓6F寝室 附Github仓库:WEDO 例会照片 工作情况 ...

- 性能测试分析过程(三)linux下查看最消耗CPU/内存的进程

linux下查看最消耗CPU 内存的进程 1.CPU占用最多的前10个进程: ps auxw|head -1;ps auxw|sort -rn -k3|head -10 2.内存消耗最多的前10 ...

- Eclipse创建Maven父子项目

Eclipse创建Maven父子项目 - 木头若愚 - CSDN博客https://blog.csdn.net/jay_1989/article/details/53906995 创建maven项目是 ...