cloudera learning2:HDFS

存入HDFS的文件会按块(block)划分,默认每块128MB。默认1个block还有2个备份。备份增加了数据的可靠性和提高计算效率(数据本地化)。

HDFS部署可选择不支持HA,也可选择支持HA。

NameNode内存中有metadata,metadata里主要记录的信息包括:file location,ownership,permissions,block's name and location。

metadata持久化在fsimage文件中,每次NameNode启动时加载到内存。Block location的信息并不存在fsimage中,而是启动后,dataNode定时发给NameNode.

对metadata进行的操作不仅保留在内存中,同时也会写到edit log文件中。当NameNode关闭后,内存中的metadata会消失,下次启动时,会动过edit log一条条还原所有的修改,这个过程导致NameNode启动非常的慢,后来增加了SecondaryNameNode,NameNode会定期的把fsimage和edit log传给Secondary NameNode. Secondary NameNode合并fsimage和log成为新的fsimg并传回NameNode,这样下次启动的时候,就可以只读fsimage了,大大减少启NameNode启动时间。每次SecondaryNameNode对fsimage的update叫做一次checkpoint。

SecondaryNameNode并不是NameNode的failover Node,只是它的“小秘书”。

SecondaryNameNode只在非HA的模式下存在,应该安装在与NameNode不同的机器上,SecondaryNameNode同样需要NameNode一样多的内存。

HDFS的HA是为了解决NameNode的单点问题。两个NameNode一个active,一个standby。standby负责checkpoint.

DataNode控制block的访问权限并保持与NameNode的通信。

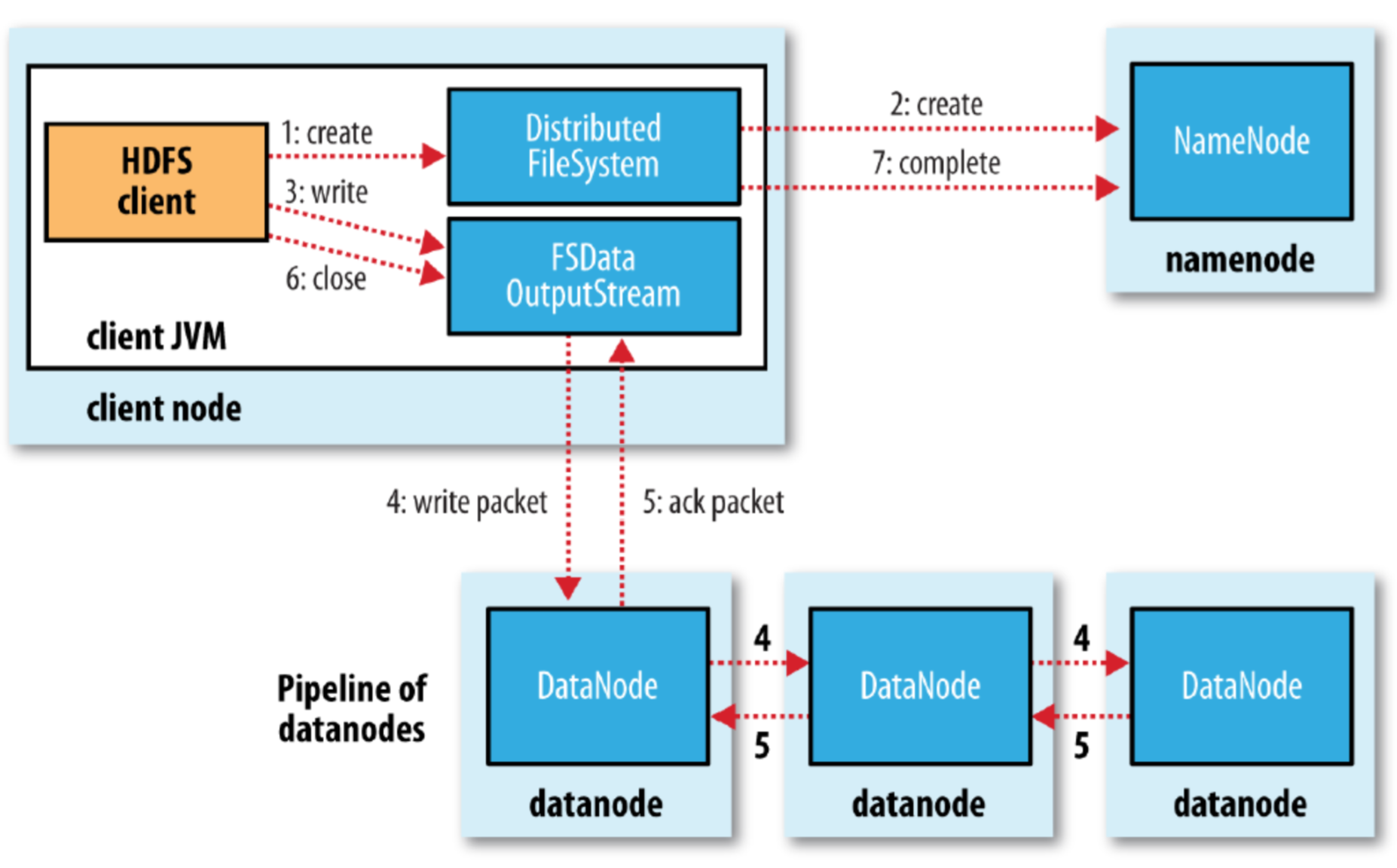

1.client connect to NameNode。

2.NameNode在metadata中为要写入的文件建立一条记录并返回可以写入的blockname和dataNode lists给client。

3.client connect 第一个DataNode,send data。

4.第一个DataNode接收到data后connect第二个DataNode,send data.

5.第二个DataNode又connect第三个dataNode,send data。

6.请求写入结果,并返回给client

7.client向NameNode发送写入完成信息。

在写入的过程中,如果第一个DataNode的pipeline断掉了,会有一个新的pipline建立起来,向第二个dataNode继续写。NameNode会继续找新的dataNode进行备份。

在block被写入时,client会对每一个block计算checksum同时发给dataNode,从而保持数据的完整性。

HDFS读数据流程:

1.client connect to NameNode。

2.Namenode返回要读出的数据所存放的datanode list(list中datanode的排序安照离client又近到远)和开头的几个block的名字。

3.client链接datanode读取数据,如果第一个datanode失去链接,则client去链接list中下一个datanode。

读取的过程中同样执行checksum。

Hadoop是机架感知的,在配好机架信息的前提下,hdfs的备份会存放在不同的机架。

DataNode每隔三秒向NameNode发送一次heartbeat,表示自己是health的。如果一段时间内NameNode没有收到某DataNode发送的heartbeat,则可认定这个DataNode lost,NameNode会把改dataNode上存储的blocks再在系统里进行一次备份,保证每个block的3备份。

Data never travels via a Namedata.

NameNode运行时,所有的metadata都在内存中,默认的NameNode堆大小为1G。1G的内存可以hold住1million的hdfs block。

cloudera learning2:HDFS的更多相关文章

- cloudera hbase集群简单思路

文章copy link:http://cloudera.iteye.com/blog/889468 链接所有者保留所有权! http://www.csdn.net/article/2013-05-10 ...

- hadoop cdh 4.5的安装配置

春节前用的shark,是从github下载的源码,自己编译.shark的master源码仅支持hive 0.9,支持hive 0.11的shark只是个分支,不稳定,官方没有发布release版,在使 ...

- Apache Pig处理数据示例

Apache Pig是一个高级过程语言,可以调用MapReduce查询大规模的半结构化数据集. 样例执行的环境为cloudera的单节点虚拟机 读取结构数据中的指定列 在hdfs上放置一个文件 [cl ...

- Hadoop-Impala学习笔记之入门

CDH quickstart vm包含了单节点的全套hadoop服务生态,可从https://www.cloudera.com/downloads/quickstart_vms/5-13.html下载 ...

- cdh日常维护常见问题及解决方案

为数据节点添加新硬盘 - 挂载硬盘到指定文件夹.如`/dfs_diskb`: - 打开cloudera manager -> hdfs -> 配置 -> DataNode -> ...

- 《ProgrammingHive》阅读笔记-第二章

书本第二章的一些知识点,在cloudera-quickstart-vm-5.8.0-0上进行操作. 配置文件 配置在/etc/hive/conf/hive-site.xml文件里面,采用mysql作为 ...

- Apache Hive处理数据示例

继上一篇文章介绍如何使用Pig处理HDFS上的数据,本文将介绍使用Apache Hive进行数据查询和处理. Apache Hive简介 首先Hive是一款数据仓库软件 使用HiveQL来结构化和查询 ...

- CDH 5.16.1 离线部署 & 通过 CDH 部署 Hadoop 服务

参考 Cloudera Enterprise 5.16.x Installing Cloudera Manager, CDH, and Managed Services Installation Pa ...

- Hello World on Impala

Cloudera Impala 官方教程 <Impala Tutorial>,解说了Impala一些基本操作,但操作步骤前后缺少连贯性,本文节W选<Impala Tutorial&g ...

随机推荐

- JavaScript高级程序设计学习笔记--事件

HTML事件处理程序 <input type="button" value="Click Me" onclick"showMessage()&q ...

- HTML 简单的介绍

Q: 什么是HTML? A: HTML 是一种超文本标记语言. 所谓的超文本是指指页面内可以包含图片,链接,甚至音乐.程序等非文字元素.超文本标记语言的结构包括"头"部分(英语:H ...

- NYOJ题目20吝啬的国度

-----------------------------------------n-1条边的无向连通图是一棵树,又因为树上两点之间的路径是唯一的,所以解是唯一的.(注意并不一定是二叉树,所以最好采用 ...

- Macbook Pro 使用小记

本周到手Macbook Pro,很激动.刚刚使用了几天,简单记下自己的感受. Macbook Pro的硬件配置和做工真没得说,非常完美. 触控板很强大.很好用,鼠标可以基本不用了,但要稍微学习一下 ...

- nginx部分命令

启动nginx start nginx 停止nginx nginx -s stop 重启nginx nginx -s reload 查看版本信息 nginx -v 大写V是查看配置信息 查看nginx ...

- backbonejs使用

backbone是一个非常好的前端MVC框架,将数据与逻辑分离出来,在稍大一点项目中,backbone都有用武之地. 个人感觉backbone最好的地方就是通过事件来管理数据改变导致的视图改变,bac ...

- 怎样上传网页到ftp中

1.下载filezilla软件软件并安装 打开刚刚装好的FileZilla,点击菜单中的"文件" 2.点击站点管理器 3.点击新站点

- [转载]Grunt插件之LiveReload 实现页面自动刷新,所见即所得编辑

配置文件下载 http://vdisk.weibo.com/s/DOlfks4wpIj LiveReload安装前的准备工作: 安装Node.js和Grunt,如果第一次接触,可以参考:Window ...

- [转]as3中的SharedObject的保存路径

SharedObject的保存路径 Windows XP 网络访问: C:\Documents and Settings\[你的用户名]\Application Data\Macromedia\Fla ...

- mac优秀软件介绍

1.首先是office软件: Microsoft_Office_2016_Installer.pkg 然后是一个破解软件 FWMSO2016VLU2.0.dmg_.zip 两个都不可少 2.然后是如果 ...