15-糗事百科(python+xpath)

爬取糗事百科的段子:

1.用xpath分析首要爬去内容的表达式;

2.用发起请求,获得原码;

3.用xpath分析源码,提取有用信息;

4.由python格式转为json格式,写入文件

#_*_ coding: utf-8 _*_

'''

Created on 2018年7月17日

@author: sss

function: 爬取糗事百科里面的内容 ''' import requests

import json

from lxml import etree url = "https://www.qiushibaike.com/8hr/page/3/"

headers = {'User-Agent': 'Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1 Trident/5.0;'}

html= requests.get(url, headers = headers).text

# print(html) #将返回的字符串格式,转为HTML DOM模式

text = etree.HTML(html) #获得包含每个糗事的链表

#返回所有糗事的节点位置,contains()模糊查询方法,第一个参数为要匹配的标签,第二个参数为标签的内容

node_list = text.xpath('//div[contains(@id, "qiushi_tag_")]') items = {}

for node in node_list:

#用户名

# username = node.xpath('./div/a/h2')[0].text

username = node.xpath('.//h2')[0].text

#图片连接

image = node.xpath('.//img/@src')#[0]

#取出标题下的内容

content = node.xpath('./a/div/span')[0].text

#点赞

zan = node.xpath('./div/span/i')[0].text

#评论

comment = node.xpath('./div/span/a/i')[0].text items = {

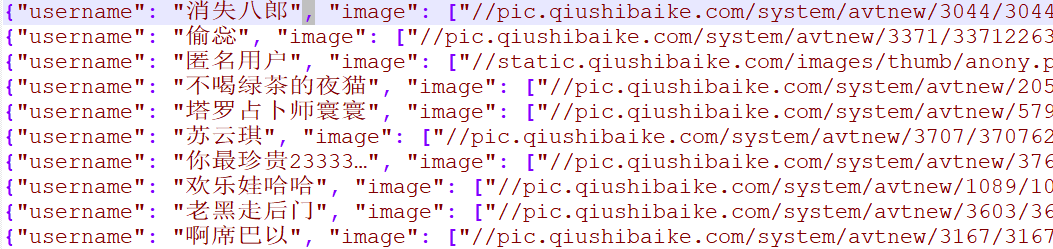

'username' : username,

'image' : image,

'content' : content,

'zan' : zan,

'comments' : comment

} #把python格式的转换为json格式,此时转换成了字符串,就可以写入糗事段子.txt文件中了

we=json.dumps(items, ensure_ascii=False)

print(we)

with open('qiushi.txt', 'a', encoding='utf-8') as f: #注意在这里转为utf-8格式

f.write((we + '\n'))

效果:

不

不

不以json格式存储:

#_*_ coding: utf-8 _*_

'''

Created on 2018年7月17日

@author: sss

function: 爬取糗事百科里面的内容 ''' import requests

import json

from lxml import etree url = "https://www.qiushibaike.com/8hr/page/3/"

headers = {'User-Agent': 'Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1 Trident/5.0;'}

html= requests.get(url, headers = headers).text

# print(html) #将返回的字符串格式,转为HTML DOM模式

text = etree.HTML(html) #获得包含每个糗事的链表

#返回所有糗事的节点位置,contains()模糊查询方法,第一个参数为要匹配的标签,第二个参数为标签的内容

node_list = text.xpath('//div[contains(@id, "qiushi_tag_")]') items = {}

for node in node_list:

#用户名

# username = node.xpath('./div/a/h2')[0].text

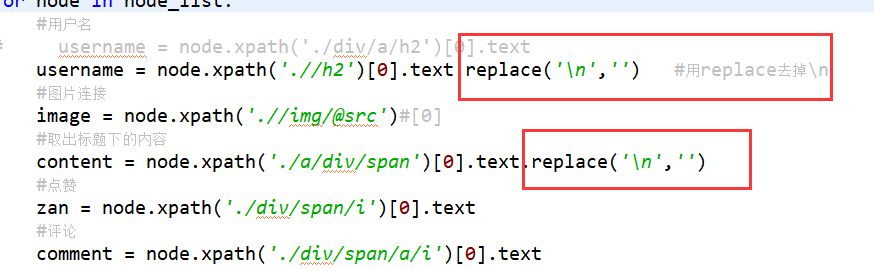

username = node.xpath('.//h2')[0].text.replace('\n','') #用replace去掉\n

#图片连接

image = node.xpath('.//img/@src')#[0]

#取出标题下的内容

content = node.xpath('./a/div/span')[0].text.replace('\n','')

#点赞

zan = node.xpath('./div/span/i')[0].text

#评论

comment = node.xpath('./div/span/a/i')[0].text items = {

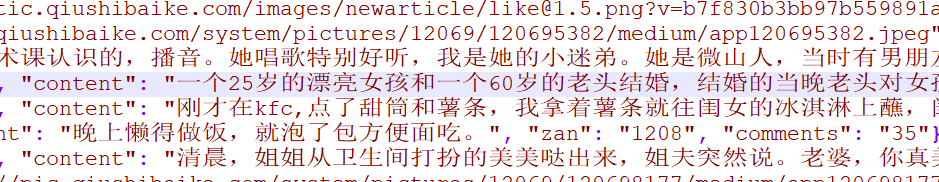

'username' : username,

'image' : image,

'content' : content,

'zan' : zan,

'comments' : comment

} #把python格式的转换为json格式,此时转换成了字符串,就可以写入糗事段子.txt文件中了

# we=json.dumps(items, ensure_ascii=False)

# print(we)

# with open('qiushi.json', 'a', encoding='utf-8') as f: #注意在这里转为utf-8格式

# f.write((we + '\n'))

with open('qiushi_wenben.txt', 'a', encoding = "utf-8") as f:

f.write('用户:' + username + '\n')

f.write('图片链接:https:' + image[0] + '\n')

f.write('内容:' + content + '\n')

f.write('赞:' + zan + '\n')

f.write('评论:' + comment + '\n\n')

效果:

15-糗事百科(python+xpath)的更多相关文章

- 糗事百科python爬虫

# -*- coding: utf-8 -*- #coding=utf-8 import urllib import urllib2 import re import thread import ti ...

- Python爬虫(十八)_多线程糗事百科案例

多线程糗事百科案例 案例要求参考上一个糗事百科单进程案例:http://www.cnblogs.com/miqi1992/p/8081929.html Queue(队列对象) Queue是python ...

- Python爬虫实战一之爬取糗事百科段子

大家好,前面入门已经说了那么多基础知识了,下面我们做几个实战项目来挑战一下吧.那么这次为大家带来,Python爬取糗事百科的小段子的例子. 首先,糗事百科大家都听说过吧?糗友们发的搞笑的段子一抓一大把 ...

- python 多线程糗事百科案例

案例要求参考上一个糗事百科单进程案例 Queue(队列对象) Queue是python中的标准库,可以直接import Queue引用;队列是线程间最常用的交换数据的形式 python下多线程的思考 ...

- python scrapy实战糗事百科保存到json文件里

编写qsbk_spider.py爬虫文件 # -*- coding: utf-8 -*- import scrapy from qsbk.items import QsbkItem from scra ...

- python爬虫30 | scrapy后续,把「糗事百科」的段子爬下来然后存到数据库中

上回我们说到 python爬虫29 | 使用scrapy爬取糗事百科的例子,告诉你它有多厉害! WOW!! scrapy awesome!! 怎么会有这么牛逼的框架 wow!! awesome!! 用 ...

- python爬虫29 | 使用scrapy爬取糗事百科的例子,告诉你它有多厉害!

是时候给你说说 爬虫框架了 使用框架来爬取数据 会节省我们更多时间 很快就能抓取到我们想要抓取的内容 框架集合了许多操作 比如请求,数据解析,存储等等 都可以由框架完成 有些小伙伴就要问了 你他妈的 ...

- Xpath--使用Xpath爬取糗事百科成人版图片

#!usr/bin/env python#-*- coding:utf-8 _*-"""@author:Hurrican@file: 爬取糗事百科.py@time: 20 ...

- Python爬虫批量下载糗事百科段子,怀念的天王盖地虎,小鸡炖蘑菇...

欢迎添加华为云小助手微信(微信号:HWCloud002 或 HWCloud003),输入关键字"加群",加入华为云线上技术讨论群:输入关键字"最新活动",获取华 ...

- 爬取糗事百科热门段子的数据并保存到本地,xpath的使用

和之前的爬虫类博客的爬取思路基本一致: 构造url_list,因为糗事百科的热门栏目默认是13页,所以这个就简单了 遍历发送请求获取响应 提取数据,这里用的是xpath提取,用的是Python的第三方 ...

随机推荐

- bzoj 1185 [HNOI2007]最小矩形覆盖——旋转卡壳

题目:https://www.lydsy.com/JudgeOnline/problem.php?id=1185 矩形一定贴着凸包的一条边.不过只是感觉这样. 枚举一条边,对面的点就是正常的旋转卡壳. ...

- RedHat6.5用ISO配置yum源

CentOS自带强大的yum功能,默认为从网上自动下载rpm包,对于网速不太给力或者没有网络的情况下需要用的话就不是很方便,很多软件尤其是服务器上的软件我们么有必要追求最新,稳定性最重要,这里我们用C ...

- Zookeeper--集群管理

Zookeeper--集群管理 在多台服务器组成的集群中,需要监控每台服务器的状态,一旦某台服务器挂掉了或有新的机器加入集群,集群都要感知到,从而采取相应的措施.一个主动的集群可以自动感知节点的死亡和 ...

- poj 3977 Subset(折半枚举+二进制枚举+二分)

Subset Time Limit: 30000MS Memory Limit: 65536K Total Submissions: 5721 Accepted: 1083 Descripti ...

- Hadoop MapReduce 初步学习总结

在Hadoop中一个作业被提交后,其后具体的执行流程要经历Map任务的提交中间结果处理,Reduce任务的分配和执行直至完成这些过程,下面就是MapReduce中作业详细的执行流程图(摘自<Ha ...

- lamp与lnmp的选择

lnmp和lamp业务上的不同 由于二者仅仅是区别在于web的选择,nginx更高效,占用资源更少,详情区别查看LNMP环境应用实践 lnmp和lamp安装上的不同 生产环境中,可能会遇到lamp架构 ...

- Druid.io系列(二):基本概念与架构

原文链接: https://blog.csdn.net/njpjsoftdev/article/details/52955788 在介绍Druid架构之前,我们先结合有关OLAP的基本原理来理解Dr ...

- Oracle 10g RAC TAF

Oracle RAC 同时具备HA(High Availiablity) 和LB(LoadBalance). 而其高可用性的基础就是Failover(故障转移). 它指集群中任何一个节点的故障都不会影 ...

- 新版台式机安装win7操作系统

1.进入bios设置-----authentication选项中的secure boot设置为disabled2.在boot options选项中launch csm设置为always 3.在boot ...

- vs2010 安装 Ajax Control Toolkit

Ajax Control Toolkit 7.1005.0 The Ajax Control Toolkit contains a rich set of controls that you can ...