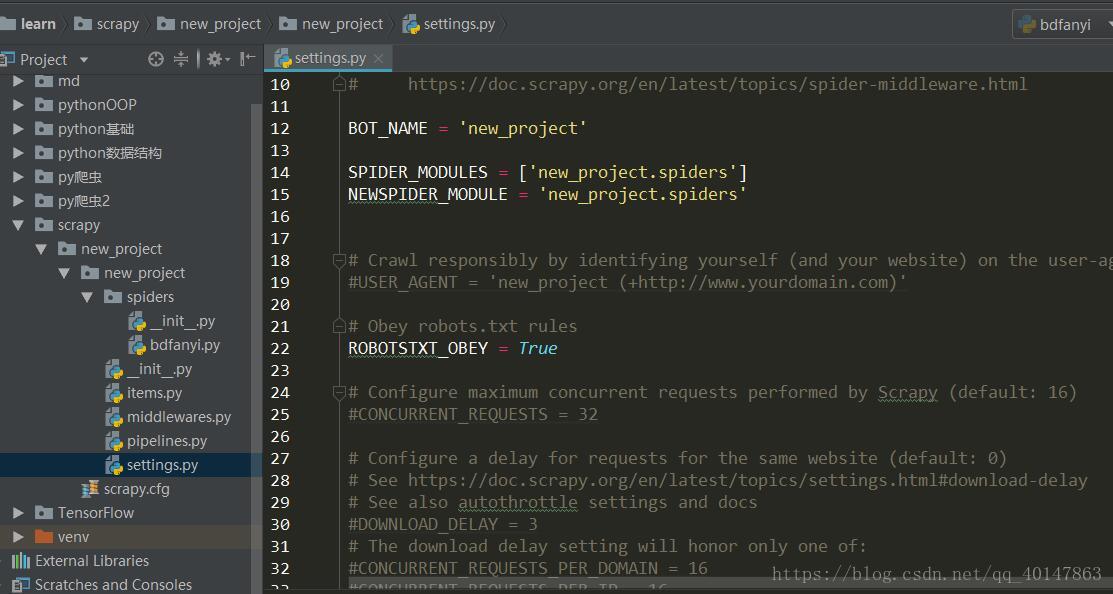

Python爬虫教程-32-Scrapy 爬虫框架项目 Settings.py 介绍

本篇介绍项目开发的过程中,对 Setting 文件的配置和使用

Python爬虫教程-32-Scrapy 爬虫框架项目 Settings.py 介绍

- settings.py 文件的使用

- 想要详细查看 settings.py文件的更多内容,可查看中文文档:

Settings 中配置 USER_AGENTS

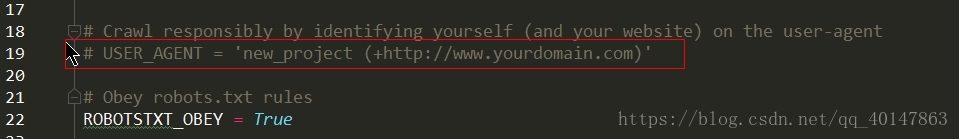

- 在 settings.py 文件中很多东西默认是给注释掉的,当我们需要使用的时候,根据注释的提示,我们编写我们自己的内容

- 例如:

- 我们想设置一个 USER_AGENT 列表

- 在 settings.py 文件中找到 USER_AGENT ,拷贝常用的 USER _AGENT 值在它下面

- 但是 settings 只有一行,就是没有具体的内容,我们想要使用的话,就需要我们自己去填写

- 这就需要我们自己在网上找到常用的浏览器 User-Agent 值, 我找到了一些,想要使用直接拷贝就可以

- 在 settings.py 文件中找到 USER_AGENT ,拷贝常用的 USER _AGENT 值在它下面

USER_AGENTS = ["Mozilla/5.0 (compatible; MISE 9.0; Windows NT 6.1; Win64; x64; Trident/5.0; .NET CLR 3.5.30729; .NET CLR 3.0.30729; .NET CLR 2.0.5.727; Media Center PC 6.0)","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.71 Safari/537.36","Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/537.11 (KHTML, like Gecko) Chrome/23.0.1271.64 Safari/537.11","Mozilla/5.0 (Windows; U; Windows NT 6.1; en-US) AppleWebKit/534.16 (KHTML, like Gecko) Chrome/10.0.648.133 Safari/534.16","Mozilla/5.0 (Windows NT 6.1; WOW64; rv:34.0) Gecko/20100101 Firefox/34.0","Mozilla/5.0 (X11; U; Linux x86_64; zh-CN; rv:1.9.2.10) Gecko/20100922 Ubuntu/10.10 (maverick) Firefox/3.6.10","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/39.0.2171.95 Safari/537.36 OPR/26.0.1656.60 ","Opera/8.0 (Windows NT 5.1; U; en) ","Mozilla/5.0 (Windows NT 5.1; U; en; rv:1.8.1) Gecko/20061208 Firefox/2.0.0 Opera 9.50 ","Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; en) Opera 9.50","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/534.57.2 (KHTML, like Gecko) Version/5.1.7 Safari/534.57.2","Mozilla/5.0 (compatible; MSIE 9.0; Windows NT 6.1; WOW64; Trident/5.0; SLCC2; .NET CLR 2.0.50727; .NET CLR 3.5.30729; .NET CLR 3.0.30729; Media Center PC 6.0; .NET4.0C; .NET4.0E; QQBrowser/7.0.3698.400) ","Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1; SV1; QQDownload 732; .NET4.0C; .NET4.0E)",]

- 直接将这段代码拷贝到 Settings 文件中就可以

Settings 中配置 PROXIES

- 关于 proxy 代理 IP 的详细介绍,查看:Python爬虫教程-11-proxy代理IP,隐藏地址(猫眼电影)

- 获取代理IP 的网站:

- www.goubanjia.com

- www.xicidaili.com

- 从网站上找可用的 IP,直接拷贝就行,然后在Settings 中拷贝下面这段代码:

# IP 有效期一般20天,请自行到上述网站获取最新 IPPROXIES = [{'ip_port': '177.136.120.174:80', 'user_passwd': 'user1:pass1'},{'ip_port': '218.60.8.99:3129', 'user_passwd': 'user2:pass2'},{'ip_port': '206.189.204.62:8080', 'user_passwd': 'user3:pass3'},{'ip_port': '125.62.26.197:3128', 'user_passwd': 'user4:pass4'}]

- 这些类似的设置都是一次设置,就可以重复使用了

关于去重

- 很多网站都是相同的内容,比如介绍 python 爬虫的,很多很多,假设爬取到这些的时候,我们就值需要一个,利用 scrapy 的去重功能,防止它对重复网站无限制爬下去

- 为了防止爬虫陷入死循环,需要去重

- 即在 spider 中 parse 函数中,返回 Request 的时候加上 dont_filter = False 参数

myspider(scrapy.Spider):def parse (...):...yield scrapy.Request(url = url, callback = self.parse, dont_filter = False)

- 如何在 scrapy 使用 selenium

- 可以放入中间件中的 process _request 函数中

- 在函数中调用 selenium,完成爬取后返回 Response

class MyMiddleWare(object):def process_request(...):driver = webdriver.Chrome()html = driver.page_sourcedriver.quit()return HtmlResponse(url = request.url, encoding = 'utf-8', body = html ,request = requeset

更多文章链接:Python 爬虫随笔

- 本笔记不允许任何个人和组织转载

Python爬虫教程-32-Scrapy 爬虫框架项目 Settings.py 介绍的更多相关文章

- iOS 9应用开发教程之创建iOS 9项目与模拟器介绍

iOS 9应用开发教程之创建iOS 9项目与模拟器介绍 编写第一个iOS 9应用 本节将以一个iOS 9应用程序为例,为开发者讲解如何使用Xcode 7.0去创建项目,以及iOS模拟器的一些功能.编辑 ...

- Python爬虫教程-新浪微博分布式爬虫分享

爬虫功能: 此项目实现将单机的新浪微博爬虫重构成分布式爬虫. Master机只管任务调度,不管爬数据:Slaver机只管将Request抛给Master机,需要Request的时候再从Master机拿 ...

- Django框架中settings.py注释

1 # coding:utf8 2 """ 3 Django settings for DjangoTest project. 4 5 Generated by 'dja ...

- django项目settings.py的基础配置

一个新的django项目初始需要配置settings.py文件: 1. 项目路径配置 新建一个apps文件夹,把所有的项目都放在apps文件夹下,比如apps下有一个message项目,如果不进行此项 ...

- 大爽Python入门教程 3-2 条件判断: if...elif..else

大爽Python入门公开课教案 点击查看教程总目录 简单回顾if 回顾下第一章的代码 >>> x = 5 >>> if x > 0: ... print(&q ...

- python基础教程2第20章 项目1:即时标记

simple_markup.py import sys, re from util import * print('<html><head><title>...&l ...

- Python基础教程(016)--Python2和Python3的介绍

前言 Python2和Python3的区别 内容 Python3是现在和未来的主要版本 Python3没有考虑向下兼容. 官方提供了一个Python过度版本Python2.6 Python2.6及支持 ...

- Python爬虫教程-01-爬虫介绍

Spider-01-爬虫介绍 Python 爬虫的知识量不是特别大,但是需要不停和网页打交道,每个网页情况都有所差异,所以对应变能力有些要求 爬虫准备工作 参考资料 精通Python爬虫框架Scrap ...

- Python爬虫教程-00-写在前面

鉴于好多人想学Python爬虫,缺没有简单易学的教程,我将在CSDN和大家分享Python爬虫的学习笔记,不定期更新 基础要求 Python 基础知识 Python 的基础知识,大家可以去菜鸟教程进行 ...

随机推荐

- CF1097D Makoto and a Blackboard(期望)

[Luogu-CF1097D] 给定 \(n,k\)一共会进行 \(k\) 次操作 , 每次操作会把 \(n\) 等概率的变成 \(n\) 的某个约数 求操作 \(k\) 次后 \(n\) 的期望是多 ...

- 洛谷 P3227 [HNOI2013]切糕(最小割)

题解 Dinic求最小割 题目其实就是求最小的代价使得每个纵轴被分成两部分 最小割!!! 我们把每个点抽象成一条边,一个纵轴就是一条\(S-T\)的路径 但是题目要求\(|f(x,y)-f(x',y' ...

- ORACLE MERGE INTO UPDATE DELETE 用法

ORACLE MERGE INTO UPDATE DELETE 用法 使用该MERGE语句从一个或多个源中选择行以进行更新或插入表或视图.您可以指定条件以确定是更新还是插入目标表或视图. 此语句是组合 ...

- 【测试的艺术】+测试分析&测试计划+模板

一.项目概述 1.1.项目背景 #就是说一下为什么要做这个项目 1.2.项目目标 #这个项目最终要达到的目标是什么 二.项目整体分析 #项目分为哪些部分?各部分之间的关联是什么?各部分的目标是什么? ...

- kafka producer自定义partitioner和consumer多线程

为了更好的实现负载均衡和消息的顺序性,Kafka Producer可以通过分发策略发送给指定的Partition.Kafka Java客户端有默认的Partitioner,平均的向目标topic的各个 ...

- Google推荐的图片加载库Glide

英文原文 Introduction to Glide, Image Loader Library for Android, recommended by Google 首发地址 http://jco ...

- Helper Devise: could not find the `Warden::Proxy` instance on request environment

在使用devise这个gem时,编写控制器层的单元测试,你需要在你的rspec帮助文件 rails_helper.rb里添加下面这一样 RSpec.configure do |config| conf ...

- JVM Run-Time Data Areas--reference

http://www.programcreek.com/2013/04/jvm-run-time-data-areas/ This is my note of reading JVM specific ...

- Cannot find module 'object-keys' 的解决办法

把node_modules文件夹删除,重新cnpm install安装node_modules就好了.

- css样式margin padding border