变分自编码器(Variational auto-encoder,VAE)

参考:

https://www.cnblogs.com/huangshiyu13/p/6209016.html

https://zhuanlan.zhihu.com/p/25401928

https://blog.csdn.net/ustbfym/article/details/78870990

https://blog.csdn.net/StreamRock/article/details/81258543

https://blog.csdn.net/weixin_40955254/article/details/82315224

https://blog.csdn.net/weixin_40955254/article/details/82315909

Kingma, Diederik P., and Max Welling. "Auto-encoding variational bayes." arXiv preprint arXiv:1312.6114 (2013)

简介:

变分自编码器(Variational auto-encoder,VAE)是一类重要的生成模型(generative model),它于2013年由Diederik P.Kingma和Max Welling提出。

这里有一些使用VAE好处,就是我们可以通过编码解码的步骤,直接比较重建图片和原始图片的差异,但是GAN做不到。

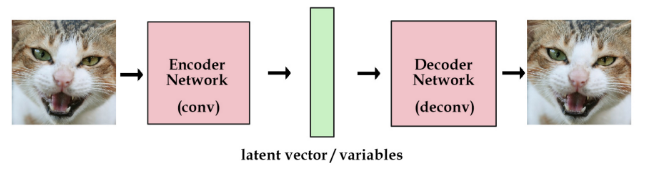

假设,给定一系列猫的照片,我希望你能够对应我随机输入的一个n维向量,生成一张新的猫的照片,你需要怎么去做?对于GAN就是典型的深度学习时代的逻辑,你不是不清楚这个n维向量与猫的图片之间的关系嘛,没关系,我直接拟合出来猫的图片对于n维向量的分布,通过对抗学习的方式获得较好的模型效果,这个方法虽然很暴力,但是却是有效的。

VAE则不同,他通过说我希望生成一张新的猫脸,那么这个n维向量代表的就是n个决定最终猫脸模样的隐形因素。对于每个因素,都对应产生一种分布,从这些分布关系中进行采样,那么我就可以通过一个深度网络恢复出最终的猫脸。VAE相比较于GAN它的效果往往会略微模糊一点,但是也不失为一种良好的解决方案。

问题背景:

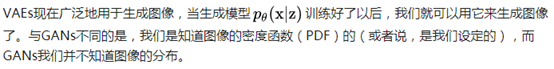

首先我们有一批数据样本 {x1,…,xn},其整体用 X 来描述,我们本想根据 {x1,…,xn} 得到 X 的分布 p(X),如果能得到的话,那我直接根据 p(X) 来采样,就可以得到所有可能的 X 了(包括 {x1,…,xn} 以外的),这是一个终极理想的生成模型了。但是,这个过程往往是很困难的。

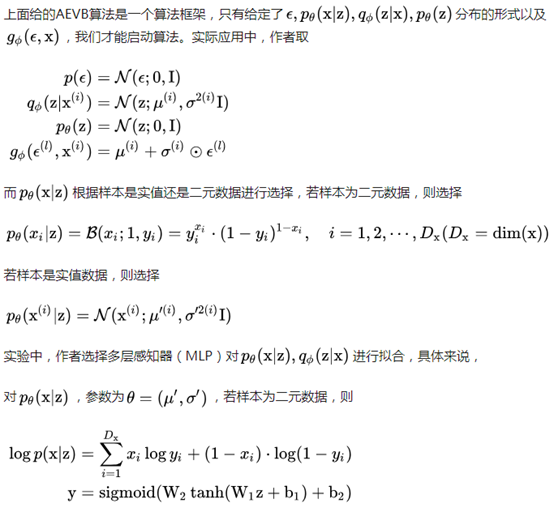

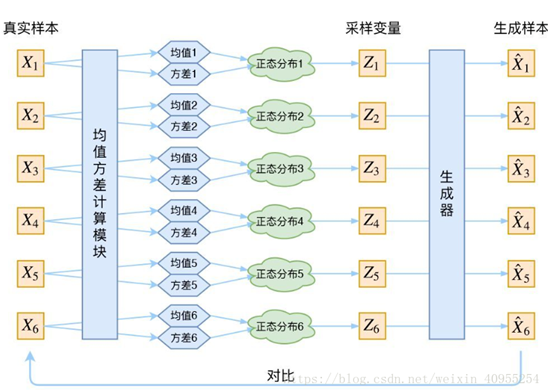

于是,我们退而求其次,就想到了上文中提到的隐形变量Z,这个Z就是决定最终x形态的因素向量。给定一个图片Xk,我们假定p(Z|Xk)是专属于Xk的后验概率分布,这个概率分布服从正态分布。得到了这个概率,我们可以从分布中采样,并且通过最终的解码器将图片再恢复出来。

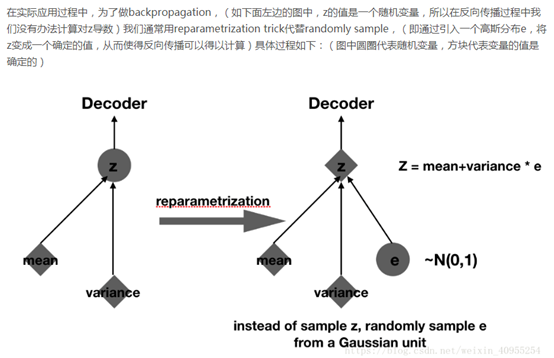

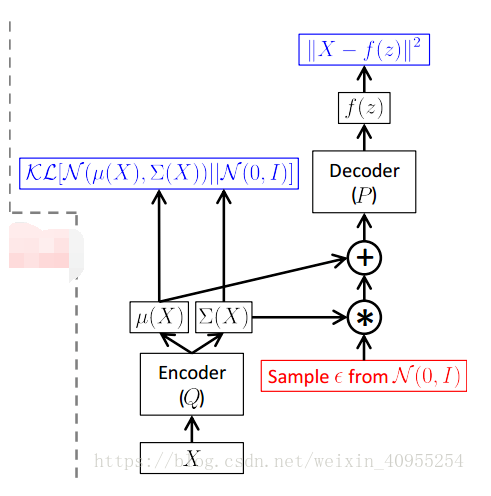

由于上述所说,我们所假设的这些分布都是正态分布,那么我们就需要求得相应的方差和均值,所以在编码实现的过程中,不难看到encoder部分真实做的事情就是,对相应的输入数据,通过两个网络产生了均值和方差。

是一个包含了N个连续或者离散样本x的数据集。

是一个包含了N个连续或者离散样本x的数据集。

假设数据是通过涉及到一个未观察到的连续随机变量z的过程产生的,这个过程包含了两步。

(1)通过某个先验分布  产生一个

产生一个  ;

;

(2)根据某个条件分布  产生样本

产生样本  。

。

假设  和

和 产生自分布

产生自分布 。

。

如何得到  和

和  是一个未知的难题。

是一个未知的难题。

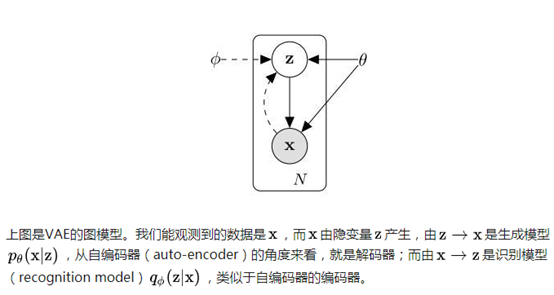

文章中用  作为编码器/识别模型(encoder or recognition model),基于数据x产生一个关于数据x的编码值z的分布。

作为编码器/识别模型(encoder or recognition model),基于数据x产生一个关于数据x的编码值z的分布。

作为解码器/生成模型(decoder or generative decoder),基于编码值z产生一个对应数据x的分布。

作为解码器/生成模型(decoder or generative decoder),基于编码值z产生一个对应数据x的分布。

其中φ和θ的值通过两者的联合学习得到。

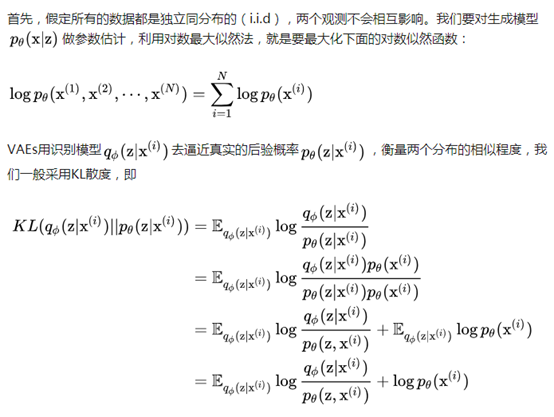

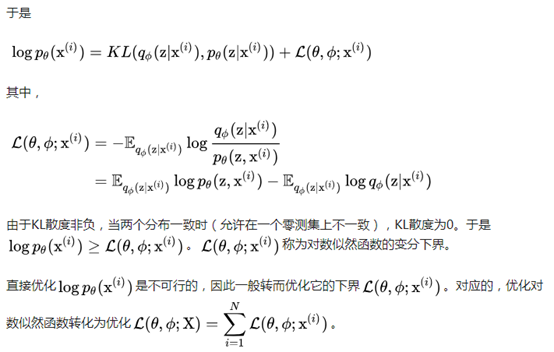

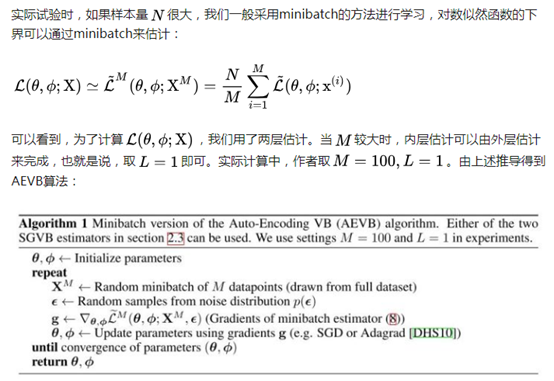

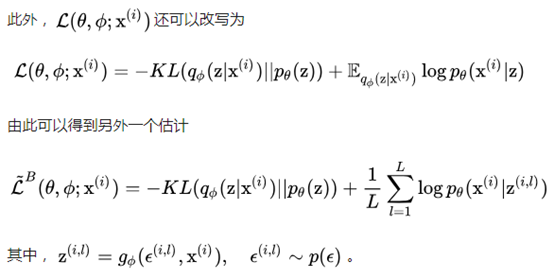

模型推导:

等价于

等价于

最大似然估计(maximum likelihood estimation, MLE):一种重要而普遍的求估计量的方法。MLE的目标是找出一组参数,使得模型产生出观测数据的概率最大。

KL散度:相对熵(relative entropy),又被称为Kullback-Leibler散度(Kullback-Leibler divergence)或信息散度(information divergence),是两个概率分布(probability distribution)间差异的非对称性度量。在在信息理论中,相对熵等价于两个概率分布的信息熵(Shannon entropy)的差值。

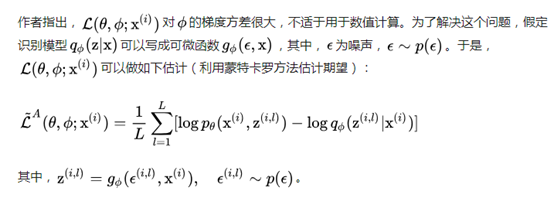

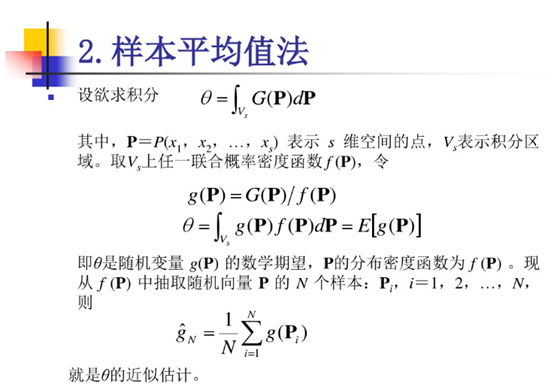

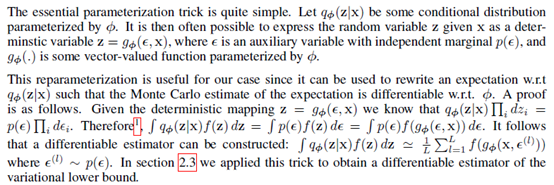

蒙特卡罗估计(Monte Carlo estimate):

证明:

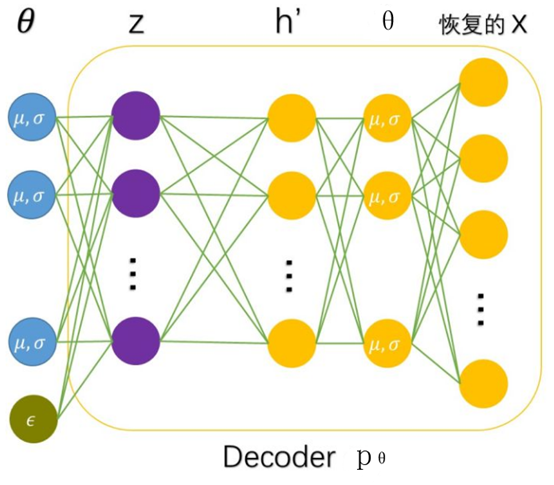

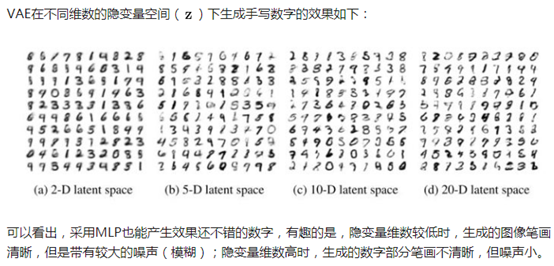

MLP(多层感知器):

VAE的encoder和decoder都只用了一层隐含层。

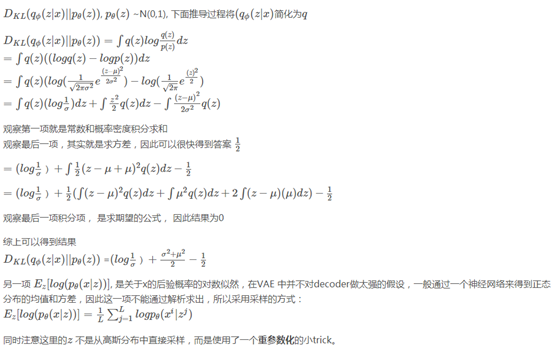

近似计算的证明:

表示元素乘法;按照高斯分布求解KL散度即可得到结果。

表示元素乘法;按照高斯分布求解KL散度即可得到结果。

训练好了以后,生成样本采用下面的网络结构:

变分自编码器(Variational auto-encoder,VAE)的更多相关文章

- (转) 变分自编码器(Variational Autoencoder, VAE)通俗教程

变分自编码器(Variational Autoencoder, VAE)通俗教程 转载自: http://www.dengfanxin.cn/?p=334&sukey=72885186ae5c ...

- 变分自编码器(Variational Autoencoder, VAE)通俗教程

原文地址:http://www.dengfanxin.cn/?p=334 1. 神秘变量与数据集 现在有一个数据集DX(dataset, 也可以叫datapoints),每个数据也称为数据点.我们假定 ...

- 4.keras实现-->生成式深度学习之用变分自编码器VAE生成图像(mnist数据集和名人头像数据集)

变分自编码器(VAE,variatinal autoencoder) VS 生成式对抗网络(GAN,generative adversarial network) 两者不仅适用于图像,还可以 ...

- 基于变分自编码器(VAE)利用重建概率的异常检测

本文为博主翻译自:Jinwon的Variational Autoencoder based Anomaly Detection using Reconstruction Probability,如侵立 ...

- 变分推断到变分自编码器(VAE)

EM算法 EM算法是含隐变量图模型的常用参数估计方法,通过迭代的方法来最大化边际似然. 带隐变量的贝叶斯网络 给定N 个训练样本D={x(n)},其对数似然函数为: 通过最大化整个训练集的对数边际似然 ...

- 基于图嵌入的高斯混合变分自编码器的深度聚类(Deep Clustering by Gaussian Mixture Variational Autoencoders with Graph Embedding, DGG)

基于图嵌入的高斯混合变分自编码器的深度聚类 Deep Clustering by Gaussian Mixture Variational Autoencoders with Graph Embedd ...

- VAE变分自编码器实现

变分自编码器(VAE)组合了神经网络和贝叶斯推理这两种最好的方法,是最酷的神经网络,已经成为无监督学习的流行方法之一. 变分自编码器是一个扭曲的自编码器.同自编码器的传统编码器和解码器网络一起,具有附 ...

- VAE变分自编码器

我在学习VAE的时候遇到了很多问题,很多博客写的不太好理解,因此将很多内容重新进行了整合. 我自己的学习路线是先学EM算法再看的变分推断,最后学VAE,自我感觉这个线路比较好理解. 一.首先我们来宏观 ...

- Auto Encoder用于异常检测

对基于深度神经网络的Auto Encoder用于异常检测的一些思考 from:https://my.oschina.net/u/1778239/blog/1861724 一.前言 现实中,大部分数据都 ...

随机推荐

- 正则表达式 (python 2)

Python提供re模块,包含所有正则表达式的功能.由于Python的字符串本身也用\转义,所以要特别注意: s = 'ABC\\-001' # Python的字符串# 对应的正则表达式字符串变成:# ...

- Entity Framework: 主从表的增删改

1.根据主表添加从表数据 var dest = (from d in context.Destinations where d.Name == "Bali" select d).S ...

- IIS 7.5+FCK编辑器+burp suite神器拿webshell

本人小菜一枚,大牛勿喷 看图: 一个越南狗的网站,看了看好多人来过哦,估计都是在这跪下了,试了好多别人上传滴都不行,看了看是IIS7.5,难怪都卡在这里了,于是小编直接上神器Burp Suite- 截 ...

- AngularJs学习笔记--Understanding the Controller Component

原版地址:http://docs.angularjs.org/guide/dev_guide.mvc.understanding_model 在angular中,controller是一个javasc ...

- Windows Server 2012/2012 R2:安装和配置 SMTP 服务器

Windows Server 2012/2012 R2:安装和配置 SMTP 服务器 安装 SMTP 服务器 以下是安装 SMTP 服务器功能的步骤: 打开“服务器管理器”:单击键盘上的 Window ...

- xml-apis-ext.jar

xml-apis-ext.jar,hightcharts导出图片是解决乱码需要用到的一个包

- 显示锁(ReentranLock)

1. Lock接口:定义了一组抽象的加锁操作,提供了一种无条件的.可轮询的.定时的以及可中断的锁获取操作,所有的加锁和解锁的方法都是显示的. 2. ReentrantLock锁:实现了Lock接口,并 ...

- CF#538(div2) B. Yet Another Array Partitioning Task 【YY】

任意门:http://codeforces.com/contest/1114/problem/B B. Yet Another Array Partitioning Task time limit p ...

- JSON数据转换之net.sf.json包的使用

转载 解析json之net.sf.json https://blog.csdn.net/itlwc/article/details/38442667 一.介绍 使用之前需要导入的jar包: json- ...

- 为类型“xxxx”多次调用了 Map,且其中至少有一个调用未指定目标表名称。

ef的继承映射真的是能搞死人啊...小结一下: 下图中的代码,ResponseTextMessage.ResponseNewsMessage.ResponseMethodMessage等几个类都是Re ...