Spark的基本说明

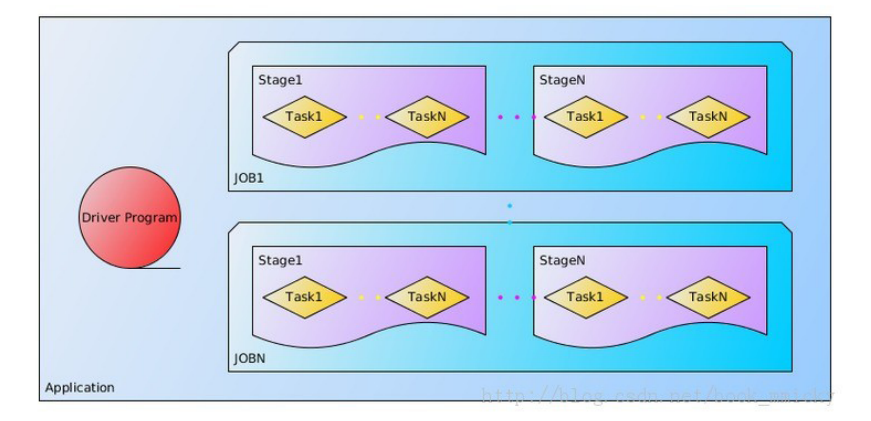

1、关于Application

用户程序,一个Application由一个在Driver运行的功能代码和多个Executor上运行的代码组成(工作在不同的节点上)。

又分成多个Job,每个Job由多个RDD和一些Action操作组成、job本分多个task组,每个task组称为:stage。

每个task又被分到多个节点,由Executor执行:

在程序中RDD转化其实还未真正运行,真正运行的是操作的时候。

2、程序执行过程

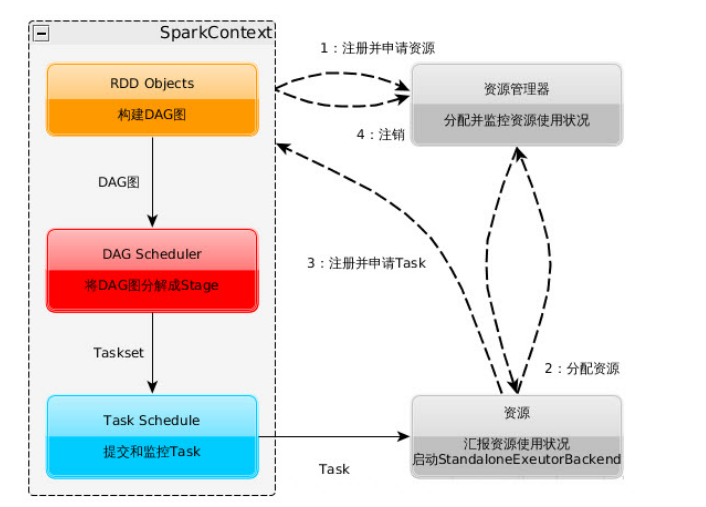

1)构建Spark Application的运行环境,就是启动SparkContext,启动后,向资源管理器

(standalone--spark自己的Master管理资源、Mesos或Yarn)注册且申请运行Executor资源。

2)资源管理器分配Executor资源,并且在各个节点上启动StandaloneExecutorBackend(对Standalone来说),Executor将运行情况随着心跳发送到资源管理器上。

3)SparkContext根据用户程序,构建DAG图,将DAG分解成Stage,划分原则是宽依赖时候划分,把Stage(TaskSet)发送给TaskScheduler。Stage

根据RDD的Partition数量来决定Task的数量;Executor向SparkContext申请Task。Task Scheduler将Task发送给Executor运行,且同时把代码发送给Executor(好像是Master开启HTTP服务,Executor去取代码)。

4)Task在Executor【此程序专属】上运行,多线程运行,线程数看可以运行的核数。

5)Spark Context运行地点和Worker不要分隔太远,中间过程有数据交换。

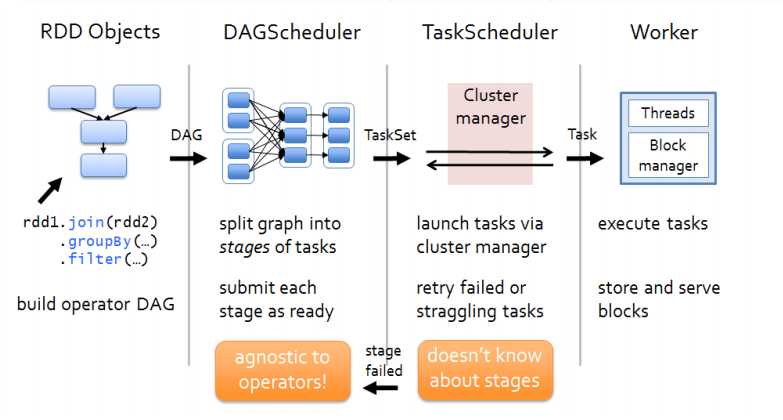

3、DAG Scheduler

1)根据RDD的依赖关系来划分Stage,简单来说,如果一个子RDD只依赖一个父RDD,则在一个Stage中,否则在多个Stage中,只依赖一个父RDD称为窄依赖,依赖多个父RDD为宽依赖,

发生宽依赖称为Shuffle。

2)当Shuffle数据处理失败的时候,它重新处理之前的数据。

3)它根据RDD构建DAG(有向无环图),然后再进一步找出开销最小的调度方法。将Stage发送给Task Scheduler。

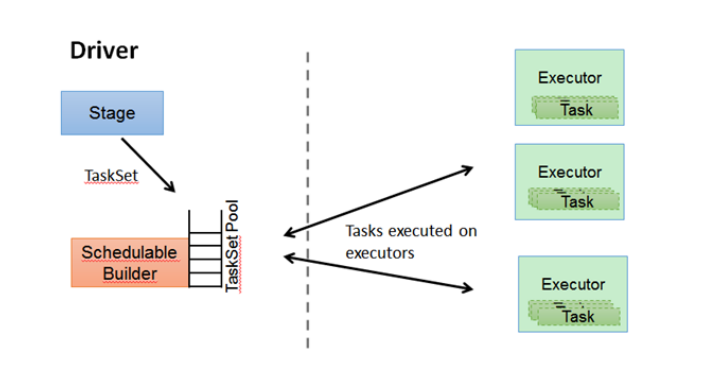

4、Task Scheduler

1)保存维护所有的TaskSet。

2)当Executor向Driver发送心跳的时候,TaskScheduler会根据其资源使用情况分配相应Task,如果允许失败,重试失败的Task。

5、RDD的运行原理

1)根据Spark内部对象或者Hadoop等外部对象创建RDD。

2)构建DAG。

3)划分为Task,分别在多个节点上执行后汇总。

举例:第一个字母排序:

sc.textFile("hdfs://names")

.map(name => (name.charAt(0),name))

.groupByKey()

.mapValues(names =>names.toSet.size)

.collect()

假设文件内容为按行的姓名:

Ah (A,Ah) (A,(Ah,Anlly) [ (A,2),

PPT ---> map----> (P,PPT) ----->groupByKey--->(P,(PPT))-------->mapValues---> (P,1)]

Anlly (A,Anlly)

1)创建RDD、最后的collect为动作不会创建RDD,其他的操作都会创建新的RDD。

2)创建DAG,groupBy()会进行依赖多条上一个RDD的数据,所以多划分为一个阶段。

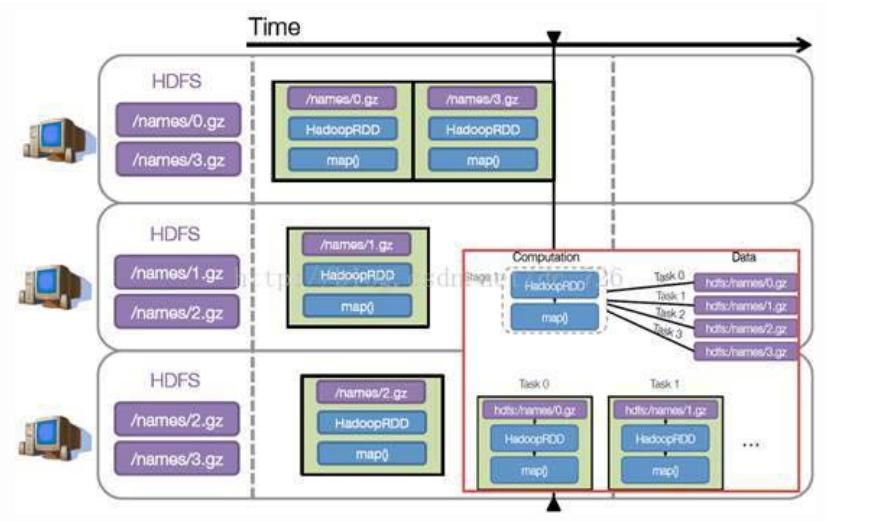

如图:

3)执行任务,每个阶段必须等上一个阶段执行完成。每个Stage又分成不同的Task执行,每个Task都包含代码+数据。

假设例子中的names下面有四个文件块,那么HadoopRDD中的Partitions自动划分为四个分区对应这四块数据。

就会创建四个Task执行相关任务。

每个Task操作一块数据再执行,以上例子的简单模拟:

import org.apache.spark.{SparkConf, SparkContext}

object NameCountCh {

def main(args: Array[String]) {

if (args.length < 1) {

System.err.println("Usage:<File>")

System.exit(1)

}

val conf = new SparkConf().setAppName("NameCountCh")

val sc = new SparkContext(conf)

sc.textFile(args(0))

.map(name => (name.charAt(0), name))

.groupByKey()

.mapValues(names => names.toSet.size)

.collect().foreach(println)

}

}

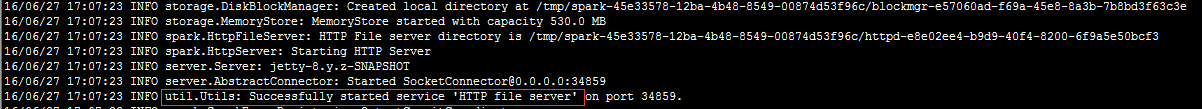

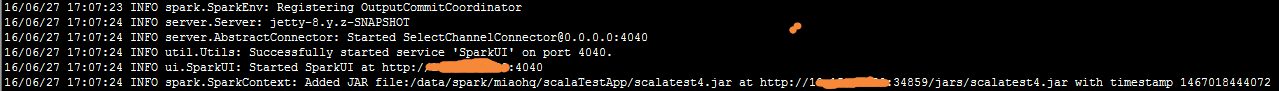

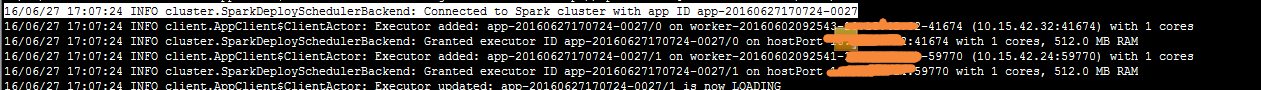

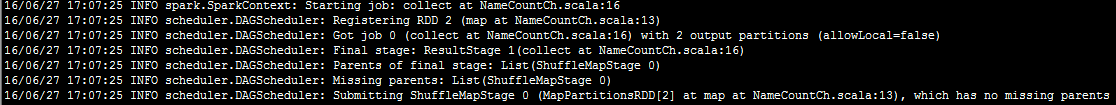

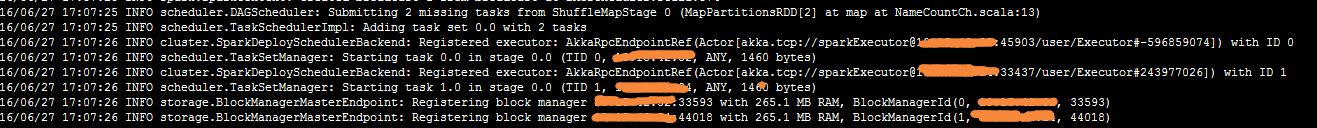

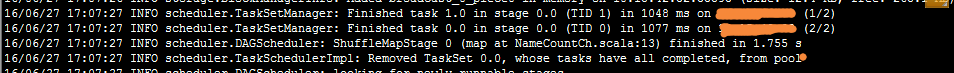

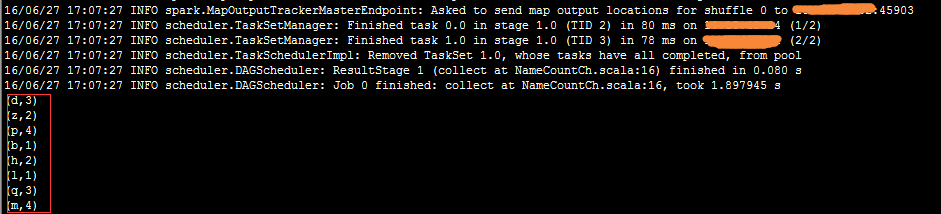

实际执行过程截图:

执行命令: ./spark-submit --master spark://xxxx:7077 --class NameCountCh --executor-memory 512m --total-executor-cores 2 /data/spark/miaohq/scalaTestApp/scalatest4.jar hdfs://spark29:9000/home/miaohq/testName.txt

1、启动一个HTTP端口:

2、按照提交的文件将文件放到这个Web服务器上

3、创建程序生成两个Executor

4、DAG调度

完成第一stage:

调度第二stage:

完成第二个stage输出结果:

疑惑:

1、小文件看不出来文件分区的过程,另外设置了几个执行核,就会有几个Executor,如果超过总数可能要多线程了??

2、为什么一个stage是两个task,按照原理应该是文件分为几个partition就几个task,目前测试文件很小,只能分1个partition,也不是和Executor相关的,

设置了3个执行核心仍然只是两个task?

3、为什么从mapValues划分第二个stage不应该是 groupByKey()???

6、Standalone架构下Spark的执行

1、standalone是Spark实现的资源调度框架,有:Client节点、Master节点、Worker节点。

2、Driver即可运行在Master节点,也可以运行在本地的Client端。

用spark-shell交互工具提交Spark的job的时候,运行在Master节点;

用spark-submit 提交或者用sparkConf.setManager("Spark://master:7077")是运行在Client端。

3、运行在Client端的执行过程如下:

说明:

1)sparkContext连接到Master,注册并申请资源(cpu 和内存)

2)Master根据申请信息和Worker心跳报告决定在哪个主机上分配资源,然后获取资源,启动StandaloneExecutorBackend。

3)StandaloneExecutorBackend向sparkContext注册。

4)sparkContext发送代码给StandaloneExecutorBackend且根据代码,构建DAG。

遇到Action动作会生成一个Job,然后根据Job内部根据RDD依赖关系生成多个Stage,Stage提交给TaskScheduler,

5)StandaloneExecutorBackend在汇报状态时候获取Task信息调用Executor多线程执行task,且向sparkContext汇报,

直到任务完成。

6)所有Task完成后,SparkContext向Master注销,释放资源。

说明:

文章中图片和内容来自:http://www.cnblogs.com/shishanyuan

Spark的基本说明的更多相关文章

- Spark踩坑记——Spark Streaming+Kafka

[TOC] 前言 在WeTest舆情项目中,需要对每天千万级的游戏评论信息进行词频统计,在生产者一端,我们将数据按照每天的拉取时间存入了Kafka当中,而在消费者一端,我们利用了spark strea ...

- Spark RDD 核心总结

摘要: 1.RDD的五大属性 1.1 partitions(分区) 1.2 partitioner(分区方法) 1.3 dependencies(依赖关系) 1.4 compute(获取分区迭代列表) ...

- spark处理大规模语料库统计词汇

最近迷上了spark,写一个专门处理语料库生成词库的项目拿来练练手, github地址:https://github.com/LiuRoy/spark_splitter.代码实现参考wordmaker ...

- Hive on Spark安装配置详解(都是坑啊)

个人主页:http://www.linbingdong.com 简书地址:http://www.jianshu.com/p/a7f75b868568 简介 本文主要记录如何安装配置Hive on Sp ...

- Spark踩坑记——数据库(Hbase+Mysql)

[TOC] 前言 在使用Spark Streaming的过程中对于计算产生结果的进行持久化时,我们往往需要操作数据库,去统计或者改变一些值.最近一个实时消费者处理任务,在使用spark streami ...

- Spark踩坑记——初试

[TOC] Spark简介 整体认识 Apache Spark是一个围绕速度.易用性和复杂分析构建的大数据处理框架.最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apach ...

- Spark读写Hbase的二种方式对比

作者:Syn良子 出处:http://www.cnblogs.com/cssdongl 转载请注明出处 一.传统方式 这种方式就是常用的TableInputFormat和TableOutputForm ...

- (资源整理)带你入门Spark

一.Spark简介: 以下是百度百科对Spark的介绍: Spark 是一种与 Hadoop 相似的开源集群计算环境,但是两者之间还存在一些不同之处,这些有用的不同之处使 Spark 在某些工作负载方 ...

- Spark的StandAlone模式原理和安装、Spark-on-YARN的理解

Spark是一个内存迭代式运算框架,通过RDD来描述数据从哪里来,数据用那个算子计算,计算完的数据保存到哪里,RDD之间的依赖关系.他只是一个运算框架,和storm一样只做运算,不做存储. Spark ...

- (一)Spark简介-Java&Python版Spark

Spark简介 视频教程: 1.优酷 2.YouTube 简介: Spark是加州大学伯克利分校AMP实验室,开发的通用内存并行计算框架.Spark在2013年6月进入Apache成为孵化项目,8个月 ...

随机推荐

- sql面试-查询选修课程的学生

首先: 1 . EXISTS 子查询找到的提交 NOT EXISTS 子查询中 找不到的提交 说明:不要去翻译为存在和不存在,把脑袋搞晕. 2 . 建立程序循环的概念,这是一个动态的查询过程.如 F ...

- map函数原理

# -*- coding: utf-8 -*- #python 27 #xiaodeng #map函数 #map函数会对一个序列对象中的每一个元素应用被传入的函数,并返回一个包含了所有函数调用结果的一 ...

- jQuery ajax - ajax() 方法详解

一些代码通过jQuery来做ajax异步提交. //验证昵称是否存在 function checkNickNameIsExist(){ var nickName = jQuery("#nic ...

- shell之“>/dev/null 2>&1”

shell之“>/dev/null 2>&1” http://ixdba.blog.51cto.com/2895551/526442 今天在自己的一个技术群中又被问道了这么一个问题 ...

- 图文例解C++类的多重继承与虚拟继承

文章导读:C++允许为一个派生类指定多个基类,这样的继承结构被称做多重继承. 在过去的学习中,我们始终接触的单个类的继承,但是在现实生活中,一些新事物往往会拥有两个或者两个以上事物的属性,为了解决这个 ...

- 微信小程序用户数据解密

概述 通过微信web开发者工具创建登录,获取用户信息,发送至后台,进行用户数据解密 详细 代码下载:http://www.demodashi.com/demo/10705.html 一.准备工作 1. ...

- Openstack网络相关概念比较复杂,经常使人混淆,本文进行相关说明。

Openstack网络相关概念比较复杂,经常使人混淆,本文进行相关说明. 文中相关术语与缩写 英文 缩写 中文 Virtual Local Area Network VLAN 虚拟局域网 Virtua ...

- (原)Ubuntu16中安装nvidia的显卡驱动

转载请注明出处: http://www.cnblogs.com/darkknightzh/p/5638185.html part1 直接在“软件和更新-附加驱动”里面设置 安装完ubuntu16后,显 ...

- 【LeetCode】144. Binary Tree Preorder Traversal (3 solutions)

Binary Tree Preorder Traversal Given a binary tree, return the preorder traversal of its nodes' valu ...

- windows服务器开启openssl

windows服务器默认是没有开启openss的php扩展支持,不过一般服务器里面默认都已经安装了这个功能.自己开启一下就好,今天在安装某程序的时候,需要用到openss的支持,才发现windows服 ...