Trident继承kafka

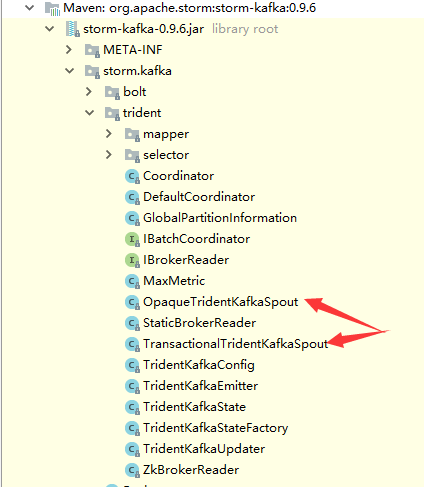

1.Kafka涉及的类

上一个类是不透明事务

后一个是完全事务

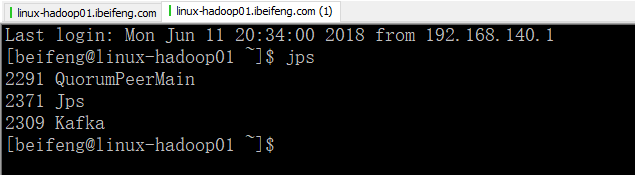

2.启动服务

3..驱动类

重要的地方是修改了两个部分:

1.数据的来源是kafka

2.第二个是字段的Fields是str

package com.jun.tridentWithKafka; import backtype.storm.Config;

import backtype.storm.LocalCluster;

import backtype.storm.StormSubmitter;

import backtype.storm.generated.AlreadyAliveException;

import backtype.storm.generated.InvalidTopologyException;

import backtype.storm.spout.SchemeAsMultiScheme;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Values;

import storm.kafka.BrokerHosts;

import storm.kafka.StringScheme;

import storm.kafka.ZkHosts;

import storm.kafka.trident.OpaqueTridentKafkaSpout;

import storm.kafka.trident.TridentKafkaConfig;

import storm.trident.Stream;

import storm.trident.TridentState;

import storm.trident.TridentTopology;

import storm.trident.operation.builtin.Count;

import storm.trident.operation.builtin.Sum;

import storm.trident.testing.FixedBatchSpout;

import storm.trident.testing.MemoryMapState; public class TridentWithKafka {

public static void main(String[] args) throws AlreadyAliveException, InvalidTopologyException {

TridentTopology tridentTopology=new TridentTopology();

//使用Kafka中的数据

BrokerHosts hosts = new ZkHosts("linux-hadoop01.ibeifeng.com:2181");

String topic = "nginxlog";

TridentKafkaConfig conf = new TridentKafkaConfig(hosts, topic); conf.scheme = new SchemeAsMultiScheme(new StringScheme());

conf.forceFromStart = true; OpaqueTridentKafkaSpout spout = new OpaqueTridentKafkaSpout(conf); //流处理

Stream stream=tridentTopology.newStream("orderAnalyse",spout)

//过滤

.each(new Fields("str"),new ValidLogFilter())

//解析

.each(new Fields("str"), new LogParserFunction(),new Fields("orderId","orderTime","orderAmtStr","memberId"))

//投影

.project(new Fields("orderId","orderTime","orderAmtStr","memberId"))

//时间解析

.each(new Fields("orderTime"),new DateTransFormerFunction(),new Fields("day","hour","minter"))

;

//分流

//1.基于minter统计订单数量,分组统计

TridentState state=stream.groupBy(new Fields("minter"))

//全局聚合,使用内存存储状态信息

.persistentAggregate(new MemoryMapState.Factory(),new Count(),new Fields("orderNumByMinter"));

// state.newValuesStream().each(new Fields("minter","orderNumByMinter"),new PrintFilter()); //2.另一个流,基于分钟的订单金额,局部聚合

Stream partitionStream=stream.each(new Fields("orderAmtStr"),new TransforAmtToDoubleFunction(),new Fields("orderAmt"))

.groupBy(new Fields("minter"))

//局部聚合

.chainedAgg() //聚合链

.partitionAggregate(new Fields("orderAmt"),new LocalSum(),new Fields("orderAmtSumOfLocal"))

.chainEnd(); //聚合链

// partitionStream.each(new Fields("minter","orderAmtSumOfLocal"),new PrintFilter());

//做一次全局聚合

TridentState partitionState=partitionStream.groupBy(new Fields("minter"))

//全局聚合

.persistentAggregate(new MemoryMapState.Factory(),new Fields("orderAmtSumOfLocal"),new Sum(),new Fields("totalOrderAmt"));

partitionState.newValuesStream().each(new Fields("minter","totalOrderAmt"),new PrintFilter()); //提交

Config config=new Config();

if(args==null || args.length<=0){

LocalCluster localCluster=new LocalCluster();

localCluster.submitTopology("tridentDemo",config,tridentTopology.build());

}else {

config.setNumWorkers(2);

StormSubmitter.submitTopology(args[0],config,tridentTopology.build());

}

}

}

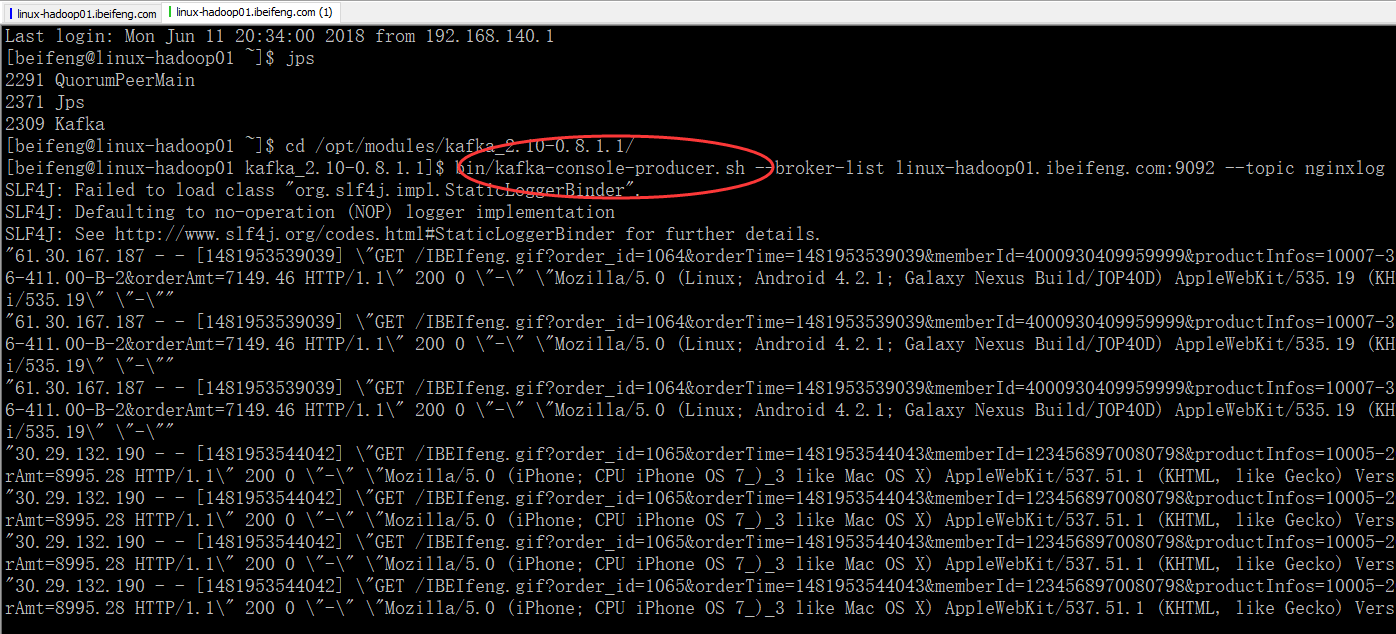

4.输入数据

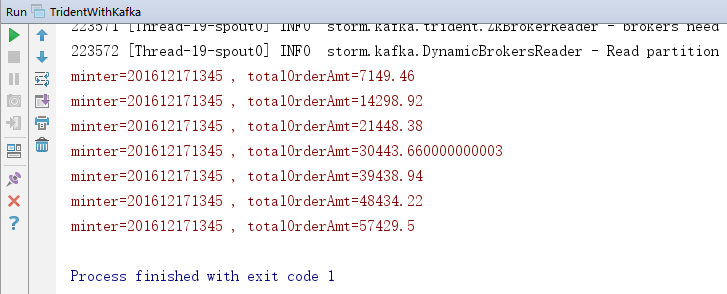

5.控制台

Trident继承kafka的更多相关文章

- Trident整合Kafka

首先编写一个打印函数KafkaPrintFunction import org.apache.storm.trident.operation.BaseFunction; import org.apac ...

- Java操作Kafka执行不成功的解决方法,Kafka Broker Advertised.Listeners属性的设置

创建Spring Boot项目继承Kafka,向Kafka发送消息始终不成功.具体项目配置如下: <?xml version="1.0" encoding="UTF ...

- storm-kafka教程

一.原理介绍 本文内容参考:https://github.com/apache/storm/tree/master/external/storm-kafka#brokerhosts (一)使用st ...

- storm-kafka编程指南

目录 storm-kafka编程指南 一.原理及关键步骤介绍 (一)使用storm-kafka的关键步骤 1.创建ZkHosts 2.创建KafkaConfig 3.设置MultiScheme 4.创 ...

- Apache Storm

作者:jiangzz 电话:15652034180 微信:jiangzz_wx 微信公众账号:jiangzz_wy 背景介绍 流计算:将大规模流动数据在不断变化的运动过程中实现数据的实时分析,捕捉到可 ...

- 认识Linux文件系统的架构

本文主要研究一下storm的OpaquePartitionedTridentSpoutExecutor TridentTopology.newStream storm-core-1.2.2-sourc ...

- Storm集成Kafka的Trident实现

原本打算将storm直接与flume直连,发现相应组件支持比较弱,topology任务对应的supervisor也不一定在哪个节点上,只能采用统一的分布式消息服务Kafka. 原本打算将结构设 ...

- 学好Spark/Kafka必须要掌握的Scala技术点(二)类、单例/伴生对象、继承和trait,模式匹配、样例类(case class)

3. 类.对象.继承和trait 3.1 类 3.1.1 类的定义 Scala中,可以在类中定义类.以在函数中定义函数.可以在类中定义object:可以在函数中定义类,类成员的缺省访问级别是:publ ...

- Flume+Kafka+Storm+Redis 大数据在线实时分析

1.实时处理框架 即从上面的架构中我们可以看出,其由下面的几部分构成: Flume集群 Kafka集群 Storm集群 从构建实时处理系统的角度出发,我们需要做的是,如何让数据在各个不同的集群系统之间 ...

随机推荐

- 洛谷P4451 [国家集训队]整数的lqp拆分 [生成函数]

传送门 题意简述:语文不好不会写,自己看吧 思路如此精妙,代码如此简洁,实是锻炼思维水经验之好题 这种题当然是一眼DP啦. 设\(dp_n\)为把\(n\)拆分后的答案.为了方便我们设\(dp_0=1 ...

- thinkphp (tcms)

使用的是:3.2.3模板: js获取thinkphp数组时:var obj = {:json_encode($obj)}: 转成js对象:进而再处理: 创建公共控制器: thinkphp:ajax返回 ...

- Confluence 6 查看空间活动

空间活动信息是默认禁用(disabled by default)的.活动(Activity)的标没有显示,如果你的 Confluence Usage Stats 插件没有启用的.请查看下面的说明: ...

- Allegro PCB Design GXL (legacy) 使用slide无法将走线推挤到焊盘的原因

Allegro PCB Design GXL (legacy) version 16.6-2015 启用slide命令之后,单击鼠标右键,取消“Enhanced Pad Entry”即可.

- easyui组件window拖动时超过浏览器顶部则无法拖回

项目研发过程中遇到一个问题,easyui的window可以随意拖动或者放大缩小,但是鼠标只有放在“header”上面时鼠标箭头才会变成四个方向的箭头,也就是只有在这时才能拖动窗口:但是当拖动的窗口超过 ...

- python修改hosts

#coding=utf-8 host = ['192.168.10.240 store.wondershare.com', '192.168.10.240 store.wondershare.jp', ...

- Django复习

django复习 django和其他框架的对比 django,集成很多功能的大型框架,为开发者提供了很多方便的组件:orm.form.ModelForm.auth.admin.contenttypes ...

- C++ Primer 笔记——函数

1.函数内的局部静态对象在程序的执行路径第一次经过对象定义语句的时候初始化,并且直到程序终止才被销毁,在此期间即使对象所在的函数结束执行也不会对它有影响. size_t get_count() { ; ...

- C++设计模式——单例模式(转)

问题描述 现在,不管开发一个多大的系统(至少我现在的部门是这样的),都会带一个日志功能:在实际开发过程中,会专门有一个日志模块,负责写日志,由于在系统的任何地方,我们都有可能要调用日志模块中的函数,进 ...

- 没有-jackson相关依赖会抛出如下异常--------在spring官方文档有解释

<!--jackson相关依赖--><!-- https://mvnrepository.com/artifact/com.fasterxml.jackson.core/jackso ...