Kafka工作原理解析以及主要配置详解

Apache Kafka常用配置

作者:尹正杰

版权声明:原创作品,谢绝转载!否则将追究法律责任。

一.Broker配置信息

|

属性 |

默认值 |

描述 |

|

broker.id |

必填参数,broker的唯一标识 |

|

|

log.dirs |

/tmp/kafka-logs |

Kafka数据存放的目录。可以指定多个目录,中间用逗号分隔,当新partition被创建的时会被存放到当前存放partition最少的目录。换句话说,多个目录分布在不同磁盘上可以提高读写性能。 |

|

port |

9092 |

BrokerServer接受客户端连接的端口号 |

|

zookeeper.connect |

null |

Zookeeper的连接串,格式为:hostname1:port1,hostname2:port2,hostname3:port3。可以填一个或多个,为了提高可靠性,建议都填上。注意,此配置允许我们指定一个zookeeper路径来存放此kafka集群的所有数据,为了与其他应用集群区分开,建议在此配置中指定本集群存放目录,格式为:hostname1:port1,hostname2:port2,hostname3:port3/chroot/path 。需要注意的是,消费者的参数要和此参数一致。 |

|

message.max.bytes |

1000000 |

服务器可以接收到的最大的消息大小。注意此参数要和consumer的maximum.message.size大小一致,否则会因为生产者生产的消息太大导致消费者无法消费。 |

|

num.io.threads |

8 |

服务器用来执行读写请求的IO线程数,此参数的数量至少要等于服务器上磁盘的数量。 |

|

queued.max.requests |

500 |

I/O线程可以处理请求的队列大小,若实际请求数超过此大小,网络线程将停止接收新的请求。 |

|

socket.send.buffer.bytes |

100 * 1024 |

The SO_SNDBUFF buffer the server prefers for socket connections. |

|

socket.receive.buffer.bytes |

100 * 1024 |

The SO_RCVBUFF buffer the server prefers for socket connections. |

|

socket.request.max.bytes |

100 * 1024 * 1024 |

服务器允许请求的最大值, 用来防止内存溢出,其值应该小于 Java heap size. |

|

num.partitions |

1 |

默认partition数量,如果topic在创建时没有指定partition数量,默认使用此值,建议改为5 |

|

log.segment.bytes |

1024 * 1024 * 1024 |

Segment文件的大小,超过此值将会自动新建一个segment,此值可以被topic级别的参数覆盖。 |

|

log.roll.{ms,hours} |

24 * 7 hours |

新建segment文件的时间,此值可以被topic级别的参数覆盖。 |

|

log.retention.{ms,minutes,hours} |

7 days |

Kafka segment log的保存周期,保存周期超过此时间日志就会被删除。此参数可以被topic级别参数覆盖。数据量大时,建议减小此值。 |

|

log.retention.bytes |

-1 |

每个partition的最大容量,若数据量超过此值,partition数据将会被删除。注意这个参数控制的是每个partition而不是topic。此参数可以被log级别参数覆盖。 |

|

log.retention.check.interval.ms |

5 minutes |

删除策略的检查周期 |

|

auto.create.topics.enable |

true |

自动创建topic参数,建议此值设置为false,严格控制topic管理,防止生产者错写topic。 |

|

default.replication.factor |

1 |

默认副本数量,建议改为2。 |

|

replica.lag.time.max.ms |

10000 |

在此窗口时间内没有收到follower的fetch请求,leader会将其从ISR(in-sync replicas)中移除。 |

|

replica.lag.max.messages |

4000 |

如果replica节点落后leader节点此值大小的消息数量,leader节点就会将其从ISR中移除。 |

|

replica.socket.timeout.ms |

30 * 1000 |

replica向leader发送请求的超时时间。 |

|

replica.socket.receive.buffer.bytes |

64 * 1024 |

套接字接收缓冲器,用于网络对领导者的复制数据请求。 |

|

replica.fetch.max.bytes |

1024 * 1024 |

尝试获取每个分区中的消息的Bayes请求副本发送给领导者。 |

|

replica.fetch.wait.max.ms |

500 |

将数据发送到领导的等待时间的最大时间,在由副本发送给领导者的获取请求中。 |

|

num.replica.fetchers |

1 |

用于复制来自领导者的消息的线程数。增加这个值可以增加跟随代理的I/O并行度。 |

|

fetch.purgatory.purge.interval.requests |

1000 |

取回请求炼狱的清除间隔(请求次数)。 |

|

zookeeper.session.timeout.ms |

6000 |

ZooKeeper session 超时时间。如果在此时间内server没有向zookeeper发送心跳,zookeeper就会认为此节点已挂掉。 此值太低导致节点容易被标记死亡;若太高,.会导致太迟发现节点死亡。 |

|

zookeeper.connection.timeout.ms |

6000 |

客户端连接zookeeper的超时时间。 |

|

zookeeper.sync.time.ms |

2000 |

H ZK follower落后 ZK leader的时间。 |

|

controlled.shutdown.enable |

true |

允许broker shutdown。如果启用,broker在关闭自己之前会把它上面的所有leaders转移到其它brokers上,建议启用,增加集群稳定性。 |

|

auto.leader.rebalance.enable |

true |

如果启用此功能,则控制器将自动尝试通过周期性地将领导力返回到每个分区的“首选”副本(如果可用)来平衡代理之间的分区领导。 |

|

leader.imbalance.per.broker.percentage |

10 |

每个经纪人的领导失衡比例。如果该比率高于经纪人的配置价值,则控制器将重新平衡领导地位。 |

|

leader.imbalance.check.interval.seconds |

300 |

检查领导者不平衡的频率。 |

|

offset.metadata.max.bytes |

4096 |

允许客户端以其偏移量保存的最大元数据量。 |

|

connections.max.idle.ms |

600000 |

空闲连接超时:服务器套接字处理器线程关闭比此更空闲的连接。 |

|

num.recovery.threads.per.data.dir |

1 |

启动时日志恢复和关闭时刷新的每个数据目录的线程数。 |

|

unclean.leader.election.enable |

true |

指示是否启用ISR集合中未启用的副本作为最后手段被选为领导者,即使这样做可能导致数据丢失。 |

|

delete.topic.enable |

false |

启用deletetopic参数,建议设置为true。 |

|

offsets.topic.num.partitions |

50 |

偏移提交主题的分区数。由于部署后更改此项目前不受支持,因此建议使用更高的设置来进行生产(例如100-200) |

|

offsets.topic.retention.minutes |

1440 |

年龄大于此年龄的偏移将被标记为删除。当日志清洁器压缩偏移主题时,实际清除将发生 |

|

offsets.retention.check.interval.ms |

600000 |

偏移管理器检查过时偏移的频率。 |

|

offsets.topic.replication.factor |

3 |

偏移提交主题的复制因子。为了确保更高的可用性,推荐更高的设置(例如,三或四)。如果偏移主题是在代理少于复制因子时创建的,那么将用较少的副本创建偏移主题。 |

|

offsets.topic.segment.bytes |

104857600 |

偏移量主题的段大小。由于它使用了压缩的主题,因此应保持相对较低,以便于更快的日志压缩和加载。 |

|

offsets.load.buffer.size |

5242880 |

当一个代理成为一组使用者组的偏移管理器时(即,当它成为偏移主题分区的领导时),就会发生偏移负载。此设置对应于在将偏移加载到偏移管理器的缓存中时从偏移片段读取时要使用的批处理大小(以字节为单位)。 |

|

offsets.commit.required.acks |

-1 |

可以接受偏移提交之前所需的确认数。这类似于生产者的确认设置。一般来说,默认值不应该被重写。 |

|

offsets.commit.timeout.ms |

5000 |

偏移提交将被延迟,直到该超时或所需副本数已接收到偏移提交。这类似于生产者请求超时。 |

二.Producer配置信息

|

属性 |

默认值 |

描述 |

|

metadata.broker.list |

启动时producer查询brokers的列表,可以是集群中所有brokers的一个子集。注意,这个参数只是用来获取topic的元信息用,producer会从元信息中挑选合适的broker并与之建立socket连接。格式是:host1:port1,host2:port2。 |

|

|

request.required.acks |

0 |

0:这意味着生产者producer不等待来自broker同步完成的确认继续发送下一条(批)消息。此选项提供最低的延迟但最弱的耐久性保证(当服务器发生故障时某些数据会丢失,如leader已死,但producer并不知情,发出去的信息broker就收不到)。 1:这意味着producer在leader已成功收到的数据并得到确认后发送下一条message。此选项提供了更好的耐久性为客户等待服务器确认请求成功(被写入死亡leader但尚未复制将失去了唯一的消息)。 -1:这意味着producer在follower副本确认接收到数据后才算一次发送完成。 此选项提供最好的耐久性,我们保证没有信息将丢失,只要至少一个同步副本保持存活。 三种机制,性能依次递减 (producer吞吐量降低),数据健壮性则依次递增。 |

|

request.timeout.ms |

10000 |

Broker等待ack的超时时间,若等待时间超过此值,会返回客户端错误信息。 |

|

producer.type |

sync |

同步异步模式。async表示异步,sync表示同步。如果设置成异步模式,可以允许生产者以batch的形式push数据,这样会极大的提高broker性能,推荐设置为异步。 |

|

serializer.class |

kafka.serializer.DefaultEncoder |

序列号类,.默认序列化成 byte[] 。 |

|

key.serializer.class |

Key的序列化类,默认同上。 |

|

|

partitioner.class |

kafka.producer.DefaultPartitioner |

Partition类,默认对key进行hash。 |

|

compression.codec |

none |

指定producer消息的压缩格式,可选参数为: “none”, “gzip” and “snappy”。 |

|

compressed.topics |

null |

启用压缩的topic名称。若上面参数选择了一个压缩格式,那么压缩仅对本参数指定的topic有效,若本参数为空,则对所有topic有效。 |

|

message.send.max.retries |

3 |

Producer发送失败时重试次数。若网络出现问题,可能会导致不断重试。 |

|

retry.backoff.ms |

100 |

在每次重试之前,制作人刷新相关主题的元数据以查看是否已经选出新的领导者。由于领导者选举需要一些时间,因此此属性指定生产者在刷新元数据之前等待的时间量。 |

|

topic.metadata.refresh.interval.ms |

600 * 1000 |

当出现故障(分区丢失,领导不可用……)时,生产者通常刷新来自代理的主题元数据。它也会定期轮询(默认值:每10分钟6 000毫秒)。如果将此设置为负值,元数据只会在故障时刷新。如果将此设置为零,则在发送的每个消息(不推荐)之后,元数据将被刷新。重要提示:刷新只在发送消息之后进行,所以如果生产者从不发送消息,则元数据永远不会被刷新 |

|

queue.buffering.max.ms |

5000 |

启用异步模式时,producer缓存消息的时间。比如我们设置成1000时,它会缓存1秒的数据再一次发送出去,这样可以极大的增加broker吞吐量,但也会造成时效性的降低。 |

|

queue.buffering.max.messages |

10000 |

采用异步模式时producer buffer 队列里最大缓存的消息数量,如果超过这个数值,producer就会阻塞或者丢掉消息。 |

|

queue.enqueue.timeout.ms |

-1 |

当达到上面参数值时producer阻塞等待的时间。如果值设置为0,buffer队列满时producer不会阻塞,消息直接被丢掉。若值设置为-1,producer会被阻塞,不会丢消息。 |

|

batch.num.messages |

200 |

采用异步模式时,一个batch缓存的消息数量。达到这个数量值时producer才会发送消息。 |

|

send.buffer.bytes |

100 * 1024 |

Socket write buffer size |

|

client.id |

“” |

客户端ID是在每个请求中发送的帮助用户跟踪调用的用户指定字符串。它应该在逻辑上识别请求的应用程序 |

三.Consumer配置信息

|

属性 |

默认值 |

描述 |

|

group.id |

Consumer的组ID,相同goup.id的consumer属于同一个组。 |

|

|

zookeeper.connect |

Consumer的zookeeper连接串,要和broker的配置一致。 |

|

|

consumer.id |

null |

如果不设置会自动生成。 |

|

socket.timeout.ms |

30 * 1000 |

网络请求的socket超时时间。实际超时时间由max.fetch.wait + socket.timeout.ms 确定。 |

|

socket.receive.buffer.bytes |

64 * 1024 |

The socket receive buffer for network requests. |

|

fetch.message.max.bytes |

1024 * 1024 |

查询topic-partition时允许的最大消息大小。consumer会为每个partition缓存此大小的消息到内存,因此,这个参数可以控制consumer的内存使用量。这个值应该至少比server允许的最大消息大小大,以免producer发送的消息大于consumer允许的消息。 |

|

num.consumer.fetchers |

1 |

The number fetcher threads used to fetch data. |

|

auto.commit.enable |

true |

如果此值设置为true,consumer会周期性的把当前消费的offset值保存到zookeeper。当consumer失败重启之后将会使用此值作为新开始消费的值。 |

|

auto.commit.interval.ms |

60 * 1000 |

Consumer提交offset值到zookeeper的周期。 |

|

queued.max.message.chunks |

2 |

用来被consumer消费的message chunks 数量, 每个chunk可以缓存fetch.message.max.bytes大小的数据量。 |

|

auto.commit.interval.ms |

60 * 1000 |

Consumer提交offset值到zookeeper的周期。 |

|

queued.max.message.chunks |

2 |

用来被consumer消费的message chunks 数量, 每个chunk可以缓存fetch.message.max.bytes大小的数据量。 |

|

fetch.min.bytes |

1 |

服务器为获取请求返回的最小数据量。如果可用的数据不足,请求将等待大量的数据在回答请求之前累积。 |

|

fetch.wait.max.ms |

100 |

如果没有足够的数据立即满足fetch.min.bytes,服务器在回答获取请求之前将阻塞的最大时间。 |

|

rebalance.backoff.ms |

2000 |

再平衡期间重试的退避时间。 |

|

refresh.leader.backoff.ms |

200 |

在试图确定刚刚失去它的首领的分区的首领之前等待退避时间。 |

|

auto.offset.reset |

largest |

当ZooKeeper中没有初始偏移量或偏移量超出范围时该怎么做;最小:自动将偏移量重置为最小偏移;最大:自动将偏移量重置为最大偏移;其他任何事情:向使用者抛出异常; |

|

consumer.timeout.ms |

-1 |

若在指定时间内没有消息消费,consumer将会抛出异常。 |

|

exclude.internal.topics |

true |

来自内部主题(如偏移)的消息是否应该暴露给消费者。 |

|

zookeeper.session.timeout.ms |

6000 |

zookeeper会话超时。如果消费者在这段时间内没有向饲养员心跳,则被认为是死亡的,并且会发生再平衡。 |

|

zookeeper.connection.timeout.ms |

6000 |

客户端在向动物管理员建立连接时等待的最大时间。 |

|

zookeeper.sync.time.ms |

2000 |

ZK追随者能在ZK领导下走多远 |

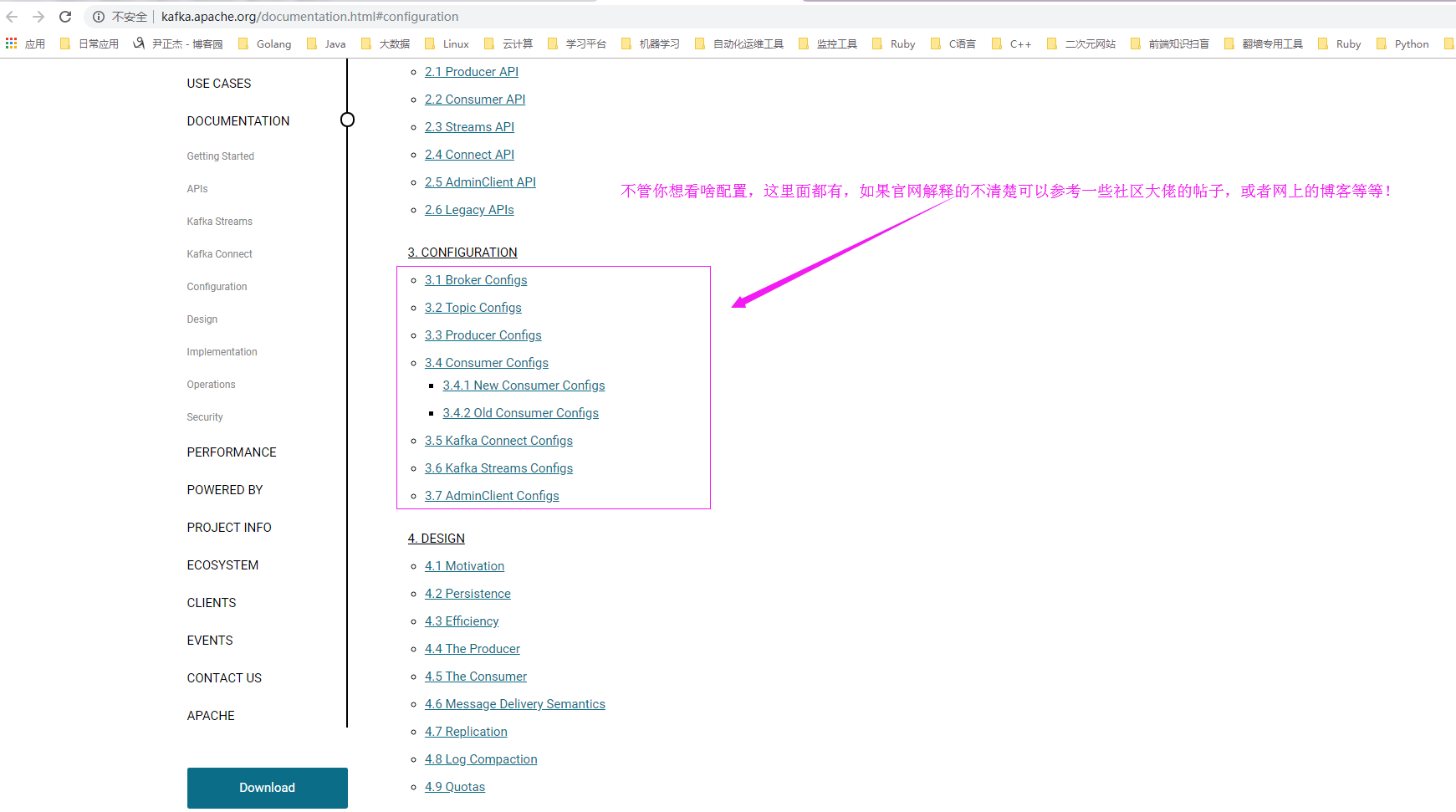

四.kafka最新版本的配置参数

其实上述参数只是目前来说我们可能会用到一些部分参数举例,随着Kafka版本的升级变更(截止2018-09-15日,发布最新的kafka版本是2018-07-28日发布的kafka-2.0.0),有的参数消失,也有的参数被加入进来,而传承下来的参数一般都不太会修改既定的默认值,参数可能会有略微的调整,详情请参考官网链接:http://kafka.apache.org/documentation.html#configuration。

五.Kafka 0.10.2.0生产环境配置

[root@kafka116.yinzhengjie.org.cn ~]# cat /soft/kafka/config/server.properties

# Licensed to the Apache Software Foundation (ASF) under one or more

# contributor license agreements. See the NOTICE file distributed with

# this work for additional information regarding copyright ownership.

# The ASF licenses this file to You under the Apache License, Version 2.0

# (the "License"); you may not use this file except in compliance with

# the License. You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License. # see kafka.server.KafkaConfig for additional details and defaults ############################# Server Basics ############################# #每一个broker在集群中的唯一表示,要求是正数。当该服务器的IP地址发生改变时,broker.id没有变化,则不会影响consumers的消息情况

broker.id= #这就是说,这条命令其实并不执行删除动作,仅仅是在zookeeper上标记该topic要被删除而已,同时也提醒用户一定要提前打开delete.topic.enable开关,否则删除动作是不会执行的。

delete.topic.enable=true #是否允许自动创建topic,若是false,就需要通过命令创建topic

auto.create.topics.enable=false ############################# Socket Server Settings ############################# # The address the socket server listens on. It will get the value returned from

# java.net.InetAddress.getCanonicalHostName() if not configured.

# FORMAT:

# listeners = listener_name://host_name:port

# EXAMPLE:

# listeners = PLAINTEXT://your.host.name:9092 #Socket服务器侦听的地址。如果没有配置,它将获得从Java.NET.InAddio.GETCANONICALITHAMEMENE()返回的值

#listeners=PLAINTEXT://10.1.3.116:9092 #broker server服务端口

port= #broker的主机地址,若是设置了,那么会绑定到这个地址上,若是没有,会绑定到所有的接口上,并将其中之一发送到ZK,一般不设置

host.name=10.1.3.116

# Hostname and port the broker will advertise to producers and consumers. If not set,

# it uses the value for "listeners" if configured. Otherwise, it will use the value

# returned from java.net.InetAddress.getCanonicalHostName(). #kafka 0.9.x以后的版本新增了advertised.listeners配置,kafka 0.9.x以后的版本不要使用 advertised.host.name 和 advertised.host.port 已经deprecated.如果配置的话,它使用 "listeners" 的值。否则,它将使用从java.net.InetAddress.getCanonicalHostName()返回的值。

#advertised.listeners=PLAINTEXT://your.host.name:9092 #将侦听器(listener)名称映射到安全协议,默认情况下它们是相同的。有关详细信息,请参阅配置文档。

#listener.security.protocol.map=PLAINTEXT:PLAINTEXT,SSL:SSL,SASL_PLAINTEXT:SASL_PLAINTEXT,SASL_SSL:SASL_SSL #处理网络请求的最大线程数

num.network.threads= #处理磁盘I/O的线程数

num.io.threads= #套接字服务器使用的发送缓冲区(SOYSNDBUF)

socket.send.buffer.bytes= #套接字服务器使用的接收缓冲区(SOYRCVBUF)

socket.receive.buffer.bytes= #套接字服务器将接受的请求的最大大小(对OOM的保护)

socket.request.max.bytes= #I/O线程等待队列中的最大的请求数,超过这个数量,network线程就不会再接收一个新的请求。应该是一种自我保护机制。

queued.max.requests= ############################# Log Basics ############################# #日志存放目录,多个目录使用逗号分割,如果你有多块磁盘,建议配置成多个目录,从而达到I/O的效率的提升。

log.dirs=/home/yinzhengjie/kafka/logs #每个topic的分区个数,若是在topic创建时候没有指定的话会被topic创建时的指定参数覆盖

num.partitions= #在启动时恢复日志和关闭时刷盘日志时每个数据目录的线程的数量,默认1

num.recovery.threads.per.data.dir= # 默认副本数

default.replication.factor= #服务器接受单个消息的最大大小,即消息体的最大大小,单位是字节

message.max.bytes= # 自动负载均衡,如果设为true,复制控制器会周期性的自动尝试,为所有的broker的每个partition平衡leadership,为更优先(preferred)的replica分配leadership。

# auto.leader.rebalance.enable=false ############################# Log Flush Policy ############################# #在强制fsync一个partition的log文件之前暂存的消息数量。调低这个值会更频繁的sync数据到磁盘,影响性能。通常建议人家使用replication来确保持久性,而不是依靠单机上的fsync,但是这可以带来更多的可靠性,默认10000。

#log.flush.interval.messages= #2次fsync调用之间最大的时间间隔,单位为ms。即使log.flush.interval.messages没有达到,只要这个时间到了也需要调用fsync。默认3000ms.

#log.flush.interval.ms= ############################# Log Retention Policy ############################# # 日志保存时间 (hours|minutes),默认为7天(168小时)。超过这个时间会根据policy处理数据。bytes和minutes无论哪个先达到都会触发。

log.retention.hours= #日志数据存储的最大字节数。超过这个时间会根据policy处理数据。

#log.retention.bytes= #控制日志segment文件的大小,超出该大小则追加到一个新的日志segment文件中(-1表示没有限制)

log.segment.bytes= # 当达到下面时间,会强制新建一个segment

#log.roll.hours = * # 日志片段文件的检查周期,查看它们是否达到了删除策略的设置(log.retention.hours或log.retention.bytes)

log.retention.check.interval.ms= #是否开启压缩

#log.cleaner.enable=false #日志清理策略选择有:delete和compact主要针对过期数据的处理,或是日志文件达到限制的额度,会被 topic创建时的指定参数覆盖

#log.cleanup.policy=delete # 日志压缩运行的线程数

#log.cleaner.threads= # 压缩的日志保留的最长时间

#log.cleaner.delete.retention.ms= ############################# Zookeeper ############################# #zookeeper集群的地址,可以是多个,多个之间用逗号分割.

zookeeper.connect=10.1.3.117:,10.1.3.118:,10.1.3.119: #ZooKeeper的最大超时时间,就是心跳的间隔,若是没有反映,那么认为已经死了,不易过大

zookeeper.session.timeout.ms= #指定多久消费者更新offset到zookeeper中。注意offset更新时基于time而不是每次获得的消息。一旦在更新zookeeper发生异常并重启,将可能拿到已拿到过的消息,连接zk的超时时间

zookeeper.connection.timeout.ms= #请求的最大大小为字节,请求的最大字节数。这也是对最大记录尺寸的有效覆盖。注意:server具有自己对消息记录尺寸的覆盖,这些尺寸和这个设置不同。此项设置将会限制producer每次批量发送请求的数目,以防发出巨量的请求。

max.request.size= #每次fetch请求中,针对每次fetch消息的最大字节数。这些字节将会督导用于每个partition的内存中,因此,此设置将会控制consumer所使用的memory大小。这个fetch请求尺寸必须至少和server允许的最大消息尺寸相等,否则,producer可能发送的消息尺寸大于consumer所能消耗的尺寸

。fetch.message.max.bytes= #ZooKeeper集群中leader和follower之间的同步时间,换句话说:一个ZK follower能落后leader多久。

#zookeeper.sync.time.ms= ############################# Replica Basics ############################# # leader接收follower的"fetch请求"的超时时间,默认是10秒。

# replica.lag.time.max.ms= # 如果relicas落后太多,将会认为此partition relicas已经失效。而一般情况下,因为网络延迟等原因,总会导致replicas中消息同步滞后。如果消息严重滞后,leader将认为此relicas网络延迟较大或者消息吞吐能力有限。在broker数量较少,或者网络不足的环境中,建议提高此值.follower落

后于leader的最大message数,这个参数是broker全局的。设置太大 了,影响真正“落后”follower的移除;设置的太小了,导致follower的频繁进出。无法给定一个合适的replica.lag.max.messages的值,因此不推荐使用,据说新版本的Kafka移除了这个参数。#replica.lag.max.messages= # follower与leader之间的socket超时时间

#replica.socket.timeout.ms= # follower每次fetch数据的最大尺寸

replica.fetch.max.bytes= # follower的fetch请求超时重发时间

replica.fetch.wait.max.ms= # fetch的最小数据尺寸

#replica.fetch.min.bytes= #0.11..0版本开始unclean.leader.election.enable参数的默认值由原来的true改为false,可以关闭unclean leader election,也就是不在ISR(IN-Sync Replica)列表中的replica,不会被提升为新的leader partition。kafka集群的持久化力大于可用性,如果ISR中没有其它的replica,

会导致这个partition不能读写。unclean.leader.election.enable=false # follower中开启的fetcher线程数, 同步速度与系统负载均衡

num.replica.fetchers= # partition leader与replicas之间通讯时,socket的超时时间

#controller.socket.timeout.ms= # partition leader与replicas数据同步时,消息的队列尺寸.

#controller.message.queue.size= #指定将使用哪个版本的 inter-broker 协议。 在所有经纪人升级到新版本之后,这通常会受到冲击。升级时要设置

#inter.broker.protocol.version=0.10. #指定broker将用于将消息添加到日志文件的消息格式版本。 该值应该是有效的ApiVersion。 一些例子是:0.8.,0.9.0.0,0.10.。 通过设置特定的消息格式版本,用户保证磁盘上的所有现有消息都小于或等于指定的版本。 不正确地设置这个值将导致使用旧版本的用户出错,因为他们

将接收到他们不理解的格式的消息。

#log.message.format.version=0.10. [root@kafka116.yinzhengjie.org.cn ~]#

[root@kafka116.yinzhengjie.org.cn ~]#

[root@kafka116.yinzhengjie.org.cn ~]#

博主推荐阅读,不是给他们打广告,而是这些博主写的是真不错,指的我去学习(大家也可以一起跟着扫个忙):

推荐一:Kafka配置项unclean.leader.election.enable造成consumer出现offset重置现象(https://www.cnblogs.com/felixzh/p/9088787.html)

推荐二:Kafka参数图鉴——unclean.leader.election.enable(https://blog.csdn.net/u013256816/article/details/80790185)

推荐三:kafka各版本差异(https://www.aliyun.com/zixun/content/1_5_2002969.html)

Kafka工作原理解析以及主要配置详解的更多相关文章

- 大数据学习day11------hbase_day01----1. zk的监控机制,2动态感知服务上下线案例 3.HDFS-HA的高可用基本的工作原理 4. HDFS-HA的配置详解 5. HBASE(简介,安装,shell客户端,java客户端)

1. ZK的监控机制 1.1 监听数据的变化 (1)监听一次 public class ChangeDataWacher { public static void main(String[] arg ...

- 2018.10.7 理解Hibernate的工作原理及其中的ORM详解

复习 hibernate框架 简介j及其搭建: hibernate是一个开源框架,它是对象关联关系映射的框架,它对JDBC做了轻量级的封装,而我们java程序员可以使用面向对象的思想来操纵数据库. 1 ...

- ajax工作原理及jsonp跨域详解

一.Ajax简介 ajax = 异步 JavaScript 和 XML. ajax是一种在无需重新加载整个网页的情况下,能够更新部分网页的技术.我们知道,传统的网页(不使用ajax)如果需要更新内容, ...

- SpringMVC原理及非注解配置详解

1. Spring介绍 Spring MVC是Spring提供的一个强大而灵活的web框架.借助于注解,Spring MVC提供了几乎是POJO的开发模式,使得控制器的开发和测试更加简单. 这些控制器 ...

- kafka原理和实践(五)spring-kafka配置详解

系列目录 kafka原理和实践(一)原理:10分钟入门 kafka原理和实践(二)spring-kafka简单实践 kafka原理和实践(三)spring-kafka生产者源码 kafka原理和实践( ...

- Nginx 反向代理工作原理简介与配置详解

Nginx反向代理工作原理简介与配置详解 by:授客 QQ:1033553122 测试环境 CentOS 6.5-x86_64 nginx-1.10.0 下载地址:http://nginx. ...

- Spring学习 6- Spring MVC (Spring MVC原理及配置详解)

百度的面试官问:Web容器,Servlet容器,SpringMVC容器的区别: 我还写了个文章,说明web容器与servlet容器的联系,参考:servlet单实例多线程模式 这个文章有web容器与s ...

- 图解kafka - 设计原理解析

什么是消息队列? 简单来说,消息队列是存放消息的容器.客户端可以将消息发送到消息服务器,也可以从消息服务器获取消息. 问题导读: ********* 为什么需要消息系统? kafka架构? kafka ...

- 初学Kafka工作原理流程介绍

Apache kafka 工作原理介绍 消息队列技术是分布式应用间交换信息的一种技术.消息队列可驻留在内存或磁盘上, 队列存储消息直到它们被应用程序读走.通过消息队列,应用程序可独立地执行--它们不需 ...

随机推荐

- Python学习笔记 -- 第六章 文件操作

I/O编程 在磁盘上读写文件的功能都是由操作系统提供的,现代操作系统不允许普通的程序直接操作磁盘,所以,读写文件就是请求操作系统打开一个文件对象(通常称为文件描述符),然后,通过操作系统提供的接口从这 ...

- git心得与总结

任何文件在Git库中都有四种状态:未跟踪状态untracked.跟踪状态tracked(未修改状态unmodified.已修改状态modified.暂存状态staged),由于文件的上述四种状态,在使 ...

- 《面向对象程序设计》c++第五次作业___calculator plus plus

c++第五次作业 Calculator plusplus 代码传送门 PS:这次作业仍然orz感谢一位同学与一位学长的windows帮助,同时再次吐槽作业对Mac系统用户的不友好.(没朋友千万别用Ma ...

- Doors Breaking and Repairing CodeForces - 1102C (思维)

You are policeman and you are playing a game with Slavik. The game is turn-based and each turn consi ...

- MySQL基础~~增、删、改、简单查

mysql> desc demo; +-----------+------------+------+-----+---------+----------------+ | Field | Ty ...

- FileUtils功能概述

https://commons.apache.org/proper/commons-io/javadocs/api-release/org/apache/commons/io/FileUtils.ht ...

- MySQL乐观锁在分布式场景下的实践

背景 在电商购物的场景下,当我们点击购物时,后端服务就会对相应的商品进行减库存操作.在单实例部署的情况,我们可以简单地使用JVM提供的锁机制对减库存操作进行加锁,防止多个用户同时点击购买后导致的库存不 ...

- ADOTable的CancelUpdate和CancelBatch的区别?(100分)

出差新疆,修改别人的代码,请教CancelUpdate和CancelBatch的区别! 如果希望取消对当前记录所做的任何更改或者放弃新添加的记录,则必须调用CancelUpdate 方法CancelB ...

- ref、out与params

ref 把值传递转换为引用传递,侧重于将一个值带到函数中进行改变,再将改变后的值带出去,ref参数在函数外必须为ref参数赋值 ; AddSalary(ref salary); //如果不写ref,s ...

- BZOJ4551[Tjoi2016&Heoi2016]树——dfs序+线段树/树链剖分+线段树

题目描述 在2016年,佳媛姐姐刚刚学习了树,非常开心.现在他想解决这样一个问题:给定一颗有根树(根为1),有以下 两种操作:1. 标记操作:对某个结点打上标记(在最开始,只有结点1有标记,其他结点均 ...