Python爬虫实例(六)多进程下载金庸网小说

目标任务:使用多进程下载金庸网各个版本(旧版、修订版、新修版)的小说

代码如下:

# -*- coding: utf-8 -*-

import requests

from lxml import etree

from multiprocessing import Pool

import os

import sys

reload(sys)

sys.setdefaultencoding('utf-8') headers = {'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:47.0) Gecko/20100101 Firefox/47.0'} def download(title,url, filename):

response = requests.get(url, headers=headers).text

html = etree.HTML(response)

pages = html.xpath('//div//p/text()')[2:]

with open(filename, 'a') as f:

f.write(title+'\n')

for page in pages:

with open(filename, 'a') as f:

f.write(page+'\n') def main(url):

start_url = 'http://www.jinyongwang.com'+url

sname = start_url.split('/')[-2]

if sname.startswith('o'):

folder = 'old/'

if(not os.path.exists(folder)):

os.makedirs(folder)

elif sname.startswith('n'):

folder = 'new/'

if(not os.path.exists(folder)):

os.makedirs(folder)

else:

folder = 'now/'

if(not os.path.exists(folder)):

os.makedirs(folder)

filename = folder+sname+'.txt'

base_url = 'http://www.jinyongwang.com'

response = requests.get(start_url, headers=headers).text

html = etree.HTML(response)

urls = html.xpath('//ul[@class="mlist"]/li/a/@href')

titles = html.xpath('//ul[@class="mlist"]/li//text()')

for index,url in enumerate(urls):

full_url = base_url+url

title = titles[index]

download(title, full_url, filename) if __name__ == '__main__':

url01 = 'http://www.jinyongwang.com/'

response = requests.get(url01, headers=headers).text

html = etree.HTML(response)

urls = html.xpath('//li[@class="book_li"]/p[3]//a/@href')

pool = Pool()

pool.map(main,urls)

pool.close()

pool.join()

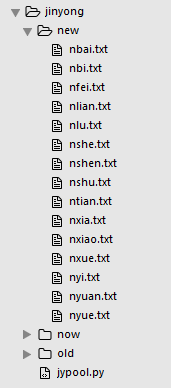

结果展示:

Python爬虫实例(六)多进程下载金庸网小说的更多相关文章

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实战六之抓取爱问知识人问题并保存至数据库

大家好,本次为大家带来的是抓取爱问知识人的问题并将问题和答案保存到数据库的方法,涉及的内容包括: Urllib的用法及异常处理 Beautiful Soup的简单应用 MySQLdb的基础用法 正则表 ...

- Python爬虫入门六之Cookie的使用

大家好哈,上一节我们研究了一下爬虫的异常处理问题,那么接下来我们一起来看一下Cookie的使用. 为什么要使用Cookie呢? Cookie,指某些网站为了辨别用户身份.进行session跟踪而储存在 ...

- Python 爬虫十六式 - 第七式:正则的艺术

RE:用匹配来演绎编程的艺术 学习一时爽,一直学习一直爽 Hello,大家好,我是 Connor,一个从无到有的技术小白.上一次我们说到了 pyquery 今天我们将迎来我们数据匹配部分的最后一位 ...

- Python 爬虫十六式 - 第一式:HTTP协议

HTTP:伟大而又无闻的协议 学习一时爽,一直学习一直爽! Hello,大家好啊,我是Connor,一个从无到有的技术小白.有的人一说什么是HTTP协议就犯愁,写东西的时候也没想过什么是HTTP协 ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- Python爬虫利器六之PyQuery的用法

前言 你是否觉得 XPath 的用法多少有点晦涩难记呢? 你是否觉得 BeautifulSoup 的语法多少有些悭吝难懂呢? 你是否甚至还在苦苦研究正则表达式却因为少些了一个点而抓狂呢? 你是否已经有 ...

- Python 爬虫十六式 - 第六式:JQuery的假兄弟-pyquery

PyQuery:一个类似jquery的python库 学习一时爽,一直学习一直爽 Hello,大家好,我是 Connor,一个从无到有的技术小白.上一次我们说到了 BeautifulSoup 美味 ...

随机推荐

- ios开发之--条用第三方地图路线导航

项目里面有位置功能,需要有导航,导航两种实现方式 (集成第三方SDK.URL跳转第三方应用) ,直接集成就不说,下面来说下通过url跳转, 最终效果如如下: 如果手机上安装的有客户端就展示,没有就不展 ...

- MinGW 是什么

3.1:MinGW 是什么? MinGW 提供了一套简单方便的Windows下的基于GCC 程序开发环境.MinGW 收集了一系列免费的Windows 使用的头文件和库文件:同时整合了GNU ( ht ...

- SSL延迟有多大 (Https)

据说,Netscape公司当年设计SSL协议的时候,有人提过,将互联网所有链接都变成HTTPs开头的加密链接. 这个建议没有得到采纳,原因之一是HTTPs链接比不加密的HTTP链接慢很多.(另一个原因 ...

- Robot Framework配置发送邮件功能

请参考:http://www.robotframework.net/?/article/118

- linux环境下执行RF测试脚本

1. 测试执行 测试管理平台需根据用户选中的测试案例,按照相应格式对执行启动命令进行组装和发送,触动案例的自动化测试执行. 命令格式根据测试模式(以项目为单位.以测试集为单位.以案例为单位)具有不同的 ...

- 深入浅出MongoDB应用实战开发

写在前面的话: 这篇文章会有点长,谨此记录自己昨天一整天看完<深入浅出MongoDB应用实战开发>视频时的笔记.只是在开始,得先抛出一个困扰自己很长时间的问题:“带双引号的和不带双引号的j ...

- 用js写留言信息的判断非空条件

首先在tp上有多种方法去判断留言是否为空,但是js是最方便也是最没有冲突的. <form action="{:U('validate')}" method="pos ...

- iPhone X的缺口和CSS

苹果公司(Apple)的发布会也开完了,新产品也将登陆了.估计很多开发人员看到iPhone X的设备是要崩溃了,特别对于前端开发人员更是如此. iPhone X的屏幕覆盖了整个手机的屏幕,为相机和其他 ...

- C# 中文日期 周几

//该语句显示的为英文格式 DateTime.Now.DayOfWeek.ToString(); //显示中文格式星期几 "星期" + DateTime.Now.ToString( ...

- 监控redis服务器执行的命令--类似于tomcat的local-access.log

一.问题由来 一般程序启动时会去拉必要的缓存存进去redis. 由于我们这边开发可直连开发和测试环境,有时候会发生,开发同学本地直连了测试环境,本地ide一启动,可能会导致重新覆盖了测试环境上的缓存. ...