cuda编程-并行规约

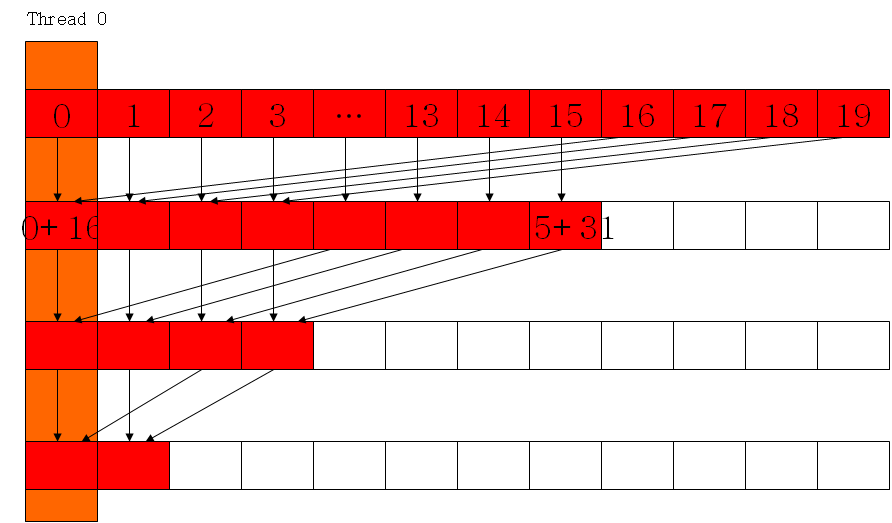

利用shared memory计算,并避免bank conflict;通过每个block内部规约,然后再把所有block的计算结果在CPU端累加

代码:

#include <cuda_runtime.h>

#include <device_launch_parameters.h>

#include <stdio.h>

#include <stdlib.h>

#include <memory>

#include <iostream> #define DATA_SIZE 128

#define TILE_SIZE 64 __global__ void reductionKernel(float *in, float *out){

int tx = threadIdx.x;

int bx = blockIdx.x; __shared__ float data_shm[TILE_SIZE];

data_shm[tx] = in[bx * blockDim.x + tx];

__syncthreads(); for (int i = blockDim.x / ; i > ; i >>= ){

if (tx < i){

data_shm[tx] += data_shm[tx + i];

}

__syncthreads();

} if (tx == )

out[bx] = data_shm[];

} void reduction(){

int out_size = (DATA_SIZE + TILE_SIZE - ) / TILE_SIZE;

float *in = (float*)malloc(DATA_SIZE * sizeof(float));

float *out = (float*)malloc(out_size*sizeof(float));

for (int i = ; i < DATA_SIZE; ++i){

in[i] = i;

}

memset(out, , out_size*sizeof(float)); float *d_in, *d_out;

cudaMalloc((void**)&d_in, DATA_SIZE * sizeof(float));

cudaMalloc((void**)&d_out, out_size*sizeof(float));

cudaMemcpy(d_in, in, DATA_SIZE * sizeof(float), cudaMemcpyHostToDevice); dim3 block(TILE_SIZE, );

dim3 grid(out_size, );

reductionKernel << <grid, block >> >(d_in, d_out); cudaMemcpy(in, d_in, DATA_SIZE * sizeof(float), cudaMemcpyDeviceToHost);

cudaMemcpy(out, d_out, out_size * sizeof(float), cudaMemcpyDeviceToHost); float sum = ;

for (int i = ; i < out_size; ++i){

sum += out[i];

}

std::cout << sum << std::endl; // Check on CPU

float sum_cpu = ;

for (int i = ; i < DATA_SIZE; ++i){

sum_cpu += in[i];

}

std::cout << sum_cpu << std::endl; }

cuda编程-并行规约的更多相关文章

- CUDA中并行规约(Parallel Reduction)的优化

转自: http://hackecho.com/2013/04/cuda-parallel-reduction/ Parallel Reduction是NVIDIA-CUDA自带的例子,也几乎是所有C ...

- 【Cuda编程】加法归约

目录 cuda编程并行归约 AtomicAdd调用出错 gpu cpu下时间计算 加法的归约 矩阵乘法 矩阵转置 统计数目 平方和求和 分块处理 线程相邻 多block计算 cuda编程并行归约 At ...

- CUDA编程(六)进一步并行

CUDA编程(六) 进一步并行 在之前我们使用Thread完毕了简单的并行加速,尽管我们的程序运行速度有了50甚至上百倍的提升,可是依据内存带宽来评估的话我们的程序还远远不够.在上一篇博客中给大家介绍 ...

- cuda编程基础

转自: http://blog.csdn.net/augusdi/article/details/12529247 CUDA编程模型 CUDA编程模型将CPU作为主机,GPU作为协处理器(co-pro ...

- CUDA学习笔记(一)——CUDA编程模型

转自:http://blog.sina.com.cn/s/blog_48b9e1f90100fm56.html CUDA的代码分成两部分,一部分在host(CPU)上运行,是普通的C代码:另一部分在d ...

- CUDA编程

目录: 1.什么是CUDA 2.为什么要用到CUDA 3.CUDA环境搭建 4.第一个CUDA程序 5. CUDA编程 5.1. 基本概念 5.2. 线程层次结构 5.3. 存储器层次结构 5.4. ...

- CUDA编程-(1)Tesla服务器Kepler架构和万年的HelloWorld

结合CUDA范例精解以及CUDA并行编程.由于正在学习CUDA,CUDA用的比较多,因此翻译一些个人认为重点的章节和句子,作为学习,程序将通过NVIDIA K40服务器得出结果.如果想通过本书进行CU ...

- CUDA编程模型

1. 典型的CUDA编程包括五个步骤: 分配GPU内存 从CPU内存中拷贝数据到GPU内存中 调用CUDA内核函数来完成指定的任务 将数据从GPU内存中拷贝回CPU内存中 释放GPU内存 *2. 数据 ...

- CUDA编程之快速入门

CUDA(Compute Unified Device Architecture)的中文全称为计算统一设备架构.做图像视觉领域的同学多多少少都会接触到CUDA,毕竟要做性能速度优化,CUDA是个很重要 ...

随机推荐

- 获取数值型数组中大于60的元素个数,给数值型数组中不足60分的加20分。(数组,for循环,if条件判断语句)

package com.Summer_0420.cn; /** * @author Summer * 获取数值型数组中大于60的元素个数 * 给数值型数组中不足60分的加20分 */ public c ...

- for或者while的标记循环

for或者while的标记循环 今天在写代码的时候,发现一个for循环前有一个字母,不知道这个是什么语法,后来查了一下,这个语法是用来实现标记循环的功能 这个是代码块 r:for(int rowNum ...

- Vscode的python配置(macOS)

_ 1. Vscode是一款开源的跨平台编辑器.默认情况下,vscode使用的语言为英文(en),以下步骤改为中文 打开vscode工具,使用快捷键组合[Cmd+Shift+p],在搜索框中输入“co ...

- ReactJs入门教程-精华版

原文地址:https://www.cnblogs.com/Leo_wl/p/4489197.html阅读目录 ReactJs入门教程-精华版 回到目录 ReactJs入门教程-精华版 现在最热门的前端 ...

- Intellij Idea 教程

Intellij Idea 教程 [涵盖安装.配置.常见问题&技巧.Maven.Git.Tomcat.快捷键.项目配置等] 目录 入门............................. ...

- Python全栈开发之路 【第八篇】:面向对象编程设计与开发(2)

一.继承与派生 什么是继承? 继承指的是类与类之间的关系,是一种什么是什么的关系,继承的功能之一就是用来解决代码重用问题. 继承是一种创建新的类的方式,在python中,新建的类可以继承一个或多个父类 ...

- anaconda 出现add 。。。进不去

找到.condarc 文件 C:\Users\leiyi内 把里面内容替换为 channels: - https://mirrors.tuna.tsinghua.edu.cn/anaconda/pk ...

- Form的is_valid校验规则及验证顺序

一.验证顺序 查看form下的源码了解顺序 BaseForm为基类,中间包含了is_valid校验方法 @html_safe class BaseForm: ......... self.is_b ...

- 异常:fatal: unable to access 'https://git.oschina.net/pcmpcs/library.git/': Could not resolve host

git fork项目时出现的异常. 原因: 我以前用的是ssh地址做的远程通信地址,而这次是用的是https,因为很久没用,所以忘记了以前是用ssh的了.解决方案一:复制ssh协议的地址,然后再关联 ...

- PHP安装pecl扩展--通用

虽然现在composer很流行,但是有时候,我们还是要安装pecl的扩展. pecl扩展可以在pecl.php.net中查看,想要什么扩展,可以去搜索,比如xdebug.siege.memcached ...