Trident中的DRPC实现

一:介绍

1.说明

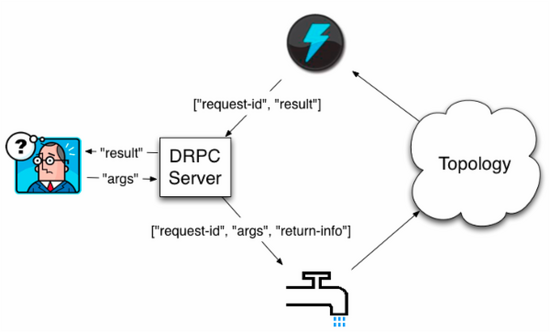

Storm里面引入DRPC主要是利用storm的实时计算能力来并行化CPU intensive的计算。DRPC的storm topology以函数的参数流作为输入,而把这些函数调用的返回值作为topology的输出流。

2.工作机制

Distributed RPC是由一个”DPRC Server”协调的(storm自带了一个实现)DRPC服务器协调

1) 接收一个RPC请求。

2) 发送请求到storm topology

3) 从storm topology接收结果。

4) 把结果发回给等待的客户端。从客户端的角度来看一个DRPC调用跟一个普通的RPC调用没有任何区别。

3.工作流程

客户端给DRPC服务器发送要执行的方法的名字,以及这个方法的参数。

实现了这个函数的topology使用 DRPCSpout 从DRPC服务器接收函数调用流。

每个函数调用被DRPC服务器标记了一个唯一的id。 这个topology然后计算结果,在topology的最后一个叫做 ReturnResults 的bolt会连接到DRPC服务器,并且把这个调用的结果发送给DRPC服务器(通过那个唯一的id标识)。DRPC服务器用那个唯一id来跟等待的客户端匹配上,唤醒这个客户端并且把结果发送给它。

二:本地DRPC

1.主驱动类

package com.jun.tridentWithHbase; import backtype.storm.Config;

import backtype.storm.LocalCluster;

import backtype.storm.LocalDRPC;

import backtype.storm.StormSubmitter;

import backtype.storm.generated.AlreadyAliveException;

import backtype.storm.generated.InvalidTopologyException;

import backtype.storm.tuple.Fields;

import backtype.storm.tuple.Values;

import org.apache.storm.hbase.trident.state.HBaseMapState;

import storm.trident.Stream;

import storm.trident.TridentState;

import storm.trident.TridentTopology;

import storm.trident.operation.builtin.Count;

import storm.trident.operation.builtin.MapGet;

import storm.trident.operation.builtin.Sum;

import storm.trident.state.OpaqueValue;

import storm.trident.state.StateFactory;

import storm.trident.testing.FixedBatchSpout;

import storm.trident.testing.MemoryMapState; public class TridentDemo {

public static void main(String[] args) throws AlreadyAliveException, InvalidTopologyException {

TridentTopology tridentTopology=new TridentTopology();

//模拟数据

Fields field=new Fields("log","flag");

FixedBatchSpout spout=new FixedBatchSpout(field,5,

new Values("168.214.187.214 - - [1481953616092] \"GET /view.php HTTP/1.1\" 200 0 \"http://cn.bing.com/search?q=spark mllib\" \"Mozilla/5.0 (Windows NT 6.1; rv:2.0.1) Gecko/20100101 Firefox/4.0.1\" \"-\"","A"),

new Values("168.187.202.202 - - [1481953537038] \"GET /IBEIfeng.gif?order_id=1063&orderTime=1481953537038&memberId=4000012340500607&productInfos=10005-2099.48-B-1|10004-1886.62-A-2|10001-961.99-A-1&orderAmt=6834.70 HTTP/1.1\" 200 0 \"-\" \"Mozilla/5.0 (compatible; MSIE 10.0; Windows NT 6.2;Tident/6.0)\" \"-\"","A"),

new Values("61.30.167.187 - - [1481953539039] \"GET /IBEIfeng.gif?order_id=1064&orderTime=1481953539039&memberId=4000930409959999&productInfos=10007-3329.13-B-1|10009-2607.71-B-1|10002-390.62-A-1|10006-411.00-B-2&orderAmt=7149.46 HTTP/1.1\" 200 0 \"-\" \"Mozilla/5.0 (Linux; Android 4.2.1; Galaxy Nexus Build/JOP40D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Mobile Safari/535.19\" \"-\"","A"),

new Values("30.29.132.190 - - [1481953544042] \"GET /IBEIfeng.gif?order_id=1065&orderTime=1481953544043&memberId=1234568970080798&productInfos=10005-2099.48-B-1|10001-3242.40-C-2|10006-411.00-B-1&orderAmt=8995.28 HTTP/1.1\" 200 0 \"-\" \"Mozilla/5.0 (iPhone; CPU iPhone OS 7_)_3 like Mac OS X) AppleWebKit/537.51.1 (KHTML, like Gecko) Version/7.0 Mobile/11B511 Safari/9537.53\" \"-\"","B"),

new Values("222.190.187.201 - - [1481953578068] \"GET /IBEIfeng.gif?order_id=1066&orderTime=1481953578068&memberId=3488586887970809&productInfos=10005-2099.48-B-1|10001-2774.16-C-2&orderAmt=7647.80 HTTP/1.1\" 200 0 \"-\" \"Mozilla/5.0 (Windows NT 6.1; rv:2.0.1) Gecko/20100101 Firefox/4.0.1\" \"-\"","B"),

new Values("72.202.43.53 - - [1481953579069] \"GET /IBEIfeng.gif?order_id=1067&orderTime=1481953579069&memberId=2084859896989877&productInfos=10007-3329.13-B-1|10001-961.99-A-2&orderAmt=5253.10 HTTP/1.1\" 200 0 \"-\" \"Mozilla/5.0 (Linux; Android 4.2.1; Galaxy Nexus Build/JOP40D) AppleWebKit/535.19 (KHTML, like Gecko) Chrome/18.0.1025.166 Mobile Safari/535.19\" \"-\"","B")

);

//多次循环

spout.setCycle(true);

//流处理

Stream stream=tridentTopology.newStream("orderAnalyse",spout)

//过滤

.each(new Fields("log"),new ValidLogFilter())

//解析

.each(new Fields("log"), new LogParserFunction(),new Fields("orderId","orderTime","orderAmtStr","memberId"))

//投影

.project(new Fields("orderId","orderTime","orderAmtStr","memberId"))

//时间解析

.each(new Fields("orderTime"),new DateTransFormerFunction(),new Fields("day","hour","minter"))

;

//分流

//1.基于minter统计订单数量,分组统计

TridentState state=stream.groupBy(new Fields("minter"))

//全局聚合,使用内存存储状态信息

.persistentAggregate(new MemoryMapState.Factory(),new Count(),new Fields("orderNumByMinter"));

// state.newValuesStream().each(new Fields("minter","orderNumByMinter"),new PrintFilter()); //2.另一个流,基于分钟的订单金额,局部聚合

Stream partitionStream=stream.each(new Fields("orderAmtStr"),new TransforAmtToDoubleFunction(),new Fields("orderAmt"))

.groupBy(new Fields("minter"))

//局部聚合

.chainedAgg() //聚合链

.partitionAggregate(new Fields("orderAmt"),new LocalSum(),new Fields("orderAmtSumOfLocal"))

.chainEnd(); //聚合链 //做一次全局聚合

TridentState partitionState=partitionStream.groupBy(new Fields("minter"))

//全局聚合

.persistentAggregate(new MemoryMapState.Factory(),new Fields("orderAmtSumOfLocal"),new Sum(),new Fields("totalOrderAmt"));

partitionState.newValuesStream().each(new Fields("minter","totalOrderAmt"),new PrintFilter()); //提交

Config config=new Config();

if(args==null || args.length<=0){

//应该是构建一个DRPC的服务器

LocalDRPC localDRPC=new LocalDRPC();

tridentTopology.newDRPCStream("orderDataServer",localDRPC)

//参数处理

.each(new Fields("args"),new RequestParamsParserFunction(),new Fields("date"))

//查询,重要的参数是上面的partitionState

.stateQuery(partitionState,new Fields("date"),new MapGet(),new Fields("totalAmtByMinter"))

//投影

.project(new Fields("date","totalAmtByMinter"));

//提交任务

LocalCluster localCluster=new LocalCluster();

localCluster.submitTopology("tridentDemo",config,tridentTopology.build());

//获取值

String jsonResult=localDRPC.execute("orderDataServer","201612171345 201612171345");

System.out.println("***"+jsonResult+"***"); }else {

config.setNumWorkers(2);

StormSubmitter.submitTopology(args[0],config,tridentTopology.build());

}

}

}

2.请求参数处理类

package com.jun.tridentWithHbase; import backtype.storm.tuple.Values;

import storm.trident.operation.Function;

import storm.trident.operation.TridentCollector;

import storm.trident.operation.TridentOperationContext;

import storm.trident.tuple.TridentTuple; import java.util.Map; public class RequestParamsParserFunction implements Function {

@Override

public void execute(TridentTuple tridentTuple, TridentCollector tridentCollector) {

String parameters=tridentTuple.getStringByField("args");

String[] params=parameters.split(" ");

for (String param:params){

tridentCollector.emit(new Values(param));

}

} @Override

public void prepare(Map map, TridentOperationContext tridentOperationContext) { } @Override

public void cleanup() { }

}

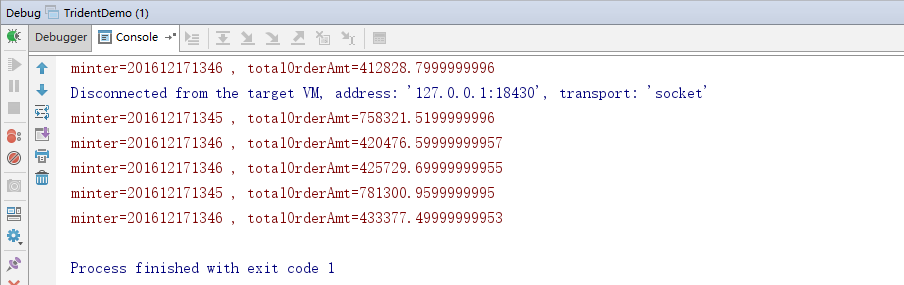

3.效果

三:集群模式的DRPC

1.主驱动类

config.setNumWorkers(2);

//集群上构建DRPC服务器

tridentTopology.newDRPCStream("orderDataServer")

//参数处理

.each(new Fields("args"),new RequestParamsParserFunction(),new Fields("date"))

//查询,重要的参数是上面的partitionState

.stateQuery(partitionState,new Fields("date"),new MapGet(),new Fields("totalAmtByMinter"))

//投影

.project(new Fields("date","totalAmtByMinter"));

StormSubmitter.submitTopology(args[0],config,tridentTopology.build());

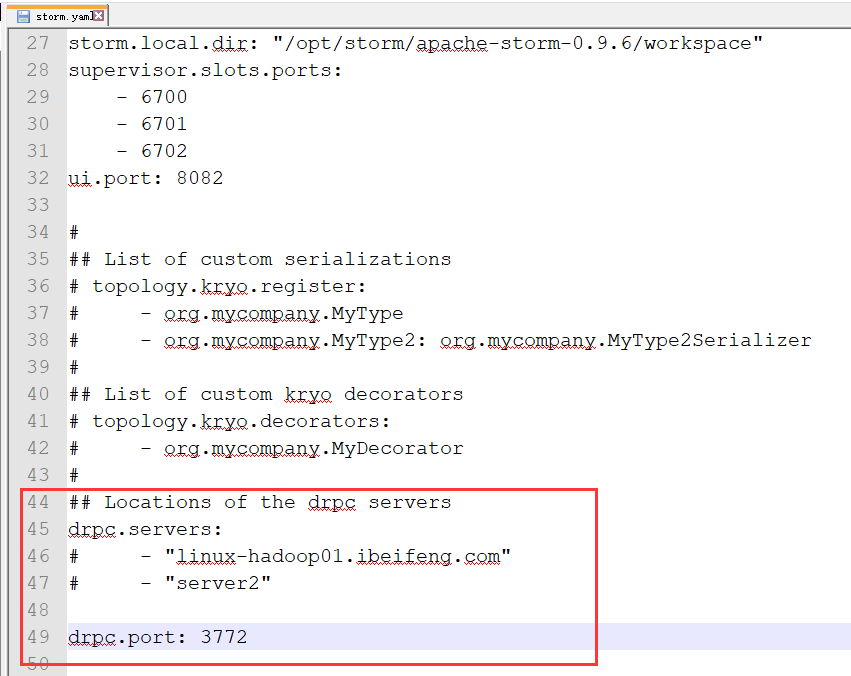

2.配置DRPC服务和端口

3.启动storm

4.启动Drpc进程

在drpc.servers参数所指定的服务器上。

命令:nohup bin/storm drpc >>/dev/null 2>&1 &

查看端口是否正常打开:netstat -tlnup | grep 3772

5.将jar包提交到集群上

6.编写客户端

package com.jun.tridentWithKafka; import backtype.storm.generated.DRPCExecutionException;

import backtype.storm.utils.DRPCClient;

import org.apache.thrift7.TException; public class DrpcClientDemo {

public static void main(String[] args) {

DRPCClient drpcClient=new DRPCClient("linux-hadoop01.ibeifeng.com",3772);

try {

String jsonResult=drpcClient.execute("orderDataServer","201612171345 201612171345");

System.out.println("==="+jsonResult+"===");

} catch (TException e) {

e.printStackTrace();

} catch (DRPCExecutionException e) {

e.printStackTrace();

}

}

}

Trident中的DRPC实现的更多相关文章

- Trident中使用HBase进行状态管理

1.使用的类 2.使用HBaseMapState 3.使用状态管理 使用的状态管理还要看Spout StateFactory factory1 = HBaseMapState.opaque(opts1 ...

- Trident中的过滤与函数的区别

1.共同点 都需要实现storm.trident.operation.Function接口 2.不同点 其中函数有发射这个步骤. .each(new Fields("orderTime&qu ...

- Trident中的解析包含的函数操作与投影操作

一:函数操作 1.介绍 Tuple本身是不可变的 Function只是在原有的基础上追加新的tuple 2.说明 如果原来的字段是log,flag 新增之后的tuple可以访问这些字段,log,fla ...

- Trident中 FixedBatchSpout分析

FixedBatchSpout 继承自 IBatchSpout IBatchSpout 方法 public interface IBatchSpout extends Serializable { v ...

- storm trident 示例

Storm Trident的核心数据模型是一批一批被处理的“流”,“流”在集群的分区在集群的节点上,对“流”的操作也是并行的在每个分区上进行. Trident有五种对“流”的操作: 1. 不 ...

- [翻译][Trident] Trident state原理

原文地址:https://github.com/nathanmarz/storm/wiki/Trident-state ----------------------------- Trident在读写 ...

- storm的trident编程模型

storm的基本概念别人总结的, https://blog.csdn.net/pickinfo/article/details/50488226 编程模型最关键最难就是实现局部聚合的业务逻辑聚合类实现 ...

- 访问WEB-INF目录中的JSP文件

方法1:本来WEB-INF中的jsp就是无法通过地址栏访问的.所以安全.如果说你要访问这个文件夹中的jsp文件需要在项目的web.xml文件中去配置servlet格式差不多的配置就ok了.如下: 访问 ...

- Storm系列(十七)DRPC介绍

Storm版本0.9.5 在storm中DRPC服务应用于远程分布式计算,根据客户端提交的请求参数,而返回Storm计算的结果. DRPC服务启动流程(远程模式) 启动DRPC服务,启动命令:stor ...

随机推荐

- django的内置信号

Model singnalspre_init 在model执行构造方法之前自动触发post_init django的model在执行构造方法之后,自动触发pre_save django的对象保存之前, ...

- 24)django-信号

目录 1)django信号简介 2)django内置信号 3)django自定义信号 一:django信号简介 Django中提供了“信号调度”,用于在框架执行操作时解耦. 通俗来讲,就是一些动作发生 ...

- Codeforces 487E Tourists [广义圆方树,树链剖分,线段树]

洛谷 Codeforces 思路 首先要莫名其妙地想到圆方树. 建起圆方树后,令方点的权值是双联通分量中的最小值,那么\((u,v)\)的答案就是路径\((u,v)\)上的最小值. 然而这题还有修改, ...

- VBS学习

简介 VBS windows脚本 Microsoft visual basic script editionVBS 是visual basic的一个抽象子集,系统内置,不编译为二进制文件,(由host ...

- 经典JS闭包面试题(来理解闭包)(转)

转载地址:http://www.cnblogs.com/xxcanghai/p/4991870.html 先看代码: function fun(n,o) { console.log(o) return ...

- 【转】nvidia-smi 命令解读

nvidia-smi是linux下用来查看GPU使用情况的命令.具体的参数信息详见 原文:http://blog.csdn.net/sallyxyl1993/article/details/62220 ...

- 弃 Java 而使用 Kotlin 的你后悔了吗?| kotlin将会是最好的开发语言

自从 2011 年发布以来,Kotlin 凭借强大的功能在开发者中的欢迎程度与日俱增.且在一年前,Google 宣布 Kotlin 正式成为 Android 官方开发语言,由此引发了从 Java 迁移 ...

- 机器学习之线性回归---logistic回归---softmax回归

在本节中,我们介绍Softmax回归模型,该模型是logistic回归模型在多分类问题上的推广,在多分类问题中,类标签 可以取两个以上的值. Softmax回归模型对于诸如MNIST手写数字分类等问题 ...

- bat命令查询硬件信息

bat命令查询硬件信息 50 需求是这样的写一个bat命令,当命令执行的时候,先请用户输入姓名,然后继续执行查询出以下信息并写入一个文件,文件名称随便,文件可以放在与当前命令同一个文件夹下.最终文件中 ...

- Confluence 6 查看站点状态

请注意,有关站点的活动信息在默认情况下是禁用的.请查看下面的说明. 如果这个插件被启用的话,有关站点的全局活动状态将会在你的 Confluence 站点中显示出来.显示的数据包括: 在给定的时间内有多 ...