Orders matters: seq2seq for set 实验

论文提出了input的顺序影响seq2seq结果 有一些输入本身是无序的怎么去处理呢

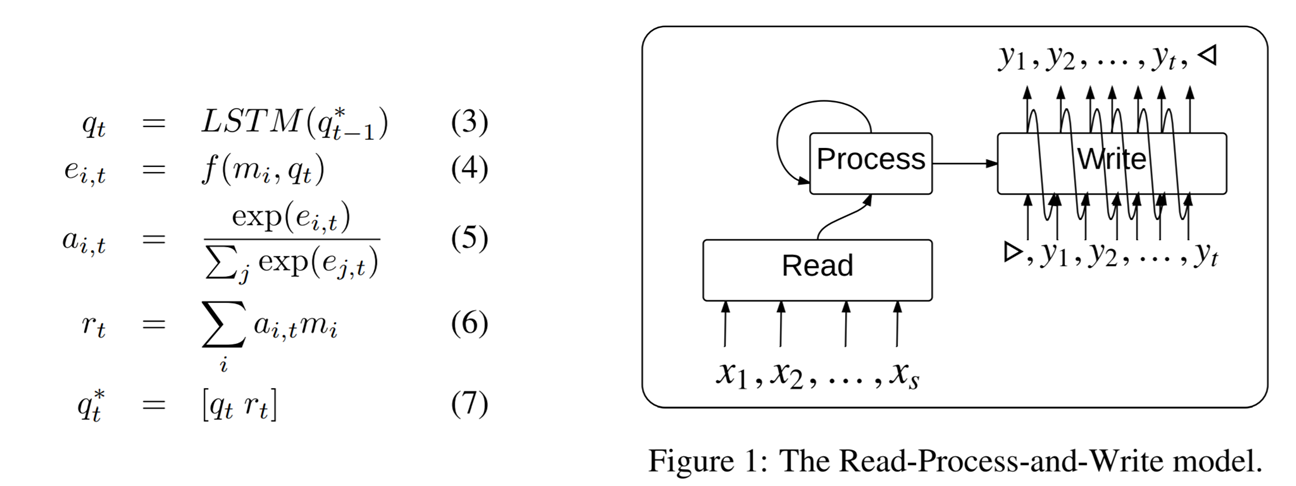

作者提出LSTM controller的方式 替代输入的LSTM encode方式

作者实验这种方式对应无序浮点数序列排序效果好于直接seq2seq

N是要排序的数的数目

P = 10 steps 表示 LSTM contorller process 10次

glimpses = 1 表示输出使用attention机制

不过实验复现这个结果不太一致

这里实验结果如下,也许实验细节和论文有出入,比如排序问题

要求输入是set 与顺序无关,那么LSTM的初始 input query是啥?

这里使用了全0向量作为input query实验

另外这个排序训练过程decoder是否使用feed prev?

这里使用feed prev 同时

使用soft attention读取输入作为下一步输入

实验结论:

- Ptr-Net 和作者提出的 set2seq方式

都是收敛有效的 - Ptr-Net 采用glimplse=1 N=15 使用tensorflow lstm训练,adgrad optimizer,learning rate 0.1初始,

运行10000次的结果

比上图所示要好很多AverageEvals:[0.37186, 0.14407] loss 是0.37186 序列完全预测准确情况的比例是14.4% 远远好于上面提到的4%的结果

- Set2seq虽然work 但是没有看出比直接ptr-net效果要好。。。

开始几步收敛确实更快

但是后续收敛远远慢于ptr net

选用Step = 20 对比 ptr net

所以是哪里出了问题

没有正确复现?

还是本来sort这个例子 lstm controller相比直接lstm序列encode就没有提升效果呢?

实验地址

https://github.com/chenghuige/hasky/tree/master/applications/set2seq

Orders matters: seq2seq for set 实验的更多相关文章

- 数据库中间件DBLE学习(二) 学习配置schema.xml

前言 一边有一个经常引诱我让我"娱乐至死"的视频,还有一个不停"鞭策"我让我快点学习的大BOSS.正是有这两种极端的爱才让我常常在自信中明白自己努力的方向.嗯, ...

- 《Do Neural Dialog Systems Use the Conversation History Effectively? An Empirical Study》

https://zhuanlan.zhihu.com/p/73723782 请复制粘贴到markdown 查看器查看! Do Neural Dialog Systems Use the Convers ...

- oracle 11g实验五——触发器的使用

实验要求: 实验五 触发器的使用 实验目的 1. 理解触发器的概念.作用及分类: 2. 掌握触发器的创建.使用: 实验内容 1. 建立表orders:用于存储订单列表信息:表order_item ...

- DL4NLP —— seq2seq+attention机制的应用:文档自动摘要(Automatic Text Summarization)

两周以前读了些文档自动摘要的论文,并针对其中两篇( [2] 和 [3] )做了presentation.下面把相关内容简单整理一下. 文本自动摘要(Automatic Text Summarizati ...

- Pytorch系列教程-使用Seq2Seq网络和注意力机制进行机器翻译

前言 本系列教程为pytorch官网文档翻译.本文对应官网地址:https://pytorch.org/tutorials/intermediate/seq2seq_translation_tutor ...

- pytorch做seq2seq注意力模型的翻译

以下是对pytorch 1.0版本 的seq2seq+注意力模型做法语--英语翻译的理解(这个代码在pytorch0.4上也可以正常跑): # -*- coding: utf-8 -*- " ...

- deeplearning.ai学习seq2seq模型

一.seq2seq架构图 seq2seq模型左边绿色的部分我们称之为encoder,左边的循环输入最终生成一个固定向量作为右侧的输入,右边紫色的部分我们称之为decoder.单看右侧这个结构跟我们之前 ...

- google nmt 实验踩坑记录

最近因为要做一个title压缩的任务,所以调研了一些text summary的方法. text summary 一般分为抽取式和生成式两种.前者一般是从原始的文本中抽取出重要的word o ...

- 时间序列深度学习:seq2seq 模型预测太阳黑子

目录 时间序列深度学习:seq2seq 模型预测太阳黑子 学习路线 商业中的时间序列深度学习 商业中应用时间序列深度学习 深度学习时间序列预测:使用 keras 预测太阳黑子 递归神经网络 设置.预处 ...

随机推荐

- Incorrect username or password ( access token )解决

Q:Git提交时,给出提示Incorrect username or password ( access token ) K: 此处是用户名或者密码有误,建议解决方法两种.具体看哪一种可行,可试. 第 ...

- echarts中dataZoom的使用

ataZoom的使用方法 功能: 1.有inslide和slide两种dataZoom,也分X,Y轴 两种dataZoom的使用 dataZoom:[ { type:"slider" ...

- python实现23种设计模式

本文源码寄方于github:https://github.com/w392807287/Design_pattern_of_python 参考文献: <大话设计模式>——吴强 <Py ...

- 最课程阶段大作业06:U度节能平台控制系统

除了互联网项目,当今社会还有一个概念非常流行,那就是:物联网.什么是物联网?物联网是通过传感设备,按约定的协议,把任意物品与互联网相连接,进行信息交换和通信,以实现智能化识别.定位.跟踪.监控和管理的 ...

- ViewPager Fragment 懒加载 可见 总结 MD

Markdown版本笔记 我的GitHub首页 我的博客 我的微信 我的邮箱 MyAndroidBlogs baiqiantao baiqiantao bqt20094 baiqiantao@sina ...

- SpringBoot(十三):springboot2.0.2定时任务

使用定义任务: 第一步:启用定时任务第二步:配置定时器资源等第三步:定义定时任务并指定触发规则 1)启动类启用定时任务 在springboot入口类上添加注解@EnableScheduling即可. ...

- How to copy the contents of std::vector to c-style static array,safely?

[问题] I am getting warning when using the std copy function. I have a byte array that I declare. byte ...

- C# 程序打包成安装项目

Xaml设置图标https://blog.csdn.net/u014234260/article/details/73648649 winform程序控制面板中卸载显示图标https://blog.c ...

- Centos升级mongo客户端

一.背景 在宿主机centos上启一个Mongo容器,暴露端口21117,并设置用户名,密码(root/mongo) docker run --name mongo1 -p : -d mongo -- ...

- Java驱动远程连接mongoDB(简明易懂版)

mongodb默认是不能远程连接的,而且在linux安装完你会发现,它的目录极其简单,连个配置文件都没有. 我的mongodb的版本是3.6,目前最新的.https://www.mongodb.com ...