深入研究Spark SQL的Catalyst优化器(原创翻译)

树

- Literal(值:Int):常数值

- Attribute(名称:String):输入行的属性,例如“x”

- Add(左:TreeNode,右:TreeNode):两个表达式的总和。

Add(Attribute(x), Add(Literal(1), Literal(2)))

规则

tree.transform {

case Add(Literal(c1), Literal(c2)) => Literal(c1+c2)

}

将此应用于x +(1 + 2)的树会产生新的树x + 3。这里关键是使用了Scala的标准模式匹配语法,它可用于匹配对象的类型和为提取的值(这里为c1和c2)提供名称。

tree.transform {

case Add(Literal(c1), Literal(c2)) => Literal(c1+c2)

case Add(left, Literal(0)) => left

case Add(Literal(0), right) => right

}

实际上,规则可能需要多次执行才能完全转换树。Catalyst将规则形成批处理,并执行每个批处理至固定点,该固定点是树应用其规则后不发生改变。虽然规则运行到固定点意味着每个规则是简单且自包含,但这些规则仍会对树上产生较大的全局效果。在上面的例子中,重复的应用规则会持续折叠较大的树,比如(x + 0)+(3 + 3)。另一个例子,第一个批处理可以分析所有属性指定类型的表达式,而第二批处理可使用这些类型来进行常量折叠。在每批处理完毕后,开发人员还可以对新树进行规范性检查(例如,查看所有属性为指定类型),这些检查一般使用递归匹配来编写。

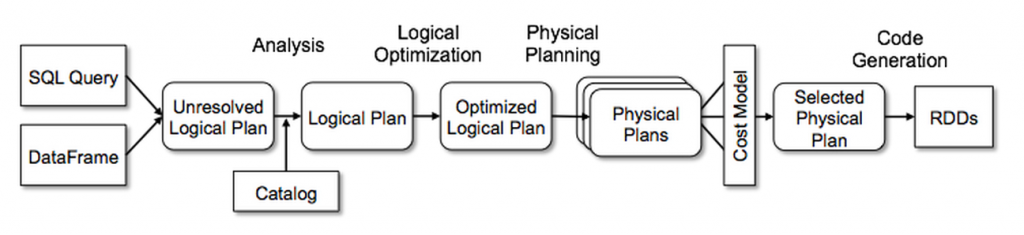

在Spark SQL中使用Catalyst

解析

逻辑计划优化

object DecimalAggregates extends Rule[LogicalPlan] {

/** Maximum number of decimal digits in a Long */

val MAX_LONG_DIGITS = 18

def apply(plan: LogicalPlan): LogicalPlan = {

plan transformAllExpressions {

case Sum(e @ DecimalType.Expression(prec, scale))

if prec + 10 <= MAX_LONG_DIGITS =>

MakeDecimal(Sum(UnscaledValue(e)), prec + 10, scale) }

}

再举一个例子,一个12行代码的规则通过简单的正则表达式将LIKE表达式优化为String.startsWith或String.contains调用。在规则中使用任意Scala代码使得这些优化易于表达,而这些规则超越了子树结构的模式匹配。

物理计划

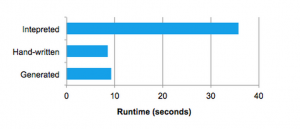

代码生成

def compile(node: Node): AST = node match {

case Literal(value) => q"$value"

case Attribute(name) => q"row.get($name)"

case Add(left, right) => q"${compile(left)} + ${compile(right)}"

}

以q开头的字符串是quasiquotes,虽然它们看起来像字符串,但它们在编译时由Scala编译器解析,并代表其代码的AST。 Quasiquotes用$符号表示法将变量或其他AST拼接到它们中。例如,文字(1)将成为1的Scala表达式的AST,而属性(“x”)变为row.get(“x”)。最后,类似Add(Literal(1),Attribute(“x”))的树成为像1 + row.get(“x”)这样的Scala表达式的AST。

- Spark SQL and DataFrame Programming Guide from Apache Spark

- Data Source API in Spark presentation by Yin Huai

- Introducing DataFrames in Spark for Large Scale Data Science by Reynold Xin

- Beyond SQL: Speeding up Spark with DataFrames by Michael Armbrust

深入研究Spark SQL的Catalyst优化器(原创翻译)的更多相关文章

- SQL Server的优化器会缓存标量子查询结果集吗

在这篇博客"ORACLE当中自定义函数性优化浅析"中,我们介绍了通过标量子查询缓存来优化函数性能: 标量子查询缓存(scalar subquery caching)会通过缓存结果减 ...

- Deep Dive into Spark SQL’s Catalyst Optimizer(中英双语)

文章标题 Deep Dive into Spark SQL’s Catalyst Optimizer 作者介绍 Michael Armbrust, Yin Huai, Cheng Liang, Rey ...

- 有时间了解一下Spark SQL parser的解析器架构

1:了解大体架构 2:了解流程以及各个类的职责 3:尝试编写一个

- Spark SQL在100TB上的自适应执行实践(转载)

Spark SQL是Apache Spark最广泛使用的一个组件,它提供了非常友好的接口来分布式处理结构化数据,在很多应用领域都有成功的生产实践,但是在超大规模集群和数据集上,Spark SQL仍然遇 ...

- DataFrame编程模型初谈与Spark SQL

Spark SQL在Spark内核基础上提供了对结构化数据的处理,在Spark1.3版本中,Spark SQL不仅可以作为分布式的SQL查询引擎,还引入了新的DataFrame编程模型. 在Spark ...

- Spark SQL概念学习系列之Spark SQL 优化策略(五)

查询优化是传统数据库中最为重要的一环,这项技术在传统数据库中已经很成熟.除了查询优化, Spark SQL 在存储上也进行了优化,从以下几点查看 Spark SQL 的一些优化策略. (1)内存列式存 ...

- Spark SQL Catalyst源代码分析Optimizer

/** Spark SQL源代码分析系列*/ 前几篇文章介绍了Spark SQL的Catalyst的核心运行流程.SqlParser,和Analyzer 以及核心类库TreeNode,本文将具体解说S ...

- Apache Spark 2.2中基于成本的优化器(CBO)(转载)

Apache Spark 2.2最近引入了高级的基于成本的优化器框架用于收集并均衡不同的列数据的统计工作 (例如., 基(cardinality).唯一值的数量.空值.最大最小值.平均/最大长度,等等 ...

- 第五篇:Spark SQL Catalyst源码分析之Optimizer

/** Spark SQL源码分析系列文章*/ 前几篇文章介绍了Spark SQL的Catalyst的核心运行流程.SqlParser,和Analyzer 以及核心类库TreeNode,本文将详细讲解 ...

随机推荐

- YUI 的模块信息配置优先级关系梳理

背景 YUI的配置参数较多, 可以在好几个地方配置一个module的相关信息, 如: //在全局配置, 所以YUI实例共享 YUI_config = { modules: { 'w-autcomple ...

- logback的使用和logback.xml详解

一.logback的介绍 Logback是由log4j创始人设计的另一个开源日志组件,官方网站: http://logback.qos.ch.它当前分为下面下个模块: logback-core:其它两 ...

- 关于HTTP请求出现 405状态码 not allowed的解决办法

最近学爬虫.发现httppost请求目标网站会出现405 状态码,原因为 Apache.IIS.Nginx等绝大多数web服务器,都不允许静态文件响应POST请求 所以将post请求改为get请求即可

- 解决:mysql is blocked because of many connection errors;

标签:because service foreign errors closed 原创作品,允许转载,转载时请务必以超链接形式标明文章 原始出处 .作者信息和本声明.否则将追究法律责任.http:// ...

- Core Graphics框架是Quartz的核心,也是内容描画的基本接口。

Core Graphics框架是Quartz的核心,也是内容描画的基本接口.

- 一分钟搭建Vue2.0+Webpack2.0多页面项目

想要自己一步步搭建的比较麻烦,不是很推荐,最少也要使用vue-cli,在其基础上开始搭建,今天我的主题是一分钟搭建,那么常规方法肯定不能满足的, 而我用的方法也很简单,就是使用已经配置完成的demo模 ...

- 使用 ServiceAnt 更好地解耦你的程序

今天要厚着脸皮给大家推荐一个自己做的通信中间件--ServiceAnt,目前已经在我们团队的两个产品线上投入了使用. ServiceAnt是什么 它最初的定位是ESB(企业服务总线),但目前还没有达到 ...

- U8g2库I2C总线再次突破性调试成功

这次采用U8X8的方式,不再采用u8g2,因为后者一直报内存问题.所以采用了不占内存的u8x8模式 同时u8g2库文件的示例代码也是很牛逼的, 里面还有message box 非常的可爱运行效果也非常 ...

- centos7 安装jdk 1.8

1.下载jdk1.8 for linux的安装包 jdk-8u11-linux-x64.tar.gz,下载地址:http://download.oracle.com/otn-pub/java/jdk ...

- 豹哥嵌入式讲堂:ARM知识概要杂辑(2)- 第一款Cortex-M处理器

1.天生荣耀:ARM Cortex-M处理器由来 ARM公司自2004年推出ARMv7内核架构时,摒弃了以往"ARM+数字"这种处理器命名方法(ARM11之前的处理器统称经典处理器 ...