安装hadoop集群--hdfs

准备一台干净的虚拟机-centos7

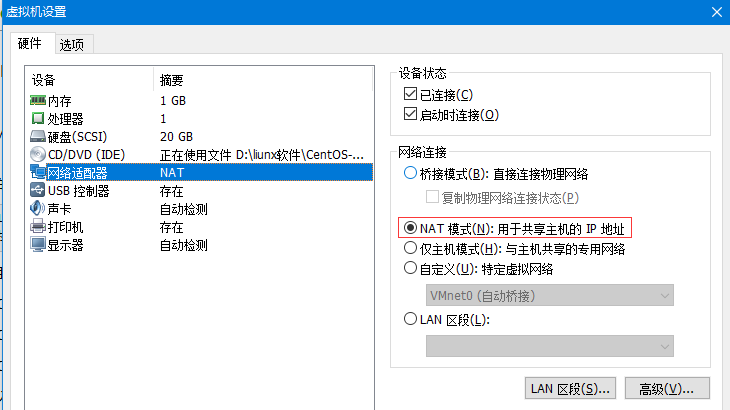

网络连接改成NAT模式 进行下一步安装

- [root@hdp-01 ~]# vi /etc/sysconfig/network-scripts/ifcfg-ens33

- ONBOOT=no改为ONBOOT=yes

重启网络服务:

- [root@hdp-01 ~]# sudo service network restart

- [root@hdp-01 ~]# mkdir apps

- [root@hdp-01 ~]# tar -zxvf jdk-8u152-linux-x64.tar.gz -C apps/

[root@hdp-01 ~]# mv jdk1.8.0_152 java- [root@hdp-01 ~]# vi /etc/profile

- [root@hdp-01 ~]# vi /etc/profile

在文件最后加入:

- export JAVA_HOME=/root/apps/java

- export PATH=$PATH:$JAVA_HOME/bin

修改完成后,记得 source /etc/profile使配置生效

hdp-01为模板克隆四台虚拟机 分别为hdp-02 hdp-03 hdp-04

Windows配置hosts文件

C:\Windows\System32\drivers\etc

- 192.168.137.138 hdp-01

- 192.168.137.139 hdp-02

- 192.168.137.140 hdp-03

- 192.168.137.141 hdp-04

配置SSH免密登录

在每台服务器或虚拟机上配置hosts,命令行输入:

- vi /etc/hosts

在其中添加所有服务器或虚拟机节点ip和对应的域名

- 192.168.137.138 hdp-01

- 192.168.137.139 hdp-02

- 192.168.137.140 hdp-03

- 192.168.137.141 hdp-04

在hdp-01中输入ssh-keygen 一直回车

复制公钥到其他节点

- ssh-copy-id -i .ssh/id_rsa.pub root@hdp-01

- ssh-copy-id -i .ssh/id_rsa.pub root@hdp-02

- ssh-copy-id -i .ssh/id_rsa.pub root@hdp-03

- ssh-copy-id -i .ssh/id_rsa.pub root@hdp-04

复制完成即可实现免密登录,测试一下:

ssh 0.0.0.0

上传hadoop-2.8.4.tar.gz到hdp-01

- [root@hdp-01 ~]# tar -zxvf hadoop-2.8.4.tar.gz -C apps/

- [root@hdp-01 apps]# mv hadoop-2.8.4/ hadoop

修改配置文件

指定hadoop的默认文件系统为:hdfs

指定hdfs的namenode节点为哪台机器

指定namenode软件存储元数据的本地目录

指定datanode软件存放文件块的本地目录

hadoop的配置文件在:/root/apps/hadoop/etc/hadoop/

- [root@hdp-01 ~]# cd apps/hadoop/etc/hadoop

- [root@hdp-01 hadoop]# vi hadoop-env.sh

修改hadoop-env.sh

export JAVA_HOME=/root/apps/java

修改core-site.xml

- <configuration>

- <property>

- <name>fs.defaultFS</name>

- <value>hdfs://hdp-01:9000</value>

- </property>

- </configuration>

修改hdfs-site.xml

- <configuration>

- <property>

- <name>dfs.namenode.name.dir</name>

- <value>/root/dfs/name</value>

- </property>

- <property>

- <name>dfs.datanode.data.dir</name>

- <value>/root/dfs/data</value>

- </property>

- </configuration>

[root@hdp-01 ~]# cd apps/hadoop/share/

[root@hdp-01 share]# rm -rf doc/

拷贝整个hadoop安装目录到其他机器

- scp -r /root/apps/hadoop hdp-02:/root/apps/

- scp -r /root/apps/hadoop hdp-03:/root/apps/

- scp -r /root/apps/hadoop hdp-04:/root/apps/

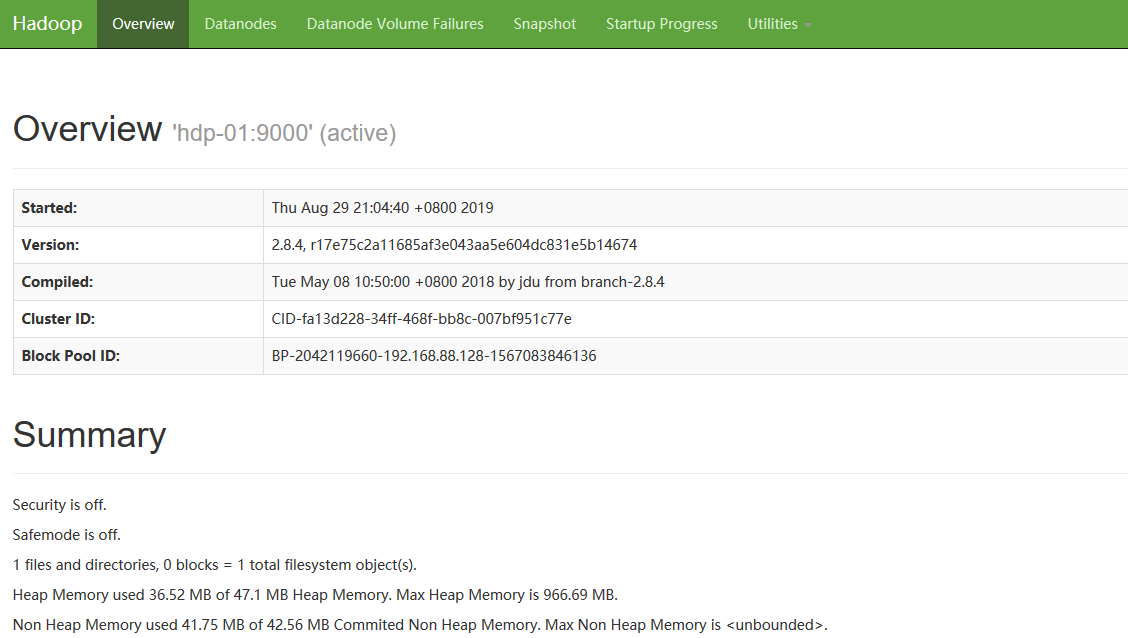

启动HDFS

提示:要运行hadoop的命令,需要在linux环境中配置HADOOP_HOME和PATH环境变量

vi /etc/profile

- export JAVA_HOME=/root/apps/java

- export HADOOP_HOME=/root/apps/hadoop

- export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile

- [root@hdp-01 ~]# scp -r /etc/profile hdp-02:/etc/profile

- [root@hdp-01 ~]# scp -r /etc/profile hdp-03:/etc/profile

- [root@hdp-01 ~]# scp -r /etc/profile hdp-04:/etc/profile

初始化namenode的元数据目录

hdp-01上执行hadoop的一个命令来初始化namenode的元数据存储目录

- [root@hdp-01 ~]# hadoop namenode -format

创建一个全新的元数据存储目录

生成记录元数据的文件fsimage

生成集群的相关标识:如:集群id——clusterID

启动namenode进程(在hdp-01上)

关闭防火墙

- [root@hdp-01 ~]# hadoop-daemon.sh start namenode

启动完后,ps查看一下namenode的进程是否存在

windows中用浏览器访问namenode提供的web端口:50070

启动众datanode们(在任意地方)

hadoop-daemon.sh start datanode

用自动批量启动脚本来启动HDFS

修改hadoop安装目录中/etc/hadoop/slaves(把需要启动datanode进程的节点列入)

- [root@hdp-01 ~]# vi apps/hadoop/etc/hadoop/slaves

- //加入

- hdp-01

- hdp-02

- hdp-03

- hdp-04

在hdp-01上用脚本:start-dfs.sh 来自动启动整个集群

停止则用脚本:stop-dfs.sh

安装hadoop集群--hdfs的更多相关文章

- 高可用,完全分布式Hadoop集群HDFS和MapReduce安装配置指南

原文:http://my.oschina.net/wstone/blog/365010#OSC_h3_13 (WJW)高可用,完全分布式Hadoop集群HDFS和MapReduce安装配置指南 [X] ...

- docker安装hadoop集群

docker安装hadoop集群?图啥呢?不图啥,就是图好玩.本篇博客主要是来教大家如何搭建一个docker的hadoop集群.不要问 为什么我要做这么无聊的事情,答案你也许知道,因为没有女票.... ...

- Hadoop集群-HDFS集群中大数据运维常用的命令总结

Hadoop集群-HDFS集群中大数据运维常用的命令总结 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本篇博客会简单涉及到滚动编辑,融合镜像文件,目录的空间配额等运维操作简介.话 ...

- 安装Hadoop集群的最快的软件

Quick Hadoop是一款安装Hadoop集群的桌面软件,只需要点两下鼠标,一分钟之内安装Hadoop到集群上,超快! 还在每台主机的Shell里一行一行地敲安装Hadoop的命令?别苦逼了! 用 ...

- CentOS7 搭建Ambari-Server,安装Hadoop集群(一)

2017-07-05:修正几处拼写错误,之前没发现,抱歉! 第一次在cnblogs上发表文章,效果肯定不会好,希望各位多包涵. 编写这个文档的背景是月中的时候,部门老大希望我们能够抽时间学习一下Had ...

- 通过ambari安装hadoop集群,ZT

通过ambari安装hadoop集群,ZT http://www.cnblogs.com/cenyuhai/p/3295635.html http://www.cnblogs.com/cenyuhai ...

- Linux上安装Hadoop集群(CentOS7+hadoop-2.8.0)--------hadoop环境的搭建

Linux上安装Hadoop集群(CentOS7+hadoop-2.8.0)------https://blog.csdn.net/pucao_cug/article/details/71698903 ...

- 安装hadoop集群服务器(hadoop1.2.1)

摘要:hadoop,一个分布式系统基础架构,可以充分利用集群的威力进行高速运算和存储.本文主要介绍hadoop的安装与集群服务器的配置. 准备文件: ▪ VMware11.0.0 ▪ Cen ...

- CentOS7 安装Hadoop集群环境

先按照上一篇安装与配置好CentOS以及zookeeper http://www.cnblogs.com/dopeter/p/4609276.html 本章介绍在CentOS搭建Hadoop集群环境 ...

随机推荐

- Web网站工作原理解析

Web的工作原理 Web采用的是客户机--服务器架构(Client--Server model),如下图所示,其中客户端(Client)可以通过网络连接访问另一台计算机的资源或服务,而提供资源或服 ...

- [04] HEVD 内核漏洞之IntegerOverflow

作者:huity出处:https://www.cnblogs.com/huity35/p/11252574.html版权:本文版权归作者所有.文章在博客园.看雪.个人博客同时发布.转载:欢迎转载,但未 ...

- JVM执行原理

,Java是一种技术,它由四方面组成:Java编程语言.Java类文件格式.Java虚拟机和Java应用程序接口(Java API).它们的关系如下图所示: 运行期环境代表着Java平台,开发人员编写 ...

- 基于drone构建CI-CD系统

kubernetes集群三步安装 CI 概述 用一个可描述的配置定义整个工作流 程序员是很懒的动物,所以想各种办法解决重复劳动的问题,如果你的工作流中还在重复一些事,那么可能就得想想如何优化了 持续集 ...

- 新浪微博SSO授权后回调客户端没有执行sinaweiboDidLogIn&无法返回应用

TARGETS --> URL Types --> 添加 --> 在URL Schemes里填上sinaweibosso.XXXX(AppKey),Identifier这里可以随机 ...

- 在ABP中灵活使用AutoMapper

demo地址:ABP.WindowsService 该文章是系列文章 基于.NetCore和ABP框架如何让Windows服务执行Quartz定时作业 的其中一篇. AutoMapper简介 Auto ...

- 解决微信小程序开发者工具输入框焦点问题

Windows10笔记本上运行微信小程序开发者工具,输入框(input,textarea)没有焦点,只能在真机调试,效率太低.后来发现是Window10对笔记本高分屏支持不好,要DPI缩放,导致兼容性 ...

- OOM和JVM配置优化

OOM这个缩写就是Java程序开发过程中让人最头痛的问题:Out of Memory.在很多开发人员的开发过程中,或多或少的都会遇到这类问题,这类问题定位比较困难,往往需要根据经验来判断可能出现问题的 ...

- middleware中间件

django 中的中间件(middleware),在django中,中间件其实就是一个类,在请求到来和结束后,django会根据自己的规则在合适的时机执行中间件中相应的方法. 在django项目的se ...

- CSS3: perspective 3D属性

本文引自:http://blog.csdn.net/cddcj/article/details/52956540 perspective 属性指定了观察者与z=0平面的距离,使具有三维位置变换的元素产 ...