大数据平台Hive数据迁移至阿里云ODPS平台流程与问题记录

一、背景介绍

最近几天,接到公司的一个将当前大数据平台数据全部迁移到阿里云ODPS平台上的任务。而申请的这个ODPS平台是属于政务内网的,因考虑到安全问题当前的大数据平台与阿里云ODPS的网络是不通的,所以不能使用数据采集工作流模板。

然而,考虑到原大数据平台数据量并不是很大,可以通过将原大数据平台数据导出到CSV文件,然后再将CSV文件导入到ODPS平台。在这个过程中踩的坑有点多,所以想写篇文档作为记录。

二、大数据平台Hive数据导出到本地

编写export_data.sh脚本如下:

#!/bin/bash

#

#导出数据

hive -e "use swt_ods; show tables;" > /root/hive_data/table_names.txt

for table_name in `cat /root/hive_data/table_names.txt`

do

hive -e "select * from swt_ods.$table_name;" > /root/hive_data/export_data/$table_name".csv"

sed -i 's/\t/,/g' /root/hive_data/export_data/$table_name".csv"

done

执行脚本,并将数据/root/hive_data/export_data/目录下载到本地。

三、ODPS平台创建对应表

3.1 导出原大数据平台Hive建表语句

编写export_create_table_sql.sh脚本如下:

#!/bin/bash

#

#导出DDL

hive -e "use swt_ods; show tables;" > /root/hive_data/table_names.txt

for table_name in `cat /root/hive_data/table_names.txt`

do

hive -e "show create table swt_ods.$table_name;" > /root/hive_data/export_create_table_sql/$table_name

tac $table_name| sed ,14d| tac > /root/hive_data/export_create_table_sql/$table_name".sql"

rm -f $table_name

echo ";" >> /root/hive_data/export_create_table_sql/$table_name".sql"

cat /root/hive_data/export_create_table_sql/$table_name".sql" >> /root/hive_data/export_create_table_sql/all.sql

done

执行脚本,并将/root/hive_data/export_create_table_sql/all.sql下载到本地。

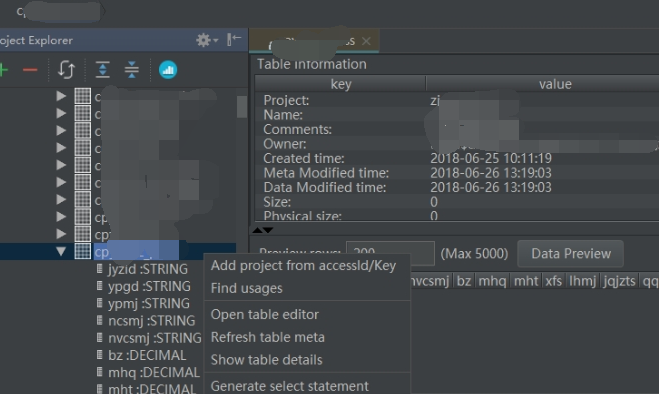

3.2 在ODPS中创建对应的表

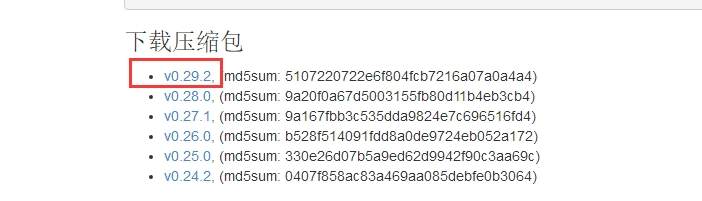

3.2.1 下载并配置MaxCompute 命令行工具

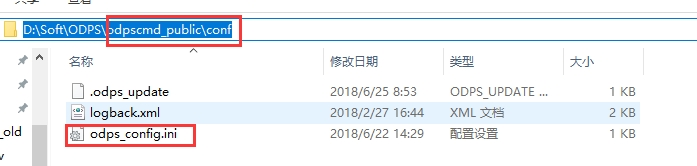

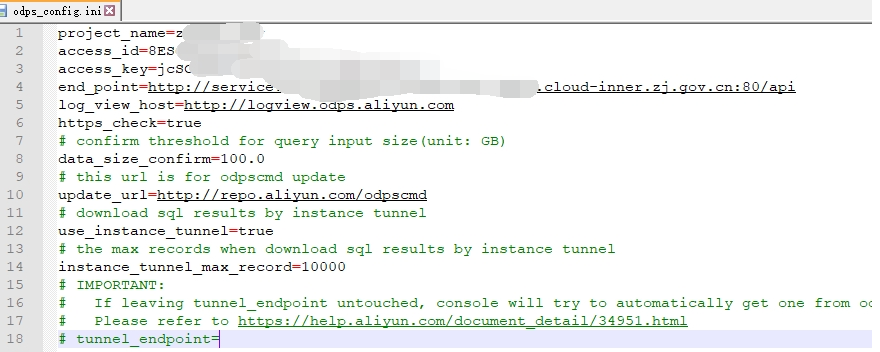

在Windows中,解压即安装。在解压目录中配置odps_config.ini文件

在解压目录odpscmd_public\bin目录下,双击运行odpscmd.bat。

3.2.2 使用命令行创建表

将all.sql中的建表语句粘贴到命令行执行即可创建表。

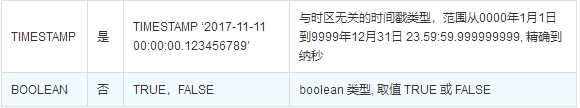

3.2.3 建表过程遇到的问题

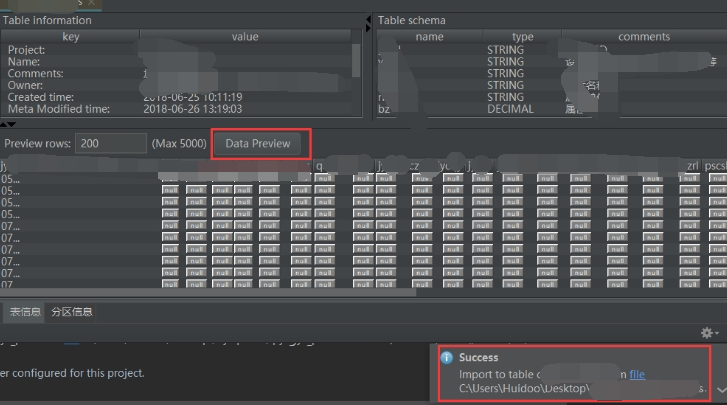

四、本地数据导入到ODPS平台

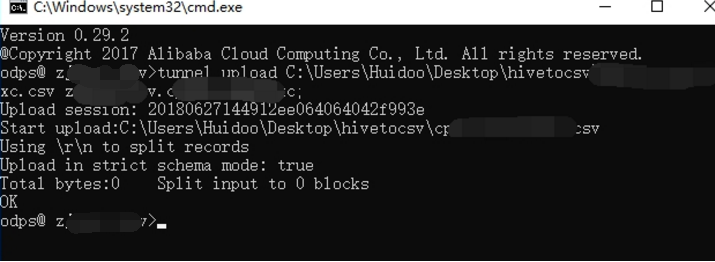

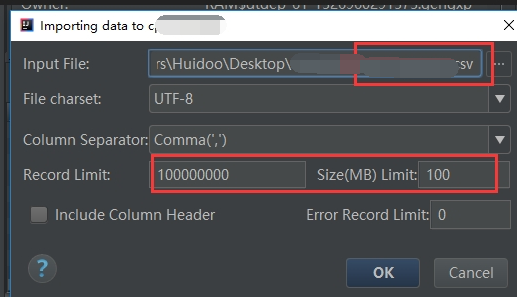

4.1 命令行使用tunnel命令导入数据

使用命令行的方式批量导入数据到对应的表中。

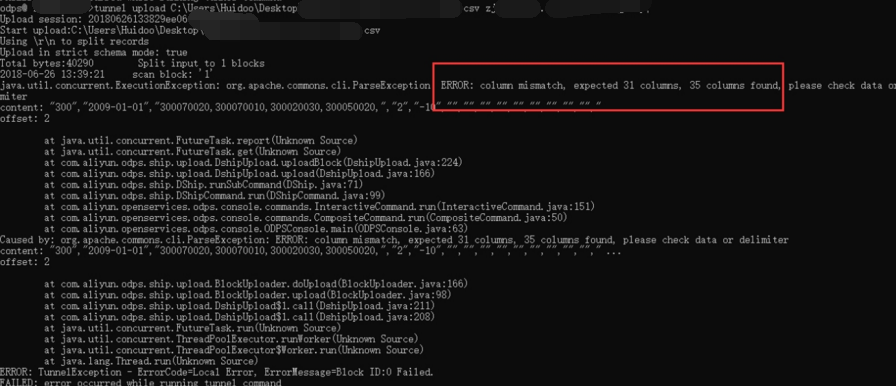

4.2 导入数据遇到的主要问题

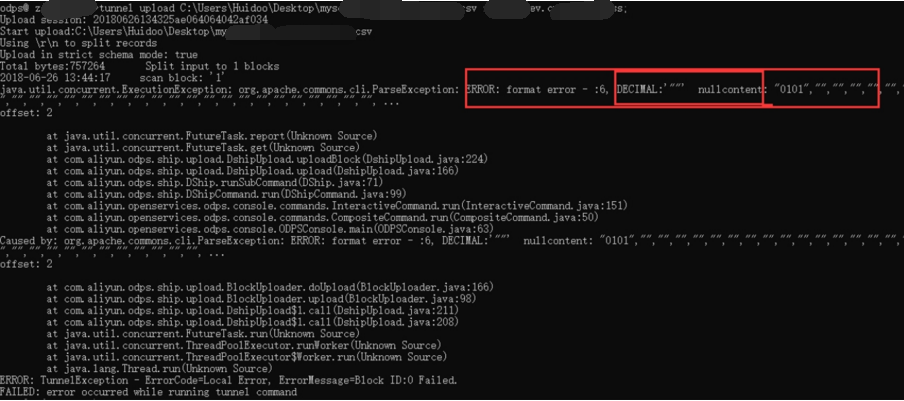

4.2.1 decimal类型数据无法插入空值

可能需要加什么选项或者参数可以解决,但是在查看tunnel upload命令的详细介绍后也没有找到使用命令行来解决这个问题的方法。

4.2.2 原始数据存在的问题

问题描述:

大数据平台Hive数据迁移至阿里云ODPS平台流程与问题记录的更多相关文章

- 直压到亚马逊AWS平台,阿里云OSS平台或者腾讯云COS平台

GTX Compressor (直压上云技术预览版) Powered by GTXLab of Genetalks. 技术预览版本下载地址: https://github.com/Genetalks/ ...

- 实战:基于 Spring 的应用配置如何迁移至阿里云应用配置管理 ACM

最近遇到一些开发者朋友,准备将原有的Java Spring的应用配置迁移到 阿里云应用配置管理 ACM 中.迁移过程中,遇到不少有趣的问题.本文将通过一个简单的样例来还原迁移过程中遇到的问题和相关解决 ...

- 阿里云物联网平台体验(NetGadgeteer+C#篇)

目前对接阿里云物联网平台有多种软件和硬件,可以有多种不同语言来实现对接,比如c/c++,Java,JS,Python,C#等等,不过C#版本只有PC对接云平台的代码,嵌入式的目前还没有看到,所以本篇文 ...

- 阿里云物联网平台体验(树莓派+Nodejs篇)

我们在<阿里云物联网平台体验(树莓派+python篇)>里,写了通过Python语言开发云到端的物联网程序,本篇文章将介绍通过nodejs来实现类似功能. 同样在阿里云官方文档里已经有了一 ...

- 阿里云物联网平台体验(树莓派+Python篇)

阿里云物联网平台体验(树莓派+Python篇) 虽然对阿里云物联网平台比较熟悉了,从一开始就有幸参与了飞凤平台(Link Develop 一站式开发平台的前身)的一些偏硬件接入的工作.但是同时也见证了 ...

- 阿里云 IOT 对接设备开发 C# 开发设备对接阿里云 IOT平台

一,创建阿里云 IOT 产品.设备 目前阿里云每月赠送 100 万条流量,可以免费使用基础版.高级版,开通后即可免费使用. 阿里云 IOT 平台地址 https://iot.console.aliyu ...

- 阿里云物联网平台: Android 连接阿里云物联网平台

说明 这节是是为下一节做铺垫的 只要是按照我提供的学习路线一节一节的认认真真学过来的,这节就十分的简单 有了前两节的基础,这节呢咱让Android 连接阿里云物联网平台 使用这节的代码 https: ...

- 将个人博客从GitHub迁移至阿里云服务器过程总结

让我们先回顾下前两篇博客: 程序员如何从0到1搭建自己的技术博客 在个人博客中优雅的使用Gitalk评论插件 通过前两篇博客,我们了解了如何快速的从0到1搭建一个个人博客并使用了Gitalk评论插件, ...

- 阿里云ODPS <====>蚂蚁大数据

1.命令行客户端工具的安装参考文档:http://repo.aliyun.com/odpscmd/?spm=a2c4g.11186623.2.17.5c185c23zHshCq 2.创建和查看表:ht ...

随机推荐

- matlab 加根号

text(3,0.5,'z=0.2$$\sqrt{c/h_0}$$+0.3','interpreter','latex')

- 循环队列和链式队列(C++实现)

循环队列: 1.循环队列中判断队空的方法是判断front==rear,队满的方法是判断front=(rear+1)%maxSize.(我曾经想过为什么不用一个length表示队长,当length==m ...

- Android相关面试题---初识

一 .Activity的生命周期 Android是使用任务(Task)来管理活动的,一个任务就是一组存放在栈里的活动的集合,这个栈也被称为返回栈(Back Stack).每当我们启动一个新的活动,它会 ...

- 前端使用pdf.js预览pdf文件

现在的浏览器基本都支持直接把pdf文件拖到浏览器就可以打开了,不用安装额外的插件.但是不同的浏览器显示的页面不一样.如果我们想在网页上统一预览pdf怎样实现呢? Mozilla开源了一个插件pdf.j ...

- DBA_TABLES ALL_TABLES USER_TABLES

DBA_TABLES >= ALL_TABLES >= USER_TABLES DBA_TABLES意为DBA拥有的或可以访问的所有的关系表. ALL_TABLES意为某一用户拥有的或可以 ...

- Spring Cloud Commons模块

上一篇介绍了 Spring Cloud Context模块 ,本文介绍SpringCloud的另一个基础模块 SpringCloud Commons模块 .只要在项目的pom文件中引入了spring- ...

- es6 总结知识点

1. let 和 const 只在代码块中有效 {} js块级作用域. const 定义的对象是可以改变其属性的 const a =[], b={} ; a.push(1); b.a=1; / ...

- 算法工程师<编程题>

<编程题> 1.[Maximum Product Subarray 求最大子数组乘积] 这个求最大子数组乘积问题是由最大子数组之和问题演变而来,但是却比求最大子数组之和要复杂,因为在求和的 ...

- Bootstrap-datepicker3官方文档中文翻译---Markup/标记(原文链接 http://bootstrap-datepicker.readthedocs.io/en/latest/index.html)

Markup/标记 下面是已经支持的标签的例子.这些标签本身不会提供DatePicker控件:你需要在标签上实例化Datepicker. input/输入框 最简单的例子: input获得焦点 (使用 ...

- bootstrap学习(二)页面

响应式图片: //当图片大的时候,逐渐缩小浏览器大小,图片会显示为自适应大小 ,img-responsive <div class="container"> <d ...