improve deep learning network 课程笔记

公开课笔记

Bias & variance

bias: 1. more epoch 2. deeper network 3.hyperparameters

variance : larger dataset 2. regularization

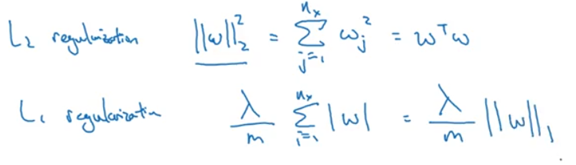

regularization

L2 norm: weight decay

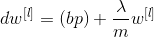

dropout regularization

dropout:在反向传播误差更新权值时候,随机删除一部分hidden units,以防止过拟合。

other methods for variance:

data augmentation:图像有 翻转、裁剪、扭曲、旋转等操作

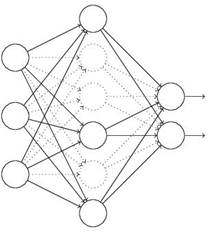

early stopping:

在validation error开始上升时,停止训练

当神经网络还未运行太多迭代过程的时候,w参数接近于0。开始迭代过程,w的值会变得越来越大。early stopping要做的就是在中间点停止迭代过程。这样我们将会得到一个中等大小的w参数,这个结果与得到与L2正则化的结果相似,最终得到w参数较小的神经网络。

梯度消失和梯度爆炸vanishing & exploding

神经网络过深时易产生的现象.

解决方法:1.高斯分布权重初始化 2. relu 3.clip gradient(解决梯度爆炸)

4. shortcut

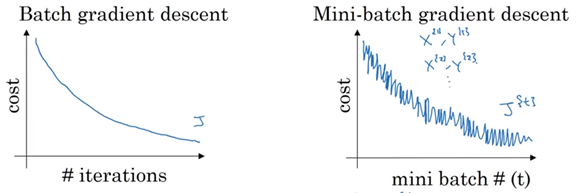

Mini batches

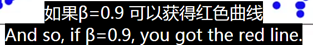

Exponentially weighted average

Bias correction

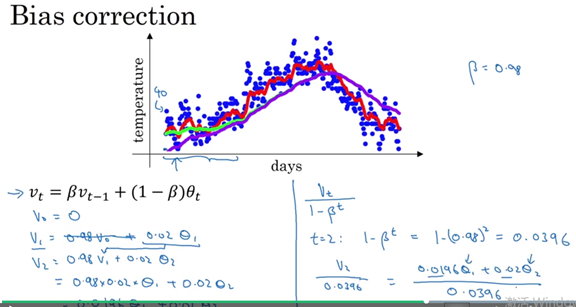

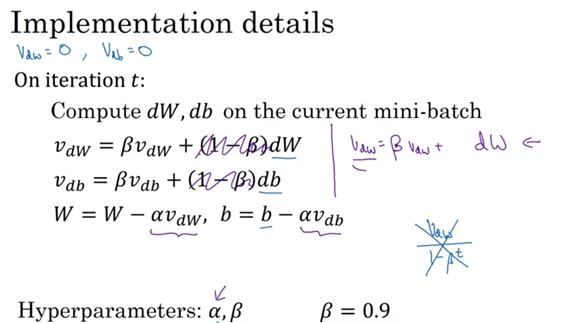

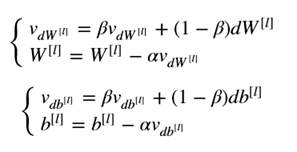

Monumentum

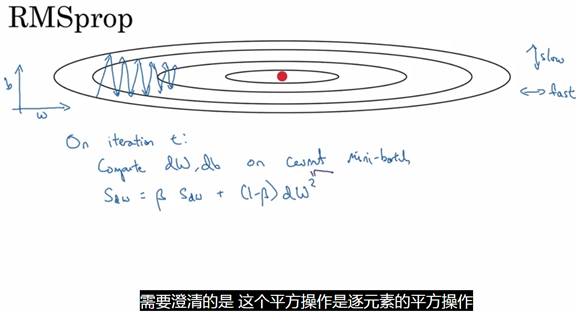

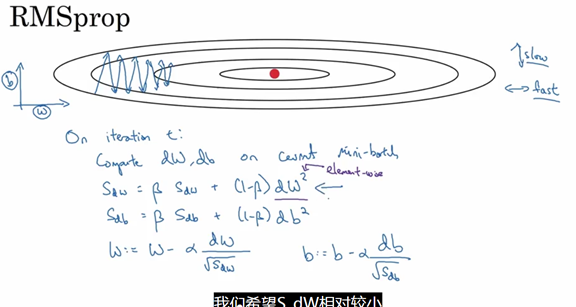

RMSprop

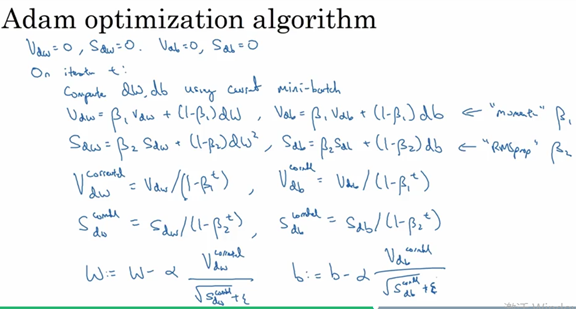

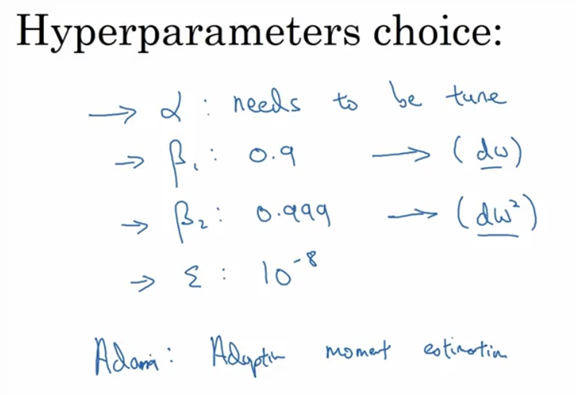

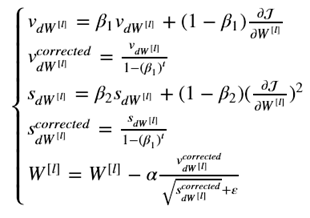

Adam OPTIMIZER

Momentum + RMSprop

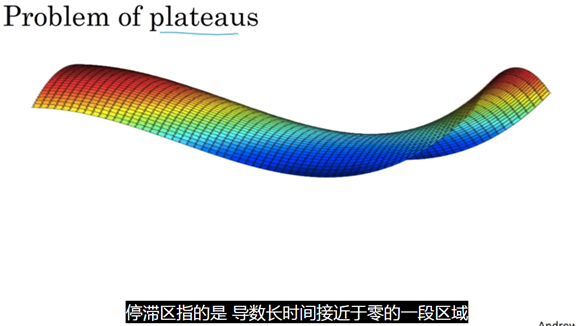

Learning rate decay

解决方法:Adam optimizer等

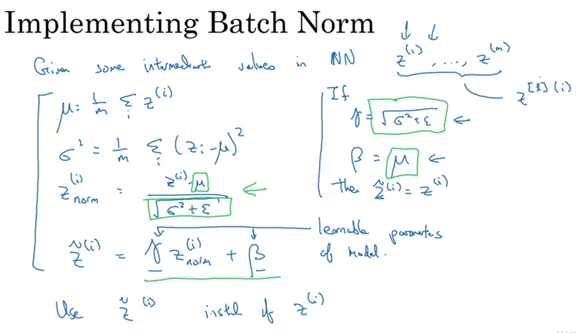

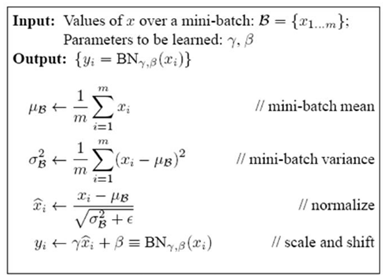

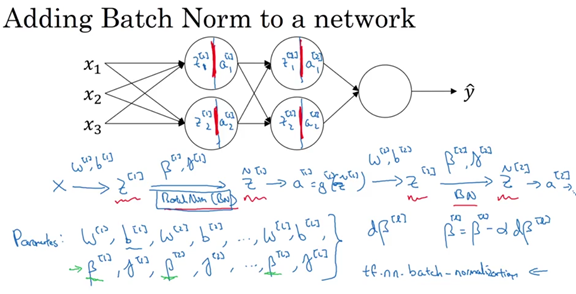

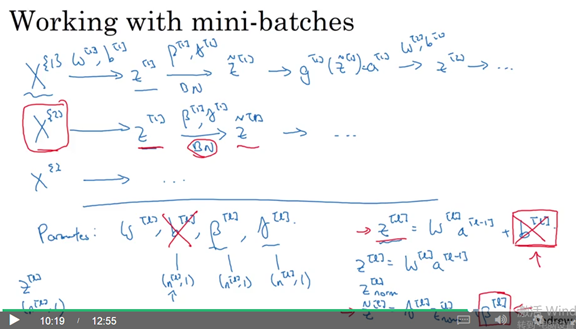

Batch normalize

关于batch normalization 论文解读:https://www.cnblogs.com/guoyaohua/p/8724433.html

IID独立同分布假设,就是假设训练数据和测试数据是满足相同分布的,这是通过训练数据获得的模型能够在测试集获得好的效果的一个基本保障。那BatchNorm的作用是什么呢?BatchNorm就是在深度神经网络训练过程中使得每一层神经网络的输入保持相同分布的。

Scale and shift:

经过变换后网络表达能力下降,为了防止这一点,每个神经元增加两个调节参数(scale和shift),这两个参数通过训练来学习,用于对变换后的激活反变换,使得网络表达能力增强。

在我们训练的过程中,对于训练集的Mini-batch,使用指数加权平均,当训练结束的时候,得到指数加权平均后的均值和方差,而这些值直接用于Batch Norm公式的计算,用以对测试样本进行预测。

improve deep learning network 课程笔记的更多相关文章

- 《Neural Networks and Deep Learning》课程笔记

Lesson 1 Neural Network and Deep Learning 这篇文章其实是 Coursera 上吴恩达老师的深度学习专业课程的第一门课程的课程笔记. 参考了其他人的笔记继续归纳 ...

- 【Deep Learning Nanodegree Foundation笔记】第 1 课:INTRODUCTION Welcome

Welcome to the Deep Learning Nanodegree Foundations Program! In this lesson, you'll meet your instru ...

- How To Improve Deep Learning Performance

如何提高深度学习性能 20 Tips, Tricks and Techniques That You Can Use ToFight Overfitting and Get Better Genera ...

- Deep Learning.ai学习笔记_第一门课_神经网络和深度学习

目录 前言 第一周(深度学习引言) 第二周(神经网络的编程基础) 第三周(浅层神经网络) 第四周(深层神经网络) 前言 目标: 掌握神经网络的基本概念, 学习如何建立神经网络(包含一个深度神经网络), ...

- 【Deep Learning Nanodegree Foundation笔记】第 10 课:Sentiment Analysis with Andrew Trask

In this lesson, Andrew Trask, the author of Grokking Deep Learning, will walk you through using neur ...

- 【Deep Learning Nanodegree Foundation笔记】第 0 课:课程计划

第一周 机器学习的类型,以及何时使用机器学习 我们将首先简单介绍线性回归和机器学习.这将让你熟悉这些领域的常用术语,你需要了解的技术进展,并了解深度学习在更大的机器学习背景中的位置. 直播:线性回归 ...

- 吴恩达《深度学习》-第一门课 (Neural Networks and Deep Learning)-第四周:深层神经网络(Deep Neural Networks)-课程笔记

第四周:深层神经网络(Deep Neural Networks) 4.1 深层神经网络(Deep L-layer neural network) 有一些函数,只有非常深的神经网络能学会,而更浅的模型则 ...

- 【Deep Learning Nanodegree Foundation笔记】第 7 课:NEURAL NETWORKS Intro to Neural Networks

In this lesson, you'll dive deeper into the intuition behind Logistic Regression and Neural Networks ...

- Deep Learning.ai学习笔记_第五门课_序列模型

目录 第一周 循环序列模型 第二周 自然语言处理与词嵌入 第三周 序列模型和注意力机制 第一周 循环序列模型 在进行语音识别时,给定一个输入音频片段X,并要求输出对应的文字记录Y,这个例子中输入和输出 ...

随机推荐

- Android Freeline加速编译App方案 使用和总结

Freeline简单介绍 在Android Studio还没推出Instant Run功能之前,每次改动Android project项目时都要将整个项目又一次编译一次,然后再将资源和代码文件打包成A ...

- input text 去掉标签下拉提示autocomplete

autocomplete 属性 autocomplete 属性规定输入字段是否应该启用自动完成功能. 自动完成允许浏览器预测对字段的输入.当用户在字段开始键入时,浏览器基于之前键入过的值,应该显示出在 ...

- Linux Load average负载详细解释

http://tianmaotalk.iteye.com/blog/1027970 Linux Load average负载详细解释 linux查看机器负载

- DevExpress SpinEdit控件使用实例——删除ASPxSpinEdit右边的上下小箭头SpinButtons-ShowIncrementButtons

使用ASPxSpinEdit来添加数字类型的输入框: 默认情况下, SpinEdit通过点击右边的上下箭头来加减number,下面的代码是去掉上下箭头,内容居中显示,并将边框颜色置为白色: <d ...

- js闭包避免内存泄漏 减少内存使用 避免对象无法回收注意事项

闭包 如果闭包的作用域中保存着一个 HTML 元素,则该元素无法被销毁.(下面代码来自高程) 闭包是 JavaScript 开发的一个关键方面:匿名函数可以访问父级作用域的变量. function a ...

- WebApi接口传参不再困惑(4):传参详解

前言:还记得刚使用WebApi那会儿,被它的传参机制折腾了好久,查阅了半天资料.如今,使用WebApi也有段时间了,今天就记录下API接口传参的一些方式方法,算是一个笔记,也希望能帮初学者少走弯路.本 ...

- docker容器互连

三种方式 1.使用容器连接的示例如下: $ docker run --name some-app --link itbilu-mysql:mysql -d application-that-uses- ...

- 李洪强iOS经典面试题31-解释垃圾回收的原理

李洪强iOS经典面试题31-解释垃圾回收的原理 问题 我们知道,Android 手机通常使用 Java 来开发,而 Java 是使用垃圾回收这种内存管理方式. 那么,ARC 和垃圾回收对比,有什么优点 ...

- Django-model进阶(中介模型,查询优化,extra,整体插入)

QuerySet 可切片 使用Python 的切片语法来限制查询集记录的数目 .它等同于SQL 的LIMIT 和OFFSET 子句. ? 1 >>> Entry.objects.al ...

- js将秒数换算成时分秒

转载自:http://jingyan.baidu.com/article/375c8e19a0413925f2a229d2.html <script language="javascr ...