[Spark SQL] SparkSession、DataFrame 和 DataSet 练习

本課主題

- DataSet 实战

DataSet 实战

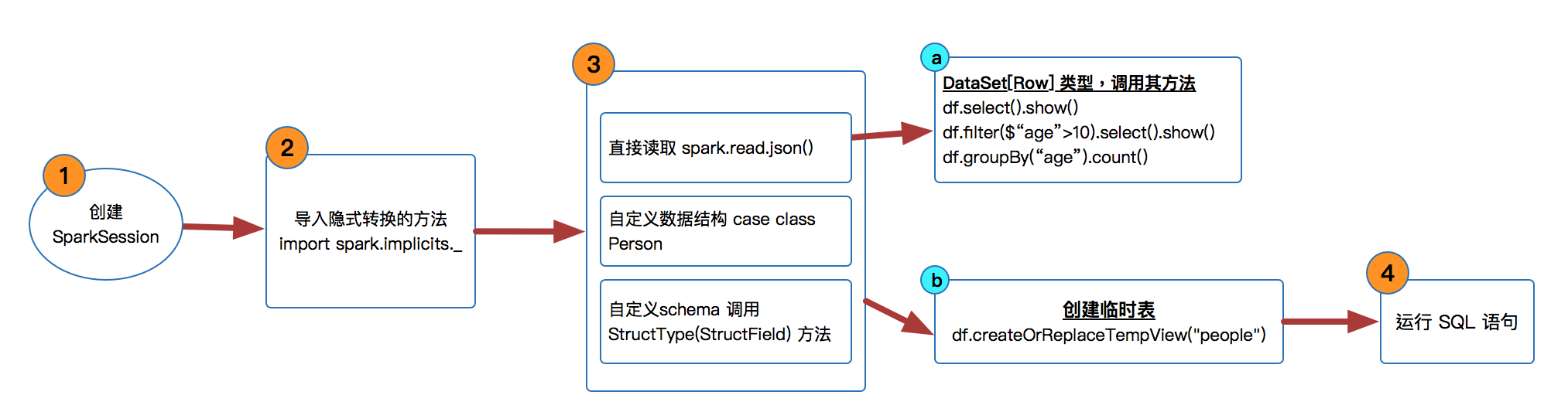

SparkSession 是 SparkSQL 的入口,然后可以基于 sparkSession 来获取或者是读取源数据来生存 DataFrameReader,在 Spark 2.x 版本中已经没有 DataFrame 的 API,它变成了 DataSet[Row] 类型的数据。

- 创建 SparkSession

val spark = SparkSession

.builder()

.master("local")

.appName("Spark SQL Basic Examples")

.getOrCreate() - 导入隐式转换的方法

import spark.implicits._

import org.apache.spark.sql.types._ // 自定义schema时导入 创建 DataFrame 即 DataSet[Row] 类型数据。

val df = spark.read.json("src/main/resources/general/people.json")- 可以直接调用 DataFrame 很多很好用的方法,比如 select( ),filter( ),groupBy( )

df.show() //打印数据,默认是前20条数据

df.printSchema()

df.select("name").show() //提取column是name的数据

df.select($"name",$"age" + 1).show() //提取column是name和age+1的数据

df.filter($"age" > 25).select("name").show()

df.groupBy($"age").count().show()

- 可以直接调用 DataFrame 很多很好用的方法,比如 select( ),filter( ),groupBy( )

- 也可以自定义 case class 来创建 DataSet[Row] 类型

val personDF = sc.textFile("src/main/resources/general/people.txt") //personRDD

.map(x => x.split(",")) //Array[String] = Array(name, age)

.map(attr => Person(attr(0),attr(1).trim().toInt))

.toDF() - 或者用自定义 schema 的方式

val schemaString = "name,age"

val fields = schemaString.split(",").map(fieldName => StructField(fieldName, StringType, nullable = true))

val schema = StructType(fields) val personRDD = sc.textFile("src/main/resources/general/people.txt") //personRDD

val rowRDD = personRDD.map(_.split(",")).map(attr => Row(attr(0),attr(1).trim()))

val personDF = spark.createDataFrame(rowRDD,schema) 或者是调用 createOrReplaceTempView 方法来创建临时表运行 SQL

personDF.createOrReplaceTempView("people")

val sqlDF = spark.sql("SELECT * FROM people")

sqlDF.map(people => "Name: " + people(0)).show()

參考資料

资料来源来至 Spark 官方网站

[Spark SQL] SparkSession、DataFrame 和 DataSet 练习的更多相关文章

- spark结构化数据处理:Spark SQL、DataFrame和Dataset

本文讲解Spark的结构化数据处理,主要包括:Spark SQL.DataFrame.Dataset以及Spark SQL服务等相关内容.本文主要讲解Spark 1.6.x的结构化数据处理相关东东,但 ...

- Spark SQL、DataFrame和Dataset——转载

转载自: Spark SQL.DataFrame和Datase

- Spark学习之路(八)—— Spark SQL 之 DataFrame和Dataset

一.Spark SQL简介 Spark SQL是Spark中的一个子模块,主要用于操作结构化数据.它具有以下特点: 能够将SQL查询与Spark程序无缝混合,允许您使用SQL或DataFrame AP ...

- Spark 系列(八)—— Spark SQL 之 DataFrame 和 Dataset

一.Spark SQL简介 Spark SQL 是 Spark 中的一个子模块,主要用于操作结构化数据.它具有以下特点: 能够将 SQL 查询与 Spark 程序无缝混合,允许您使用 SQL 或 Da ...

- spark算子之DataFrame和DataSet

前言 传统的RDD相对于mapreduce和storm提供了丰富强大的算子.在spark慢慢步入DataFrame到DataSet的今天,在算子的类型基本不变的情况下,这两个数据集提供了更为强大的的功 ...

- Spark SQL 之 DataFrame

Spark SQL 之 DataFrame 转载请注明出处:http://www.cnblogs.com/BYRans/ 概述(Overview) Spark SQL是Spark的一个组件,用于结构化 ...

- 转】Spark SQL 之 DataFrame

原博文出自于: http://www.cnblogs.com/BYRans/p/5003029.html 感谢! Spark SQL 之 DataFrame 转载请注明出处:http://www.cn ...

- Spark RDD、DataFrame和DataSet的区别

版权声明:本文为博主原创文章,未经博主允许不得转载. 目录(?)[+] 转载请标明出处:小帆的帆的专栏 RDD 优点: 编译时类型安全 编译时就能检查出类型错误 面向对象的编程风格 直接通过类 ...

- Spark官方1 ---------Spark SQL和DataFrame指南(1.5.0)

概述 Spark SQL是用于结构化数据处理的Spark模块.它提供了一个称为DataFrames的编程抽象,也可以作为分布式SQL查询引擎. Spark SQL也可用于从现有的Hive安装中读取数据 ...

随机推荐

- Python Django CMDB项目实战之-2创建APP、建模(models.py)、数据库同步、高级URL、前端页面展示数据库中数据

基于之前的项目代码来编写 Python Django CMDB项目实战之-1如何开启一个Django-并设置base页index页文章页面 现在我们修改一个文章列表是从数据库中获取数据, 下面我们就需 ...

- day01_使用Android Studio创建第一个Android项目

使用Android Studio开发Android项目如此简单 watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQv/font/5a6L5L2T/fontsize ...

- 重要经验五:block作为属性的注意事项

现代ios应用的开发.不使用GCD和block,效率会减少非常多,在今年3月份之前,我在block的学习和使用方面,精力和经验都明显不足,在SF有个牛逼同事.不仅自己积累了一套库,并且对这个库持续进行 ...

- [源码]解析 SynchronousQueue 上界,下界.. 数据保存和数据传递. 堵塞队列. 有无频繁await?

简析SynchronousQueue.LinkedBlockingQueue(两个locker,更快),ArrayBlockingQueue(一个locker,读写都竞争) 三者都是bloc ...

- 关于React组件之间如何优雅地传值的探讨

闲话不多说,开篇撸代码,你可以会看到类似如下的结构: import React, { Component } from 'react'; // 父组件 class Parent extends Com ...

- SGD

using System; using System.Collections.Generic; using System.Linq; using System.Text; using System.T ...

- .NET 绝对路径的配置

有时候因为用IIS配置网站,会导致一些全局引用有路径问题无法引用到.今天就说一下,关于全局引用的绝对路径的配置,譬如,由于IIS配置的虚拟路径,一些CSS,JS的引用找不到,又或者自定义的一些跳转出现 ...

- Java实现的电脑已连接WiFi热点的导入导出小工具

很多时候我们电脑连接了很多无线WiFi,只要连接过一次,电脑就会记下该热点的密码,方便我们下一次连接.但是问题来了,一旦我们重装系统,之前连接过的WiFi就丢失了,想要连接就得再输入密码,为了 解决这 ...

- 37、mysql初识

之前我们写代码需要存取信息时用的是文件可是用文件存取数据非常局限,今天我们将走进一个新的世界mysql 一.数据库由来 之前所学,数据要永久保存,比如用户注册的用户信息,都是保存于文件中,而文件只能存 ...

- IOS学习4——block代码块

本文转载自:iOS开发-由浅至深学习block 一.关于block 在iOS 4.0之后,block横空出世,它本身封装了一段代码并将这段代码当做变量,通过block()的方式进行回调.这不免让我们想 ...