爬虫-selenium的使用

安装

pip install selenium

开始

# coding=utf-8

from selenium import webdriver # 引用selenium库

import time # 实例化一个浏览器

driver = webdriver.Chrome()

# 请求网页地址

driver.get("http://www.baidu.com")

# 元素定位方法

driver.find_element_by_id("kw").send_keys("python")

driver.find_element_by_id("su").click() # 退出浏览器

time.sleep(3)

driver.quit()

报错

raceback (most recent call last):

File "D:/python_work/18-20爬虫代码V3.1/爬虫代码V3.1/day06/code/01_try_selenium.py", line 6, in <module>

driver = webdriver.Chrome()

File "D:\Programs\Python\Python35\lib\site-packages\selenium\webdriver\chrome\webdriver.py", line 73, in __init__

self.service.start()

File "D:\Programs\Python\Python35\lib\site-packages\selenium\webdriver\common\service.py", line 83, in start

os.path.basename(self.path), self.start_error_message)

selenium.common.exceptions.WebDriverException: Message: 'chromedriver' executable needs to be in PATH. Please see https://sites.google.com/a/chromium.org/chromedriver/home

原因:没有安装chromedriver

chromedriver下载地址:https://chromedriver.storage.googleapis.com/index.html

解压缩

unzip chromedriver_linux64.zip

把文件夹移动到/usr/bin目录下

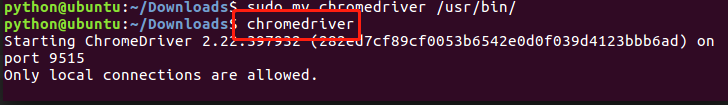

sudo mv chromedriver /usr/bin/

测试是否成功

继续运行代码,成功

selenium用法

# coding=utf-8

from selenium import webdriver # 引用selenium库

import time # 实例化一个浏览器

driver = webdriver.Chrome()

# 请求网页地址

driver.get("http://www.baidu.com")

# 最大化窗口

# driver.maximize_window()

# 自定义窗口大小

driver.set_window_size("","")

# 保存图片

driver.save_screenshot('./baidu.png') # 元素定位方法

driver.find_element_by_id("kw").send_keys("python")

driver.find_element_by_id("su").click() # 请求

# 获取cookies

cookies = driver.get_cookies()

cookies = {i["name"]:i["value"] for i in cookies}

print(cookies)

# 获取网页elenments 即 html字符串

html = driver.page_source

print(html)

# 获取当前请求的url

current_url = driver.current_url

print(current_url) # 退出当前页面

driver.close()

# 退出浏览器

driver.quit()

find_element

# coding=utf-8

from selenium import webdriver

import time driver = webdriver.Chrome()

driver.get("https://www.baidu.com/s?ie=UTF-8&wd=python") # find_element和find_elements区别

# find_element返回一个对象,如果没有会报错

# find_elements返回一个对象集组成的列表,如果没有返回一个空列表 # 获取内容块列表

ret = driver.find_elements_by_xpath("//div[@id='content_left']//div[contains(@class,'c-container')]")

# by_xpath中获取属性需要使用get_attribute()

for i in ret:

# print(i.get_attribute('srcid'))

pass

# by_xpath中获取文本钥匙用text 注:不是text()

# 获取"下一页>"文本所在的链接

print(driver.find_elements_by_link_text("下一页>")[0].get_attribute("href"))

# 获取含有"下一页"文字的文本所在的链接

print(driver.find_element_by_partial_link_text("下一页").get_attribute("href"))

# 根据表签名获取内容

ret1 = driver.find_elements_by_tag_name("h3")

for i in ret1:

# print(i.text)

pass

# 根据class获取内容

ret2 = driver.find_elements_by_class_name("c-container")

print(ret2)

# 获取css选择器

print(driver.find_element_by_class_name("table,img")) driver.quit()

frame操作

# coding=utf-8

from selenium import webdriver

import time driver = webdriver.Chrome()

driver.get("https://mail.qq.com") # 切换到iframe

driver.switch_to.frame("login_frame")

# 如果没有切换到iframe的话 会找不到元素而报错

driver.find_element_by_id("u").send_keys("") time.sleep(3)

driver.quit()

爬虫-selenium的使用的更多相关文章

- [Python爬虫] Selenium实现自动登录163邮箱和Locating Elements介绍

前三篇文章介绍了安装过程和通过Selenium实现访问Firefox浏览器并自动搜索"Eastmount"关键字及截图的功能.而这篇文章主要简单介绍如何实现自动登录163邮箱,同时 ...

- [Python爬虫] Selenium+Phantomjs动态获取CSDN下载资源信息和评论

前面几篇文章介绍了Selenium.PhantomJS的基础知识及安装过程,这篇文章是一篇应用.通过Selenium调用Phantomjs获取CSDN下载资源的信息,最重要的是动态获取资源的评论,它是 ...

- [Python爬虫] Selenium获取百度百科旅游景点的InfoBox消息盒

前面我讲述过如何通过BeautifulSoup获取维基百科的消息盒,同样可以通过Spider获取网站内容,最近学习了Selenium+Phantomjs后,准备利用它们获取百度百科的旅游景点消息盒(I ...

- [Python爬虫] Selenium爬取新浪微博客户端用户信息、热点话题及评论 (上)

转载自:http://blog.csdn.net/eastmount/article/details/51231852 一. 文章介绍 源码下载地址:http://download.csdn.net/ ...

- python爬虫---selenium库的用法

python爬虫---selenium库的用法 selenium是一个自动化测试工具,支持Firefox,Chrome等众多浏览器 在爬虫中的应用主要是用来解决JS渲染的问题. 1.使用前需要安装这个 ...

- [python爬虫] Selenium常见元素定位方法和操作的学习介绍

这篇文章主要Selenium+Python自动测试或爬虫中的常见定位方法.鼠标操作.键盘操作介绍,希望该篇基础性文章对你有所帮助,如果有错误或不足之处,请海涵~同时CSDN总是屏蔽这篇文章,再加上最近 ...

- [python爬虫] Selenium常见元素定位方法和操作的学习介绍(转载)

转载地址:[python爬虫] Selenium常见元素定位方法和操作的学习介绍 一. 定位元素方法 官网地址:http://selenium-python.readthedocs.org/locat ...

- 笔记-爬虫-selenium常用方法

笔记-爬虫-selenium常用方法 1. 查找元素 常用的查找方法 find_element_by_name find_element_by_xpath find_element_by_l ...

- Python爬虫-selenium的使用(2)

使用selenium打开chrome浏览器百度进行搜索 12345678910111213141516171819202122232425 from selenium import webdriver ...

- [Python爬虫] Selenium自动访问Firefox和Chrome并实现搜索截图

前两篇文章介绍了安装,此篇文章算是一个简单的进阶应用吧!它是在Windows下通过Selenium+Python实现自动访问Firefox和Chrome并实现搜索截图的功能. [Pyth ...

随机推荐

- CSP2019蒸馏记

Day -\(\infty\) ~ Day -2 认真准备联赛. Day -1 复习模板,全真模拟比赛平衡树 下午进行了湖南大学 2 小时游. Day 0 上午睡过头了 下午日常训练,并没有什么开放日 ...

- oracle--drop user 和 drop user cascade 的区别【转载】

drop user : 仅仅是删除用户, drop user ×× cascade :会删除此用户名下的所有表和视图. user Specify the user to be dropped. Ora ...

- .NET CORE编写控制台程序应有的优雅姿势(转载)

原文地址:https://www.cnblogs.com/zuowj/p/11107243.html 本文所说的编写控制台程序应有的“正确”方法,我把正确二字加上引号,因为没有绝对的正确,因人而异,因 ...

- Maven 教程(22)— Maven中 plugins 和 pluginManagement

原文地址https://blog.csdn.net/liupeifeng3514/article/details/80236827 plugins和pluginManagement的区别概述plugi ...

- 【Oracle】重做undo表空间

重做undo表空间 场景: alert日志,报了如下错误: [oraprod@arpinfo bdump]$ tail -f alert_PROD.log Errors in file /ora115 ...

- 小记:iterator && auto

小记:iterator && auto iterator 众所周知,我们有一种强大的东西,它叫做STL,比如queue.vector.set.map.multimap .deque等. ...

- DFRobot模块物联网演示项目整合

简介 本文是此次物联网项目的终结篇.本文将演示如何整合之前的文章中的模块和代码,来简单的完成一个物联网项目.最终的实现效果是:利用Iphone手机上的MQTTool App,来获取DHT11的温湿度数 ...

- 去掉eslint代码校验

找到.eslintrc文件,去掉extend下面的'@vue/standard'.

- 1-Kong文章记录

参考: https://www.cnblogs.com/duanxz/p/9770645.html 系列博客可参考: 开源API网关系统(Kong教程)入门到精通 https://www.cnblog ...

- C++中的Point类与vector类的简单处理

首先设计Vector与Point的表示方法,再依次完善两个类中的构造函数,复制构造函数等. 向量由两个点表示,当进行运算的时候,转化起点坐标为(0,0): 第14行:由于Vector需要用到Point ...