Spark Streaming处理Flume数据练习

把Flume Source(netcat类型),从终端上不断给Flume

Source发送消息,Flume把消息汇集到Sink(avro类型),由Sink把消息推送给Spark Streaming并处理后输出

版本信息:spark2.4.0 Flume 1.7.0

(基于pyspark)

一、Flume安装

①、文件导入

# 将apache-flume-1.7.0-bin.tar.gz解压到/usr/local目录下

sudo tar -zxvf apache-flume-1.7.0-bin.tar.gz -C /usr/local

#将解压的文件修改名字为flume,简化操作

sudo mv ./apache-flume-1.7.0-bin ./flume

#把/usr/local/flume目录的权限赋予当前登录Linux系统的用户,这里假设是hadoop用户

sudo chown -R hadoop:hadoop ./flume

②、变量配置

#配置环境变量

sudo vim ~/.bashrc

#加入下面路径

export FLUME_HOME=/usr/local/flume

export FLUME_CONF_DIR=$FLUME_HOME/conf

export PATH=$PATH:$FLUME_HOME/bin

③、flume-env.sh 配置文件修改

cd /usr/local/flume/conf

sudo cp ./flume-env.sh.template ./flume-env.sh

sudo vim ./flume-env.sh

#加入java路径,根据各自路径配置

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64;

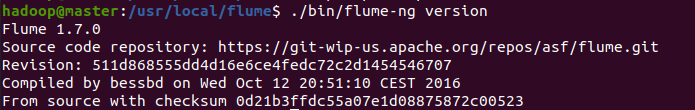

④、查看Flume版本

cd /usr/local/flume

./bin/flume-ng version

二、Avro中anent配置文件建立

cd /usr/local/flume/conf2.sudo

vim ./flume-to-spark.conf

新建文件flume-to-spark.conf

# Name the components on this agent

a1.sources = r1

a1.sinks = k1

a1.channels = c1

#receive message from port 33333

# Describe/configure the source

a1.sources.r1.type = netcat

a1.sources.r1.bind = localhost

a1.sources.r1.port = 33333

#send message through port 44444

a1.sinks.k1.type = avro

a1.sinks.k1.hostname = localhost

a1.sinks.k1.port = 44444

# Use a channel which buffers events in memory

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000000

a1.channels.c1.transactionCapacity = 1000000

# Bind the source and sink to the channel

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

1.Flume suorce类为netcat,绑定到localhost的33333端口, 消息可以通过telnet localhost 33333 发送到flume suorce

2.Flume Sink类为avro,绑定44444端口,flume sink通过 localhost 44444端口把消息发送出来。而spark streaming程序一直监听44444端口。

三、spark配置

①、下载spark-streaming-kafka-0-8_2.11-2.4.0.jar

2.11对应scala,2.4.0对应spark版本(根据自己配置版本下载)

下载地址:

把这个jar文件放到/usr/local/spark/jars/flume目录下

②、sudo cp ./spark-streaming-kafka-0-8_2.11-2.4.0.jar /usr/local/spark/jars/flume/

③、修改spark目录下conf/spark-env.sh文件中的SPARK_DIST_CLASSPATH变量.把flume的相关jar包添加到此文件中。

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoopclasspath):$(/usr/local/hbase/bin/hbaseclasspath):/usr/local/spark/jars/flume/*:/usr/local/flume/lib/*

四、编写spark程序使用Flume数据源

创建python文件

cd /usr/local/spark/mycode

mkdir flume

cd flume

sudo vim FlumeEventCount.py

代码如下:

from __future__ import print_function

import sys

from pyspark import SparkContext

from pyspark.streaming import StreamingContext

from pyspark.streaming.flume import FlumeUtils

import pyspark

if __name__ == "__main__":

if len(sys.argv) != 3:

print("Usage: flume_wordcount.py <hostname> <port>", file=sys.stderr)

exit(-1)

sc = SparkContext(appName="FlumeEventCount")

ssc = StreamingContext(sc, 10)

hostname= sys.argv[1]

port = int(sys.argv[2])

stream=FlumeUtils.createStream(ssc,hostname,port,pyspark.StorageLevel.MEMORY_AND_DISK_SER_2)

stream.pprint()

stream.count().map(lambda cnt : "Recieve " + str(cnt) +" Flume events!!!!").pprint()

ssc.start()

ssc.awaitTermination()

五、效果测试

首先启动Spark streaming程序(基于pyspark) (终端1)

入参为本地localhose 端口44444(该端口对应flume-to-spark.conf中的sinks端口)

/usr/local/spark/bin/spark-submit --driver-class-path /usr/local/spark/jars/*:/usr/local/spark/jars/flume/* ./FlumeEventCount.py localhost 44444

然后启动一个新的终端,启动Flume Agent (终端2)

cd /usr/local/flume

bin/flume-ng agent --conf ./conf --conf-file ./conf/spark-streaming.conf --name a1 -Dflume.root.logger=INFO,console

最后再启动一个新的终端连接33333端口 (终端3)

telnet localhost 33333#输入hello world

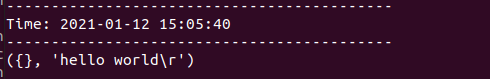

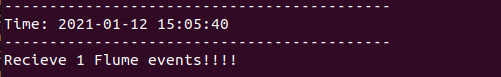

终端1结果如下:(分开返回两条信息)

学习交流,有任何问题还请随时评论指出交流。

Spark Streaming处理Flume数据练习的更多相关文章

- spark streaming集成flume

1. 安装flume flume安装,解压后修改flume_env.sh配置文件,指定java_home即可. cp hdfs jar包到flume lib目录下(否则无法抽取数据到hdfs上): $ ...

- Spark学习之路(十五)—— Spark Streaming 整合 Flume

一.简介 Apache Flume是一个分布式,高可用的数据收集系统,可以从不同的数据源收集数据,经过聚合后发送到分布式计算框架或者存储系统中.Spark Straming提供了以下两种方式用于Flu ...

- Spark 系列(十五)—— Spark Streaming 整合 Flume

一.简介 Apache Flume 是一个分布式,高可用的数据收集系统,可以从不同的数据源收集数据,经过聚合后发送到分布式计算框架或者存储系统中.Spark Straming 提供了以下两种方式用于 ...

- 通过Spark Streaming处理交易数据

Apache Spark 是加州大学伯克利分校的 AMPLabs 开发的开源分布式轻量级通用计算框架. 由于 Spark 基于内存设计,使得它拥有比 Hadoop 更高的性能(极端情况下可以达到 10 ...

- Spark Streaming 整合 Flume

Spark Streaming 整合 Flume 一.简介二.推送式方法 2.1 配置日志收集Flume 2.2 项目依赖 2.3 Spark Strea ...

- Spark Streaming揭秘 Day16 数据清理机制

Spark Streaming揭秘 Day16 数据清理机制 今天主要来讲下Spark的数据清理机制,我们都知道,Spark是运行在jvm上的,虽然jvm本身就有对象的自动回收工作,但是,如果自己不进 ...

- Spark Streaming接收Kafka数据存储到Hbase

Spark Streaming接收Kafka数据存储到Hbase fly spark hbase kafka 主要参考了这篇文章https://yq.aliyun.com/articles/60712 ...

- Spark Streaming从Flume Poll数据案例实战和内幕源码解密

本节课分成二部分讲解: 一.Spark Streaming on Polling from Flume实战 二.Spark Streaming on Polling from Flume源码 第一部分 ...

- cdh环境下,spark streaming与flume的集成问题总结

文章发自:http://www.cnblogs.com/hark0623/p/4170156.html 转发请注明 如何做集成,其实特别简单,网上其实就是教程. http://blog.csdn.n ...

随机推荐

- 使用MySQL乐观锁解决超卖问题

在秒杀系统设计中,超卖是一个经典.常见的问题,任何商品都会有数量上限,如何避免成功下订单买到商品的人数不超过商品数量的上限,这是每个抢购活动都要面临的难点. 1 超卖问题描述 在多个用户同时发起对同一 ...

- 如何写好PPT,什么样的PPT容易被人理解记住

PPT一般是用于讲解性的行为而存在,那如果写好PPT呢?如果写好,这个完全要取决于你所面向的目标读者,是用于学术行为呢?还是用于商业行为.面对不同的目标群体,有不同的策略.但是无论面向群体是谁我们都有 ...

- 情话爬虫工具[windows版]

有没有在气氛暧昧的情况下想说点什么却又无话可说?女朋友有没有抱怨过你,只会写代码,一点都不懂情调?这次,是时候要改变她对你的看法了!一键爬取情话,情话全都躺在txt里面.想怎么玩就怎么玩!张口一句情话 ...

- VMware Workstation 16中安装macOS Big Sur,AMD版

VMware Workstation 16中安装macOS Big Sur,AMD版 目录 VMware Workstation 16中安装macOS Big Sur,AMD版 准备阶段 步骤一:安装 ...

- IDEA将Java Web项目打war包

准备工作 1.IntelliJ IDEA开发工具 2.可以正常运行的Java Web项目 打war包流程 1.使用快捷键Ctrl+Alt+Shift+s 或者 鼠标点击选中项目名按F4 打开 Proj ...

- Java中中文排序器

在Java中使用Collator类按照汉字拼音排序字符串 public static void main(String[] args) throws Exception{ String[] strs ...

- HBase删除数据

hbase官方文档中描述了,hbase删除数据可以总结为下面三种(Java API有很多接口,可以总结下面的几种): 删除一个列的指定版本 删除一个列的所用版本 删除指定列族的所有列 hbase删除数 ...

- 使用vika维格表来管理寺庙原来如此轻松~

我有一款适合用于寺庙管理的软件推荐,它是vika维格表,一款一站式的项目管理工具. 一站式项目管理 一个小小的寺庙需要管理的内容也非常的多,你应该不会购买多个系统去管理不同的项目,这样会让寺庙的花费大 ...

- 如何push一个docker镜像到DockerHub上

在DockerHub上创建账号:https://hub.docker.com/ 这里我的账号是firewarm 本地下载镜像(这里拿alpine做示例),并为镜像打tag [root@host-30 ...

- Web服务器-并发服务器-多进程(3.4.1)

@ 目录 1.优化分析 2.代码 3. 关于作者 1.优化分析 在单进程的时候,相当于 是来一个客户,派一个人去服务一下 效率低,现在使用多进程来服务 假设场景 100个人同时访问页面 单进程:一次处 ...