斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时6

课时6 线性分类器损失函数与最优化(上)

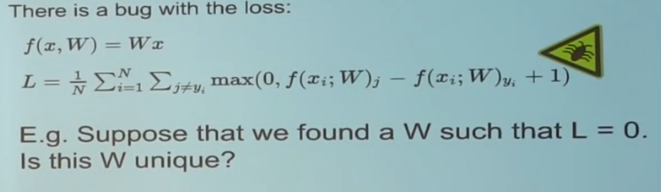

多类SVM损失:这是一个两分类支持向量机的泛化

SVM损失计算了所有不正确的例子,将所有不正确的类别的评分,与正确类别的评分之差加1,将得到的数值与0作比较,取两者中的最大值。然后将所有的数值进行求和。用平均值来代替不会影响结果。

这些评分都是无标度的,因为我们可以随便选择W,让它成比例地增大或者减小,然后分数也随之成比例地变化。所以分数的大小和它的量度的选择紧密相关,将安全系数的值设为1在某种程度上来说只是一个随意的选择。

在实际的数据集中使用这个损失函数,可能会有一些我们不太希望的性质。我们现在有整个W空间,并且根据这个损失函数他们的工作方式都是相同的,我们希望对于所有W而言有一部分的W是有优先权的,这一优先权基于我们希望W拥有的特点,不用去管数据集,只关心使W达到最优的特点。

正则化

可以用它来处理我们的损失函数,加上了一项正则化函数R(W),而R(W)衡量了W的好坏,我们不仅仅想要数据拟合得更好,也希望能优化W,所以我们找到了一些方法来证明他们是确实有效的,事实上,正则化是为了权衡你的训练损失和你用于测试集的泛化损失,所以正则化是一系列通过损失来使目标相加的技术。

L2正则化要做的就是尽可能地展开w权重,以便于考虑到所有输入特征或者说所有的像素,并且尽可能地利用这些维度

为什么要用正则化?

假设你有多组权重可以得到相同分数,我们想以某种方式选出最好的。

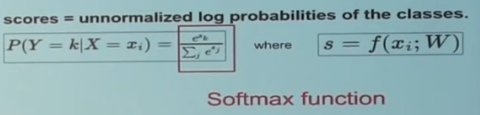

Softmax分类器

也就是一般化的逻辑斯蒂回归,他是在这些分数的基础上表明损失的一种不同的函数形式,这种解释就是说他是在这些分数基础上实现的,这些分数不是随机的,也不是表明某种边界。从一个问题出发,我们有特定的解读方式,这种方式有一定的规则,这些分数是对应不同类未经标准化的对数概率。

斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时6的更多相关文章

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时3

课时3 计算机视觉历史回顾与介绍下 ImageNet有5000万张图片,全部都是人工清洗过得,标注了超过2万个分类. CS231n将聚焦于视觉识别问题,图像分类关注的是大图整体:物体检测告诉你东西具体 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时1

课时1 计算机视觉历史回顾与介绍上 CS231n:这一一门关于计算机视觉的课程,基于一种专用的模型架构,叫做神经网络(更细一点说,是卷积神经网络CNN).计算机视觉是人工智能领域中发展最为迅猛的一个分 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时26&&27

课时26 图像分割与注意力模型(上) 语义分割:我们有输入图像和固定的几个图像分类,任务是我们想要输入一个图像,然后我们要标记每个像素所属的标签为固定数据类中的一个 使用卷积神经,网络为每个小区块进行 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时24&&25

课时24 深度学习开源库使用介绍(上) Caffe 被用于重新实现AlexNet,然后用AlexNet的特征来解决其他事情 用C++书写的,可以去GitHub上面读取源代码 主要四个类: Blob可以 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时8&&9

课时8 反向传播与神经网络初步(上) 反向传播在运算连路中,这是一种通过链式法则来进行递推的计算过程,这个链路中的每一个中间变量都会对最终的损失函数产生影响. 链式法则通常包含两部分,局部梯度和后一层 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时12&&13

课时12 神经网络训练细节part2(上) 训练神经网络是由四步过程组成,你有一个完整的数据集图像和标签,从数据集中取出一小批样本,我们通过网络做前向传播得到损失,告诉我们目前分类效果怎么样.然后我们 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时11

课时11 神经网络训练细节part1(下) 2010年,Glorot等人写的论文,我们称之为Xavier初始化,他们关注了神经元的方差表达式.他们推荐一种初始化方式,那就是对每个神经元的输入进行开根号 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时10

课时10 神经网络训练细节part1(上) 没有大量的数据也不会有太多影响,只需要找一个经过预训练的卷积神经网络然后进行调整 从数据集中抽样一小批数据, 将数据运入卷积神经网络中来计算损失值 通过反向 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时7

课时7 线性分类器损失函数与最优化(下) 我们为什么要最大化对数概率而非直接最大化概率? 你在做逻辑斯蒂回归时,如果你只是想要最大化概率,那你使用log是无意义的.因为log函数是单调函数,最大化概率 ...

- 斯坦福CS231n—深度学习与计算机视觉----学习笔记 课时14&&15

课时14 卷积神经网络详解(上) CNN处理的是一些数据块,在这之间有很多层,一系列的层将输入数据变换为输出数据,所以完成操作的中间量不仅是NN时候讲的那些向量,而是立体结构,有宽,高和深度,在整个计 ...

随机推荐

- 【转】Spring框架深入理解

参考这篇文章: http://www.ibm.com/developerworks/cn/java/j-lo-spring-principle/ Spring内部分为Beans, Context 和 ...

- OnlineJudge测试数据生成模板

int类型数据生成一(正数最多4位): #include <bits/stdc++.h> using namespace std; int main() { freopen("t ...

- JDBC连接MySQL数据库的示例代码

虽然老调,但有时也需要用一下,从网上找的原型修改了下放这. import java.sql.Connection; import java.sql.DriverManager; import java ...

- springmvc学习笔记(12)-springmvc注解开发之包装类型參数绑定

springmvc学习笔记(12)-springmvc注解开发之包装类型參数绑定 标签: springmvc springmvc学习笔记12-springmvc注解开发之包装类型參数绑定 需求 实现方 ...

- AppCan移动应用开发平台新增9个超有用插件(内含演示样例代码)

使用AppCan平台进行移动开发.你所须要具备的是Html5+CSS +JS前端语言基础.此外.Hybrid混合模式应用还需结合原生语言对功能模块进行封装,对于没有原生基础的开发人员,怎样实现App里 ...

- ubuntu如何修改root密码

安装完Ubuntu后忽然意识到没有设置root密码,不知道密码自然就无法进入根用户下.到网上搜了一下,原来是这麽回事.Ubuntu的默认root密码是随机的,即每次开机都有一个新的root密码.我们可 ...

- 通过/proc/cpuinfo判断CPU数量、Multicores、Multithreading、Hyper-threading

http://blog.sina.com.cn/s/blog_4a6151550100iowl.html 判断依据:1.具有相同core id的cpu是同一个core的超线程.2.具有相同physic ...

- uva 10806 Dijkstra, Dijkstra. (最小费最大流)

uva 10806 Dijkstra, Dijkstra. 题目大意:你和你的伙伴想要越狱.你的伙伴先去探路,等你的伙伴到火车站后,他会打电话给你(电话是藏在蛋糕里带进来的),然后你就能够跑去火车站了 ...

- mtk机型的一次救砖经历

在recovery里清除了data,cache,system三个分区,没有刷机,重启到bootloader,准备另刷recovery. 有急事走开了,回来时发现手机黑屏,无论什么组合键都没反应,以为是 ...

- 自定义UISearchDisplayController的“No Results“标签和”Cancel“按钮

本文转载至 http://www.cnblogs.com/pengyingh/articles/2350154.html - (void)searchDisplayControllerWillBegi ...