Hadoop & Spark & Hive & HBase

Hadoop:http://hadoop.apache.org/docs/r2.6.4/hadoop-project-dist/hadoop-common/SingleCluster.html

bin/hdfs namenode -formatsbin/start-dfs.sh

bin/hdfs dfs -mkdir /userbin/hdfs dfs -mkdir /user/<username>these are for testing:

bin/hdfs dfs -put etc/hadoop inputbin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.4.jar grep input output 'dfs[a-z.]+'bin/hdfs dfs -cat output/*testing results:

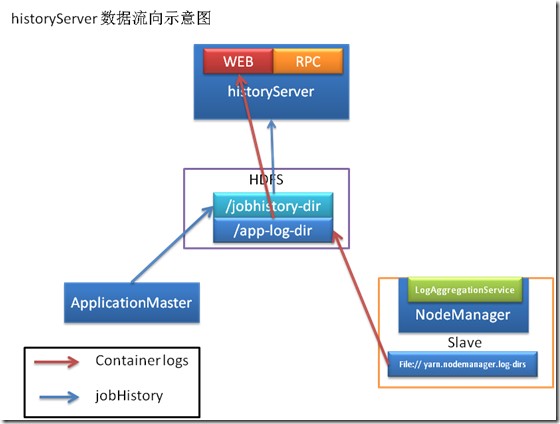

6 dfs.audit.logger4 dfs.class3 dfs.server.namenode.2 dfs.period2 dfs.audit.log.maxfilesize2 dfs.audit.log.maxbackupindex1 dfsmetrics.log1 dfsadmin1 dfs.servers1 dfs.replication1 dfs.fileHistoryServer

./sbin/mr-jobhistory-daemon.sh start historyserverSpark:start:

./sbin/start-slaves.sh spark://<your-computer-name>:7077You will see:

- Alive Workers: 1

This is for testing:

./bin/spark-shell --master spark://<your-computer-name>:7077You will see the scala shell.use :q to quit.

To see the history:

http://spark.apache.org/docs/latest/monitoring.html

http://blog.chinaunix.net/uid-29454152-id-5641909.html

http://www.cloudera.com/documentation/cdh/5-1-x/CDH5-Installation-Guide/cdh5ig_spark_configure.html

./sbin/start-history-server.sh

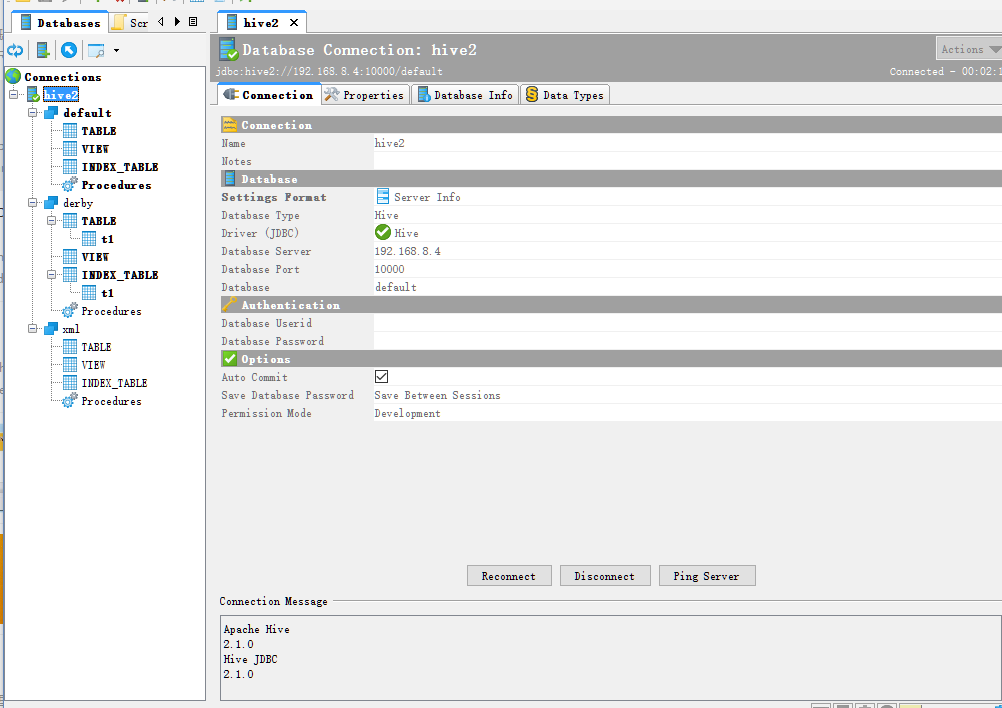

jdbc:mysql://localhost:3306/hivedb?useSSL=false&createDatabaseIfNotExist=true

nohup hiveserver2 &

User: is not allowed to impersonate anonymous (state=,code=0)

HWI WAR file not found at

Problem: failed to create task or type componentdef- Or:

./bin/start-hbase.sh

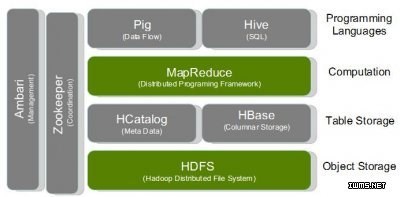

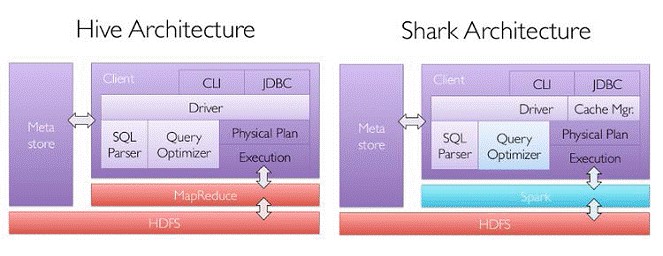

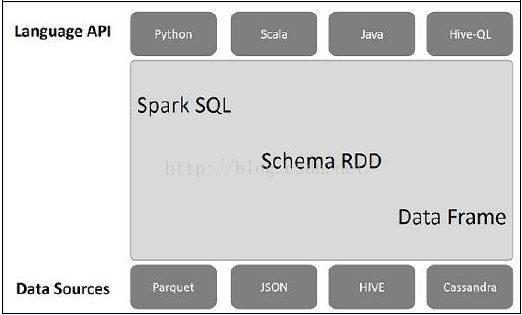

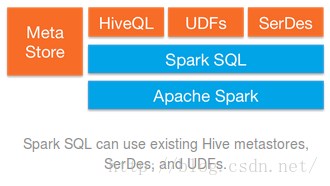

Hive & Shark & SparkSQL

Spark SQL架构如下图所示:

http://blog.csdn.net/wzy0623/article/details/52249187

- queryserver.py start

- jdbc:phoenix:thin:url=http://localhost:8765;serialization=PROTOBUF

phoenix-sqlline.py localhost:2181

Hadoop & Spark & Hive & HBase的更多相关文章

- 大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 图文详解

引言 在之前的大数据学习系列中,搭建了Hadoop+Spark+HBase+Hive 环境以及一些测试.其实要说的话,我开始学习大数据的时候,搭建的就是集群,并不是单机模式和伪分布式.至于为什么先写单 ...

- HADOOP+SPARK+ZOOKEEPER+HBASE+HIVE集群搭建(转)

原文地址:https://www.cnblogs.com/hanzhi/articles/8794984.html 目录 引言 目录 一环境选择 1集群机器安装图 2配置说明 3下载地址 二集群的相关 ...

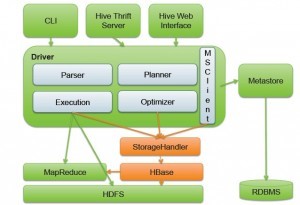

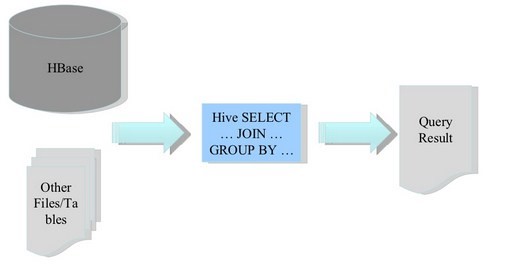

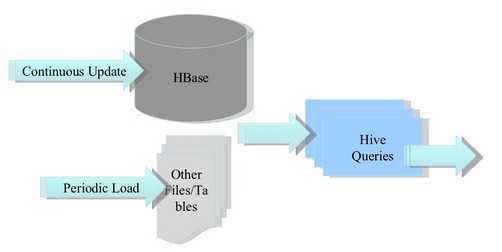

- hadoop之hive&hbase互操作

大家都知道,hive的SQL操作非常方便,但是查询过程中需要启动MapReduce,无法做到实时响应. hbase是hadoop家族中的分布式数据库,与传统关系数据库不同,它底层采用列存储格式,扩展性 ...

- 大数据学习系列之九---- Hive整合Spark和HBase以及相关测试

前言 在之前的大数据学习系列之七 ----- Hadoop+Spark+Zookeeper+HBase+Hive集群搭建 中介绍了集群的环境搭建,但是在使用hive进行数据查询的时候会非常的慢,因为h ...

- Hadoop + Hive + HBase + Kylin伪分布式安装

问题导读 1. Centos7如何安装配置? 2. linux网络配置如何进行? 3. linux环境下java 如何安装? 4. linux环境下SSH免密码登录如何配置? 5. linux环境下H ...

- 【原创】大叔问题定位分享(16)spark写数据到hive外部表报错ClassCastException: org.apache.hadoop.hive.hbase.HiveHBaseTableOutputFormat cannot be cast to org.apache.hadoop.hive.ql.io.HiveOutputFormat

spark 2.1.1 spark在写数据到hive外部表(底层数据在hbase中)时会报错 Caused by: java.lang.ClassCastException: org.apache.h ...

- Docker搭建大数据集群 Hadoop Spark HBase Hive Zookeeper Scala

Docker搭建大数据集群 给出一个完全分布式hadoop+spark集群搭建完整文档,从环境准备(包括机器名,ip映射步骤,ssh免密,Java等)开始,包括zookeeper,hadoop,hiv ...

- 大数据技术生态圈形象比喻(Hadoop、Hive、Spark 关系)

[摘要] 知乎上一篇很不错的科普文章,介绍大数据技术生态圈(Hadoop.Hive.Spark )的关系. 链接地址:https://www.zhihu.com/question/27974418 [ ...

- spark读取hbase形成RDD,存入hive或者spark_sql分析

object SaprkReadHbase { var total:Int = 0 def main(args: Array[String]) { val spark = SparkSession . ...

随机推荐

- WC2019退役记

sb题不会,暴力写不完,被全场吊着打,AFO

- 【性能测试】:JVM内存监控策略的方法,以及监控结果说明

JVM内存监控主要在稳定性压测期间,监控应用服务器内存泄露等问题: [JVM远程监控设置] 1.打开WAS控制台:https://ip:port/ibm/console/login.do 2.进入路径 ...

- Android之build.prop属性详解

注:本篇文章是基于MSD648项目(AndroidTV)的prop进行说明. Android版本:4.4.4 内核版本:3.10.86 1.生成build.prop build.prop的生成是由ma ...

- spring boot快速入门 10: 日志使用

第一步:pom 文件 <?xml version="1.0" encoding="UTF-8"?> <project xmlns=" ...

- c++ 网络编程(十) LINUX/windows 异步通知I/O模型与重叠I/O模型 附带示例代码

原文作者:aircraft 原文链接:https://www.cnblogs.com/DOMLX/p/9662931.html 一.异步IO模型(asynchronous IO) (1)什么是异步I/ ...

- 用table布局和div布局的区别

table布局的渲染是将整个table全部渲染出来,如果网路不给力的情况下,整个table会卡死在页面div布局的话,页面渲染,会一个一个的div渲染,网页出现会一个一个出来,不管网速怎样,不会全局卡 ...

- 构建流式应用—RxJS详解[转]

目录 常规方式实现搜索功能 RxJS · 流 Stream RxJS 实现原理简析 观察者模式 迭代器模式 RxJS 的观察者 + 迭代器模式 RxJS 基础实现 Observable Observe ...

- OpenTLD在VS2012和opencv246编译通过

最近看到了TLD的跟踪视频,觉得很有意思,刚好最近在看行人检测所以就打算下载源码玩一玩,因为源码是Linux版本的(原作者写的是C++和MATLAB的混合编程)C++源码可以在我的博客TLD(一种目标 ...

- [转]a-mongodb-tutorial-using-c-and-asp-net-mvc

本文转自:http://www.joe-stevens.com/2011/10/02/a-mongodb-tutorial-using-c-and-asp-net-mvc/ In this post ...

- springmvc 权限 测试版

参考博文 https://blog.csdn.net/u011277123/article/details/68940939 1.Listener加载权限信息 2.interceptor验证权限 测试 ...