[Python]jieba切词 添加字典 去除停用词、单字 python 2020.2.10

源码如下:

import jieba

import io

import re #jieba.load_userdict("E:/xinxi2.txt")

patton=re.compile(r'..') #添加字典

def add_dict():

f=open("E:/xinxi2.txt","r+",encoding="utf-8") #百度爬取的字典

for line in f:

jieba.suggest_freq(line.rstrip("\n"), True)

f.close() #对句子进行分词

def cut():

number=0

f=open("E:/luntan.txt","r+",encoding="utf-8") #要处理的内容,所爬信息,CSDN论坛标题

for line in f:

line=seg_sentence(line.rstrip("\n"))

seg_list=jieba.cut(line)

for i in seg_list:

print(i) #打印词汇内容

m=patton.findall(i)

#print(len(m)) #打印字符长度

if len(m)!=0:

write(i.strip()+" ")

line=line.rstrip().lstrip()

print(len(line))#打印句子长度

if len(line)>1:

write("\n")

number+=1

print("已处理",number,"行") #分词后写入

def write(contents):

f=open("E://luntan_cut2.txt","a+",encoding="utf-8") #要写入的文件

f.write(contents)

#print("写入成功!")

f.close() #创建停用词

def stopwordslist(filepath):

stopwords = [line.strip() for line in open(filepath, 'r', encoding='utf-8').readlines()]

return stopwords # 对句子进行去除停用词

def seg_sentence(sentence):

sentence_seged = jieba.cut(sentence.strip())

stopwords = stopwordslist('E://stop.txt') # 这里加载停用词的路径

outstr = ''

for word in sentence_seged:

if word not in stopwords:

if word != '\t':

outstr += word

#outstr += " "

return outstr #循环去除、无用函数

def cut_all():

inputs = open('E://luntan_cut.txt', 'r', encoding='utf-8')

outputs = open('E//luntan_stop.txt', 'a')

for line in inputs:

line_seg = seg_sentence(line) # 这里的返回值是字符串

outputs.write(line_seg + '\n')

outputs.close()

inputs.close() if __name__=="__main__":

add_dict()

cut()

luntan.txt的来源,地址:https://www.cnblogs.com/zlc364624/p/12285055.html

其中停用词可自行百度下载,或者自己创建一个txt文件夹,自行添加词汇用换行符隔开。

百度爬取的字典在前几期博客中可以找到,地址:https://www.cnblogs.com/zlc364624/p/12289008.html

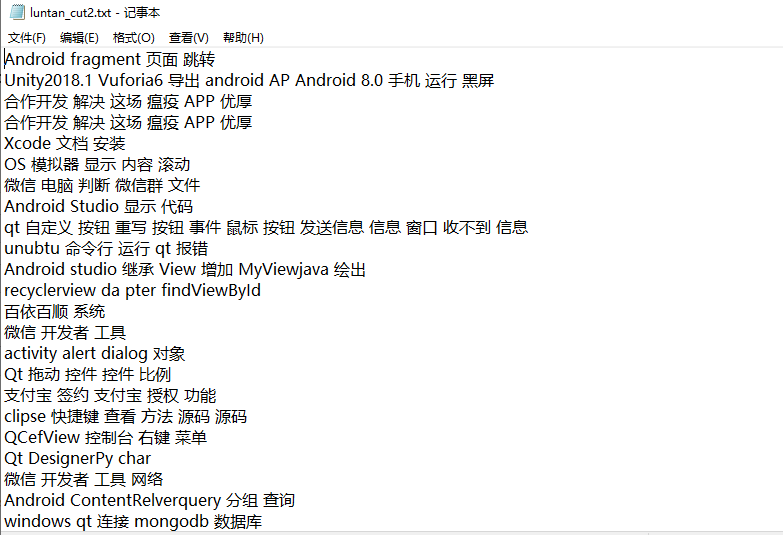

效果如下:

import jieba

import io

import re #jieba.load_userdict("E:/xinxi2.txt")

patton=re.compile(r'..') #添加字典

def add_dict():

f=open("E:/xinxi2.txt","r+",encoding="utf-8") #百度爬取的字典

for line in f:

jieba.suggest_freq(line.rstrip("\n"), True)

f.close() #对句子进行分词

def cut():

number=0

f=open("E:/luntan.txt","r+",encoding="utf-8") #要处理的内容,所爬信息,CSDN论坛标题

for line in f:

line=seg_sentence(line.rstrip("\n"))

seg_list=jieba.cut(line)

for i in seg_list:

print(i) #打印词汇内容

m=patton.findall(i)

#print(len(m)) #打印字符长度

if len(m)!=:

write(i.strip()+" ")

line=line.rstrip().lstrip()

print(len(line))#打印句子长度

if len(line)>:

write("\n")

number+=1

print("已处理",number,"行") #分词后写入

def write(contents):

f=open("E://luntan_cut2.txt","a+",encoding="utf-8") #要写入的文件

f.write(contents)

#print("写入成功!")

f.close() #创建停用词

def stopwordslist(filepath):

stopwords = [line.strip() for line in open(filepath, 'r', encoding='utf-8').readlines()]

return stopwords # 对句子进行去除停用词

def seg_sentence(sentence):

sentence_seged = jieba.cut(sentence.strip())

stopwords = stopwordslist('E://stop.txt') # 这里加载停用词的路径

outstr = ''

for word in sentence_seged:

if word not in stopwords:

if word != '\t':

outstr += word

#outstr += " "

return outstr #循环去除、无用函数

def cut_all():

inputs = open('E://luntan_cut.txt', 'r', encoding='utf-8')

outputs = open('E//luntan_stop.txt', 'a')

for line in inputs:

line_seg = seg_sentence(line) # 这里的返回值是字符串

outputs.write(line_seg + '\n')

outputs.close()

inputs.close() if __name__=="__main__":

add_dict()

cut()

[Python]jieba切词 添加字典 去除停用词、单字 python 2020.2.10的更多相关文章

- jieba文本分词,去除停用词,添加用户词

import jieba from collections import Counter from wordcloud import WordCloud import matplotlib.pyplo ...

- python去除停用词(结巴分词下)

python 去除停用词 结巴分词 import jieba #stopwords = {}.fromkeys([ line.rstrip() for line in open('stopword. ...

- (3.1)用ictclas4j进行中文分词,并去除停用词

酒店评论情感分析系统——用ictclas4j进行中文分词,并去除停用词 ictclas4j是中科院计算所开发的中文分词工具ICTCLAS的Java版本,因其分词准确率较高,而备受青睐. 注:ictcl ...

- python利用jieba进行中文分词去停用词

中文分词(Chinese Word Segmentation) 指的是将一个汉字序列切分成一个一个单独的词. 分词模块jieba,它是python比较好用的分词模块.待分词的字符串可以是 unicod ...

- 使用Python中的NLTK和spaCy删除停用词与文本标准化

概述 了解如何在Python中删除停用词与文本标准化,这些是自然语言处理的基本技术 探索不同的方法来删除停用词,以及讨论文本标准化技术,如词干化(stemming)和词形还原(lemmatizatio ...

- python编程基础知识—字典

字典 在python中,字典是一系列键-值对,每个键都与一个值相关联,可使用键来访问相关联的值.与键相关联的值可以是数字.字符串.列表乃至字典,即可将任何python对象用在字典中的值. 在pytho ...

- 如何在java中去除中文文本的停用词

1. 整体思路 第一步:先将中文文本进行分词,这里使用的HanLP-汉语言处理包进行中文文本分词. 第二步:使用停用词表,去除分好的词中的停用词. 2. 中文文本分词环境配置 使用的HanLP-汉 ...

- 词项邻近 & 停用词 & 词干还原

[词项邻近] 邻近操作符(proximity)用于指定查询中的两个词项应该在文档中互相靠近,靠近程度通常采用两者之间的词的个数或者是否同在某个结构单元(如句 子或段落)中出现来衡量. [停用词] 一些 ...

- python jieba分词(添加停用词,用户字典 取词频

中文分词一般使用jieba分词 1.安装 pip install jieba 2.大致了解jieba分词 包括jieba分词的3种模式 全模式 import jieba seg_list = jieb ...

随机推荐

- Thinkphp 前端视图输出日期时间戳自动转换为时间格式化年月日

需求:实现文章创建按年,月,日归类,并如图格式显示. 2018 年 11 月 ( 1 篇文章 ) 24日: 你走了真好,不然总担心你要走 (130) 05 月 ( 1 篇文章 ) 12日: 后来的我们 ...

- while 循环 实例

/*int i=0; while(i<100){// 循环条件 while先执行后循环 printf("while第%d遍循环体\n",i);//循环体 i++; } */ ...

- 【Java并发工具类】原子类

前言 为保证计数器中count=+1的原子性,我们在前面使用的都是synchronized互斥锁方案,加锁独占访问的方式未免太过霸道,于是我们来介绍另一种解决原子性问题的无锁方案:原子变量.在正式介绍 ...

- ASP .NET CORE 源码地址

ASP .NET CORE 源码地址:https://github.com/dotnet/ 下拉可以查找相应的源码信息, 例如:查找 ASP .NET CORE Microsoft.Extension ...

- 想学大学计算机课?这 37 门 CS 专业必修课,了解一下

最近,不少高校延迟开学,大家只能宅家上网课. 有一些朋友,想趁此期间,多学点计算机的专业课,却不知从何学起. 211,985大学的计算机专业课都是经过授课教师精心安排的,从大一到大四,课程合理设置,循 ...

- RX.js6变化

RX.js变化 RxJS 6主要用于Angular应用程序,从Angular 6开始,它是一个强制依赖. 与RxJS版本5相比,RxJS 6(或更高版本)引入了两个重要更改: 1. import的导入 ...

- djinn:1 Vulnhub Walkthrough

靶机下载链接: https://download.vulnhub.com/djinn/djinn.ova 主机端口扫描: FTP发现一些文件提示 1337端口是一个游戏,去看下 哈哈有点难,暂时放弃, ...

- opencv —— convexHull 寻找并绘制凸包

凸包的定义: 包含点集 S 所有点的最小凸多边形称为凸包. 凸包绘制原理:Graham 扫描法 首先选择 y 方向上最低的点作为起始点 p0. 然后以 p0 为原点,建立极坐标系,做逆时针极坐标扫描, ...

- Git的基本使用 -- 文件的添加、撤销、对比、删除

显示当前工作区.暂存区.仓库的状态 git status 当工作区的所有文件都提交到仓库,并和仓库保持一致时 有修改的文件时,会显示有改动的文件,并提示如何提交这些修改 添加到暂存区,还未提交到仓库时 ...

- Python 使用OS模块调用 cmd

在os模块中提供了两种调用 cmd 的方法,os.popen() 和 os.system()os.system(cmd) 是在执行command命令时需要打开一个终端,并且无法保存command命令的 ...