Flink 1.3.2 Standalone模式安装

一、依赖文件安装

1.1 JDK

参见博文:http://www.cnblogs.com/liugh/p/6623530.html

二、文件准备

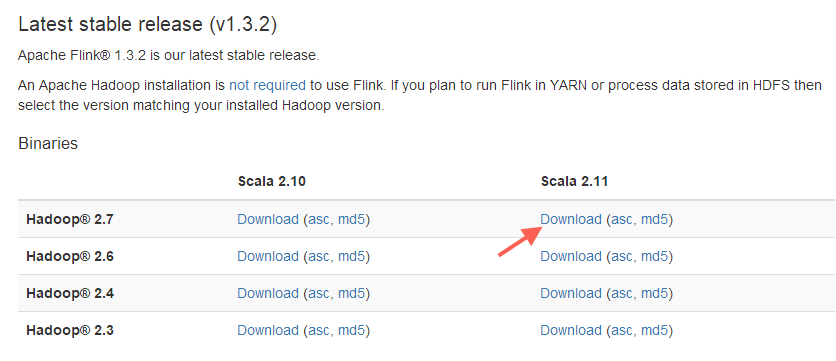

2.1 文件名称

flink-1.3.2-bin-hadoop27-scala_2.11.tgz

2.2 下载地址

http://flink.apache.org/downloads.html

三、工具准备

3.1 Xshell

一个强大的安全终端模拟软件,它支持SSH1, SSH2, 以及Microsoft Windows 平台的TELNET 协议。

Xshell 通过互联网到远程主机的安全连接以及它创新性的设计和特色帮助用户在复杂的网络环境中享受他们的工作。

3.2 Xftp

一个基于 MS windows 平台的功能强大的SFTP、FTP 文件传输软件。

使用了 Xftp 以后,MS windows 用户能安全地在UNIX/Linux 和 Windows PC 之间传输文件。

四、部署图

五、Flink安装

以下操作,均使用root用户

5.1 通过Xftp将下载下来的Flink安装文件上传到Master的/usr目录下

5.2 通过Xshell连接到虚拟机,在Master上,执行如下命令,解压文件:

# tar zxvf flink-1.3.2-bin-hadoop27-scala_2.11.tgz

5.3 在Master上,使用Vi编辑器,设置环境变量

# vi /etc/profile

在文件最后,添加如下内容:

#Flink Env

export FLINK_HOME=/usr/flink-1.3.2

export PATH=$PATH:$FLINK_HOME/bin

5.4 退出vi编辑器,使环境变量设置立即生效

# source /etc/profile

通过scp命令,将/etc/profile拷贝到两个Slave节点:

#scp /etc/profile root@DEV-SH-MAP-02:/etc

#scp /etc/profile root@DEV-SH-MAP-03:/etc

分别在两个Salve节点上执行# source /etc/profile使其立即生效

六、Flink配置

以下操作均在Master节点,配置完后,使用scp命令,将所有文件拷贝到两个Worker节点即可。

切换到/usr/flink-1.3.2/conf目录下,修改如下文件:

6.1 flink-conf.yaml

#JobManager的地址

jobmanager.rpc.address: DEV-SH-MAP-01 #JobManager Java 堆大小 jobmanager.heap.mb: 1024

#TaskManager Java 堆大小 taskmanager.heap.mb: 1024

taskmanager.numberOfTaskSlots: 2

6.2 masters

这个文件中存放的信息是JobManager的HostName,使用vi编辑器,打开masters,在文件最后,添加如下内容:

DEV-SH-MAP-01:8081

6.3 slaves

这个文件中存放的信息是TaskManager的HostName,使用vi编辑器,打开slaves,在文件最后,添加如下内容:

DEV-SH-MAP-01

DEV-SH-MAP-02

DEV-SH-MAP-03

6.4 拷贝配置文件到两个Worker节点

在Master节点,执行如下命令:

# scp -r /usr/flink-1.3.2/ root@DEV-SH-MAP-02:/usr/

# scp -r /usr/flink-1.3.2/ root@DEV-SH-MAP-03:/usr/

七、Flink使用

7.1 启动

Master节点上,执行如下命令:

#start-cluster.sh

在Master节点上,使用jps命令,查看Java进程:

41361 JobManager

41724 TaskManager

在Worker节点上,使用jps命令,查看Java进程:

37723 TaskManager

7.3 通过浏览器查看Flink信息

浏览器中,输入http://10.10.0.1:8081

7.4 停止节点

#stop-cluster.sh

Flink 1.3.2 Standalone模式安装的更多相关文章

- Spark新手入门——3.Spark集群(standalone模式)安装

主要包括以下三部分,本文为第三部分: 一. Scala环境准备 查看二. Hadoop集群(伪分布模式)安装 查看三. Spark集群(standalone模式)安装 Spark集群(standalo ...

- JBOSS EAP 6.0+ Standalone模式安装成Windows服务

网上有一些文章介绍用JavaService.exe来实现,但是到EAP 6以上版本,我试过好象没成功,幸好JBoss官方已经推出了专门的工具. 一.先到官网下载http://www.jboss.org ...

- Flink架构分析之Standalone模式启动流程

概述 FLIP6 对Flink架构进行了改进,引入了Dispatcher组件集成了所有任务共享的一些组件:SubmittedJobGraphStore,LibraryCacheManager等,为了保 ...

- 【Spark】Spark的Standalone模式安装部署

Spark执行模式 Spark 有非常多种模式,最简单就是单机本地模式,还有单机伪分布式模式,复杂的则执行在集群中,眼下能非常好的执行在 Yarn和 Mesos 中.当然 Spark 还有自带的 St ...

- spark运行模式之二:Spark的Standalone模式安装部署

Spark运行模式 Spark 有很多种模式,最简单就是单机本地模式,还有单机伪分布式模式,复杂的则运行在集群中,目前能很好的运行在 Yarn和 Mesos 中,当然 Spark 还有自带的 Stan ...

- Spark的StandAlone模式原理和安装、Spark-on-YARN的理解

Spark是一个内存迭代式运算框架,通过RDD来描述数据从哪里来,数据用那个算子计算,计算完的数据保存到哪里,RDD之间的依赖关系.他只是一个运算框架,和storm一样只做运算,不做存储. Spark ...

- Spark安装部署(local和standalone模式)

Spark运行的4中模式: Local Standalone Yarn Mesos 一.安装spark前期准备 1.安装java $ sudo tar -zxvf jdk-7u67-linux-x64 ...

- [会装]Spark standalone 模式的安装

1. 简介 以standalone模式安装spark集群bin运行demo. 2.环境和介质准备 2.1 下载spark介质,根据现有hadoop的版本选择下载,我目前的环境中的hadoop版本是2. ...

- 【原】Spark Standalone模式

Spark Standalone模式 安装Spark Standalone集群 手动启动集群 集群创建脚本 提交应用到集群 创建Spark应用 资源调度及分配 监控与日志 与Hadoop共存 配置网络 ...

随机推荐

- git合并历史提交

背景 以前一直觉得只要pull和push就够了,但合作中总会遇到各种非理想的情况.这时候才发现git其他命令的作用. 现在的情况是,repo是一个远程team维护的,我们需要增加新feature,那么 ...

- HashTable的故事----Jdk源码解读

HashTable的故事 很早之前,在讲HashMap的时候,我们就说过hash是散列,把...弄碎的意思.hashtable中的hash也是这个意思,而table呢,是指数据表格,也就是说hasht ...

- Ambari安装之部署3个节点的HA分布式集群

前期博客 Ambari安装之部署单节点集群 其实,按照这个步骤是一样的.只是按照好3个节点后,再做下HA即可. 部署3个节点的HA分布式集群 (1)添加机器 和添加服务的操作类似,如下图 之后的添加a ...

- (转)上传jar包到nexus私服

场景:在使用私服Nexus时候经常需要上传jar包,但是对上传jar包的方式不是很熟悉,所以很有必要学习下. 1 通过网页上传 GAV Definition:选择GAV Parameters 输入JA ...

- ios控制器生存周期

iOS中控制器的生命周期 一般我们在创建控制器的时候,有三种方法. 1. 直接通过代码创建 2. 通过storyboard创建 3. 通过Xib,在创建控制器的时候传入一个Xib文件作为这个控制 ...

- eclipse 打包 jar 到 Linux上运行

1.选择需要打包的项目,右键 Export 2.选择Runnable JAR file,然后点击 Next 3.选择jar包运行的main类,以及定义jar包的名字,保存的地方 4.将 导出来的 ja ...

- Python学习记录----类型匹配(转)

import types aaa = 0 print type(aaa) if type(aaa) is types.IntType: print "the type of aaa is i ...

- 移动端touch事件封装

<meta charset="utf-8"><meta name="viewport" content="width=device- ...

- [补档][JLOI 2017]聪明的燕姿

[NOI 2008]假面舞会 题目 阴天傍晚车窗外 未来有一个人在等待 向左向右向前看 爱要拐几个弯才来 我遇见谁会有怎样的对白 我等的人他在多远的未来 我听见风来自地铁和人海 我排着队拿着爱的号码牌 ...

- python教程6-2:字符串标识符

标识符合法性检查. 1.字母或者下划线开始. 2.后面是字母.下划线或者数字. 3.检查长度大于等于1. 4.可以识别关键字. python35 idcheck.py idcheck.py impo ...