信息论之从熵、惊奇到交叉熵、KL散度和互信息

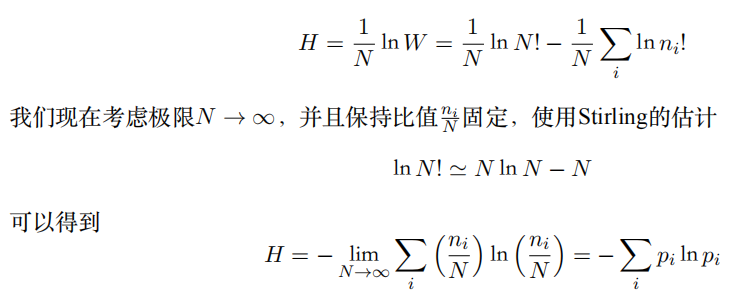

一、熵(PRML)

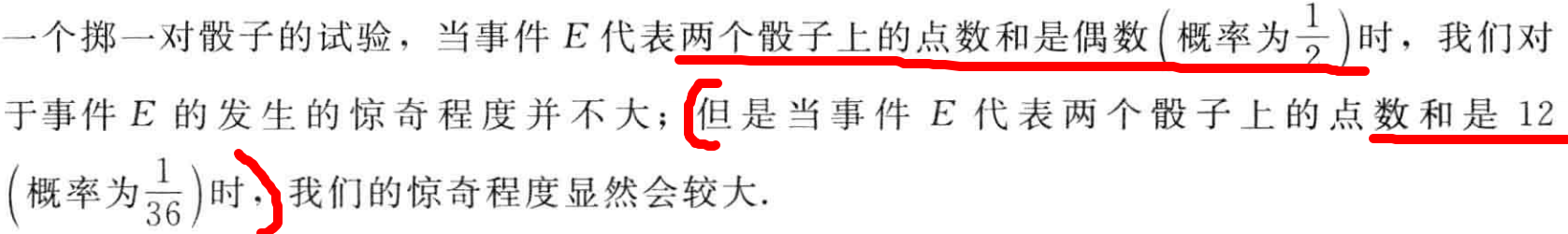

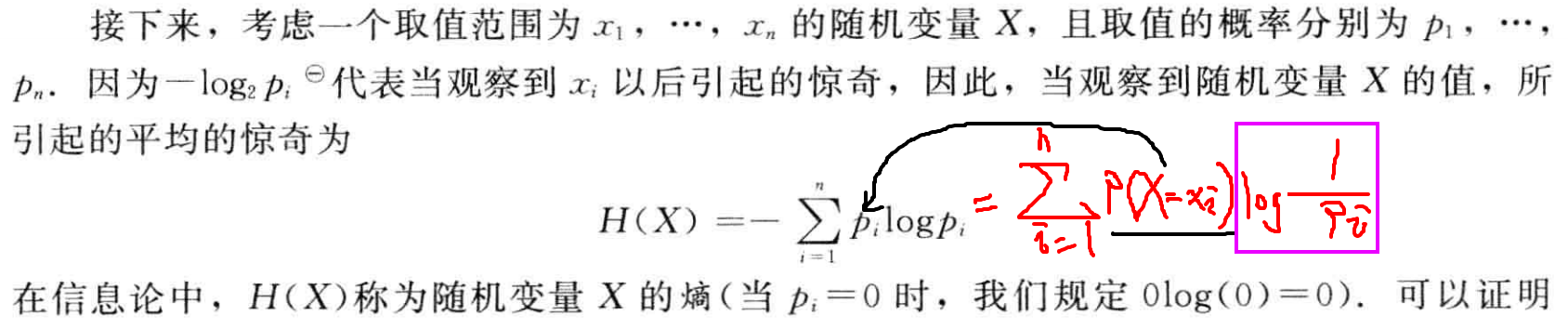

二、惊奇与信息

- 如果有⼈告诉我们⼀个相当不可能的事件发⽣了,我们收到的信息要多于我们被告知某个很可能发⽣的事件发⽣时收到的信息。

- 如果听到⼀个必然事情,那么就不会接收到信息。EX: 明天有24h

- 如果有两个不相关的事件x和y,那么观察到两个事件同时发⽣时获得的信息应该等于观察到事件各⾃发⽣时获得的信息之和,即h(x, y) = h(x) + h(y)。

- 两个不相关事件是统计独⽴的,因此p(x, y) = p(x)p(y)。

- 其中,负号确保了信息⼀定是正数或者是零。

- 注意,低概率事件x对应于⾼的信息量。

- 对数的底遵循信息论使⽤2作为对数的底(2进制编码最短)。

三、熵的相关变量

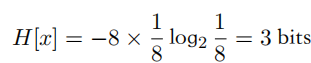

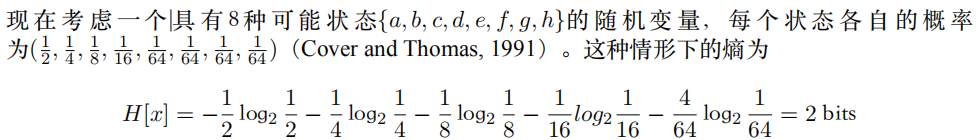

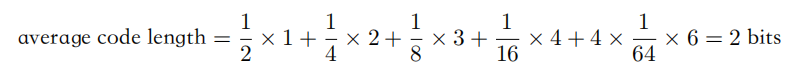

熵用于衡量不确定性,其相当于是编码一个随机变量的平均最小编码长度(最优编码的下界,即huffman编码)

1.自信息-二进制编码长度

\]

2.信息熵

= - \int p(x)\ln p(x)dx

\\ = \int p(x)\ln \frac{1}{p(x)}dx

= \mathbb{E}_{x\sim p(x)}\left[\ln\frac{1}{p(x)}\right]

\]

3.交叉熵,用一个分布p(x)的编码去编码另一个分布q(x)的代价(平均编码长度)

= - \int p(x)\ln q(x)dx

\\ = \mathbb{E}_{x\sim p(x)}\left[\ln\frac{1}{q(x)}\right]

\]

分布q(x)的自信息(最小编码长度)关于分布p(x)的期望

Ex: q(x1) = 0.25需要2bits,例如00来编码,但p(x1)=0.01

,相当于用更短的编码来编码低频取值(不符合高频短码),可能导致编码代价更大。

随机变量取值越多,熵越大(信息增益)

4.KL散度,衡量两个分布p(x)和q(x)的距离(不相似程度):

用一个分布p(x)的编码去编码另一个分布q(x)的额外代价

若KL散度为0,则表示编码额外代价为0,即两个分布相同

= - \int p(x)\ln \frac{q(x)}{p(x)} dx

= \int p(x)\ln \frac{p(x)}{q(x)} dx

\\= \int p(x)\ln p(x) - p(x)\ln q(x)dx

\\ = - \int p(x)\ln q(x)dx - (-\int p(x)\ln p(x) )

\\ = C\Big(p(x)\Big\Vert q(x)\Big) - H\Big(p(x)\Big)

\\ =

\mathbb{E}_{x\sim p(x)}\left[\ln\frac{p(x)}{q(x)}\right] \]

由于熵为常数项,最小化交叉熵,相当于最小化KL散度(最大似然),离散形式即求和。

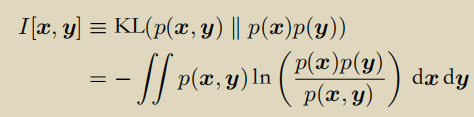

- 互信息

联合分布p(x, y)和边缘分布乘积累p(x)p(y)的KL散度。

如果互信息为0,则两个边缘分布独立p(x, y) = p(x) p(y)

信息论之从熵、惊奇到交叉熵、KL散度和互信息的更多相关文章

- 深度学习面试题07:sigmod交叉熵、softmax交叉熵

目录 sigmod交叉熵 Softmax转换 Softmax交叉熵 参考资料 sigmod交叉熵 Sigmod交叉熵实际就是我们所说的对数损失,它是针对二分类任务的损失函数,在神经网络中,一般输出层只 ...

- 信息论相关概念:熵 交叉熵 KL散度 JS散度

目录 机器学习基础--信息论相关概念总结以及理解 1. 信息量(熵) 2. KL散度 3. 交叉熵 4. JS散度 机器学习基础--信息论相关概念总结以及理解 摘要: 熵(entropy).KL 散度 ...

- 【机器学习基础】熵、KL散度、交叉熵

熵(entropy).KL 散度(Kullback-Leibler (KL) divergence)和交叉熵(cross-entropy)在机器学习的很多地方会用到.比如在决策树模型使用信息增益来选择 ...

- 交叉熵理解:softmax_cross_entropy,binary_cross_entropy,sigmoid_cross_entropy简介

cross entropy 交叉熵的概念网上一大堆了,具体问度娘,这里主要介绍深度学习中,使用交叉熵作为类别分类. 1.二元交叉熵 binary_cross_entropy 我们通常见的交叉熵是二元交 ...

- 第五节,损失函数:MSE和交叉熵

损失函数用于描述模型预测值与真实值的差距大小,一般有两种比较常见的算法——均值平方差(MSE)和交叉熵. 1.均值平方差(MSE):指参数估计值与参数真实值之差平方的期望值. 在神经网络计算时,预测值 ...

- 理解交叉熵(cross_entropy)作为损失函数在神经网络中的作用

交叉熵的作用 通过神经网络解决多分类问题时,最常用的一种方式就是在最后一层设置n个输出节点,无论在浅层神经网络还是在CNN中都是如此,比如,在AlexNet中最后的输出层有1000个节点: 而即便是R ...

- 信息论随笔3: 交叉熵与TF-IDF模型

接上文:信息论随笔2: 交叉熵.相对熵,及上上文:信息论随笔 在读<数学之美>的时候,相关性那一节对TF-IDF模型有这样一句描述:"其实 IDF 的概念就是一个特定条件下.关键 ...

- 最大似然估计 (Maximum Likelihood Estimation), 交叉熵 (Cross Entropy) 与深度神经网络

最近在看深度学习的"花书" (也就是Ian Goodfellow那本了),第五章机器学习基础部分的解释很精华,对比PRML少了很多复杂的推理,比较适合闲暇的时候翻开看看.今天准备写 ...

- 熵(Entropy),交叉熵(Cross-Entropy),KL-松散度(KL Divergence)

1.介绍: 当我们开发一个分类模型的时候,我们的目标是把输入映射到预测的概率上,当我们训练模型的时候就不停地调整参数使得我们预测出来的概率和真是的概率更加接近. 这篇文章我们关注在我们的模型假设这些类 ...

- 深度学习中交叉熵和KL散度和最大似然估计之间的关系

机器学习的面试题中经常会被问到交叉熵(cross entropy)和最大似然估计(MLE)或者KL散度有什么关系,查了一些资料发现优化这3个东西其实是等价的. 熵和交叉熵 提到交叉熵就需要了解下信息论 ...

随机推荐

- 【第4次作业】CNN实战

使用VGG模型进行猫狗大战 import numpy as np import matplotlib.pyplot as plt import os import torch import torch ...

- java文本转语音

下载jar包https://github.com/freemansoft/jacob-project/releases 解压,将jacob-1.18-xxx.dll相应放到项目使用的JAVA_HOME ...

- Kafka源码阅读系列——Producer

Producer Kafka源码的exmaple模块有一个Producer类,继承了Thread类,构造方法会指定topic,是否异步,是否幂等,配置Kafka集群信息,初始化一个KafkaProdu ...

- django中使用autocomplete无效查错

检查autocomplete是否工作正常,将自己的结果集注释掉,使用前端预设好的结果集var countries=["Afghanistan","Albania" ...

- 007使用IDEA开发

007使用IDEA开发 1.什么叫IDE? 集成开发环境(IDE,Integrated Development Environment)是用于提供程序开发环境的应用程序,一般包括代码编辑器.编译器.调 ...

- 九九乘法表打印记一次al面试

for (int i = 1; i <= 9; i++) { for (int j = 1; j <= i; j++) { System.out.print(i + "x&quo ...

- cenos7配置epel源

1.首先进入/etc/yum.repos.d/目录下,新建一个repo_bak目录,用于保存系统中原来的repo文件 [root@bogon ~]# cd /etc/yum.repos.d/ [roo ...

- adb shell monkey

monkey 在模拟器或真机里在,.它向系统发送伪随机的用户事件流(如按键输入.触摸屏输入.手势输入等),打开app 查看包名 adb shell dumpsys window windows | f ...

- iframe.contentWindows使用

一.在使用iframe的页面,要操作这个iframe里面的DOM元素可以用: contentWindow.contentDocument(测试的时候chrome浏览器,要在服务器环境下) 1.先获取i ...

- SpringBoot笔记--自动配置(高级内容)(下集)

案例需求 实现步骤: 具体的实现 1.引入Jedis依赖 2.提供Jedis的Bean 找到SpringBoot的执行文件,按住Ctrl键,进入SpringBootApplication注解,再进入E ...