BeautifulSoup图片爬取

------------恢复内容开始------------

BeautifulSoup介绍:

简单来说,Beautiful Soup 是 python 的一个库,最主要的功能是从网页抓取数据。官方解释如下:

Beautiful Soup 提供一些简单的、python 式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。 Beautiful Soup 自动将输入文档转换为 Unicode 编码,输出文档转换为 utf-8 编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup 就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。 Beautiful Soup 已成为和 lxml、html6lib 一样出色的 python 解释器,为用户灵活地提供不同的解析策略或强劲的速度。

以下为爬取网页图片的例子:

爬取图片的网页地址:https://pic.netbian.com/4kdongman/

先创建一个requests的请求,然后使用BeautifulSoup的lxml HTML解析器去解析网页

url = 'https://pic.netbian.com/4kdongman/'

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36'

}

r = requests.get(url,headers=headers)

#设置编码为gbk,要不然会乱码

r.encoding='gbk'

#使用lxml解析器解析

soup = BeautifulSoup(r.text,'lxml')

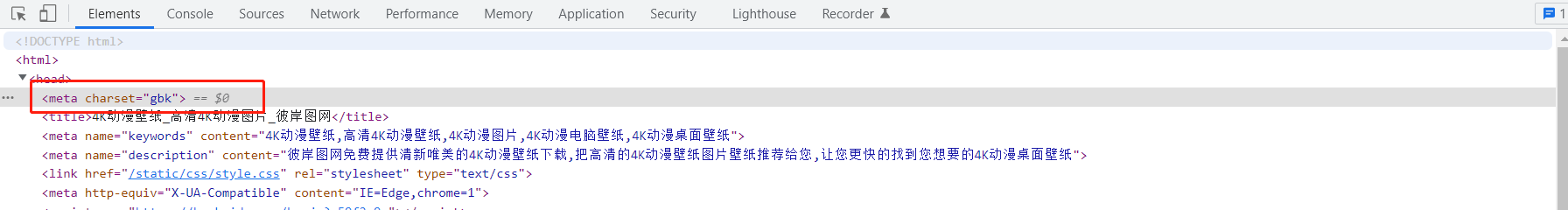

编码格式可以从网页html中看到

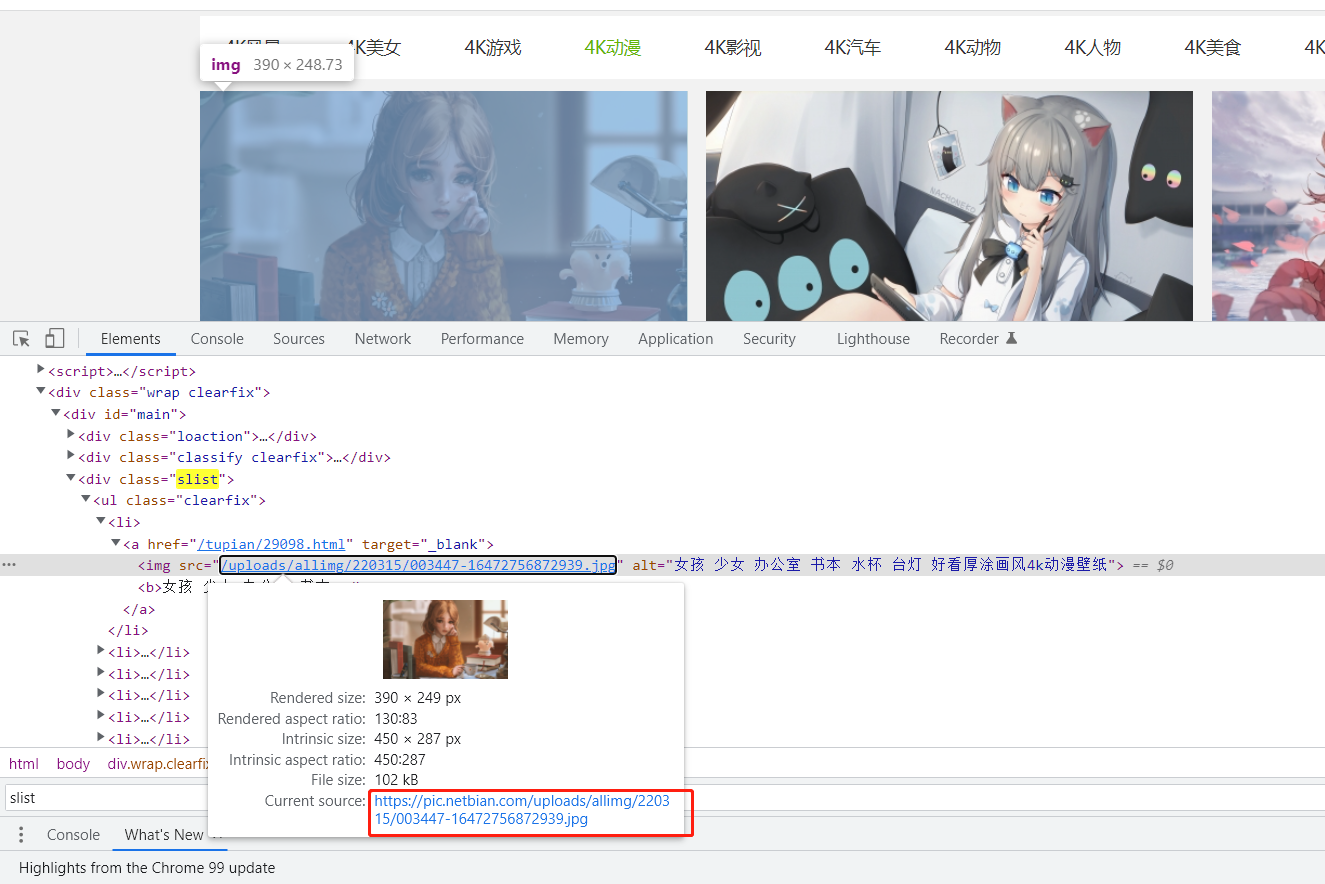

接下来可以先定位到所有图片的整体div,例如class=’slist‘这个div,然后再定位每张图片的img标签,提取相关数据,得到每张图片的url地址

#定位所有图片的整体div

all_list = soup.find_all(attrs={'class': 'slist'})

#定位所有的img标签

img_list = all_list[0].find_all('img')

#遍历每个img标签

for img in img_list:

img_url = img['src']

name = img['alt']

#拼接图片url地址

img_url = 'https://pic.netbian.com' + img_url

#图片名称

print(name)

#图片url

print(img_url)

获取到每张图片的url地址后,就可以直接将其下载下来

方法一:with open直接将图片用字节流写入保存

r_img = requests.get(img_url)

with open('./img/'+name+'.jpg','wb+') as f:

#content返回的是二进制数据,如果你是取文本,你可以使用r.txt,如果取图片和文件,则是r.content

f.write(r_img.content)

方法二:直接使用urllib.request.urlretrieve下载

#第一个参数为要下载文件的url,第二个参数为本地保存路径以及文件名的路径

urllib.request.urlretrieve(img_url,'./img/'+name+'.jpg')

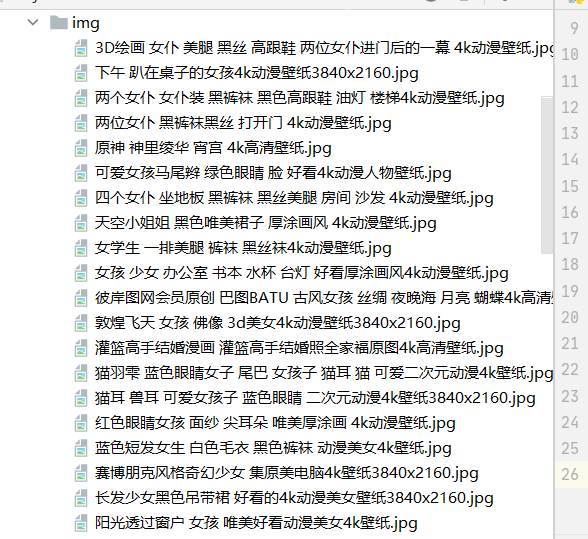

两种都可以实现,图片的下载,我保存的图片的地址为当前目录的img,从下面图片可以看到已经全部下载了

完整代码如下:

import urllib.request import requests

from bs4 import BeautifulSoup url = 'https://pic.netbian.com/4kdongman/'

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36'

}

r = requests.get(url,headers=headers)

#设置编码为gbk,要不然会乱码

r.encoding='gbk'

#使用lxml解析器解析

soup = BeautifulSoup(r.text,'lxml')

all_list = soup.find_all(attrs={'class': 'slist'})

img_list = all_list[0].find_all('img')

for img in img_list:

img_url = img['src']

name = img['alt']

img_url = 'https://pic.netbian.com' + img_url

print(name)

# r_img = requests.get(img_url)

# with open('./img/'+name+'.jpg','wb+') as f:

# f.write(r_img.content)

urllib.request.urlretrieve(img_url,'./img/'+name+'.jpg')

print('已经保存完成:'+img_url)

------------恢复内容结束------------

BeautifulSoup图片爬取的更多相关文章

- Python爬虫入门教程 26-100 知乎文章图片爬取器之二

1. 知乎文章图片爬取器之二博客背景 昨天写了知乎文章图片爬取器的一部分代码,针对知乎问题的答案json进行了数据抓取,博客中出现了部分写死的内容,今天把那部分信息调整完毕,并且将图片下载完善到代码中 ...

- 用BeautifulSoup简单爬取BOSS直聘网岗位

用BeautifulSoup简单爬取BOSS直聘网岗位 爬取python招聘 import requests from bs4 import BeautifulSoup def fun(path): ...

- 4k图片爬取+中文乱码

4k图片爬取+中文乱码 此案例有三种乱码解决方法,推荐第一种 4k图片爬取其实和普通图片爬取的过程是没有本质区别的 import requests import os from lxml import ...

- scrapy之360图片爬取

#今日目标 **scrapy之360图片爬取** 今天要爬取的是360美女图片,首先分析页面得知网页是动态加载,故需要先找到网页链接规律, 然后调用ImagesPipeline类实现图片爬取 *代码实 ...

- [Python_scrapy图片爬取下载]

welcome to myblog Dome地址 爬取某个车站的图片 item.py 中 1.申明item 的fields class PhotoItem(scrapy.Item): # define ...

- 爬虫07 /scrapy图片爬取、中间件、selenium在scrapy中的应用、CrawlSpider、分布式、增量式

爬虫07 /scrapy图片爬取.中间件.selenium在scrapy中的应用.CrawlSpider.分布式.增量式 目录 爬虫07 /scrapy图片爬取.中间件.selenium在scrapy ...

- python+BeautifulSoup+多进程爬取糗事百科图片

用到的库: import requests import os from bs4 import BeautifulSoup import time from multiprocessing impor ...

- 使用BeautifulSoup自动爬取微信公众号图片

爬取微信分享的图片,根据不同的页面自行修改,使用BeautifulSoup爬取,自行格局HTML修改要爬取图片的位置 import re import time import requests imp ...

- 网络爬虫之网站图片爬取-python实现

版本1.5 本次简单添加了四路多线程(由于我电脑CPU是四核的),速度飙升.本想试试xPath,但发现反倒是多此一举,故暂不使用 #-*- coding:utf-8 -*- import re,url ...

随机推荐

- HTML横向二级导航

图片素材没有发,就一个logo还有一个Nav背景图. 效果 HTML <!DOCTYPE html> <html lang="zh-cn"> <hea ...

- nginx实现跨域访问并支持(GET, POST,PUT,DELETE, OPTIONS)

最近有同事提出在使用客户端跨域访问的时候,发现服务器对option请求返回了403,后来查看了网络添加了一段配置,发现option服务返回204了,但是后续的put操作也直接返回了204导致无法使用图 ...

- Redis sentinel.conf配置文件详解

redis-sentinel.conf配置项说明如下: 1.port 26379 sentinel监听端口,默认是26379,可以修改. 2.sentinel monitor <master-n ...

- 学习:二维码、QR码、J4L-QRCode、java

开源码 Java 解码器(编码解码)下载:http://sourceforge.jp/projects/qrcode/downloads/28391/qrcode.zip Java QR Code O ...

- python基础语法_2基本数据类型

http://www.runoob.com/python3 大纲 Number(数字) String(字符串) List(列表) Tuple(元组) Sets(集合) Dictionarys(字典 ...

- 关于sys.path.append()

当我们导入一个模块时:import xxx,默认情况下python解析器会搜索当前目录.已安装的内置模块和第三方模块,搜索路径存放在sys模块的path中: >>> import ...

- Python解释器安装、多版本共存以及手动添加环境变量教程

Python解释器安装.多版本共存以及手动添加环境变量教程 一.Python解释器下载 1. 先进入官网(python.org) 下图为网站的主页,依次按顺序点击"①Download&quo ...

- Linux源码编译安装php7.2

以下简单的介绍下如何源码安装PHP,对于版本不一定是7.2,也可以是7.3,当然方法都是换汤不换药的,核心东西不变. 一.下载PHP源码 需要到指定的路径下载源码,执行下面的命令 wget http: ...

- 5、前端--js常量、变量、5种基本数据类型(number string boolean undefined object)、运算符、流程控制、三元运算符、函数、自定义对象、内置对象、BOM操作

变量与常量 在JS中声明变量需要使用关键字 老版本 var(全部都是全局变量) 新版本 let(可以声明局部变量) # 推荐使用let(其实问题不大) 在JS中声明常量也需要使用关键字 const # ...

- MyBatis源码环境搭建

之前研究mybatis都是参考前面学习的人的一些经验,并没有自己搭建源码环境进行.现在以mybatis3.4.6版本搭建,搭建过程中各种failed,下面大致记录环境搭建过程. 1.mybatis3. ...