HDFS基础学习

HDFS简介

HDFS即Hadoop Distributed File System,是一个分布式文件系统,用于存储海量数据。一个HDFS集群由一个NameNode和多个DataNode组成。

HDFS特性

- 主从架构

- 分块存储

- 副本机制

- 元数据记录

- 抽象目录树

HDFS shell命令行

- Hadoop内置提供了shell命令行,格式为hadoop fs 参数。前面hadoop fs为固定搭配,表示操作的是文件系统,具体操作的文件系统则看参数中文件路径url的前缀协议。

示例如下:

[root@node1 ~]# hadoop fs -ls file:///

Found 21 items

-rw-r--r-- 1 root root 0 2021-10-26 14:27 file:///.autorelabel

dr-xr-xr-x - root root 28672 2021-10-26 15:12 file:///bin

dr-xr-xr-x - root root 4096 2020-09-11 14:44 file:///boot

drwxr-xr-x - root root 3260 2022-10-25 19:23 file:///dev

drwxr-xr-x - root root 8192 2022-10-25 19:23 file:///etc

drwxr-xr-x - root root 48 2021-10-26 15:15 file:///export

drwxr-xr-x - root root 6 2018-04-11 12:59 file:///home

dr-xr-xr-x - root root 4096 2020-09-11 14:40 file:///lib

dr-xr-xr-x - root root 24576 2020-09-11 14:40 file:///lib64

drwxr-xr-x - root root 6 2018-04-11 12:59 file:///media

drwxr-xr-x - root root 6 2018-04-11 12:59 file:///mnt

drwxr-xr-x - root root 16 2020-09-11 14:40 file:///opt

dr-xr-xr-x - root root 0 2022-10-25 19:23 file:///proc

dr-xr-x--- - root root 4096 2022-10-24 21:15 file:///root

drwxr-xr-x - root root 840 2022-10-25 19:23 file:///run

dr-xr-xr-x - root root 16384 2021-10-26 15:13 file:///sbin

drwxr-xr-x - root root 6 2018-04-11 12:59 file:///srv

dr-xr-xr-x - root root 0 2022-10-25 19:23 file:///sys

drwxrwxrwt - root root 4096 2022-10-25 19:34 file:///tmp

drwxr-xr-x - root root 155 2020-09-11 14:39 file:///usr

drwxr-xr-x - root root 4096 2020-09-11 14:46 file:///var

[root@node1 ~]# hadoop fs -ls hdfs://node1:8020/

Found 3 items

drwxr-xr-x - root supergroup 0 2022-10-24 21:14 hdfs://node1:8020/itcast

drwx------ - root supergroup 0 2021-10-26 15:20 hdfs://node1:8020/tmp

drwxr-xr-x - root supergroup 0 2021-10-26 15:23 hdfs://node1:8020/user

[root@node1 ~]# hadoop fs -ls /

Found 3 items

drwxr-xr-x - root supergroup 0 2022-10-24 21:14 /itcast

drwx------ - root supergroup 0 2021-10-26 15:20 /tmp

drwxr-xr-x - root supergroup 0 2021-10-26 15:23 /user

[root@node1 ~]# hdfs dfs -ls /

Found 3 items

drwxr-xr-x - root supergroup 0 2022-10-24 21:14 /itcast

drwx------ - root supergroup 0 2021-10-26 15:20 /tmp

drwxr-xr-x - root supergroup 0 2021-10-26 15:23 /user

shell命令行常用操作

HDFS shell命令行的常用操作基本与Linux相同。具体如下:创建文件夹:hadoop fs -mkdir -p

[root@node1 ~]# hadoop fs -mkdir -p /study/hdfs

[root@node1 ~]# hdfs dfs -ls /

Found 4 items

drwxr-xr-x - root supergroup 0 2022-10-24 21:14 /itcast

drwxr-xr-x - root supergroup 0 2022-10-25 20:11 /study

drwx------ - root supergroup 0 2021-10-26 15:20 /tmp

drwxr-xr-x - root supergroup 0 2021-10-26 15:23 /user

- 显示文件:hadoop fs -ls -h

[root@node1 ~]# hadoop fs -mkdir -p /study/hdfs

[root@node1 ~]# hdfs dfs -ls /

Found 4 items

drwxr-xr-x - root supergroup 0 2022-10-24 21:14 /itcast

drwxr-xr-x - root supergroup 0 2022-10-25 20:11 /study

drwx------ - root supergroup 0 2021-10-26 15:20 /tmp

drwxr-xr-x - root supergroup 0 2021-10-26 15:23 /user

[root@node1 ~]# hadoop fs -put anaconda-ks.cfg /study/hdfs

[root@node1 ~]# hadoop fs -ls /study/hdfs

Found 1 items

-rw-r--r-- 3 root supergroup 1340 2022-10-25 20:14 /study/hdfs/anaconda-ks.cfg

[root@node1 ~]# hadoop fs -ls -h /study/hdfs

Found 1 items

-rw-r--r-- 3 root supergroup 1.3 K 2022-10-25 20:14 /study/hdfs/anaconda-ks.cfg

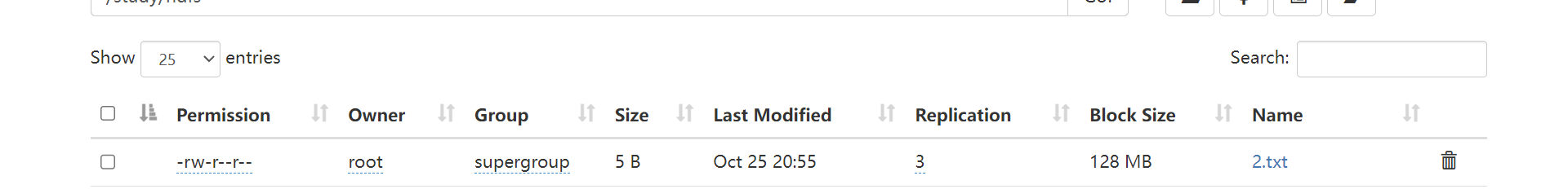

- 上传文件:hadoop fs -put

[root@node1 ~]# echo 2222 > 2.txt

[root@node1 ~]# hadoop fs -put file:///root/2.txt hdfs://node1:8020/study/hdfs

- 查看文件:hadoop fs -cat

# hadoop fs -cat /itcast/anaconda-ks.cfg

- 下载文件:hadoop fs -get

[root@node1 ~]# ll

总用量 32

-rw-r--r-- 1 root root 2 10月 24 21:15 1.txt

-rw-------. 1 root root 1340 9月 11 2020 anaconda-ks.cfg

drwxr-xr-x 2 root root 55 10月 5 00:08 hivedata

-rw------- 1 root root 23341 10月 5 00:11 nohup.out

[root@node1 ~]# hadoop fs -get hdfs://node1:8020/itcast/2.txt file:///root/

[root@node1 ~]# ll

总用量 36

-rw-r--r-- 1 root root 2 10月 24 21:15 1.txt

-rw-r--r-- 1 root root 5 10月 25 21:08 2.txt

-rw-------. 1 root root 1340 9月 11 2020 anaconda-ks.cfg

drwxr-xr-x 2 root root 55 10月 5 00:08 hivedata

-rw------- 1 root root 23341 10月 5 00:11 nohup.out

[root@node1 ~]# hadoop fs -get /itcast/2.txt ./666.txt

拷贝文件:hadoop fs -cd

追加数据到HDFS文件中:hadoop fs -appendToFile 注意!这个命令需要把集群全部打开,因为它涉及到了datanode节点,具体想了解的话可以看我上一篇博客

[root@node1 ~]# hadoop fs -appendToFile 1.txt 3.txt /2.txt

[root@node1 ~]# hadoop fs -cat /2.txt

2222

1

3

- 数据移动(重命名):hadoop fs -mv

HDFS基础学习的更多相关文章

- 零基础学习hadoop到上手工作线路指导(编程篇)

问题导读: 1.hadoop编程需要哪些基础? 2.hadoop编程需要注意哪些问题? 3.如何创建mapreduce程序及其包含几部分? 4.如何远程连接eclipse,可能会遇到什么问题? 5.如 ...

- 零基础学习hadoop到上手工作线路指导(中级篇)

此篇是在零基础学习hadoop到上手工作线路指导(初级篇)的基础,一个继续总结. 五一假期:在写点内容,也算是总结.上面我们会了基本的编程,我们需要对hadoop有一个更深的理解: hadoop分为h ...

- 零基础学习openstack【完整中级篇】及openstack资源汇总

1.你是如何学习openstack的?2.你对openstack的组件了解多少?3.你认为openstack该如何学习? 一直想写关于openstack的方面的内容,今天终于整理完成.算是完成一桩心事 ...

- 零基础学习hadoop到上手工作线路指导初级篇:hive及mapreduce

此篇是在零基础学习hadoop到上手工作线路指导(初级篇)的基础,一个继续总结.五一假期:在写点内容,也算是总结.上面我们会了基本的编程,我们需要对hadoop有一个更深的理解:hadoop分为h ...

- Spark基础学习精髓——第一篇

Spark基础学习精髓 1 Spark与大数据 1.1 大数据基础 1.1.1 大数据特点 存储空间大 数据量大 计算量大 1.1.2 大数据开发通用步骤及其对应的技术 大数据采集->大数据预处 ...

- salesforce 零基础学习(五十二)Trigger使用篇(二)

第十七篇的Trigger用法为通过Handler方式实现Trigger的封装,此种好处是一个Handler对应一个sObject,使本该在Trigger中写的代码分到Handler中,代码更加清晰. ...

- 如何从零基础学习VR

转载请声明转载地址:http://www.cnblogs.com/Rodolfo/,违者必究. 近期很多搞技术的朋友问我,如何步入VR的圈子?如何从零基础系统性的学习VR技术? 本人将于2017年1月 ...

- IOS基础学习-2: UIButton

IOS基础学习-2: UIButton UIButton是一个标准的UIControl控件,UIKit提供了一组控件:UISwitch开关.UIButton按钮.UISegmentedContro ...

- HTML5零基础学习Web前端需要知道哪些?

HTML零基础学习Web前端网页制作,首先是要掌握一些常用标签的使用和他们的各个属性,常用的标签我总结了一下有以下这些: html:页面的根元素. head:页面的头部标签,是所有头部元素的容器. b ...

随机推荐

- LuoguP1016 旅行家的预算 (贪心)

胡一个错误代码都能有75pts 忘了怎么手写deque其实是懒 #include <cstdio> #include <iostream> #include <cstri ...

- day21--Java集合04

Java集合04 9.Set接口方法 Set接口基本介绍 无序(添加和取出的顺序不一致),没有索引 不允许重复元素,所以最多只有一个null JDK API中接口的实现类有: Set接口的常用方法:和 ...

- java-多态、内部类

1.多态: 1)意义: 1.1)同一类型的引用,指向不同的对象时,有不同的实现-------行为的多态: cut(),run(),teach()... 1.2)同一个对象,被造型为不同的类型时,有不同 ...

- 技术专家说 | 如何基于 Spark 和 Z-Order 实现企业级离线数仓降本提效?

[点击了解更多大数据知识] 市场的变幻,政策的完善,技术的革新--种种因素让我们面对太多的挑战,这仍需我们不断探索.克服. 今年,网易数帆将持续推出新栏目「金融专家说」「技术专家说」「产品专家说」等, ...

- HCIA-Datacom 3.1 实验一:以太网基础与VLAN配置实验

实验介绍: 以太网是一种基于CSMA/CD(Carrier Sense Multiple Access/Collision Detection)的共享通讯介质的数据网络通讯技术.当主机数目较多时会导致 ...

- Linux网桥配置(用于大数据虚拟化)

理解 VMware里面有三个虚拟机,分别为RHEL8,RHEL7,Windows的虚拟机,只有一个物理网卡连接物理网络,现在三台虚拟机都需要直连到物理网络,此时无法访问物理网络,只能给一个虚拟机访问物 ...

- KingbaseES时间函数的比较

KingbaseES提供了多种的时间函数,这些函数在使用过程中存在哪些不同? **同一事务** test=# begin test-# for i in 1.. 10 loop test-# rais ...

- centOS查看修改时区

// 查看时间各种状态,查看时区等 timedatectl // 输出 Local time: 四 2014-12-25 10:52:10 CST Universal time: 四 2014-12- ...

- Windows服务器限制进程CPU使用率

在Windows server 2012 之前的服务系统 2008和2008 R2中有系统资源管理器System Resource Manager可以管理系统的CPU和内存使用情况.特别对于一些自己开 ...

- 命令行配置Windows高级防火墙

今天正好看到个帖子,询问如何通过命令行配置防火墙策略中远程IP的地址,特别是添加新的地址. 就是图中Scope里Remote IP address的地址. 第一反应就是用netsh firewall来 ...