Python 爬取生成中文词云以爬取知乎用户属性为例

代码如下:

# -*- coding:utf-8 -*- import requests

import pandas as pd

import time import matplotlib.pyplot as plt

from wordcloud import WordCloud

import jieba header={

'authorization':'Bearer 2|1:0|10:1515395885|4:z_c0|92:Mi4xOFQ0UEF3QUFBQUFBRU1LMElhcTVDeVlBQUFCZ0FsVk5MV2xBV3dDLVZPdEhYeGxaclFVeERfMjZvd3lOXzYzd1FB|39008996817966440159b3a15b5f921f7a22b5125eb5a88b37f58f3f459ff7f8',

'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/50.0.2661.94 Safari/537.36',

'X-UDID':'ABDCtCGquQuPTtEPSOg35iwD-FA20zJg2ps=',

} user_data = []

def get_user_data(page):

for i in range(page):

url = 'https://www.zhihu.com/api/v4/members/excited-vczh/followees?include=data%5B*%5D.answer_count%2Carticles_count%2Cgender%2Cfollower_count%2Cis_followed%2Cis_following%2Cbadge%5B%3F(type%3Dbest_answerer)%5D.topics&offset={}&limit=20'.format(i*20)

#response = requests.get(url, headers=header).text

response = requests.get(url, headers=header).json()['data']#['data'] 只有JSON格式中选择data节点

user_data.extend(response)

print('正在爬取%s页' % str(i+1))

time.sleep(1) if __name__=='__main__':

get_user_data(10)

#pandas 的函数 from_dict()可以直接将一个response变成一个对象

#df = pd.DataFrame.from_dict(user_data)

#df.to_csv('D:/PythonWorkSpace/TestData/zhihu/user2.csv')

df = pd.DataFrame.from_dict(user_data).get('headline')

df.to_csv('D:/PythonWorkSpace/TestData/zhihu/headline.txt') text_from_file_with_apath = open('D:/PythonWorkSpace/TestData/zhihu/headline.txt').read()

wordlist_after_jieba = jieba.cut(text_from_file_with_apath, cut_all=True)

wl_space_split = " ".join(wordlist_after_jieba) my_wordcloud = WordCloud().generate(wl_space_split) plt.imshow(my_wordcloud)

plt.axis("off")

plt.show()

需要安装准备的库:

pip install matplotlib

pip install jieba

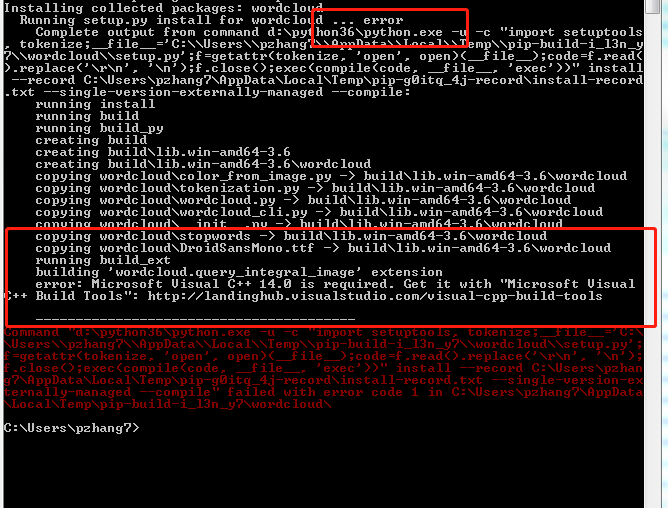

pip install wordcloud(发现这方法安装不成功)

换种安装方式到 https://github.com/amueller/word_cloud 这里下载库文件,解压,然后进入到解压后的文件,按住shift+鼠标右键 打开命令窗口运行一下命令:

python setup.py install 然后同样报错

然后我又换了一张安装方式:

到 http://www.lfd.uci.edu/~gohlke/pythonlibs/#wordcloud 页面下载所需的wordcloud模块的whl文件,下载后进入存储该文件的路径,按照方法一,执行“pip install wordcloud-1.3.3-cp36-cp36m-win_amd64.whl”,这样就会安装成功。

然后生成词云的代码如下:

text_from_file_with_apath = open('D:\Python\zhihu\headline.txt','r',encoding='utf-8').read()

wordlist_after_jieba = jieba.cut(text_from_file_with_apath, cut_all=True)

wl_space_split = " ".join(wordlist_after_jieba)

my_wordcloud = WordCloud().generate(wl_space_split)

plt.imshow(my_wordcloud)

plt.axis("off")

plt.show()

但是发现不显示中文,这可就头疼了。

显示的是一些大大小小的彩色框框。这是因为,我们使用的wordcloud.py中,FONT_PATH的默认设置不识别中文。

仔细研究之后做了改进,终于可以正常显示中文了

text_from_file_with_apath = open('D:\Python\zhihu\headline.txt','r',encoding='utf-8').read()

wordlist_after_jieba = jieba.cut(text_from_file_with_apath, cut_all=True)

wl_space_split = " ".join(wordlist_after_jieba)

#FONT_PATH = os.environ.get("FONT_PATH", os.path.join(os.path.dirname(__file__), "simkai.ttf"))

cloud = WordCloud(

#设置字体,不指定就会出现乱码

font_path="simkai.ttf",

#设置背景色

background_color='white',

#允许最大词汇

max_words=9000,

#词云形状

#mask=color_mask

)#.generate(wl_space_split)

## 产生词云

word_cloud = cloud.generate(wl_space_split)

word_cloud.to_file('D:\Python\zhihu\headline.jpg')#将图片保存到指定文件中

#直接显示图片,并且可编辑

# plt.imshow(word_cloud)

# plt.axis("off")

# plt.show()

坑:

Python读取文件时经常会遇到这样的错误:python3.4 UnicodeDecodeError: 'gbk' codec can't decode byte 0xff in position 0: illegal multibyte sequence

import codecs,sys

f = codecs.open("***.txt","r","utf-8")

指明打开文件的编码方式就可以消除错误了

Python 爬取生成中文词云以爬取知乎用户属性为例的更多相关文章

- Java爬取B站弹幕 —— Python云图Wordcloud生成弹幕词云

一 . Java爬取B站弹幕 弹幕的存储位置 如何通过B站视频AV号找到弹幕对应的xml文件号 首先爬取视频网页,将对应视频网页源码获得 就可以找到该视频的av号aid=8678034 还有弹幕序号, ...

- Python基于jieba的中文词云

今日学习了python的词云技术 from os import path from wordcloud import WordCloud import matplotlib.pyplot as plt ...

- Scrapy+eChart自动爬取生成网络安全词云

因为工作的原因,近期笔者开始持续关注一些安全咨询网站,一来是多了解业界安全咨询提升自身安全知识,二来也是需要从各类安全网站上收集漏洞情报. 作为安全情报领域的新手,面对大量的安全咨询,多少还是会感觉无 ...

- 超详细:Python(wordcloud+jieba)生成中文词云图

# coding: utf-8 import jieba from scipy.misc import imread # 这是一个处理图像的函数 from wordcloud import WordC ...

- [python] 基于词云的关键词提取:wordcloud的使用、源码分析、中文词云生成和代码重写

1. 词云简介 词云,又称文字云.标签云,是对文本数据中出现频率较高的“关键词”在视觉上的突出呈现,形成关键词的渲染形成类似云一样的彩色图片,从而一眼就可以领略文本数据的主要表达意思.常见于博客.微博 ...

- python抓取数据构建词云

1.词云图 词云图,也叫文字云,是对文本中出现频率较高的"关键词"予以视觉化的展现,词云图过滤掉大量的低频低质的文本信息,使得浏览者只要一眼扫过文本就可领略文本的主旨. 先看几个词 ...

- Python第三方库wordcloud(词云)快速入门与进阶

前言: 笔主开发环境:Python3+Windows 推荐初学者使用Anaconda来搭建Python环境,这样很方便而且能提高学习速度与效率. 简介: wordcloud是Python中的一个小巧的 ...

- 从当当客户端api抓取书评到词云生成

看了好几本大冰的书,感觉对自己的思维有不少的影响.想看看其他读者的评论.便想从当当下手抓取他们评论做个词云.想着网页版说不定有麻烦的反爬,干脆从手机客户端下手好了.果其不然,找到一个书评的api.发送 ...

- 用Python实现一个词频统计(词云+图)

第一步:首先需要安装工具python 第二步:在电脑cmd后台下载安装如下工具: (有一些是安装好python电脑自带有哦) 有一些会出现一种情况就是安装不了词云展示库 有下面解决方法,需看请复制链接 ...

随机推荐

- [ZJOI2012]波浪弱化版(带技巧的DP)

题面 \(solution:\) 这道确实挺难的,情况特别多,而且考场上都没想到如何设置状态.感觉怎么设状态不能很好的表示当前情况并转移,考后发现是对全排列的构造方式不熟而导致的,而这一题的状态也是根 ...

- mysql 查询优化案例汇总

一 简介:此文章为经历过的sql案例集合和相关思路 二 案例1: 现象: 测试环境出现select语句,join2张表多次join,explain结果如下 出现 using where,using j ...

- python标准库 - 数学库和随机数库

作者:Vamei 出处:http://www.cnblogs.com/vamei 欢迎转载,也请保留这段声明.谢谢! 我们已经在Python运算中看到Python最基本的数学运算功能.此外,math包 ...

- 在Mysql中查询两个时间段的差,可以是秒,天,星期,月份,年...

SELECT TIMESTAMPDIFF(SECOND, now(), "2016-11-11 00:00:00") 语法为:TIMESTAMPDIFF(unit,datetime ...

- 什么是 maven的uber-jar

在maven的一些文档中我们会发现 "uber-jar"这个术语,许多人看到后感到困惑.其实在很多编程语言中会把super叫做uber (因为suber可能是关键字), 这是上世纪 ...

- driver: linux2.6 内核模块导出函数实例(EXPORT_SYMBOL) 【转】

转自:http://blog.chinaunix.net/uid-23381466-id-3837650.html 内核版本:2.6.38-11-generic 内核自己都大量利用内核符号表导出函数, ...

- Linux内核驱动--硬件访问I/O【原创】

寄存器与内存 寄存器与内存的区别在哪里呢? 寄存器和RAM的主要不同在于寄存器操作有副作用(side effect或边际效果): 读取某个地址时可能导致该地址内容发生变化,比如很多设备的中断状态寄存器 ...

- C#删除WebBrowser控件Session

转载:http://www.hackdig.com/?02/hack-1464.htm 因为要搞一个类似帐号多开的小辅助,但是很坑爹的发现,在一个WebBrowser中,就算重新登录,显示的仍然是上一 ...

- MPI 在Windows10 上安装,使用VS2013编译生成可执行程序

原文地址:http://www.cnblogs.com/leijin0211/p/6851789.html 参考博客: http://www.cnblogs.com/shixiangwan/p/662 ...

- 深入解析内存原理:SRAM的基本原理

1. SRAM芯片的引脚定义早期的SRAM 芯片采用了20 线双列直插(DIP:Dual Inline Package)封装技术,它们之所以具有这么多的针脚,是因为它们必须:• 每个地址信号都需要一根 ...