二、Linear Regression 练习(转载)

转载链接:http://www.cnblogs.com/tornadomeet/archive/2013/03/15/2961660.html

前言

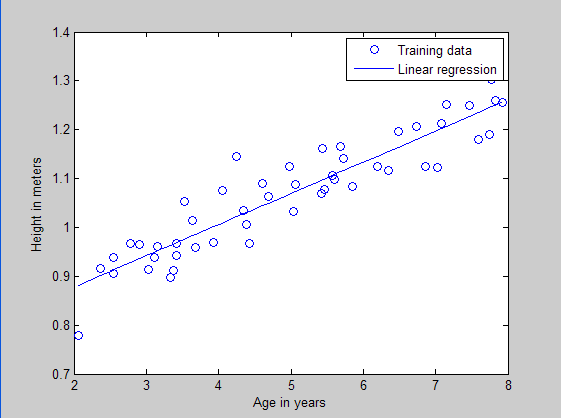

本文是多元线性回归的练习,这里练习的是最简单的二元线性回归,参考斯坦福大学的教学网http://openclassroom.stanford.edu/MainFolder/DocumentPage.php?course=DeepLearning&doc=exercises/ex2/ex2.html。本题给出的是50个数据样本点,其中x为这50个小朋友到的年龄,年龄为2岁到8岁,年龄可有小数形式呈现。Y为这50个小朋友对应的身高,当然也是小数形式表示的。现在的问题是要根据这50个训练样本,估计出3.5岁和7岁时小孩子的身高。通过画出训练样本点的分布凭直觉可以发现这是一个典型的线性回归问题。

matlab函数介绍:

legend:

比如legend('Training data', 'Linear regression'),它表示的是标出图像中各曲线标志所代表的意义,这里图像的第一条曲线(其实是离散的点)表示的是训练样本数据,第二条曲线(其实是一条直线)表示的是回归曲线。

hold on, hold off:

hold on指在前一幅图的情况下打开画纸,允许在上面继续画曲线。hold off指关闭前一副画的画纸。

linspace:

比如linspace(-3, 3, 100)指的是给出-3到3之间的100个数,均匀的选取,即线性的选取。

logspace:

比如logspace(-2, 2, 15),指的是在10^(-2)到10^(2)之间选取15个数,这些数按照指数大小来选取,即指数部分是均匀选取的,但是由于都取了10为底的指数,所以最终是服从指数分布选取的。

实验结果:

训练样本散点和回归曲线预测图:

损失函数与参数之间的曲面图:

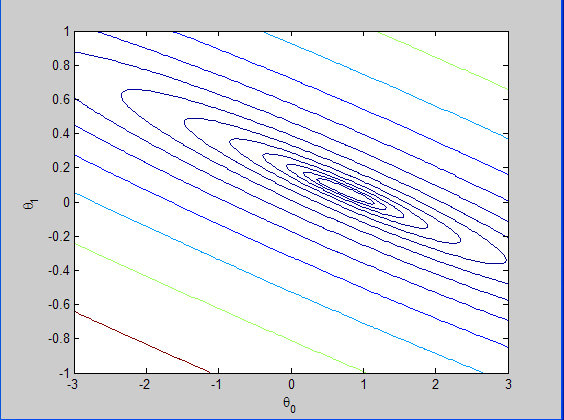

损失函数的等高线图:

程序代码及注释:

(1)采用正规方程求解:

%%方法一

x = load('ex2x.dat');

y = load('ex2y.dat');

plot(x,y,'*')

xlabel('height')

ylabel('age')

x = [ones(size(x),),x];

w=inv(x'*x)*x'*y

hold on

%plot(x,0.0639*x+0.7502)

plot(x(:,),0.0639*x(:,)+0.7502)%更正后的代码

(2)采用BGD方法:

% Exercise Linear Regression % Data is roughly based on CDC growth figures

% for boys

%

% x refers to a boy's age

% y is a boy's height in meters

% clear all; close all; clc

x = load('ex2x.dat'); y = load('ex2y.dat'); m = length(y); % number of training examples % Plot the training data

figure; % open a new figure window

plot(x, y, 'o');

ylabel('Height in meters')

xlabel('Age in years') % Gradient descent

x = [ones(m, ) x]; % Add a column of ones to x

theta = zeros(size(x(,:)))'; % initialize fitting parameters

MAX_ITR = ;

alpha = 0.07; for num_iterations = :MAX_ITR

% This is a vectorized version of the

% gradient descent update formula

% It's also fine to use the summation formula from the videos % Here is the gradient

grad = (/m).* x' * ((x * theta) - y); % Here is the actual update

theta = theta - alpha .* grad; % Sequential update: The wrong way to do gradient descent

% grad1 = (/m).* x(:,)' * ((x * theta) - y);

% theta() = theta() + alpha*grad1;

% grad2 = (/m).* x(:,)' * ((x * theta) - y);

% theta() = theta() + alpha*grad2;

end

% print theta to screen

theta % Plot the linear fit

hold on; % keep previous plot visible

plot(x(:,), x*theta, '-')

legend('Training data', 'Linear regression')%标出图像中各曲线标志所代表的意义

hold off % don't overlay any more plots on this figure,指关掉前面的那幅图 % Closed form solution for reference

% You will learn about this method in future videos

exact_theta = (x' * x)\x' * y % Predict values for age 3.5 and

predict1 = [, 3.5] *theta

predict2 = [, ] * theta % Calculate J matrix % Grid over which we will calculate J

theta0_vals = linspace(-, , );

theta1_vals = linspace(-, , ); % initialize J_vals to a matrix of 's

J_vals = zeros(length(theta0_vals), length(theta1_vals)); for i = :length(theta0_vals)

for j = :length(theta1_vals)

t = [theta0_vals(i); theta1_vals(j)];

J_vals(i,j) = (0.5/m) .* (x * t - y)' * (x * t - y);

end

end %Surf() :绘制某一区间内的完整曲面;matlab的surf函数中是在z的线性存储中,先固定y然后移动x,顺序选取。也就是说,Z(i,j)是在x(j),y(i)时候选取的。所以必须在绘制图形的时候对z转置

J_vals = J_vals';

% Surface plot

figure;

surf(theta0_vals, theta1_vals, J_vals)

xlabel('\theta_0'); ylabel('\theta_1'); % Contour plot

figure;

% Plot J_vals as contours spaced logarithmically between 0.01 and

contour(theta0_vals, theta1_vals, J_vals, logspace(-, , ))%画出等高线

xlabel('\theta_0'); ylabel('\theta_1');%类似于转义字符,但是最多只能是到参数0~

参考资料:

二、Linear Regression 练习(转载)的更多相关文章

- 转载 Deep learning:二(linear regression练习)

前言 本文是多元线性回归的练习,这里练习的是最简单的二元线性回归,参考斯坦福大学的教学网http://openclassroom.stanford.edu/MainFolder/DocumentPag ...

- 转载 Deep learning:三(Multivariance Linear Regression练习)

前言: 本文主要是来练习多变量线性回归问题(其实本文也就3个变量),参考资料见网页:http://openclassroom.stanford.edu/MainFolder/DocumentPage. ...

- [UFLDL] Linear Regression & Classification

博客内容取材于:http://www.cnblogs.com/tornadomeet/archive/2012/06/24/2560261.html Deep learning:六(regulariz ...

- 机器学习 (二) 多变量线性回归 Linear Regression with Multiple Variables

文章内容均来自斯坦福大学的Andrew Ng教授讲解的Machine Learning课程,本文是针对该课程的个人学习笔记,如有疏漏,请以原课程所讲述内容为准.感谢博主Rachel Zhang 的个人 ...

- 线性回归、梯度下降(Linear Regression、Gradient Descent)

转载请注明出自BYRans博客:http://www.cnblogs.com/BYRans/ 实例 首先举个例子,假设我们有一个二手房交易记录的数据集,已知房屋面积.卧室数量和房屋的交易价格,如下表: ...

- ISLR系列:(1)线性回归 Linear Regression

Linear Regression 此博文是 An Introduction to Statistical Learning with Applications in R 的系列读书笔记,作为本 ...

- 机器学习经典算法具体解释及Python实现--线性回归(Linear Regression)算法

(一)认识回归 回归是统计学中最有力的工具之中的一个. 机器学习监督学习算法分为分类算法和回归算法两种,事实上就是依据类别标签分布类型为离散型.连续性而定义的. 顾名思义.分类算法用于离散型分布预測, ...

- 贝叶斯线性回归(Bayesian Linear Regression)

贝叶斯线性回归(Bayesian Linear Regression) 2016年06月21日 09:50:40 Duanxx 阅读数 54254更多 分类专栏: 监督学习 版权声明:本文为博主原 ...

- Multivariance Linear Regression练习

%% 方法一:梯度下降法 x = load('E:\workstation\data\ex3x.dat'); y = load('E:\workstation\data\ex3y.dat'); x = ...

随机推荐

- 自学工业控制网络之路2.2-PROFINET

返回 自学工业控制网络之路 自学工业控制网络之路2.2-PROFINET PROFINET由PROFIBUS国际组织(PROFIBUS International,PI)推出,是新一代基于工业以太网技 ...

- luogu2831 [NOIp2016]愤怒的小鸟 (状压dp)

由范围可以想到状压dp 两个点(再加上原点)是可以确定一个抛物线的,除非它们解出来a>=0,在本题中是不合法的 这样的话,我们可以预处理出由任意两个点确定的抛物线所经过的所有的点(要特别规定一下 ...

- ubuntu 13.04 开发环境搭建

install ubuntu1, mysql serversudo apt-get install mysql-server2, ssh sudo apt-get install openssh-se ...

- A1102. Invert a Binary Tree

The following is from Max Howell @twitter: Google: 90% of our engineers use the software you wrote ( ...

- Eclipse:构造函数不提示才发现

用Eclipse快一年了,今天才发现,原来按下 Alt+? 就可以显示构造函数中的参数. 想一想这一年都不知道是怎么过的,遇到构造函数时,郁闷啊... 2007-11-01

- 四个修改Docker默认存储位置的方法

方法一.软链接 默认情况下Docker的存放位置为:/var/lib/docker 可以通过下面命令查看具体位置: sudo docker info | grep "Docker Root ...

- CentOS 7下Samba服务部署

Samba,是种用来让UNIX系列的操作系统与微软Windows操作系统的SMB/CIFS(Server Message Block/Common Internet File System)网络协议做 ...

- Ansible安装部署及常用模块详解

Ansible命令使用 Ansible语法使用ansible <pattern_goes_here> -m <module_name> -a <arguments> ...

- WCF开发实战系列一:创建第一个WCF服务

WCF开发实战系列一:创建第一个WCF服务 (原创:灰灰虫的家http://hi.baidu.com/grayworm) 在这个实战中我们将使用DataContract,ServiceContract ...

- Scala进阶之路-Scala中的Ordered--Ordering

Scala进阶之路-Scala中的Ordered--Ordering 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 说道对象的比较,在Java中大家最熟悉不过的就是实现类本身实 ...