使用vLLM和ChatGLM3-6b批量推理

当数据量大的时候,比如百万级别,使用 ChatGLM3-6b 推理的速度是很慢的。发现使用 vLLM 和 ChatGLM3-6b 批量推理极大的提高了推理效率。本文主要通过一个简单的例子进行实践。

1.安装 vLLM 和PyTorch [2]

除了 Python(本文使用 3.11)、CUDA(本文使用 11.8)外,还要安装 vllm、pytorch、xformers 等库,特别注意版本要一致。官方提供类库版本主要是针对 CUDA 12.1 版。如下所示:

# 用CUDA 11.8安装vLLM

# 指定vLLM版本

export VLLM_VERSION=0.2.6

# 指定Python版本

export PYTHON_VERSION=311

# 在线安装whl文件

pip install https://github.com/vllm-project/vllm/releases/download/v${VLLM_VERSION}/vllm-${VLLM_VERSION}+cu118-cp${PYTHON_VERSION}-cp${PYTHON_VERSION}-manylinux1_x86_64.whl

# 用CUDA 11.8重新安装PyTorch

pip uninstall torch -y

pip install torch --upgrade --index-url https://download.pytorch.org/whl/cu118

# 安装xformers库

pip3 install -U xformers --index-url https://download.pytorch.org/whl/cu118

2.离线批量推理例子 [3]

例子实现是比较简单的,主要是参数配置细节,如下所示:

from vllm import LLM, SamplingParams

# 定义批量数据

prompts = [

"宪法规定的公民法律义务有",

"属于专门人民法院的是",

"无效婚姻的种类包括",

"刑事案件定义",

"税收法律制度",

]

sampling_params = SamplingParams(temperature=0.1, top_p=0.5, max_tokens=4096)

path = '/data/ssw/llm_model/chatglm3-6b'

llm = LLM(model=path, trust_remote_code=True, tokenizer_mode="auto", tensor_parallel_size=2, dtype="auto")

outputs = llm.generate(prompts, sampling_params)

# 输出结果

for output in outputs:

prompt = output.prompt

generated_text = output.outputs[0].text

print(f"Prompt: {prompt!r}, Generated text: {generated_text!r}")

(1)temperature=0.1 [5]

控制采样随机性的浮点数。较低的值使模型更具确定性,而较高的值使模型更随机。0 意味着贪婪采样。

(2)top_p=0.5 [5]

控制要考虑的 top tokens 的累积概率的浮点数。必须在(0,1]之间。设置为 1 以考虑所有 token。

(3)max_tokens=4096 [5]

每个输出序列生成的最大 token 数。

(4)trust_remote_code=True [4]

当下载 model 和 tokenizer 时,信任远程代码(比如,来自 HuggingFace)。

(5)tokenizer_mode="auto" [4]

"auto"模式会在可用时使用快速分词器,而"slow"模式则始终使用慢分词器。

(6)tensor_parallel_size=2 [4]

用于张量并行的分布式执行的 GPU 数量。

(7)dtype="auto" [4]

模型权重和激活的数据类型。当前支持 float32,float16 和 bfloat16。如果设置为 auto,将使用模型配置文件中指定的 torch_dtype 属性。然而,如果配置中的 torch_dtype 是 float32,将使用 float16。

参考文献

[1] https://github.com/vllm-project/vllm/releases

[2] https://docs.vllm.ai/en/latest/

[3] https://github.com/vllm-project/vllm/blob/main/examples/offline_inference.py

[4] https://github.com/vllm-project/vllm/blob/main/vllm/entrypoints/llm.py

[5] https://github.com/vllm-project/vllm/blob/main/vllm/sampling_params.py

[6] 使用vLLM和ChatGLM3-6b批量推理(代码):https://github.com/ai408/nlp-engineering/blob/main/知识工程-大语言模型/公众号文章/使用vLLM和ChatGLM3-6b批量推理/chatglm3_6b_vllm.py

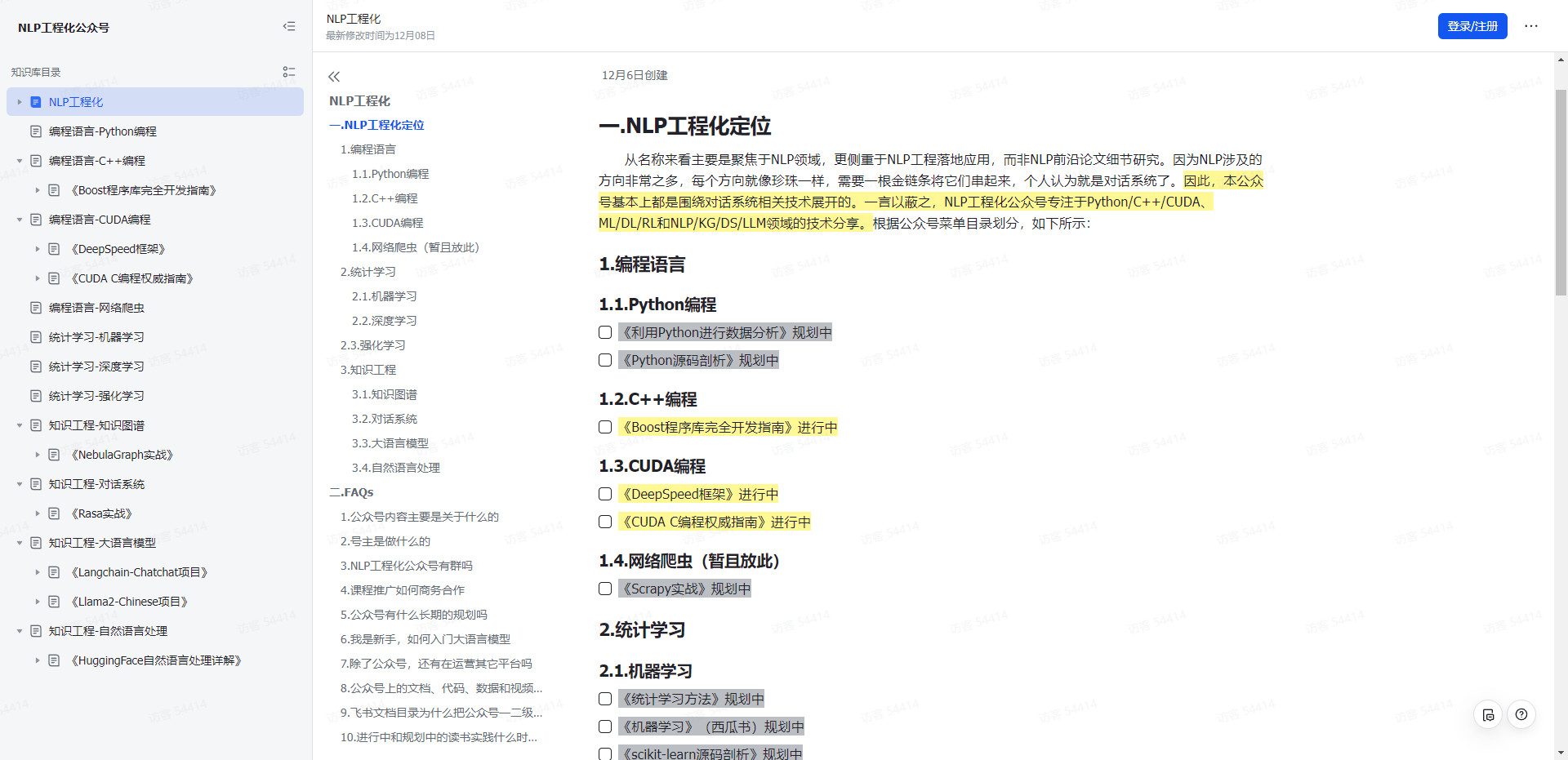

NLP工程化

1.本公众号以对话系统为中心,专注于Python/C++/CUDA、ML/DL/RL和NLP/KG/DS/LLM领域的技术分享。

2.本公众号Roadmap可查看飞书文档:https://z0yrmerhgi8.feishu.cn/wiki/Zpewwe2T2iCQfwkSyMOcgwdInhf

NLP工程化

飞书文档

使用vLLM和ChatGLM3-6b批量推理的更多相关文章

- AI应用开发实战 - 手写算式计算器

扩展手写数字识别应用 识别并计算简单手写数学表达式 主要知识点 了解MNIST数据集 了解如何扩展数据集 实现手写算式计算器 简介 本文将介绍一例支持识别手写数学表达式并对其进行计算的人工智能应用的开 ...

- AI应用开发实战 - 手写识别应用入门

AI应用开发实战 - 手写识别应用入门 手写体识别的应用已经非常流行了,如输入法,图片中的文字识别等.但对于大多数开发人员来说,如何实现这样的一个应用,还是会感觉无从下手.本文从简单的MNIST训练出 ...

- 自动驾驶轻松开发?华为云ModelArts赋能智慧出行

作为战略新兴产业,人工智能已经开始广泛应用于多个领域.近几年,科技公司.互联网公司等各领域的企业纷纷布局自动驾驶.那么,自动驾驶技术究竟发展得如何了?日前,华为云携手上海交通大学创新中心举办的华为云人 ...

- 本科阶段就挑战自动驾驶开发?华为云ModelArts帮你轻松实现!

欢迎添加华为云小助手微信(微信号:HWCloud002 或 HWCloud003),输入关键字"加群",加入华为云线上技术讨论群:输入关键字"最新活动",获取华 ...

- MLflow系列4:MLflow模型

英文链接:https://mlflow.org/docs/latest/models.html 本文链接:https://www.cnblogs.com/CheeseZH/p/11946260.htm ...

- MLflow系列1:MLflow入门教程(Python)

英文链接:https://mlflow.org/docs/latest/tutorial.html 本文链接:https://www.cnblogs.com/CheeseZH/p/11943280.h ...

- 我眼中的华为公有云AI平台--ModelArts

前言 AWS Sagemaker has been a great deal for most data scientists who would want to accomplish a truly ...

- NVIDIA GPUs上深度学习推荐模型的优化

NVIDIA GPUs上深度学习推荐模型的优化 Optimizing the Deep Learning Recommendation Model on NVIDIA GPUs 推荐系统帮助人在成倍增 ...

- Apache Hudi在Hopworks机器学习的应用

Hopsworks特征存储库统一了在线和批处理应用程序的特征访问而屏蔽了双数据库系统的复杂性.我们构建了一个可靠且高性能的服务,以将特征物化到在线特征存储库,不仅仅保证低延迟访问,而且还保证在服务时间 ...

- [源码解析] PyTorch 分布式(16) --- 使用异步执行实现批处理 RPC

[源码解析] PyTorch 分布式(16) --- 使用异步执行实现批处理 RPC 目录 [源码解析] PyTorch 分布式(16) --- 使用异步执行实现批处理 RPC 0x00 摘要 0x0 ...

随机推荐

- WPF学习 - 用鼠标移动、缩放、旋转图片(1)

1. 需求 其实我的需求很简单.就是想做一个图片查看器,可以通过鼠标来平移.缩放.旋转图片. 2. 解决思路: WPF中的UIElement提供了RenderTransform属性,用于承载各种Tra ...

- ffmpeg 在xp和server2003/2008/2012上修复无法定位GetNumaNodeProcessorMaskEx的问题

问题 在给开发一个手机视频网站时需要用到ffmpeg截取视频缩略图, 把项目提交到服务器(server2003/ server2008)上时, 发现在调用命令时会出现错误"无法定位GetNu ...

- DevSecOps之应用安全测试工具及选型

上篇文章,有同学私信想了解有哪些DevSecOps工具,这里整理出来,供大家参考(PS: 非专业安全人士,仅从DevOps建设角度,给出自己见解) 软件中的漏洞和弱点很常见:84%的软件漏洞都是利用应 ...

- Web攻防--JNDI注入--Log4j漏洞--Fastjson反序列化漏洞

JNDI注入 什么是JNDI JNDI全称为 Java Naming and Directory Interface(Java命名和目录接口),是一组应用程序接口,为开发人员查找和访问各种资源提供了统 ...

- Spring Event 观察者模式, 业务解耦神器

观察者模式在实际开发过程中是非常常见的一种设计模式. Spring Event的原理就是观察者模式,只不过有Spring的加持,让我们更加方便的使用这一设计模式. 一.什么是观察者模式 概念: 观察者 ...

- ubuntu22.04.3 安装postgresql 16 rc1数据库

ubuntu22.04.3 安装postgresql 16 rc1数据库 一.直接安装 # Create the file repository configuration: sudo sh -c ' ...

- 一文带你实现云上部署轻量化定制表单Docker

本文分享自华为云社区 <[华为云云耀云服务器L实例评测|云原生]自定制轻量化表单Docker快速部署云耀云服务器 | 玩转华为云>,作者:计算机魔术师. 华为云的云耀云服务器L实例备受推崇 ...

- fopen各个模式区别

fopen 函数是C标准库中用于打开文件的函数,它接受一个文件名和一个打开模式作为参数,返回一个指向文件的指针. 这里解释各个模式的区别: "r": 以只读模式打开文件,文件必须存 ...

- Learning Hard C# 学习笔记: 6.C#中的接口

目的: 由于C#中的类只能单个继承, 为了满足多重继承(一个子类可以继承多个父类)的需求, 所以产生了接口. 多重继承是指一个类可以从多个父类继承属性和方法.在C#中,只允许单继承,即一个类只能有一个 ...

- Cloud Bursting解决方案,Serverless容器降本增效极致体验

本文分享自华为云社区<DTSE Tech Talk | 第42期:Cloud Bursting解决方案,Serverless容器降本增效极致体验>,作者:华为云社区精选. 线下IDC自建K ...