机器学习中的权重衰退 —— 深度学习中的权重衰退 —— 权重衰退 —— weight decay

在看代码时看到了这个概念,以前虽然也看到过但是没有太在意,再次看到于是研究了一下。

引自:

https://sota.jiqizhixin.com/models/methods/0bdb8f87-9c05-483e-af49-e1140b9e7d19

直接说答案,weight decay 就是L2 Regularization 。

引自:

https://www.jianshu.com/p/995516301b0a

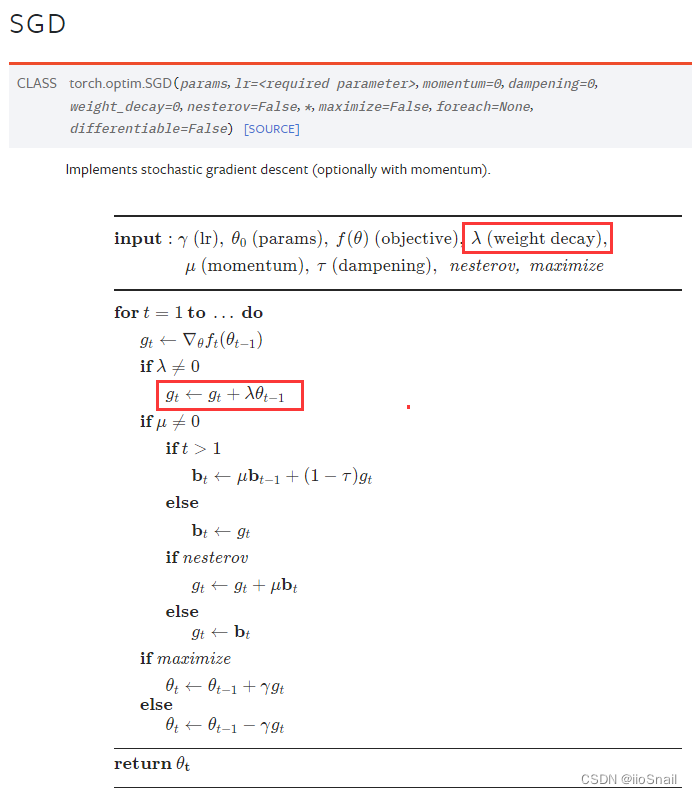

其实在深度学习框架中的优化器参数中就可以设置weight decay,如:

============================================

引自:

https://blog.csdn.net/zhaohongfei_358/article/details/129625803

weight_decay的一些trick:

- weight_decay并没有你想想中的那么好,它的效果可能只有一点点,不要太指望它。尤其是当你的模型很复杂时,权重衰退的效果可能会更小了。

- 通常取1e-3,如果要尝试的话,一般也就是1e-2, 1e-3, 1e-4 这些选项。

- 权重衰退通常不对bias做。但通常bias做不做权重衰退其实效果差不多,不过最好不要做。

- weight_decay取值越大,对抑制模型的强度越大。但这并不说明越大越好,太大的话,可能会导致模型欠拟合。

============================================

给出chainer框架中的实现:(不对bias进行decay,只对weight进行decay)

地址:

https://github.com/chainer/chainerrl/blob/master/chainerrl/optimizers/nonbias_weight_decay.py

class NonbiasWeightDecay(object):

"""Weight decay only for non-bias parameters.

This hook can be used just like chainer.optimizer_hooks.WeightDecay except

that this hook does not apply weight decay to bias parameters.

This hook assumes that all the bias parameters have the name of "b". Any

parameter whose name is "b" is considered as a bias and excluded from

weight decay.

"""

name = 'NonbiasWeightDecay'

call_for_each_param = True

timing = 'pre'

def __init__(self, rate):

self.rate = rate

def __call__(self, rule, param):

if param.name == 'b':

return

p, g = param.array, param.grad

if p is None or g is None:

return

with cuda.get_device_from_array(p) as dev:

if int(dev) == -1:

g += self.rate * p

else:

kernel = cuda.elementwise(

'T p, T decay', 'T g', 'g += decay * p', 'weight_decay')

kernel(p, self.rate, g)

def add_hook(self, hook, name=None, timing='auto'):

"""Adds a hook function. The hook function is called before or after any updates (see the timing

attribute). Args:

hook (callable): Hook function to be added. It takes two

arguments: the update rule object and the parameter variable.

name (str): Name of the hook function. The name attribute of the

hook function is used by default.

timing (str): Specifies when the hook is called. If 'auto', the

timimg property of the hook will decide the timing.

If 'pre', the hook will be called before any updates.

If 'post', the hook will be called after any updates.

If 'auto' and the timing property of the hook is not

available, timing will default to 'pre'. """

if not callable(hook):

raise TypeError('hook function must be callable')

if timing not in ('pre', 'post', 'auto'):

raise ValueError("timing must be one of ('pre', 'post', 'auto')")

if timing == 'auto':

timing = getattr(hook, 'timing', 'pre') if name is None:

name = getattr(hook, 'name', getattr(hook, '__name__', None))

if name is None:

raise ValueError(

'the name of the hook function is not specified')

if name in self._pre_update_hooks or name in self._post_update_hooks:

raise ValueError('hook "{}" already exists'.format(name)) if timing == 'pre':

self._pre_update_hooks[name] = hook

else:

self._post_update_hooks[name] = hook def remove_hook(self, name):

"""Removes the specified hook function. Args:

name (str): Name of the hook function to be removed. The hook

function registered with this name will be removed. """

try:

del self._pre_update_hooks[name]

except KeyError:

del self._post_update_hooks[name] def update(self, param):

"""Invokes hook functions and updates the parameter. Args:

param (~chainer.Variable): Variable to be updated. """

if not self.enabled:

return self.t += 1 if self._use_fp32_update and param.dtype == numpy.float16:

if self._fp32_param is None:

self._fp32_param = variable.Variable(

param.array.astype(numpy.float32),

name=param.name)

fp32_param = self._fp32_param

fp32_param.grad = param.grad.astype(numpy.float32) if fp32_param.data is not None:

self._prepare(fp32_param)

if param._loss_scale is not None:

fp32_param.grad /= param._loss_scale

for hook in six.itervalues(self._pre_update_hooks):

hook(self, fp32_param)

self.update_core(fp32_param)

for hook in six.itervalues(self._post_update_hooks):

hook(self, fp32_param) param.data = fp32_param.data.astype(param.dtype)

fp32_param.grad = None

else:

if param.data is not None:

self._prepare(param)

if param._loss_scale is not None:

param.grad /= param._loss_scale

for hook in six.itervalues(self._pre_update_hooks):

hook(self, param)

self.update_core(param)

for hook in six.itervalues(self._post_update_hooks):

hook(self, param)

============================================

参考:

https://www.jianshu.com/p/995516301b0a

https://blog.csdn.net/zhaohongfei_358/article/details/129625803

机器学习中的权重衰退 —— 深度学习中的权重衰退 —— 权重衰退 —— weight decay的更多相关文章

- 机器学习之路:tensorflow 深度学习中 分类问题的损失函数 交叉熵

经典的损失函数----交叉熵 1 交叉熵: 分类问题中使用比较广泛的一种损失函数, 它刻画两个概率分布之间的距离 给定两个概率分布p和q, 交叉熵为: H(p, q) = -∑ p(x) log q( ...

- 深度学习中常见的 Normlization 及权重初始化相关知识(原理及公式推导)

Batch Normlization(BN) 为什么要进行 BN 防止深度神经网络,每一层得参数更新会导致上层的输入数据发生变化,通过层层叠加,高层的输入分布变化会十分剧烈,这就使得高层需要不断去重新 ...

- 深度学习中Dropout原理解析

1. Dropout简介 1.1 Dropout出现的原因 在机器学习的模型中,如果模型的参数太多,而训练样本又太少,训练出来的模型很容易产生过拟合的现象. 在训练神经网络的时候经常会遇到过拟合的问题 ...

- 卷积在深度学习中的作用(转自http://timdettmers.com/2015/03/26/convolution-deep-learning/)

卷积可能是现在深入学习中最重要的概念.卷积网络和卷积网络将深度学习推向了几乎所有机器学习任务的最前沿.但是,卷积如此强大呢?它是如何工作的?在这篇博客文章中,我将解释卷积并将其与其他概念联系起来,以帮 ...

- 深度学习中的Normalization模型

Batch Normalization(简称 BN)自从提出之后,因为效果特别好,很快被作为深度学习的标准工具应用在了各种场合.BN 大法虽然好,但是也存在一些局限和问题,诸如当 BatchSize ...

- [优化]深度学习中的 Normalization 模型

来源:https://www.chainnews.com/articles/504060702149.htm 机器之心专栏 作者:张俊林 Batch Normalization (简称 BN)自从提出 ...

- Hebye 深度学习中Dropout原理解析

1. Dropout简介 1.1 Dropout出现的原因 在机器学习的模型中,如果模型的参数太多,而训练样本又太少,训练出来的模型很容易产生过拟合的现象. 在训练神经网络的时候经常会遇到过拟合的问题 ...

- zz详解深度学习中的Normalization,BN/LN/WN

详解深度学习中的Normalization,BN/LN/WN 讲得是相当之透彻清晰了 深度神经网络模型训练之难众所周知,其中一个重要的现象就是 Internal Covariate Shift. Ba ...

- 模型汇总24 - 深度学习中Attention Mechanism详细介绍:原理、分类及应用

模型汇总24 - 深度学习中Attention Mechanism详细介绍:原理.分类及应用 lqfarmer 深度学习研究员.欢迎扫描头像二维码,获取更多精彩内容. 946 人赞同了该文章 Atte ...

- 深度学习中正则化技术概述(附Python代码)

欢迎大家关注我们的网站和系列教程:http://www.tensorflownews.com/,学习更多的机器学习.深度学习的知识! 磐石 介绍 数据科学研究者们最常遇见的问题之一就是怎样避免过拟合. ...

随机推荐

- Python基础——上节补充及数据类型

1.变量的创建过程 当我们创建一个变量name='oldboy'时,实际上是这样一个过程. 程序先开辟了一个内存空间,把变量的内容放进去,再让变量name指向'oldboy'所在的内存地址. 我们可以 ...

- Java线程池maximumPoolSize和workQueue哪个先饱和?

先说结论,真正的饱和顺序是corePoolSize -> workQueue -> maximumPoolSize. 我们都知道,线程池有以下参数 ThreadPoolExecutor(i ...

- CS后门源码特征分析与IDS入侵检测

CS后门源码特征分析与IDS入侵检测考核作业 上线x64 getshell 抓心跳包,对特征字符解密Uqd3 用java的checksum8算法得到93,说明是x64的木马 public class ...

- 19-Docker数据持久化

什么是Docker数据持久化 容器在运行时会在镜像层上加上一层:可写层. 当删除容器时,可写层就会一起被删除,数据丢失. 数据持久化就是就是将数据持久化保存,删除容器之后,数据仍然存在. 方法1-挂载 ...

- Python图像暗水印添加

推荐使用库: blind-watermark pip install blind-watermark https://github.com/guofei9987/blind_watermark

- HarmonyOS SDK助力鸿蒙原生应用“易感知、易理解、易操作”

6月21-23日,华为开发者大会(HDC 2024)盛大开幕.6月23日上午,<HarmonyOS开放能力,使能应用原生易用体验>分论坛成功举办,大会邀请了多位华为技术专家深度解读如何通过 ...

- C#/.NET这些实用的技巧和知识点你都知道吗?

前言 今天大姚给大家分享一些C#/.NET中的实用的技巧和知识点,它们可以帮助我们提升代码质量和编程效率,希望可以帮助到有需要的同学. .NET使用CsvHelper快速读取和写入CSV文件 本文主要 ...

- 【全球首发】双核Cortex-A7@1.2GHz,仅99元起?含税?哇!!

- Vue手稿4

- VirtualBox Ubuntu 22.04 Server联网、与主机互联

使用 VirtualBox 7.0安装了两个Ubuntu 22.04 Server虚拟机,想要实现: 主机与虚拟机互联 虚拟机之间互联,且互联的IP应为静态 虚拟机可以联网 解决方法 每个虚拟机配置两 ...